王小鱼

大数据开发工程师

- 公司信息:

- 华为

- 工作经验:

- 10年

- 兼职日薪:

- 800元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 北京

- 丰台

技术能力

编程语言

Java:许多大数据技术(如Hadoop)使用Java编写。

Scala:特别是用于Apache Spark的开发。

Python:广泛用于数据分析和机器学习。

SQL:用于查询和操作数据库。

大数据技术

Hadoop生态系统:

HDFS(Hadoop Distributed File System):用于存储大规模数据。

MapReduce:一种编程模型,用于处理大规模数据集。

YARN(Yet Another Resource Negotiator):资源管理层。

Hive:数据仓库软件,提供类似SQL的查询语言。

Pig:用于分析大数据的平台。

Apache Spark:快速的通用大数据处理引擎,支持批处理和流处理。

Flink:另一种高性能的大数据处理引擎,尤其适合流处理。

数据库和数据仓库

NoSQL数据库:

HBase:分布式、可扩展的大数据存储。

Cassandra:高度可扩展的NoSQL数据库。

MongoDB:文档导向的NoSQL数据库。

SQL数据库:

MySQL、PostgreSQL:常见的关系数据库管理系统。

数据仓库:

Redshift、BigQuery:云数据仓库服务。

数据处理和流处理

Kafka:分布式流处理平台。

Storm:实时流处理系统。

NiFi:数据流自动化工具。

数据分析和可视化

R:用于统计分析和数据可视化。

Tableau、Power BI:数据可视化工具。

DevOps和工具

容器化和编排:

Docker:容器化平台。

Kubernetes:容器编排工具。

版本控制:

Git:版本控制系统。

CI/CD工具:

Jenkins:持续集成和持续部署工具。

项目经验

### 1. 数据湖建设项目

**描述**:构建一个基于Hadoop的数据湖,用于存储和处理来自多个数据源的海量数据。

**技术栈**:

- **Hadoop**:HDFS用于数据存储,MapReduce用于数据处理。

- **Hive**:用于数据查询和分析。

- **Sqoop**:用于将数据从关系数据库导入Hadoop。

- **Oozie**:用于管理和调度工作流。

**职责**:

- 设计和实现数据湖架构。

- 开发和优化MapReduce作业。

- 编写Hive查询进行数据分析。

- 使用Oozie调度和监控工作流。

### 2. 实时数据处理系统

**描述**:开发一个基于Apache Kafka和Apache Spark的实时数据处理系统,用于处理和分析来自物联网设备的数据。

**技术栈**:

- **Apache Kafka**:用于数据流的实时采集和传输。

- **Apache Spark**:用于实时数据处理和分析(Spark Streaming)。

- **Cassandra**:用于存储处理后的数据。

- **Grafana**:用于数据可视化和监控。

**职责**:

- 配置和管理Kafka集群。

- 编写Spark Streaming应用程序以处理实时数据流。

- 将处理后的数据存储在Cassandra中。

- 使用Grafana创建实时监控仪表盘。

### 3. 大规模数据迁移项目

**描述**:将公司数据从本地数据中心迁移到云端,采用AWS的各种服务。

**技术栈**:

- **AWS S3**:用于数据存储。

- **AWS EMR**:用于数据处理。

- **AWS Glue**:用于数据转换和编排。

- **AWS Redshift**:用于数据仓库。

**职责**:

- 规划和执行数据迁移策略。

- 使用AWS Glue进行数据转换和清洗。

- 在AWS EMR上运行数据处理作业。

- 将处理后的数据加载到Redshift中用于分析。

### 4. 客户行为分析平台

**描述**:开发一个平台,用于分析客户行为,提供个性化推荐和预测分析。

**技术栈**:

- **Python**:数据清洗和预处理。

- **Spark MLlib**:用于机器学习模型的训练和预测。

- **Elasticsearch**:用于快速搜索和分析。

- **Kibana**:用于数据可视化。

**职责**:

- 设计和实现数据管道,清洗和预处理数据。

- 使用Spark MLlib构建和优化机器学习模型。

- 将分析结果存储在Elasticsearch中。

- 使用Kibana创建交互式仪表盘,展示分析结果。

### 5. 社交媒体数据分析项目

**描述**:开发一个系统,用于收集和分析社交媒体数据,提供舆情分析和趋势预测。

**技术栈**:

- **Twitter API**:收集实时数据。

- **Apache Flink**:实时数据处理和分析。

- **HBase**:用于存储处理后的数据。

- **Tableau**:用于数据可视化和报告。

**职责**:

- 使用Twitter API收集社交媒体数据。

- 开发Flink应用程序,进行实时数据处理和舆情分析。

- 将处理后的数据存储在HBase中。

- 使用Tableau创建报告和可视化,展示舆情分析结果。

案例展示

-

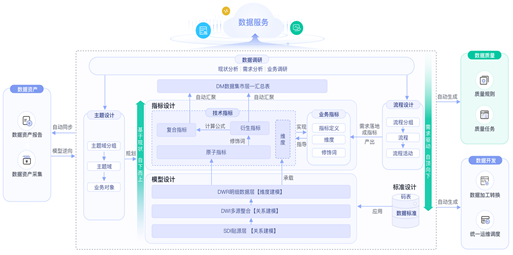

数据湖建设

数据摸底。对于一个企业/组织而言,在构建数据湖初始工作就是对自己企业/组织内部的数据做一个全面的摸底和调研,包括数据来源、数据类型、数据形态、数据模式、数据总量、数据增量等。在这个阶段一个隐含的重要工作是借助数据摸底工作,进一步梳理企业的组织结构,明确数据和组织结构之间关系。为后

-

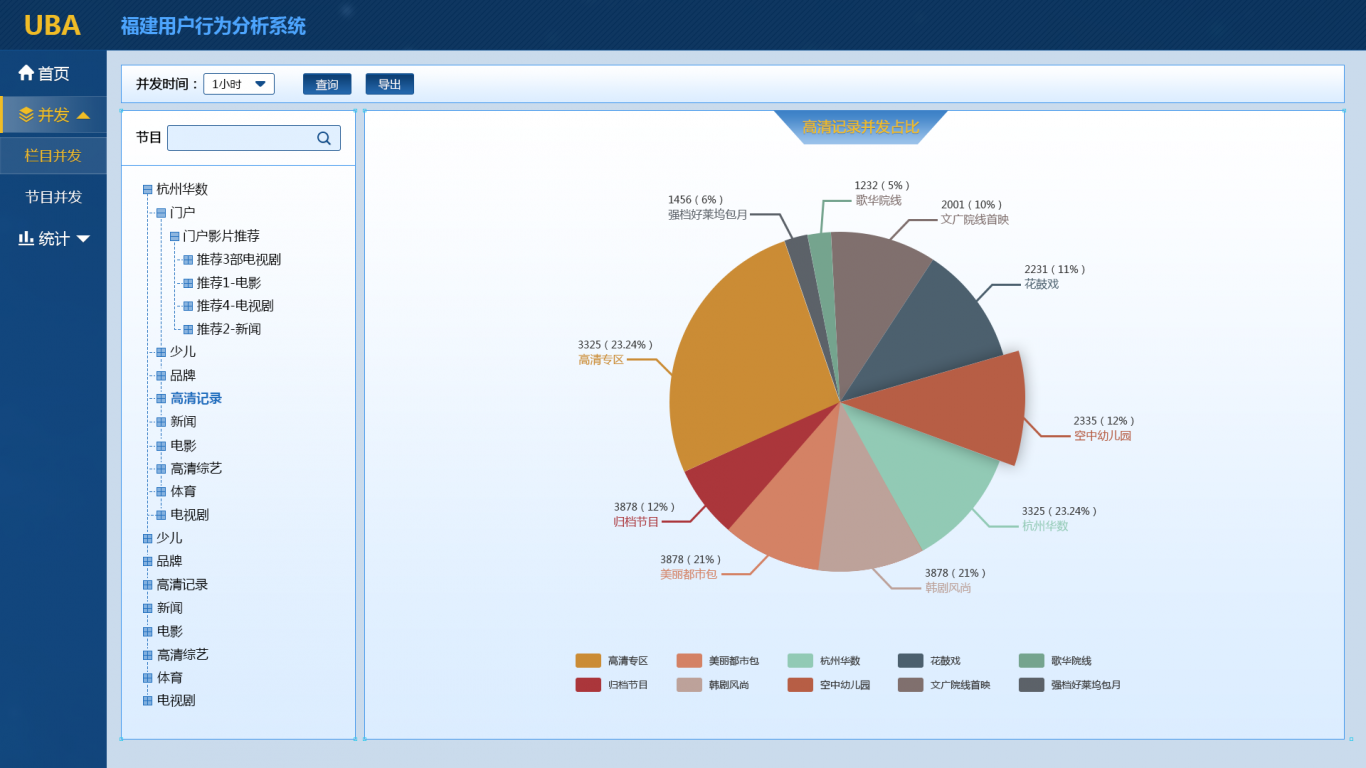

客户行为分析平台

1.用户来源分析 提供用户来源分析,用户一般来自哪些区域,一般通过什么途径(例如直接访问、搜索引擎或其他链接等)访问应用。用户对终端类型、服务渠道的偏好,在相应终端上的用户满意度。 2.用户操作分析 对外网应用进行用户平均停留时间分析,以了解用户使用时长。

相似人才推荐

-

500元/天嵌入式软件工程师杭州极米智能科技概要:嵌入式软件开发(STM32,M451,STC15):SPI、UART、RS232、RS485、IIC

-

500元/天全栈工程师凌源市汇盛信息技术有限公司概要:Node.js:熟练使用 Node.js 进行服务端开发,具备构建高性能、高并发 Web 应用的能力

-

700元/天网络工程师郑州航空工业管理学院概要:熟练掌握python语言,c语言,等编程语言,掌握爬虫,python数据分析,包括jsonpath,

-

1000元/天ServiceNow 顾问hp,dxc,deloitte概要:在ITSM 行业有着15 年以上的工作经验,尤其是servicenow 有着9 年以上的工作经验,有

-

2000元/天高级架构师上海复旦微电子股份有限公司概要:1、极精通C++,15年以上C++开发,从事过多年设备嵌入式系统软件架构和开发,设备上位机系统软件架

-

1000元/天高级开发工程师顺丰科技概要:本人软件工程专业毕业,具备 Java、C/C++跨平台开发经验,并且熟练掌握 Android/iOS

-

500元/天RPA高级开发工程师影刀概要:RPA开发、编程111111111111111111111111111111111111111111

-

500元/天实施工程师众阳健康科技集团有限公司概要:1、基础办公软件excel、word等工具的使用。 2、熟悉产品开发过程中的各个流程,可使用axu