生而自由 爱而无畏

数据仓库工程师,ETL开发工程师

- 公司信息:

- 中国证券监督管理委员会

- 工作经验:

- 8年

- 兼职日薪:

- 600元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 北京

- 丰台

技术能力

1 掌握 python基础知识,面向对象逻辑思维;

2 熟悉HTML+CSS;

3 掌握正则re解析,bs4解析,xpath解析;

4 requests动态爬取数据;

5 高并发(多进程,多线程,协程)爬取数据;

6 熟练运用selenium模块;

7 熟悉mysql,MongoDB和Redis三大主流数据库;

8 了解代理池原理;

9 掌握scrapy原理,熟练使用scrapy爬取数据;

10 熟悉分布式爬虫;

11 掌握JavaScript语法;

12 熟悉逆向爬虫的原理;(目前正在练习中,涉及到逆向爬虫的冬冬暂时还搞不定,请谅解)

13 掌握 Linux 系统的命令以及docker命令和 shell 的编写;

项目经验

1. 对中国证券监督管理委员会官网政务信息中的政策公开规章数据和主动公开目录中的各项指标数据进行爬取。(公司项目)

说明:利用requests动态异步爬取网页内容。

2. 对中国古诗文网中的诗文,名句,古籍数据进行爬取。

说明:需要绕过登录验证,登录后利用bs4或者xpath爬取数据。

3. 对北京地区链家历年二手房成交记录进行爬取。

说明:需要绕过登陆验证后,在获取数据信息

4. 基于selenium模块开发12306自动抢票程序。

案例展示

-

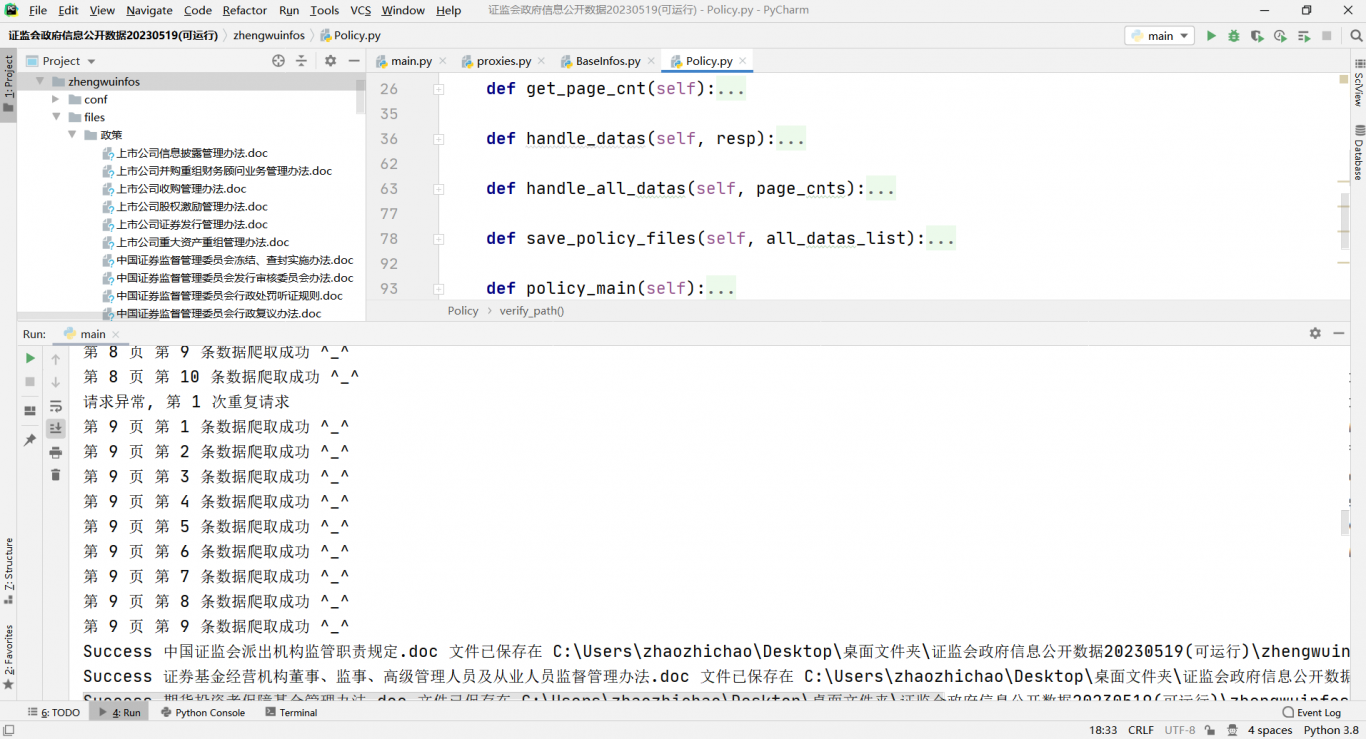

证监会网站数据爬取项目

根据网站信息,按照信息栏划分为两部分:政策类和按主题划分类,按体裁文种类同主题类 执行主函数,会在对应目录生成该类主题所有的目录层级和doc文件,代码中是按照面向对象逻辑思想使用了ip代理池,捕获异常重复发送请求,获取所需数据。 第二种方案:还可以基于scrapy框架实现

-

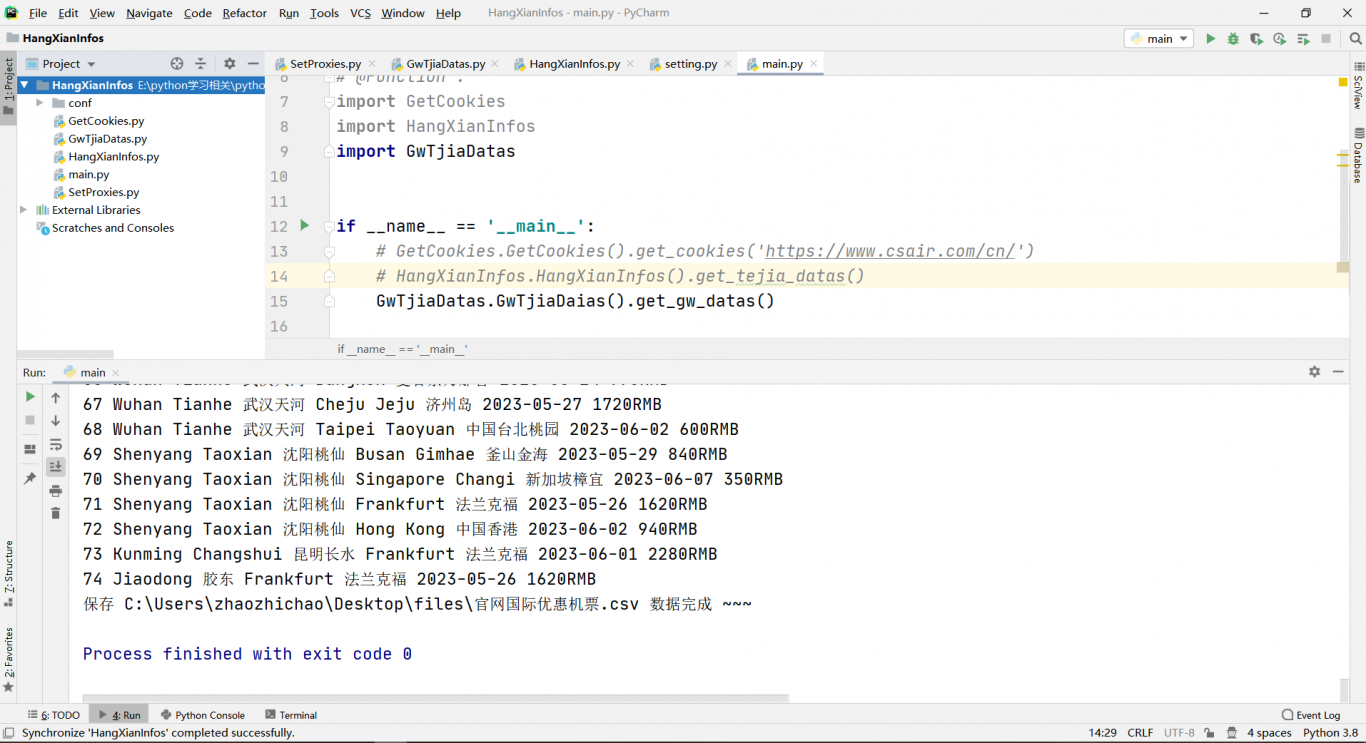

南航国际(内)优惠特价机票信息爬取

爬取南方航空小程序中对应的国内和国外优惠价格信息和正常机票价格信息(活动期间) 利用selenium获取到网站的cookie信息,再去获取各个网页数据信息,筛选所需数据永久存储

相似人才推荐

-

1500元/天副总裁、技术总监中国金融网概要:后端精通asp、asp.net、c#、winform、webform,有自主编写框架能力。 前端精

-

500元/天无无概要:有较好的c#,html,js,css,python爬虫,sqlserver,informix,微信小

500元/天无无概要:有较好的c#,html,js,css,python爬虫,sqlserver,informix,微信小 -

500元/天DBA富士康科技集团概要:1、数据库运维。熟练使用Oracle,熟悉postgres,熟悉MySQL。 2、Linux操作系

-

1000元/天高级研发工程师西安铭博网络信息科技有限公司概要:本人有公司,有专业技术团队,属于全能团队,可接外包项目,选我没有错的,,,,,,,,,,,,,,,,

-

900元/天算法工程师阿里巴巴概要:作为一名算法工程师,我拥有广泛的技术能力,可以为企业提供全面的咨询服务。以下是我作为顾问所具备的技术

-

500元/天科研助理华中科技大学概要:硕士研究生学历。主要从事深度学习、机器学习等模型的搭建及复现,以及机器视觉、数据分析等项目的开发。掌

-

800元/天爬虫工程师上海帮考科技有限公司概要:1、有3年左右爬虫开发经验,能独立完成网站分析、加密破解、数据建模等爬虫任务 2、熟悉HTTP、H

-

500元/天ww概要:从事研发数据支撑,负责部分薪酬调查分析以及制造业分析, 1.数据采集,能够进行部分网站数据批量爬取