FANK

数据库工程师

- 公司信息:

- =

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 可工作日驻场(自由职业原因)

- 所在区域:

- 北京

- 海淀

技术能力

能够熟练使用HTML+CSS/JavaScript等前端开发工具;

熟悉Linux的常规操作,能使用Linux系统进行相关项目的开发和编写shell脚本;

熟悉python语言,能够使用numpy,pandas,等数据分析模块,能结合scrapy框架和bs4模块,flask模块,实现对网页上数据的抓取和提取工作,制作爬虫;

了解pytorch,transform等深度学习框架

掌握Hbase存储原理和读写机制,掌握常用的数据存储工具,Mysql,Redis,mongodb;

熟悉Hadoop结构和其工作原理,掌握HDFS存储机制,编写MapReduce程序,掌握Yarn资源分配策略;

掌握Hive的架构,熟练使用sql语句,对数据进行ETL操作,数仓建模,数据分析,以及hive的相关调优;

能运用Sqoop进行数据的采集和传输;

项目经验

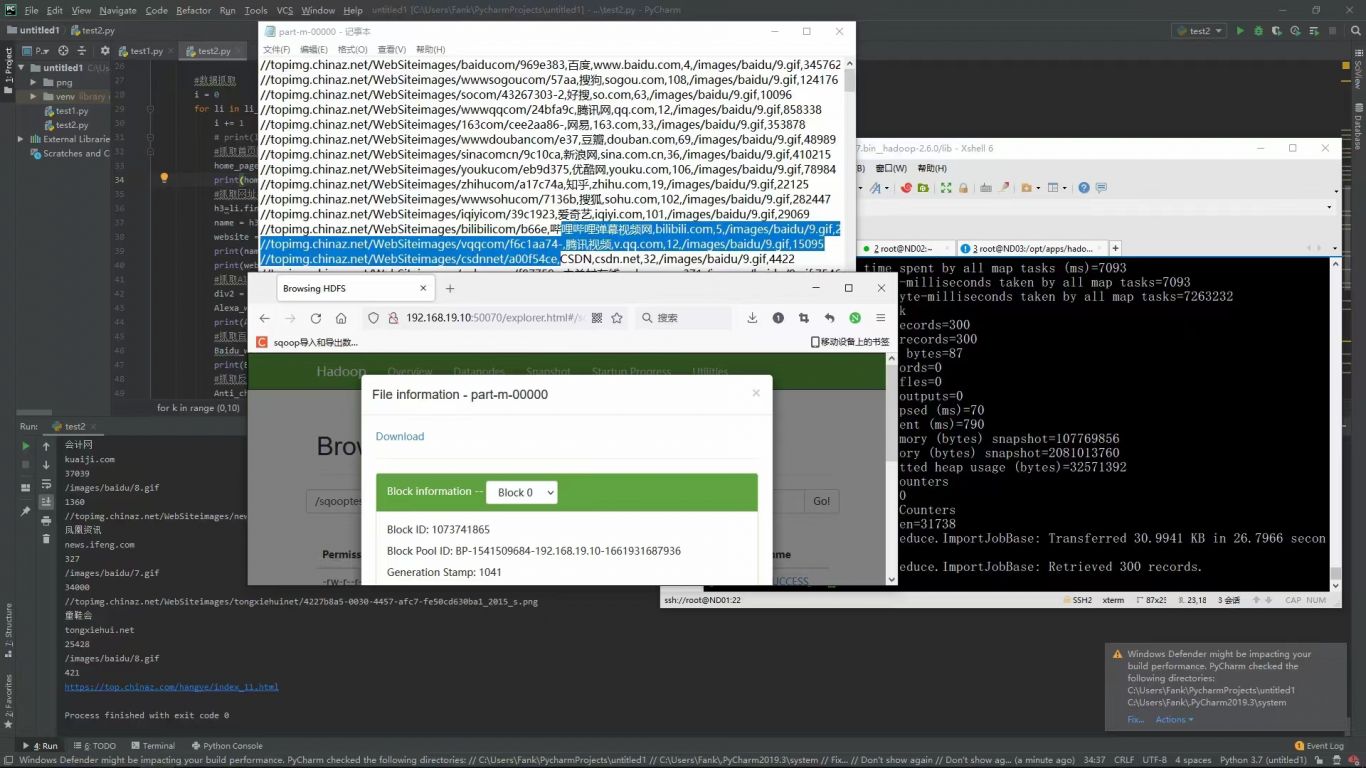

项目名称: 基于爬虫和大数据的结合

开发周期: 3个月(2023-2-2023-3)

项目描述:

爬虫将数据导入到mysql数据库中,通过sqoop将MySQL中的数据导入到Hadoop的hdfs中,Hadoop集群运用hive进行sql数据库查询,使用hdfs将数据存储在节点,并实现提取出用户留存率,日创建用户和日活跃用户,用户地址,各个年龄段的用户。通过一系列的数据筛选,提取,转换来调查用户需求,来描绘用户画像。

项目架构: Mysql + Sqoop + Hadoop +python爬虫

技术实现:

1. 使用爬虫将爬到的数据传入mysql里面。

2. 使用Sqoop将MySql的业务数据导入HDFS,将原本就保存在本地的了日志文件导入到HDFS

3. 使用Sqoop将MySql的业务数据导入HDFS,将原本就保存在本地的了日志文件导入到HDFS

3.使用SparkCore/SparkSql对数据进行清洗,最后将数据存到Hdfs,映射的到hive表;

3. 创建ODS、MI、DWD、WT、DIM、TMP层;

5. 将数据进行图表展示,发送给运营、产品、测试、管理层。

案例展示

-

python爬虫结合Hadoop

项目名称: 基于爬虫和大数据的结合 开发周期: 3个月(2023-2-2023-3) 项目描述: 爬虫将数据导入到mysql数据库中,通过sqoop将MySQL中的数据导入到Hadoop的hdfs中,Hadoop集群运用hive进行sql数据库查询,使用hdfs将数据存

-

downni视频解析

负责后端python爬虫的编写以及接口编写,实现了大部分主流视频的解析,并且是解析到源视频下载地址。

相似人才推荐

-

500元/天111111概要:使用vue框架,以及vue-router构建单页面应用,项目采用vuex处理各组件间的通讯,vue-

-

500元/天软件开发工程师金华逸丰自动化有限公司概要:C#开发、C++、嵌入式C#开发、C++、嵌入式 C#开发、C++、嵌入式C#开发、C++、嵌入式

-

500元/天资深研发工程师武汉纬创纬尊软件公司概要:工作负责心很强、积极主动,敬业,细心耐心。具备较扎实的专业知识和较强的理解与学习能力,工作效率高,对

-

600元/天研发工程师**科技有限公司概要:有10多年的 Windows 系统方面的软件开发经验,如系统各类信息检测、设置,系统软硬件检测,分析

600元/天研发工程师**科技有限公司概要:有10多年的 Windows 系统方面的软件开发经验,如系统各类信息检测、设置,系统软硬件检测,分析 -

500元/天渗透测试奇安信概要:1. 掌握渗透测试流程,熟悉传统的SQL注入,熟悉SQL注入原理,能够进行手工注入,懂得SQL注入的

-

900元/天算法高级工程师,技术经理埃森哲技术服务有限公司概要:python全栈开发,django,flask开发,算法工程师,精通机器学习、深度学习算法,Proe

-

500元/天本科在校生无概要:本人是一名网络工程专业大三在校生,会C,Python编程语言,其中自学并熟练掌握python相关的知

-

500元/天个人个人概要:模拟器脚本操作,自动化操作,可代替人工操作一些动作。 网页填表,自动化网页填表,解放双手 网页协