sven 身份已认证

生信研发工程师

- 公司信息:

- bmk

- 工作经验:

- 3年

- 兼职日薪:

- 600元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 北京

- 东城

技术能力

从事编程工作3年,接触过perl、python、R、java、C++,JS等编程语言;mysql、mongodb等数据库

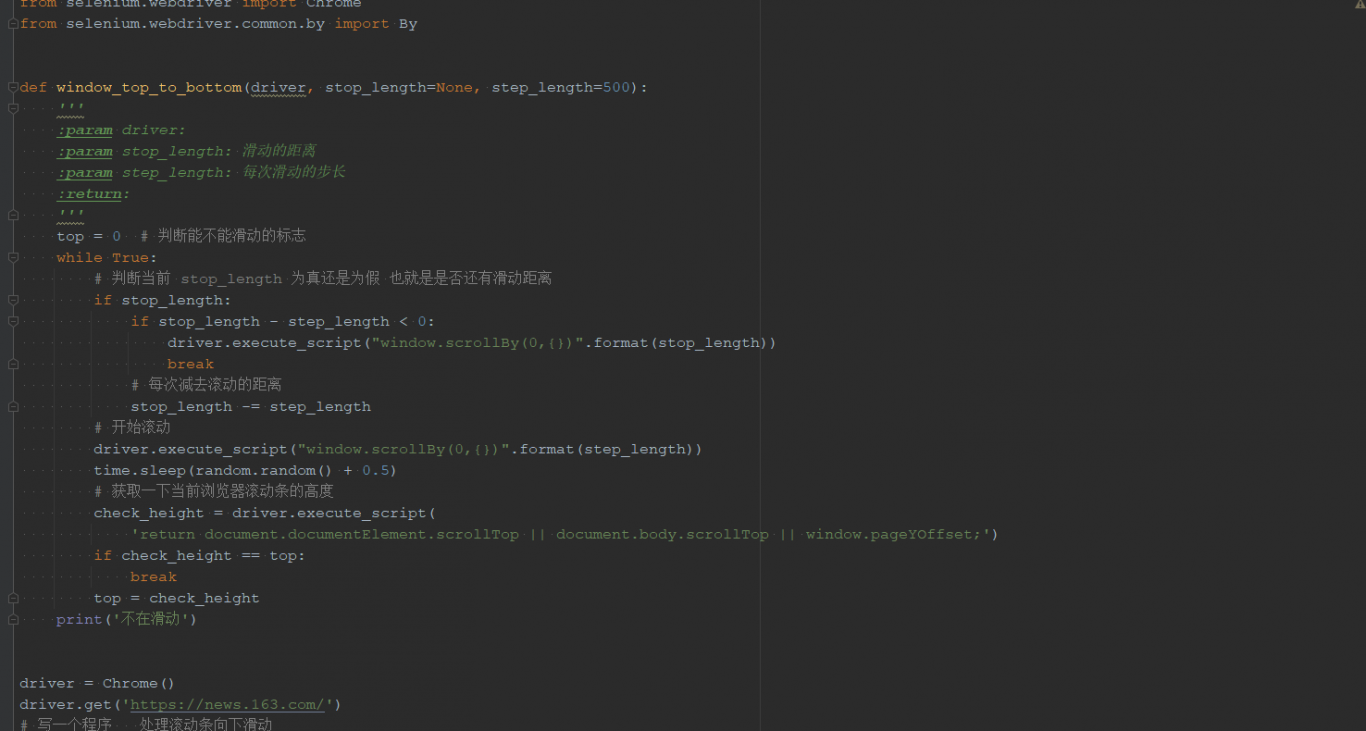

其中主要擅长的工作是使用python程序进行网站和app的数据采集。曾经使用的工具有:request、scarapy框架、selenium等获取数据,使用mysql、mongodb、redis进行数据的存储。

项目经验

项目一:马蜂窝游记播完采取

需求:根据关键字,搜索马蜂窝2020年来相关的游记相关信息:

获取的游记信息必须包含以下信息:作者、时间、具体的内容、先关的评论内容;

数据交付:将获取的游记内容保存起来,按照时间归类,每个月一个目录,相关的游记文本保存到时间目录下;

采用scrapy框架,结合request进行数据的获取和保存

项目二:医药产品数据采集

需求:

抓取指定网站的网页附件pdf文件,并将附件下载,然后对pdf文件进行内容的识别,获取文件中的指定文职的表格数据,并将表格数据按照指定的方式保存下来。

开发:

因为网站特殊性,采用selenium方式模拟人工操作进行数据的获取。

表格数据比较无规律,需要一个一个的进行查看,编写对应的函数进行数据识别和保存。

项目三:

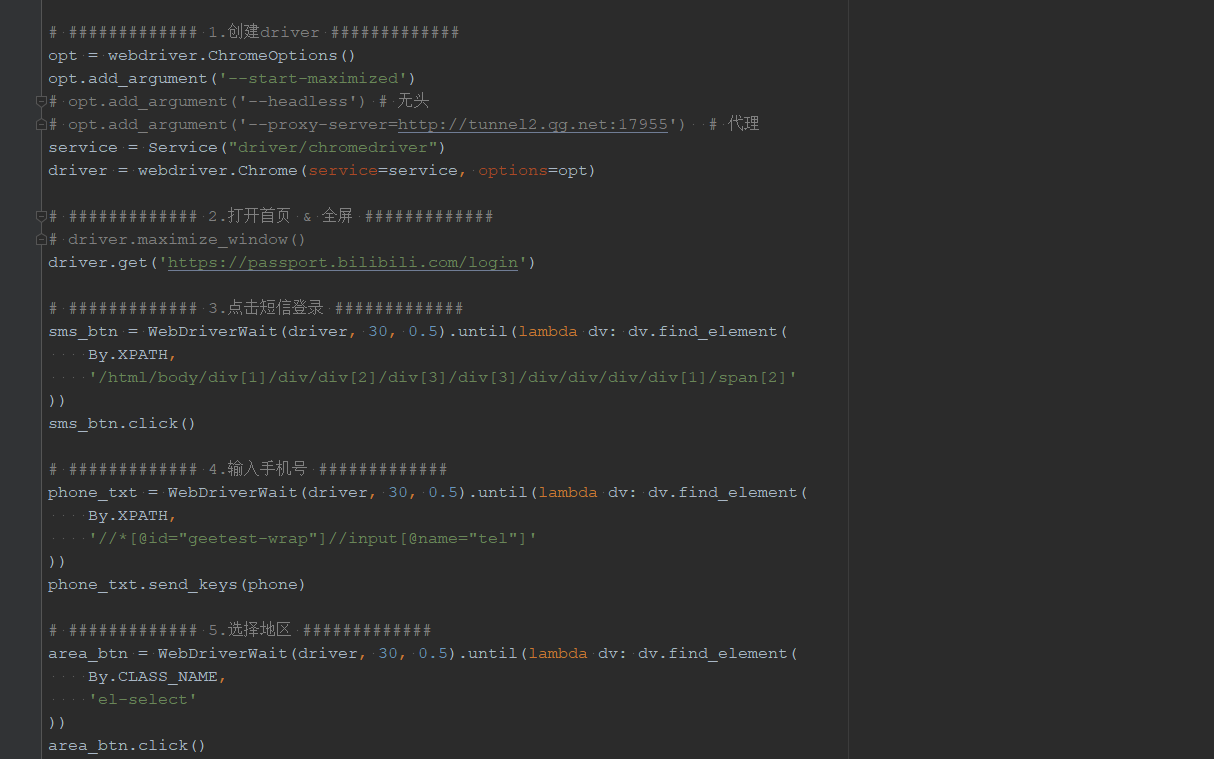

自动化注册bibi的账号,然后自动化进行答题,将账号的等级升级到lv2.

操作的方式为:

使用python的selenium功能,进行账号的注册,中间模拟人工的点击操作、获取验证码,填写验证后进行注册。

注册后,进入答题模式,因为答题是选择题,比较简单,随机选择知道题目正确后通过。

等分数到答指定分数后退出。

案例展示

-

医药产品数据采集

根据用户指定的网址登录,逐步打开指定的网址,找到下载链接位置和下载文件的所有操作方式,并记录每个操作方式的网页位置信息 采用selenium技术,模拟人工操作,进行文件的下载。 打开下载的pdf文件,查看文件特点和表格形式,采用pdfplumber进行内容和表格的数据识别(表

-

bibi自动注册和答题

自动化注册bibi的账号,然后自动化进行答题,将账号的等级升级到lv2. 操作的方式为: 使用python的selenium功能,进行账号的注册,中间模拟人工的点击操作、获取验证码,填写验证后进行注册。 注册后,进入答题模式,因为答题是选择题,比较简单,随机选择知道题目正确

相似人才推荐

-

1000元/天渗透测试,红队工程师中国科学院某研究所概要:本人有一个业内前沿水平的团队,主要业务是渗透测试,网络安全培训,攻防工具制作,ctf培训(各个方向)

-

500元/天k8s高级工程 师中科创达概要:掌握Shell、Python、Groovy、PHP、Asp编程 掌握K8s二进制和kubadmin

-

700元/天前端研发工程师云尖信息技术有限公司概要:熟练使用 android-studio,Eclipse,svn,git 等开发工具; 熟练掌握常用

-

500元/天学生无概要:会制作网页,爬虫,会java,python,写微信小程序,人工智能,单片机,嵌入式,Linux,c,

-

500元/天算法工程师广州数控设备有限公司概要:c,c++,python,ros,stm32,mcu,arduino,stm32,vs,html,c

-

500元/天学生天津工业大学概要:使用语言:Python,Java,C#,Vue,C,JavaScript,sql 擅长领域:机器学

-

1600元/天高级LabVIEW开发工程师北京中科泛华测控概要:1.对 LabVIEW 编程精通,而且也有大型程序的研发经历,善于解决研发过程中遇到的困难。 2.

1600元/天高级LabVIEW开发工程师北京中科泛华测控概要:1.对 LabVIEW 编程精通,而且也有大型程序的研发经历,善于解决研发过程中遇到的困难。 2. -

500元/天全栈开发及企业信息系统建设实施二重概要:从07年至今,一直参与企业信息化建设,经手过MES、PDM、ERP、EHR等多个系统,现作为企业信息