、

大数据工程师

- 公司信息:

- 上海欧点云科技

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 周六

- 周日

- 所在区域:

- 北京

- 昌平

技术能力

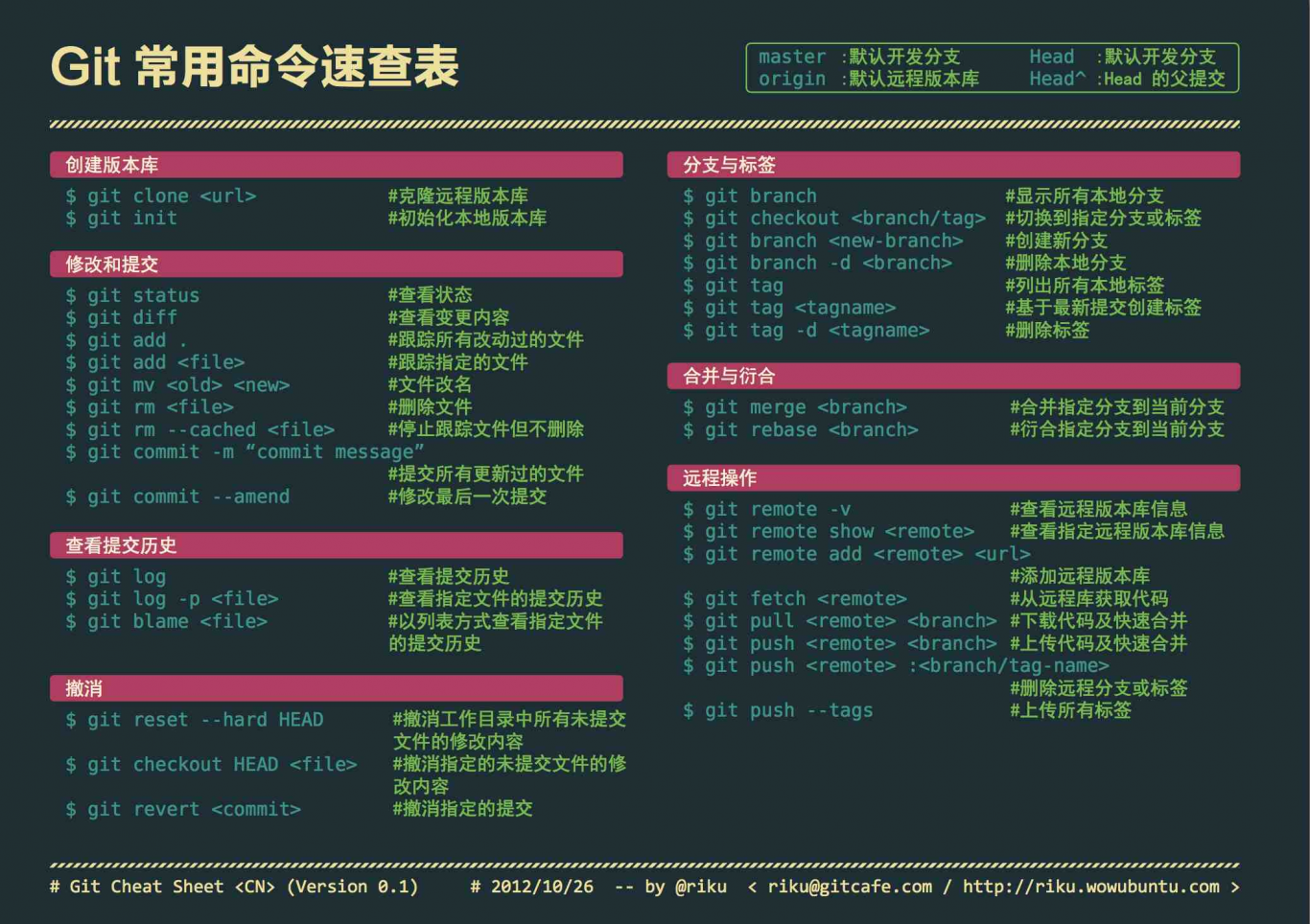

1、熟练使用 Java 语言,进行大数据开发,熟悉多线程,JVM 及垃圾回收机制。

2、熟练使用 Scala 语言,实现 SparkCore、Spark Sql、Spark Streaming 开发。

3、熟练使用 SQL 和 HQL,完成基于 Hive 数据的分析。

4、熟练使用 Linux 命令,能够进行 Shell 脚本的开发。

5、熟悉 MR 中 shuffle 运行原理,并能够使用 MR 进行业务开发熟悉 Yarn 中的资源调度过程和

Hadoop 相关组件及 Hadoop 高可用的搭建。

6、熟练使用 Hive 对分布在不同层次的海量数据做分析处理,能够对 Hive 进行调优。

7、熟练掌握 Spark,深入理解 Spark 工作机制,能够对 Spark 进行调优。

8、熟悉 Kafka 消息系统的工作机制以及 kafka 集群部署。

9、熟悉 Zookeeper 的架构,运行原理能为集群提供协调服务。

10、熟练使用 Flume、Sqoop、Datax 进行数据同步。

12、熟悉 Hbase 存储架构和 Phoenix 整合使用。

13、熟悉 Mysql 数据库,熟练编写 Sql 语句。

14、熟悉 Redis 的数据类型以及常规操作,了解 Redis 的持久化和主从配置。

项目经验

1.负责大数据平台搭建与维护,保障大数据平台正常运行和各个环节开发人员的正常使用。

2.参与部分静态数据获取与清洗,为下游系统提供数据支撑和接口

3.参与实时数据采集与处理应用程序的开发,参与能耗公式内存应用程序的开发

4.参与前端应用层平台搭建javaweb系统,为数据分析实现可视化展现

案例展示

-

电商

1、参与实时、离线数据仓库建设,负责大数据实时与离线处理程序开发。 2、理解并合理抽象业务需求,与业务团队紧密合作,发挥数据价值。 3、程序执行性能分析以及调优

-

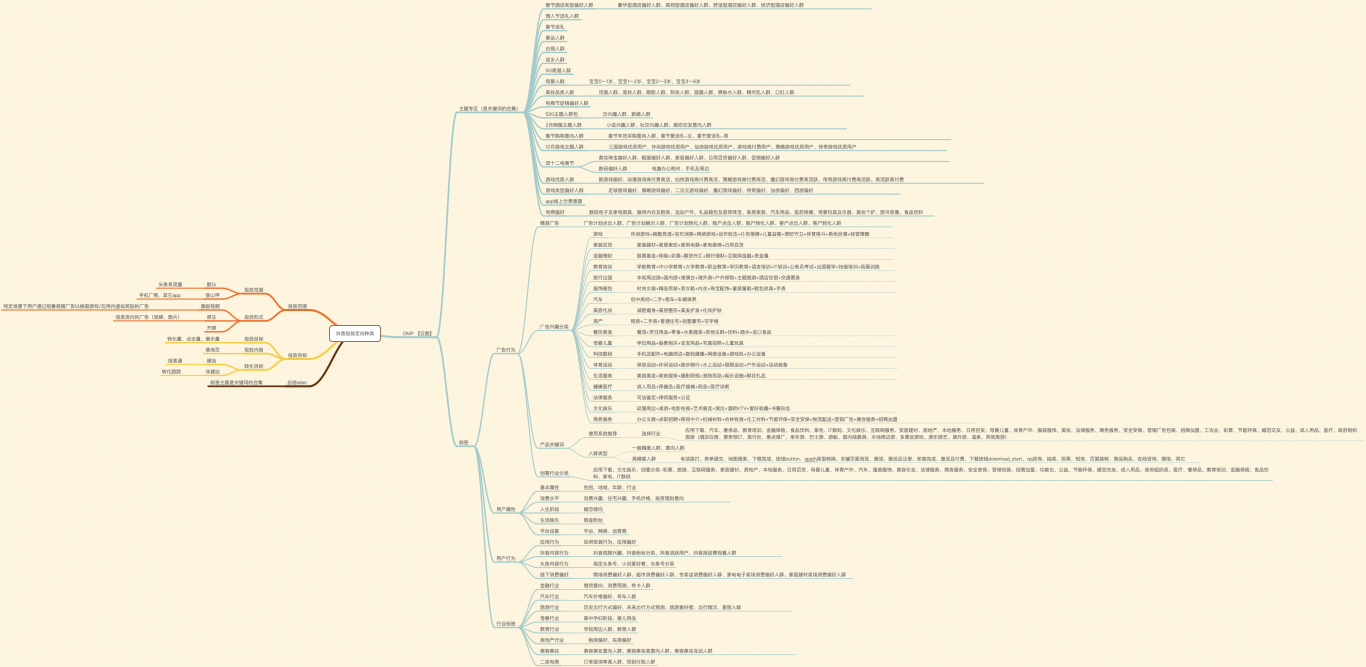

用户画像

公司在原有的电商分析系统上,对系统进行升级,通过实时检测并收集用户的行为数据,快 速分析用户浏览信息,关注内容等数据,定位用户需求和喜好,构建标签化用户信息,抽象出一 个用户的信息全貌,通过用户画像进行精准商品提供,提高用户体验和调正销售策略,为公司在 平台上针对不同用户推

相似人才推荐

-

500元/天PLC工程师日升自动化概要:做过设备维修员,负责厂区内水电气,有低压电工证,初级建构筑消防员资格证。 做过产品设计,设备制作。

500元/天PLC工程师日升自动化概要:做过设备维修员,负责厂区内水电气,有低压电工证,初级建构筑消防员资格证。 做过产品设计,设备制作。 -

500元/天电气工程师武汉精测集团有限公司概要:1、三菱PLC编程、欧姆龙PLC编程 2、EPplan电路图绘制、 3、三菱人机绘制、 pr

-

2000元/天项目经理海尔洗衣概要:在职专业互联网5年大厂团队,在线赚零花,团队豪华阵容,专业。APP及云平台已成功运营5年。流水线作业

-

500元/天在读研究生(生物信息学)广东工业大学概要:主要研究方向是生物信息学, 自己学习了机器学习, 计算机视觉, NLP方面的内容. 常用的开方软件p

-

500元/天图像处理工程师中船重工鹏力(南京)大气海洋信息系统有限公司概要:从事安防视频方面的图像处理及视频分析,掌握的主要算法包括图像检测、图像分类、图像相似性检索、图像语义

-

500元/天算法工程师平安科技概要:四川大学硕士在校生目前在平安科技实习算法工程师。熟悉语音识别相关算法。熟练使用JAVA Python

-

500元/天爬虫研发工程师博彦概要:主要从事于 python 开发,工作上主要使用 scrapy 框架,有部分反爬虫调试经验,能够逆向一

500元/天爬虫研发工程师博彦概要:主要从事于 python 开发,工作上主要使用 scrapy 框架,有部分反爬虫调试经验,能够逆向一 -

600元/天高级软件开发工程师旭创科技(苏州)有限公司概要:本人从事光通信领域工作已长达7年,个人精通LaBVIEW编程,熟练掌握C#编程。对无源器件和有源模块