丁龙

大数据开发工程师

- 公司信息:

- 杭州在信科技北京分公司

- 工作经验:

- 3年

- 兼职日薪:

- 1500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 可工作日驻场(离职原因)

- 可工作日驻场(自由职业原因)

- 所在区域:

- 北京

- 海淀

技术能力

深刻理解Hdfs分布式文件系统存储结构和高可用原理

熟练掌握Hadoop MapReduce计算框架编程,对yarn的资源调度,作业监控有一定认识

掌握Storm编程,深刻了解Spark底层运行机制,

掌握使用Flume日志采集结合Kafka、Spark\Storm实现实时计算业务

熟练使用Hive对Hdfs数据离线分析、Impala查询,并结合Sqoop对数据进行导入导出

理解Hbase的存储原理,Hbase存储架构,实现数据的毫秒检索

掌握redis内存数据库的基本原理,实现数据的毫秒查询

熟悉Scala语言、python语言、shell编程,熟练使用linux常用命令

熟悉MapReduce、Spark、Storm等计算框架并了解运行机制

熟悉Solr、ElasticSearch给数据建立索引

熟悉Docker、Alluxio

熟练使用CDH对集群进行监控管理,熟悉Ganglia,可用于监控集群服务器的运行状况

熟悉Kettle工具、熟悉使用Ooize调度hadoop任务

了解Mahout协同过滤算法,了解Kylin相关数据建模知

项目经验

【项目经验一】

项目名称:神龙大数据平台二期(2018.12-2019.07)

开发环境:IDEA、JDK1.8

主要技术:SpringBoot、MyBatis、Redis、SpringMVC、MySQL、ImPala、Kettle、Jenkins、

项目介绍:

该项目是在神龙汽车公司已有大数据平台基础上进行的二期项目开发,项目使用Kettle加Sqoop对各个子系统的数据进行采集入库到Hadoop平台。使用SpringBoot加Jdbc的方式开发RESTFul接口供前端调用ImPala数据库中的数据。

报表模块分为车辆健康预警模块、定保客户招揽模块、网点评价模块、车辆全生命周期查询、备件经营模块、售后经营报表、回厂时间预测模型、保客流失预警模型、数字营销报表。

职责描述:

1、负责将业务系统数据采集到大数据平台,业务系统包括CWEB、BPVN、BVVN、NGIC、DMS。

2、负责Kettle作业的开发设计与监控,数据抽取过程中状态写入Mysql数据库表。

3、负责后端接口开发和前后端接口调试。

【项目经验二】

项目名称:智网大数据平台(2018.07-2018.12)

开发环境:SecurceCRT、Centos7.2

主要技术:Shell、Jenkins

项目介绍:

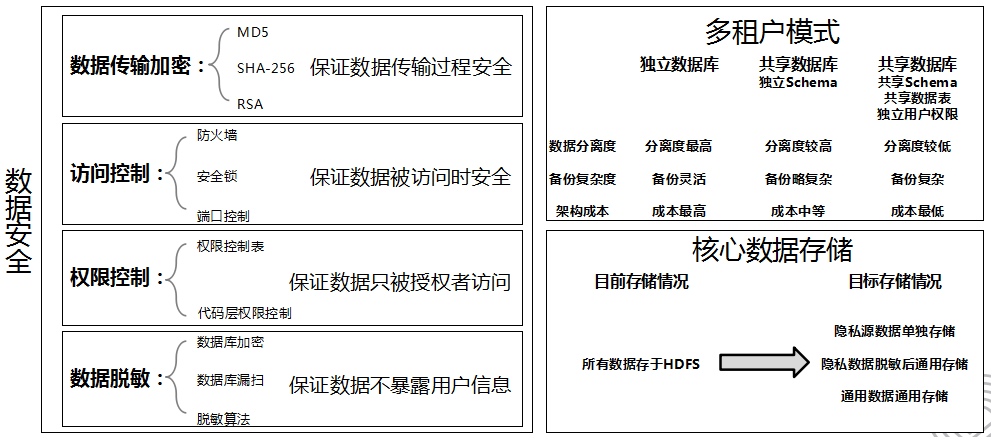

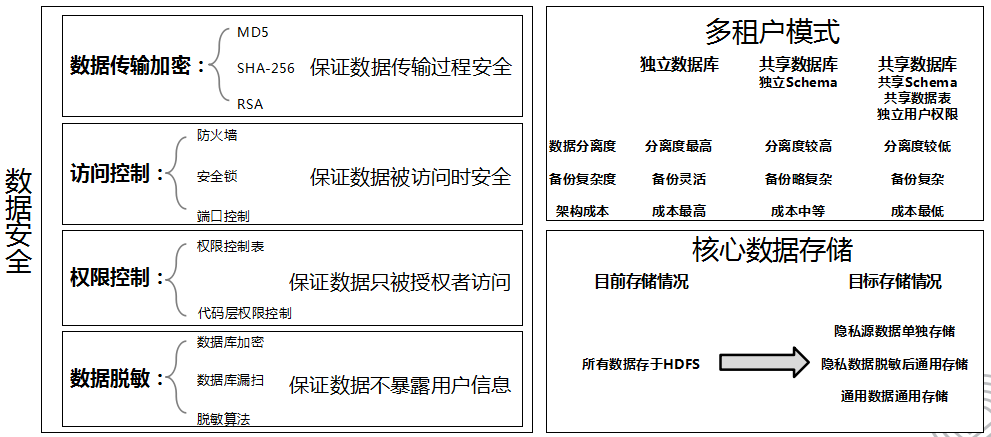

在大数据时代的环境下,公司需要有效利用多源、多结构数据,安全地进行数据加工和增值,建设公司自有数据能力并进行转化。因此公司对于大数据平台的数据生产(汇聚存储多源数据、自动化清洗与入库)、分析加工能力(公司经营分析报告、公司数据洞察报告)、数据安全(严格保证数据安全、多租户环境用户控制)和能力开放(多样化对外开放能力、平台能力模块化租赁)四个方面有极高的需求。

职责描述:

1、编写shell脚本每天定时采集接口机数据并入库到Impala数据库中。接口机数据包括JPO、AMSP、廊坊。

2、负责在线商店、TBOSS等结构化数据采集到Impala数据库中。

3、编写shell脚本对AMSP数据进行数据清洗操作。

4、编写shell脚本对接口机数据、入库后Impala表中的数据进行监控。

5、通过Jenkins对服务器之间的脚本进行作业调度与监控。

6、周期性检查每天的数据是否都入库,对于缺失的数据采取对应的措施。

案例展示

-

神龙大数据平台二期

该项目是在神龙汽车公司已有大数据平台基础上进行的二期项目开发,项目使用Kettle加Sqoop对各个子系统的数据进行采集入库到Hadoop平台。使用SpringBoot加Jdbc的方式开发RESTFul接口供前端调用ImPala数据库中的数据。 报表模块分为车辆健康预警模块

-

智网大数据平台

在大数据时代的环境下,公司需要有效利用多源、多结构数据,安全地进行数据加工和增值,建设公司自有数据能力并进行转化。因此公司对于大数据平台的数据生产(汇聚存储多源数据、自动化清洗与入库)、分析加工能力(公司经营分析报告、公司数据洞察报告)、数据安全(严格保证数据安全、多租户环境用户

-

比价平台

该项目主要是抓取京东、易迅、国美、苏宁等电商网站的商品,获取商品的标题、价格、规格参数等信息,在前台界面为用户提供商品搜索查询,以及商品比价等功能。 项目主要分为6个模块:数据下载层、数据解析层、数据存储层、数据处理层、数据展现层、系统监控层。

相似人才推荐

-

1000元/天高级软件工程师智信精密概要:7年机器视觉行业工作经验,熟练使用C/C++开发语言,熟悉C#,擅长使用MFC/QT/Duilib等

-

600元/天IT外服概要:1、熟练使用C,C++c#,vb等开发语言; 2、熟悉使用asp.net、html、xml、WCF

-

500元/天高级爬虫工程师vivo概要:1. Html css javascript 2. Python C/C++ QT 3. htt

-

500元/天技术国企,外企概要:6年技术岗位,参与大型项目开发,并是核心开发人员. 熟悉软件开发流程,熟悉c#语言、JQuery、

-

1000元/天算法工程师百度概要:精通python java c 爬虫 算法 微信小程序 公众号开发 web开发 精通

-

500元/天研究生南京航空航天大学概要:熟练掌握MATLAB和simulink,可编写有关数学的建模代码,如线性规划、遗传算法、神经网络、小

-

500元/天无无概要:Python 网络采集开发:BeautifulSoup、Selenium、XPath Python

-

800元/天C高级工程师长天科技有限公司概要:1、有Linux环境C语言基础,可开发linux系统应用 2、熟悉Unix环境高级编程,如IO操作