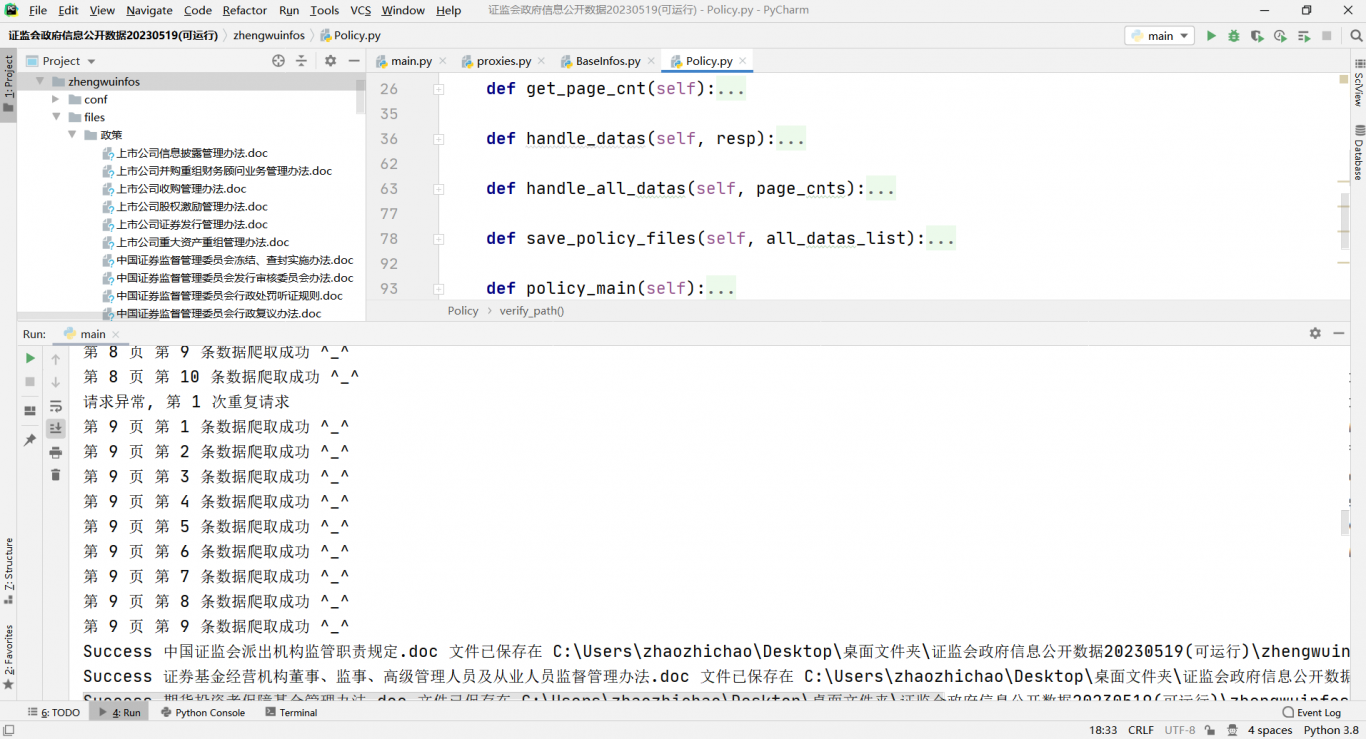

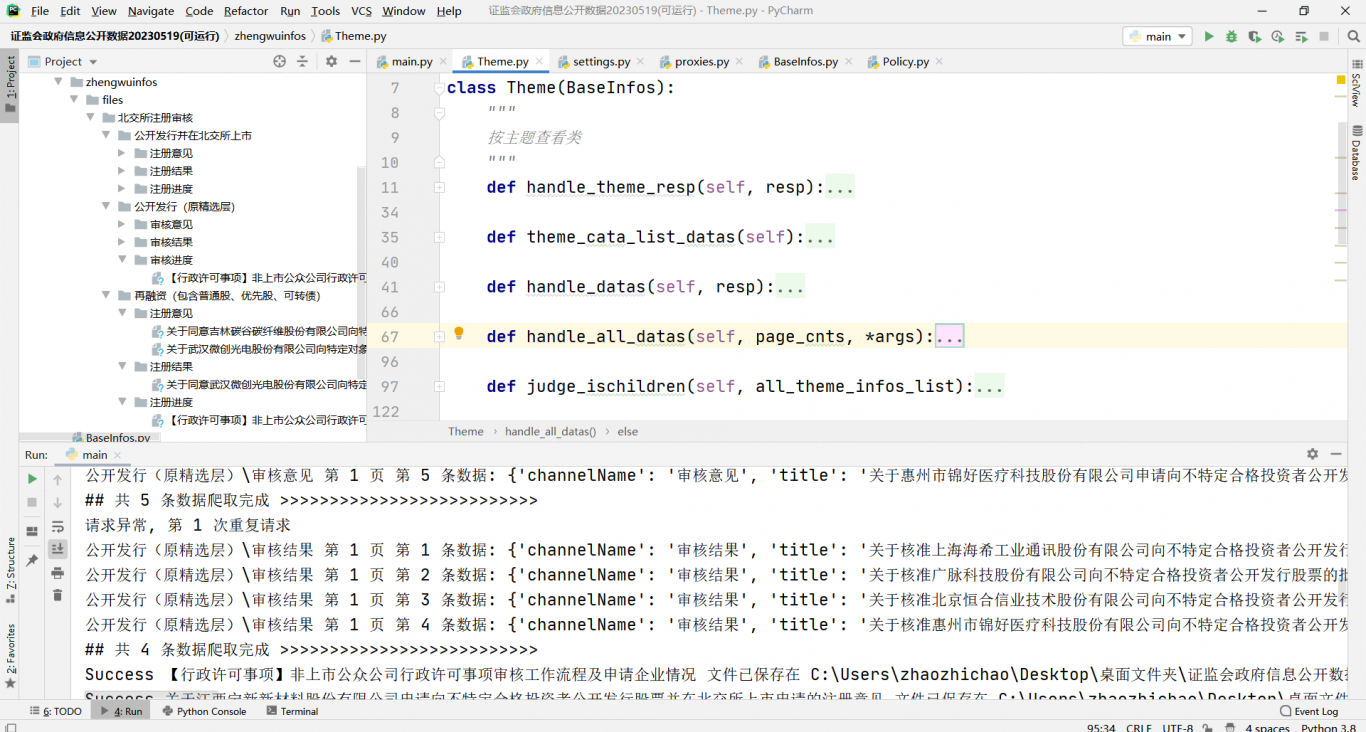

证监会网站数据爬取项目

根据网站信息,按照信息栏划分为两部分:政策类和按主题划分类,按体裁文种类同主题类 执行主函数,会在对应目录生成该类主题所有的目录层级和doc文件,代码中是按照面向对象逻辑思想使用了ip代理池,捕获异常重复发送请求,获取所需数据。 第二种方案:还可以基于scrapy框架实现该功能,只需在setting文件中配置完成中间件,UA集,代理池,下载器等,完成单任务spider任务的实现,开启scrapy项目即可。 第三种方案:还可以实现高并发任务的方式实现,利用多线程任务爬取不同专题数据 + 协程任务爬取不同页面数据也可以实现高效率的数据爬取。 后续优化完成进行补充.........