zero.

python爬虫

- 公司信息:

- 盛顺

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 其他

- 全区

技术能力

网络请求方面

多种请求库运用

熟练使用 requests 库发送 HTTP 和 HTTPS 请求,能处理各种请求方法如 GET、POST、PUT 等。可以设置请求头,模拟浏览器行为绕过一些简单的反爬机制,比如设置 User-Agent 伪装成常见浏览器。同时,对于需要登录验证的页面,能够通过传递 cookies 或者进行模拟登录操作获取页面数据。

处理网络异常

具备完善的错误处理机制。当遇到网络连接超时、服务器错误等情况时,能自动重试请求一定次数,并且记录错误日志以便后续分析。还可以根据不同的错误类型采取不同的应对策略,比如切换请求 IP(如果有代理池的话)等。

数据解析方面

HTML 解析

对于 HTML 页面,能够使用 BeautifulSoup 库进行解析。精准定位页面中的元素,通过标签名、类名、ID 等属性提取目标数据。可以处理复杂的页面结构,提取嵌套元素中的信息,并且能够对提取的数据进行清洗和预处理,去除多余的空格、换行符等。

JSON 数据处理

当遇到返回 JSON 格式数据的接口时,能轻松解析 JSON 数据并提取所需信息。理解 JSON 数据的嵌套结构,递归地获取深层数据。还可以将 JSON 数据转换为适合进一步处理的 Python 数据结构如字典、列表等。

反爬应对方面

IP 代理与轮换

拥有代理 IP 池管理能力,可以从代理服务器获取不同的 IP 地址用于发送请求,降低被目标网站封禁的风险。能够定期检测代理 IP 的可用性,及时剔除无效的 IP 地址。并且可以根据目标网站的反爬强度,动态调整请求使用代理的频率。

验证码识别

对于一些有验证码的网站,能够通过调用验证码识别库(如 Tesseract)或者使用打码平台的接口进行验证码识别。先下载验证码图片,进行预处理提高识别准确率,然后将识别结果用于登录或者提交请求等操作。

数据存储与管理方面

数据存储格式选择

可以根据数据的特点和后续使用需求,选择合适的存储方式。如将结构化数据存储为 CSV 文件以便于数据交换和在电子表格中查看;将数据存储到关系型数据库如 MySQL、PostgreSQL 中,利用数据库的事务处理、索引等功能提高数据管理效率;或者存储到非关系型数据库如 MongoDB 中,方便处理非结构化和半结构化数据。

数据去重与更新

在存储数据前能够进行数

项目经验

项目一:电商商品信息爬取与分析项目

爬取了多个主流电商平台上特定品类(如电子产品)的商品信息。使用 Python 的 requests 库发送请求,配合 BeautifulSoup 和 lxml 解析页面。通过设置随机的 User-Agent 和请求间隔来绕过反爬机制。对获取的商品价格、参数、评价等数据进行清洗整合,存储到 MySQL 数据库中。利用数据分析库如 pandas 和 matplotlib,分析价格走势、产品参数分布以及评价情感倾向,为市场调研提供有力数据支持,展示了强大的数据获取与分析能力。

项目二:学术文献检索与下载爬虫

目标是从多个知名学术数据库爬取特定领域(如计算机科学)的文献信息。采用 Selenium 模拟浏览器操作登录并进行搜索,处理复杂的验证码和动态页面加载。使用多线程技术加速爬取过程,将文献标题、作者、摘要、下载链接等信息提取并整理成结构化格式存储到 MongoDB 中。同时开发了自动下载文献的功能,方便后续研究,体现了处理复杂页面和多任务操作的技术水平。

项目三:社交媒体数据挖掘项目

聚焦于某热门社交媒体平台,旨在获取特定话题下的用户发言、点赞、转发等数据。利用 API 接口和模拟登录相结合的方式获取数据,在 API 访问受限的情况下,通过分析页面结构进行网页爬虫。运用正则表达式提取关键信息,对数据进行情感分析和用户关系网络构建,帮助了解话题热度和传播趋势,展示了在处理复杂数据结构和分析挖掘方面的实力。

案例展示

-

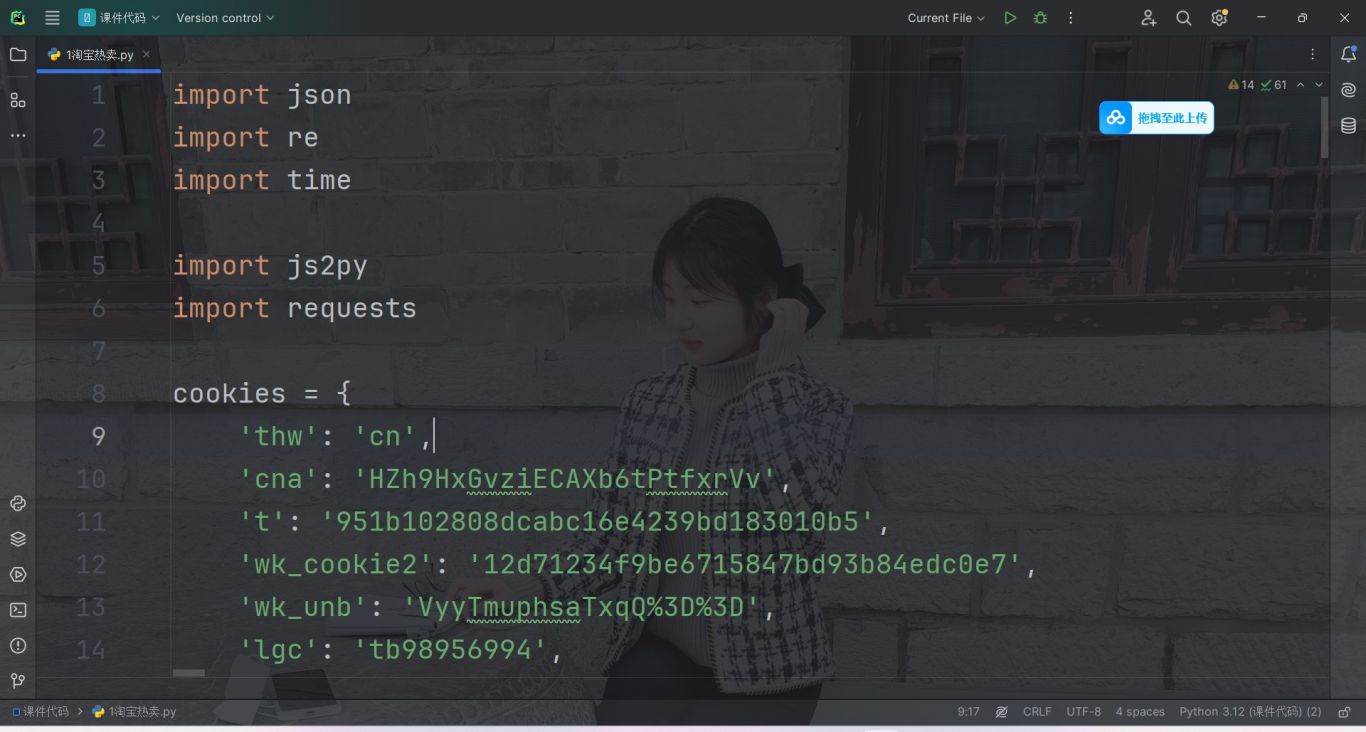

淘宝热卖

很多网页的核心数据是动态加载. 要去分析ajax/js. 找到里面的数据源 有的网页不需要登录/cookie认证. 因此找到数据源直接获取就完事 但是类似于淘宝这样的网站,它的数据生成会基于用户信息/cookie信息而改变 因此就需要携带用户cook

-

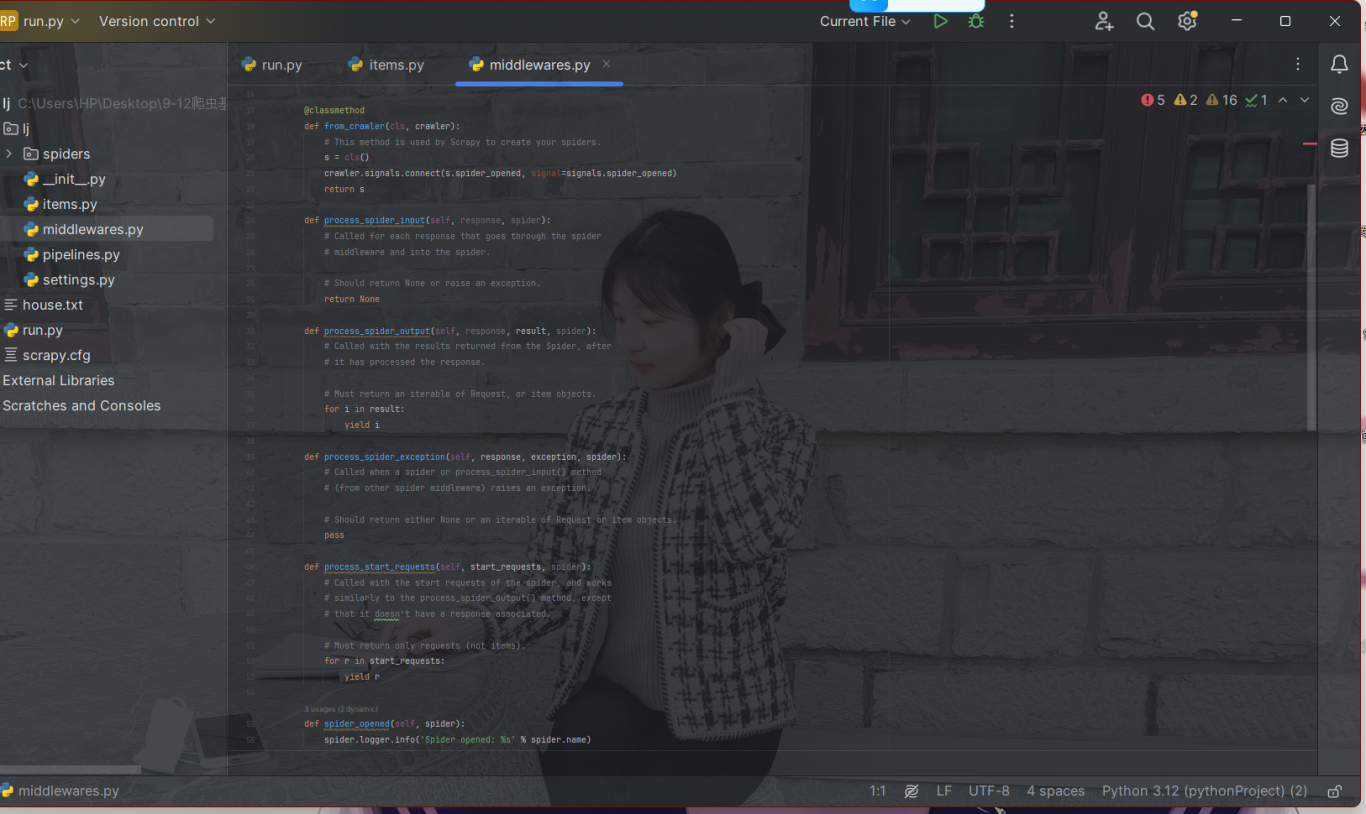

新浪新闻scrapy爬虫

1.创建项目 2.新建任务 3.修改配置文件 [setting.py] 只需要用到4个配置数据 [1.UA伪装 2.robot协议 3.并发数量 4.管道保存] # UA # 爬虫

相似人才推荐

-

1200元/天数仓字节跳动概要:python 爬虫相关技术,爬取网站的相关的数据。 数仓 大数据相关技术(spark、hive、h

-

500元/天全栈开发中国中铁概要:热衷于全栈开发,具备扎实的前端与后端技术基础。前端方面,精通Vue 3框架,能够构建响应式用户界面,

-

500元/天开发腾讯云概要:1. 8年工作经验,熟练使用多种编程语言,主要使用go、python 2. 熟悉web漏洞原理及检

-

800元/天后端开发工程师百度国际科技(深圳)有限公司概要:- 熟悉基于python的后端开发框架以及相关工具,如 flask,sqlalchemy, alem

-

500元/天后端工程师薪八达(北京)科技有限公司概要:编程语言:Python, Java 框架与技术:Flask, Spring Boot, Celer

-

500元/天高级技术咨询普华永道信息技术概要:熟练掌握C#,运用MVC模式开发Web应用 参与过大型Java项目 熟练掌握Python,爬虫,

-

1000元/天高级开发工程师不方便透露概要:1. 7年python经验,精通django、sanic等web框架 2. 3年java经验,熟练

-

500元/天AI算法工程师某国企概要:大模型应用搭建,搭建以及应用落地 / python java c 精通 /网站搭建,前后端联通以及深

500元/天AI算法工程师某国企概要:大模型应用搭建,搭建以及应用落地 / python java c 精通 /网站搭建,前后端联通以及深