勾勾

Python 数据分析 爬虫工程师

- 公司信息:

- 某国有银行科技部

- 工作经验:

- 2年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 所在区域:

- 杭州

- 西湖

技术能力

本人浙工大研究生毕业(学历可验),熟悉Python编程,有相关数据开发、数据分析、数据可视化、爬虫等能力,有使用MySQL、Neo4j等数据库等经验,数据挖掘分析、爬虫项目最为擅长。获得省级优秀毕业生、优秀研究生一等学业奖学金,发表了1篇SCI一区期刊论文、1篇SCI二区期刊论文、1篇英文书稿、3篇EI论文。某国有银行市分行金融编程技能大赛第一名。

技术栈:Scrapy、Redis、Postman、MySQL、MongoDB、Pytorch、Pandas、Matlabplotlib

项目经验

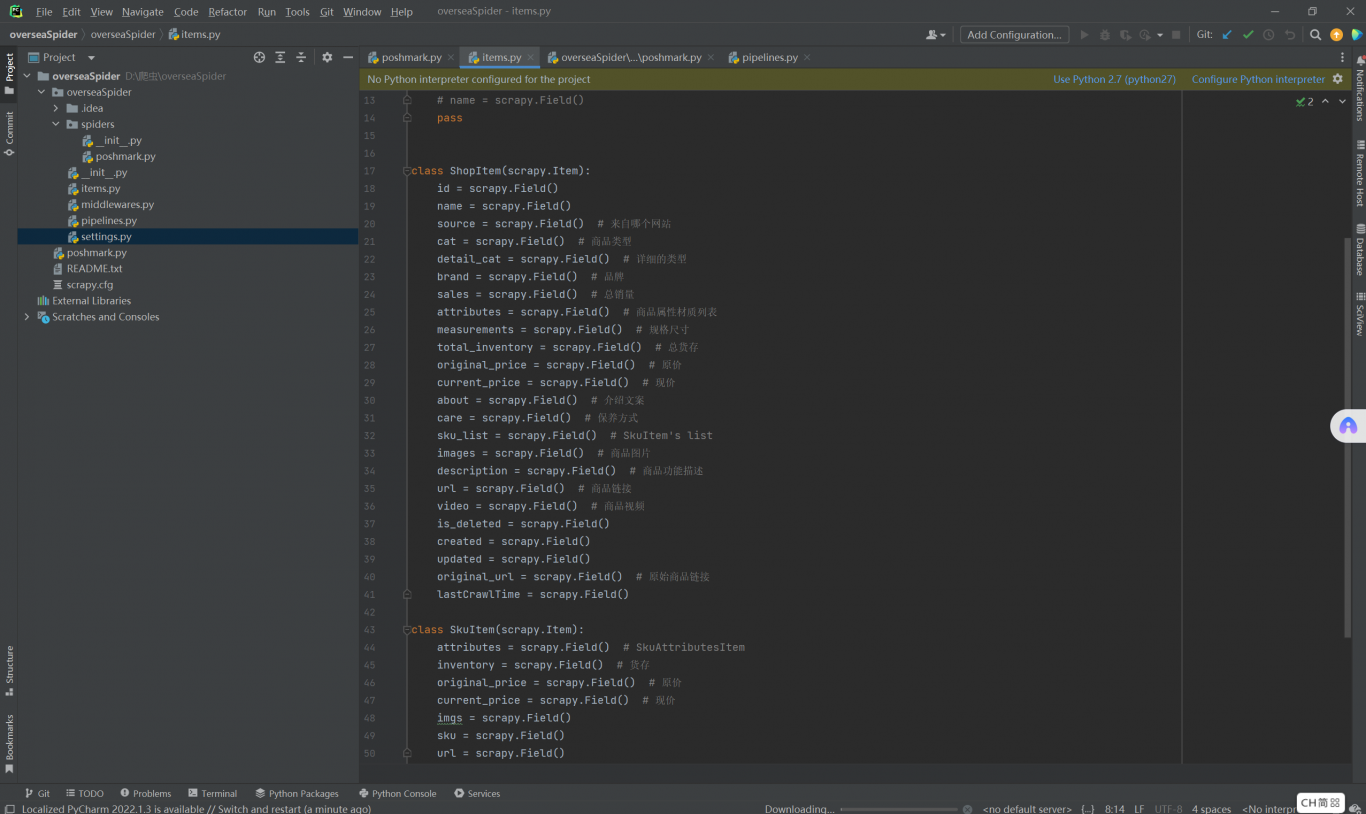

项目一: 爬取海外购物网站项目

技术栈:Scrapy、Xpath、Redis、Postman、MySQL、MongoDB

工作职责:编写爬虫程序,数据清洗,反反爬策略,维护IP代理池

项目描述:使用Scrapy框架,IP代理池、Xpath、Ajax、Postman等工具对商品的名称、价格、型号、详情链接等SKU数据进行爬取、解析等工作。将数据按照要求进行清洗并存储于MySQL和MongoDB数据库中。

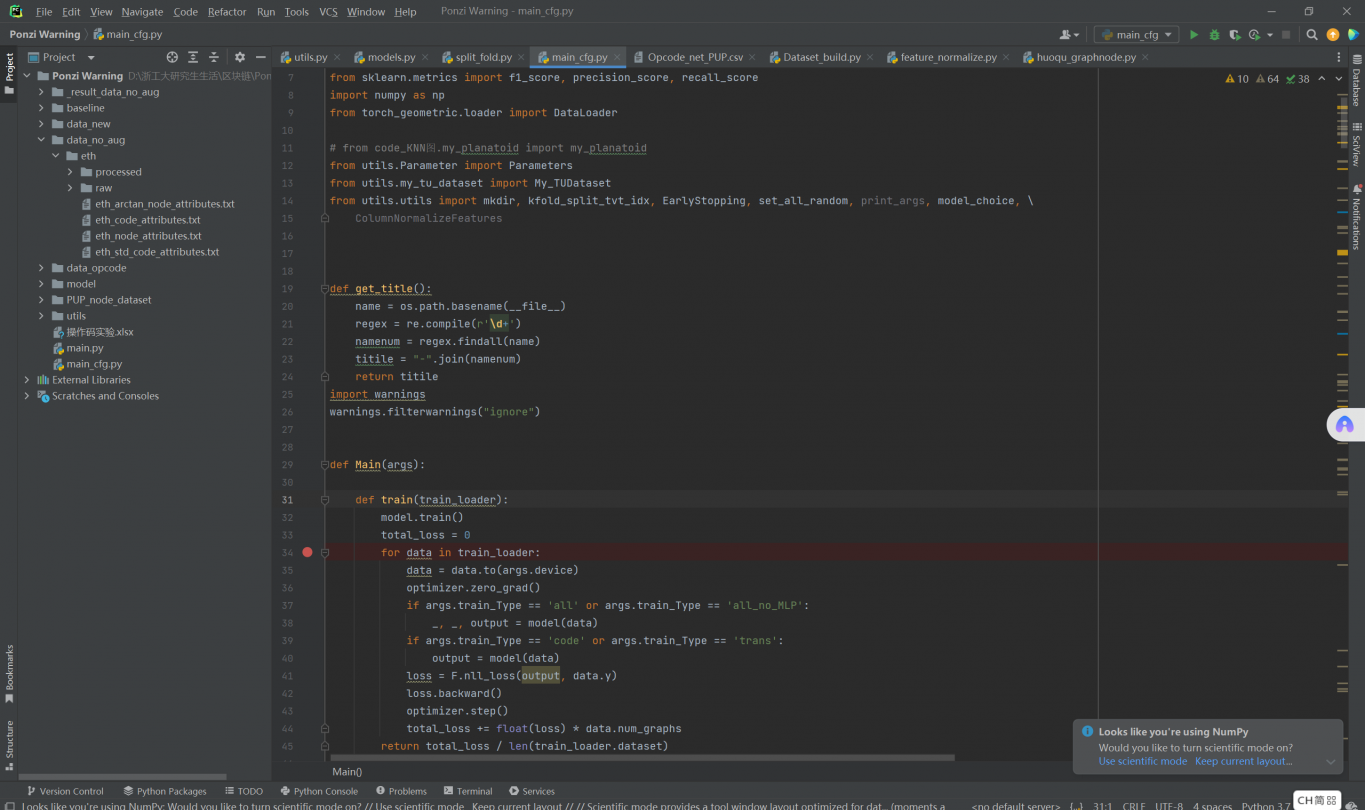

项目二: 以太坊庞氏骗局检测项目

技术栈:Pytorch、GNN、Neo4j、Networkx、Pandas、Numpy、Matlabplotlib

工作职责:数据存储、数据清洗、数据挖掘、搭建算法框架、数据分析

项目描述: 构建并使用Neo4j图数据库进行存储大规模交易数据(10GB);对数据进行清洗,提取初始特征工程,划分不同时序的数据切片图;使用Pytorch搭建动态图卷积神经网络深度学习算法框架,将其建模为图分类任务进行识别庞氏骗局。

项目三: 电商离线数据仓库项目

技术栈:Flume、Sqoop、HDFS、Hive、Spark、Superset

工作职责: 数据存储、数据清洗、数仓搭建、可视化

项目描述:利用Flume、Sqoop对电商平台中的日志数据和业务数据进行抽取并将数据同步至HDFS上,利用维度建模搭建离线数仓并结合业务特性进行数据建模,采用Hive On Spark解决实际问题,进行指标分析和数据可视化。

案例展示

-

爬取海外购物网站项目

使用Scrapy框架,IP代理池、Xpath、Ajax、Postman等工具对商品的名称、价格、型号、详情链接等SKU数据进行爬取、解析等工作。将数据按照要求进行清洗并存储于MySQL和MongoDB数据库中。擅长解决反爬、逆向挖掘的问题。

-

以太坊庞氏骗局检测项目

构建并使用Neo4j图数据库进行存储大规模交易数据(10GB);对数据进行清洗,提取初始特征工程,划分不同时序的数据切片图;使用Pytorch搭建动态图卷积神经网络深度学习算法框架,将其建模为图分类任务进行识别庞氏骗局,数据分析以及可视化

相似人才推荐

-

500元/天无无概要:拥有Python开发经验,擅长使用Python进行后端开发和自动化脚本编写。熟练掌握Python核心

-

500元/天全栈开发工程师好大鹅概要:全栈:前端vue、react、后端go、rust 1、独自给甲方开发过众多ai盈利的项目,对第

-

500元/天自动化开发工程师华勤科技概要:有扎实的 Python 编程基础,熟悉面向对象编程思想; 能够熟练使用 python 进行编程

-

700元/天windows应用开发工程师通信技术概要:windows应用开发。擅长通信类前置机、主站开发。 长期从事tcp通信相关开发。rs232串口、

-

500元/天无无概要:编程语言 Python JAVA c++ html css js vue3 操作系统 Linux

-

500元/天高级C++开发行星科技概要:掌握的技术: 1. 熟练掌握Java、Python、C++等编程语言,具备扎实的计算机基础知识

-

500元/天实施工程师信华信技术股份有限公司概要:熟练掌握通过帆软FINE-REPORT工具,根据现场实际需求,进行报表及可视化大屏制作 熟悉ora

-

500元/天机械工程师机械厂概要:本人曾从事过机械方面的设计,也拿过产品外观设计的专利,二维图,三维图,以及市政管道布置,污水处理站的