Siri

大数据开发

- 公司信息:

- 通付盾

- 工作经验:

- 2年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 可工作日驻场(离职原因)

- 可工作日驻场(自由职业原因)

- 所在区域:

- 苏州

- 全区

技术能力

负责设计和规划数据采集策略,运用各种工具和技术进行数据的收集工作

▪ ETL 设计、实现与优化,负责公司项目数据平台的数据准确性和高效性

▪ 数据仓库的建设,与技术部团队协作完成数据仓库建设推进,提升数据处理效率,解决数据工程各类问

题

▪ 负责完成模型/系统代码的实现优化,分析完善模型需求的开发,编写代码注释和开发文档

▪ 负责 WEB3 区块链节点基础设施的搭建和维护,通过脚本数据解析入库。

▪ 大数据集群 CDH 节点部署,其他组件环境安装配置,后续的组件服务优化维护。

▪ 实时(Flink)/离线(HIVE)应用任务的开发、部署和维护。

▪ 开发 Flink 实时流任务上传自定义执行平台执行,入 Hbase\mysql\redis\es\hive 数据库,或建立 hbase 与

hive 映射表用以导出 hive 离线任务结果集至 hbase,根据不同需求使用 redis 或其他缓存

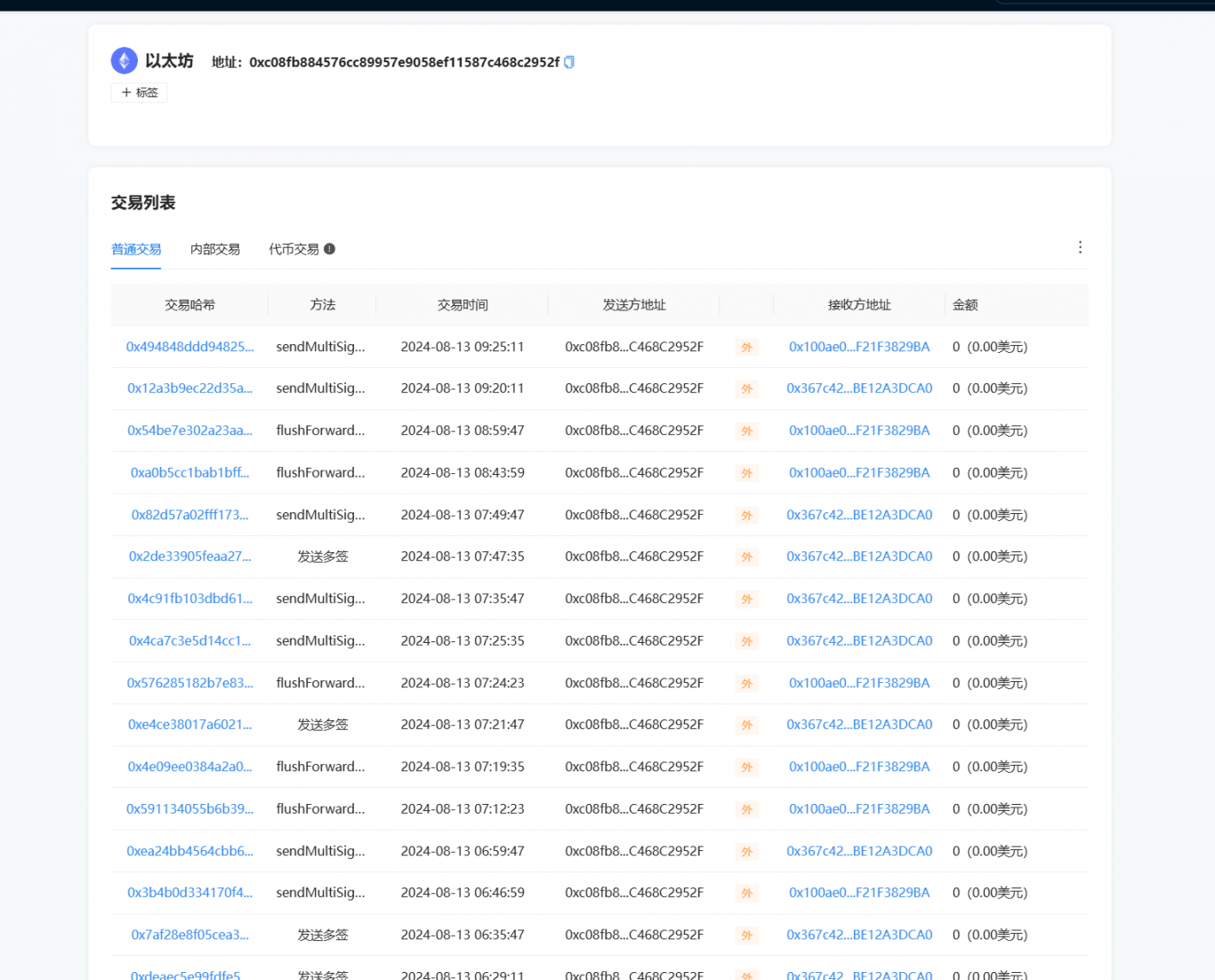

▪ 使用 Selenium+WebDriver 控制浏览器驱动进行地址\交易的标签别名爬取入库

▪ 测试数据的准确性和时效性 (ChainAegis - 全球领先的链上智能风险识别平台)

▪ 负责大数据部门 Git 上项目的权限使用及维护

项目经验

ChainAegis - 全球领先的链上智能风险识别平台

ARB(Arbitrum One chain)nitor + geth + prsm

• Arbitrum One chain 全节点的建设,包括 Layer1 层 Ethereum 和 prysm 的部署安装,结合第三方 RPC 节点有

效同步区块高度

• 通过了解 ethereumetl 源码和二次开发 Web3j 的 JAVA 库,使用本地 RPC 接口解析并导出区块、交易、日志、

内部交易等数据,写入至 kafka

• 根据 ETH\BSC 指标做出优化开发,将基础数据清洗,转换、入库,为前后端基础数据 的查询做支撑

• 根据需求完成实时流处理模型的开发及优化(部署\调用合约攻击监测,流动性排行、预警,RugPull 预警,大额转

账等)

BSC(BNB smart chain)geth(48club)

• BNB smart chain (bnb)全节点的搭建及维护,有效同步区块高度

• 使用 ethereumetl 执行命令将区块、交易、日志、内部交易等数据导出至文件,开发并执行 jar 包读取文件写入

至 kafka

• 将基础数据清洗,转换、入库,为前后端基础数据 的查询做支撑

• 根据需求完成实时流处理模型的开发及优化(部署\调用合约攻击监测,流动性排行、预警,地址交易预警,

RugPull 预警,大额转账等)

ETH (Ethereum chain) geth

• Ethereum chain 节点的更新及维护,确保其有效连接主网

• 需求指标开发

BTC (Bitcoin chain) bitcoincore

• Bitcoin chain 节点的更新及维护,确保其有效连接主网

工作经历

• 使用 bitcoin-etl 命令导出数据至文件,使用 filebeat 日志采集工具将数据采集写入 kafka(弊端,缺失数据)优

化 btc 数据导出,使用自定义 jar 包读取文件写入 kafka

Flink 实时流处理引擎(自主研发)

• 是一款针对 Flink 任务运行的一站式运维平台,主要为上传、下载 jar 包、简化提交、执行 Flink 任务,测试和生

产环境隔离,任务版本维护,关系型数据库存储元数据,任务失败预警提醒等功能

• 使用 HDFS 和 YARN 官方接口,对接处理引擎接口,启动、停止并监控任务的运行情况

• MySQL 保存平台使用者的账号密码,确保使用者操作隔离,任务维护划分。使用 MD5Hash 保存 jar 包上传在

HDFS 上的路径进行版本控制

• 内部配置区块节点监控,节点异常实现开发维护者进行手机提醒,确保区块数据准确性。对开发者,维护者有着

良好的交互,可进行有针对性的二次开发

• Flink+ HDFSApi + YarnApi + Mysql + SpringMVC + vue + 阿里钉钉 + Web3j

案例展示

-

ChainAegis链上智能风险识别平台

ARB(Arbitrum One chain)nitor + geth + prsm • Arbitrum One chain 全节点的建设,包括 Layer1 层 Ethereum 和 prysm 的部署安装,结合第三方 RPC 节点有 效同步区块高度 • 通过了解 et

-

Flink 实时流处理引擎(自主研发

• 是一款针对 Flink 任务运行的一站式运维平台,主要为上传、下载 jar 包、简化提交、执行 Flink 任务,测试和生 产环境隔离,任务版本维护,关系型数据库存储元数据,任务失败预警提醒等功能 • 使用 HDFS 和 YARN 官方接口,对接处理引擎接口,启动、停止并

相似人才推荐

-

500元/天数据分析师腾讯概要:1.个人画像:211院校,5年数据分析经验,3年数据治理经验,对数据敏感,擅长数据驱动业务。 2.

-

500元/天博士研究生西南交通大学概要:我在技术研究与应用领域展现出了一定的专业素养与技术能力。熟悉多种编程语言,主要对Python编程语言

-

500元/天中级Java全栈开发工程师山东德晋新能源有限公司概要:1.熟练掌握Java基础 ,io流,反射,stream流,多线程,字符串处理 2.熟练掌握vue以

-

800元/天产品经理成都市如织磐石科技有限公司概要:Vue、Element-ui、PHP、Uniapp、Photoshop等。专业团队,拥有UI设计师前

-

1000元/天高级算法工程师锐捷网络股份有限公司概要:自工作以来一直从事图形图像,模式识别,计算机视觉、自然语言处理、大模型算法等方面相关研发工作,并且带

-

800元/天算法工程师无锡奥特维概要:我是一名算法工程师。在技术领域,我具备扎实的理论基础和实践经验。我精通Python和C++编程语言,

800元/天算法工程师无锡奥特维概要:我是一名算法工程师。在技术领域,我具备扎实的理论基础和实践经验。我精通Python和C++编程语言, -

800元/天高级开发工程师多拼多惠(北京)科技有限公司概要:1. 微信小程序框架:包括WXML、WXSS和JavaScript。 2. 开发工具:微信开发者工

-

1000元/天数据中台中银富登村镇银行概要:熟练 Hive、MySQL等 SQL和 starrocks 数据库及大数据 Hadoop 相关生态圈

1000元/天数据中台中银富登村镇银行概要:熟练 Hive、MySQL等 SQL和 starrocks 数据库及大数据 Hadoop 相关生态圈