之遥

Python开发工程师

- 公司信息:

- 马蜂窝

- 工作经验:

- 6年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 济南

- 全区

技术能力

作为一名拥有6年马蜂窝网站工作经验的Python开发工程师,我具备以下技术能力:

1. 精通Python编程语言,熟悉面向对象编程思想,具备良好的编码习惯和编程风格。

2. 具备较强的数据挖掘能力,熟练掌握Pandas、NumPy等数据处理库,能够对海量数据进行清洗、分析和挖掘。

3. 擅长网络数据抓取,熟练使用Scrapy、BeautifulSoup、Selenium等爬虫框架和库,能够高效地抓取各类网站数据。

4. 熟悉数据库技术,包括MySQL、MongoDB等,能够进行数据库设计、优化和数据存储。

5. 掌握常用的数据分析和可视化工具,如Matplotlib、Seaborn、Tableau等,能够将数据分析结果以图表形式直观展示。

6. 了解大数据技术,如Hadoop、Spark等,具备一定的数据处理和分析能力。

7. 熟悉Linux操作系统,能够使用Shell脚本进行自动化运维。

8. 具备良好的团队合作精神和沟通能力,能够独立解决问题,并具备一定的项目管理经验。

项目经验

以下是我在马蜂窝网站工作期间的一些项目经验:

1. 旅游产品推荐系统:开发了一套基于用户行为和兴趣的旅游产品推荐系统。通过分析用户浏览、搜索、收藏等行为数据,运用协同过滤、矩阵分解等算法,为用户提供个性化旅游推荐,提高用户转化率。

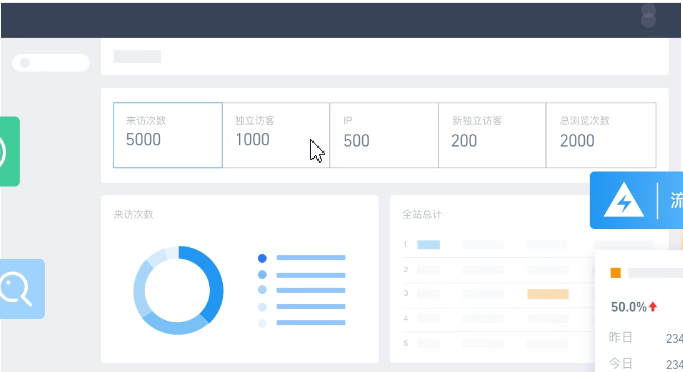

2. 网站流量分析平台:负责搭建一个实时流量分析平台,对网站访问数据进行实时采集、处理和分析,为公司提供用户行为、流量来源、页面热点等数据支持,助力产品优化和运营决策。

3. 竞品数据抓取与分析:利用Scrapy爬虫框架,抓取竞争对手的旅游产品信息,包括价格、销量、评价等,通过数据分析,为公司制定市场策略提供参考。

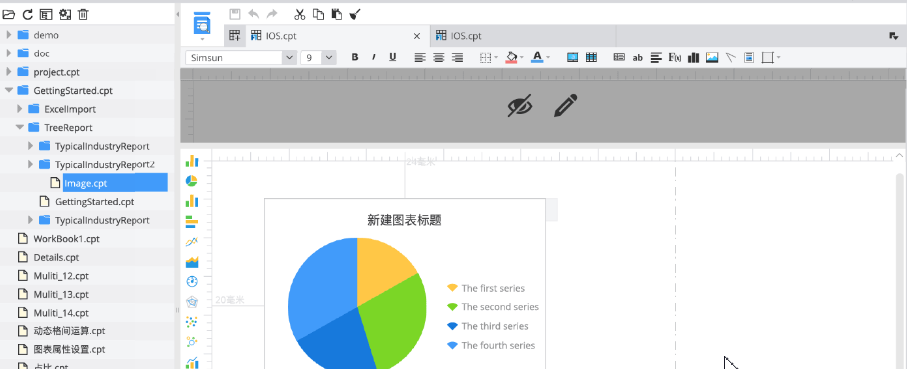

4. 数据报表自动化:使用Python编写脚本,实现每日、每周、每月数据报表的自动化生成,提高数据分析效率,减轻人工负担。

5. 旅游攻略内容审核系统:参与开发一套旅游攻略内容审核系统,通过规则引擎和机器学习技术,对用户发布的攻略进行实时审核,确保内容合规。

6. 数据仓库构建与优化:负责公司数据仓库的构建和优化工作,通过ETL工具将多源数据整合至数据仓库,为公司提供统一、高效的数据查询服务。

案例展示

-

竞品猎手

在“竞品猎手”项目中,担任了项目核心开发工程师。以下是这项目中负责的具体工作: 1. 技术选型与框架搭建:选择了Scrapy作为主要的爬虫框架,因为它的高效性和灵活性能够满足我们对大规模数据抓取的需求。同时,负责搭建项目的基本架构,包括爬虫的分布式部署、数据存储方案以及异常处理

-

智能报表生成器

在“智能报表生成器”项目中,担任项目的主要开发者。以下是在这项目中承担的具体职责: 1. 需求调研与方案设计:首先与业务部门沟通,了解他们对报表的具体需求,包括报表内容、格式、更新频率等。基于这些需求,设计了报表自动生成的整体方案,并选择了合适的工具和技术栈。 2. 技术选型

相似人才推荐

-

500元/天学生广西理工职业技术学院概要:----------精通python语言, ----------熟练web前端技术, -----

-

500元/天高级iOS开发工程师广东鸿正软件技术有限公司概要:技术能力: 熟悉python、golang程序开发, 熟悉flask、gin框架,熟悉HTML、

-

500元/天python工程师金税信息概要:1.扎实的linux Python/c语言编程基础,熟悉tornado,flask,django框

-

500元/天学生河南工学院概要:我是一个精通熟练的使用Python的大学生,拥有扎实的编程基础知识和对技术的热情,我现在掌握了Pyt

-

500元/天自由开发者无概要:我热爱编程,同时自学了几种编程语言,如python,C,C++,其中我精通的语言是python。我做

-

1000元/天平台开发工程师网易概要:1. 熟悉Linux操作系统和Shell脚本编程。 2. 熟悉Python编程语言进行后端开发,熟

-

500元/天python开发工程师南京华苏科技有限公司概要:语言:python 技术方向:web开发、机器学习、爬虫、数据分析、pc端小工具开发 数据库:m

-

500元/天全栈无概要:我们是一支由一群对计算机技术充满热情的爱好者组成的团队,我们热衷于编程,对技术的追求从未停歇。我们的