Nick Hui

高级数据开发工程师

- 公司信息:

- cognizant

- 工作经验:

- 6年

- 兼职日薪:

- 1000元/8小时

- 兼职时间:

- 可工作日远程

- 可工作日驻场(自由职业原因)

- 所在区域:

- 上海

- 浦东

技术能力

1.熟练掌握 python3 编程,会java、shell、scala语言

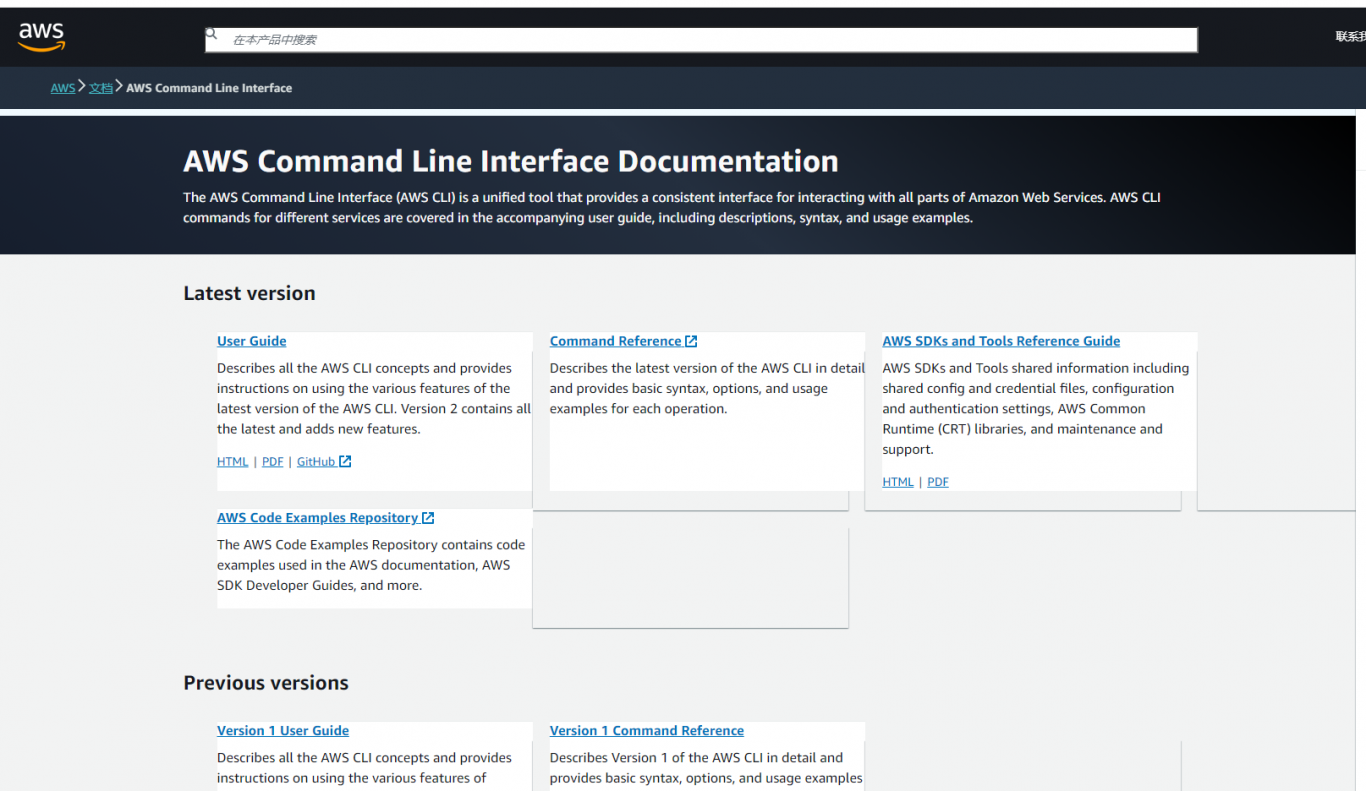

2.熟悉 aws 服务,hadoop生态

3.采集方面,掌握python的爬虫框架scrapy

4.数据处理 ,掌握数据清洗etl相关技能,kettle,airflow, pyspark

5.数据存储 ,熟练mysql,熟悉hive,hbase,oracle,sqlserver,redis,mongdb,postgresql等数据库

6.python框架,擅长django,熟悉flask、fastapi框架

7.web前端:能熟练使用html、css、javascript语言,掌握jquery、vue、react框架

8.部署:熟悉linux,docker管理, jekins , aws

项目经验

数据迁移项目 .

背景:主数据来自诺华公司concur报销数据,eapproval数据等,最终生成7 张报 告,原系统用的sqlserver的存储过程生成报告,繁琐而复杂,公司不用原系统了,决定走spark服务,

开发过程:

1、 建立数据模型,生成sttm报告

2、 根据数据模型将数据分层,大的层级有3层

第一层:raw层,主要将原始文件数据接进来,根据业务情况分增量数据和全量数据,又分了三层,pre_landing层(对原始文件进行处理成统一csv文件并备份),landing层(将csv文件写入redshift库),landing_merge层(对增量数据做处理).

第二层:unified 层,将raw层的各个表数据进行清洗,并做逻辑关联处理,落地到redshift库中(底层数据在s3上)

第三层:publish层,将unified层数据做逻辑处理落地到postgresql数据库中,再读取各个表数据生成7张报告推送到publish层的s3上

3、 开发并部署,主要使用的pyspark做开发,用jekins做部署,用airflow 做调度,生成的gluejob运行在aws的云服务上

案例展示

-

人力资源数据中台

该项目旨在帮助HR以及上层领导实时掌握各部门员工的动态信息,包括但不限于(入职、考勤、薪酬、安全事件、组织绩效、离职)等 开发过程: 1、 同数据组经理调研落实大领导的实际需求以及各HR小组的需求,设计开发规范、开发流程、预期效果等(临时兼任产品经理) 2、 了解整个公司

-

数据迁移

(因为保密协议项目图片无法取出) 该项目是个数据迁移项目 . 背景:主数据来自诺华公司concur报销数据,eapproval数据等,最终生成7 张报 告,原系统用的sqlserver的存储过程生成报告,繁琐而复杂,公司不用原系统了,决定走spark服务, 开发过程: 1

相似人才推荐

-

1000元/天图像算法工程师森兰信息概要:熟练掌握Python\OpenCV\Tensorflow\Pytorch 等神经网络框架,精通各种图

-

800元/天软件开发主管康奈集团限公司概要:的公司,团队从0开始组建,共16位成员。其中JAVA工程师8位,前端工程师3位,开发助理5位。主导开

-

500元/天Python工程师成都阿加犀智能科技有限公司概要:网络爬虫技术: 掌握Python的爬虫库,如requests用于发送HTTP请求,Beautifu

-

500元/天算法工程师字节跳动概要:数学专业基础:插值、拟合、迭代、最优化等理论 统计基础:回归分析、方差分析、聚类分析、PCA等

-

500元/天无无概要:本人大学生,相接点单赚零花钱,价格可以很低,未解决不收取费用。自学基本的编程知识,什么类型的语言都能

-

500元/天项目经理腾讯投资子公司概要:网站系统全栈开发:php+mysql ,自研系统框架 项目规划:提供项目探讨以及实施规划 项目运

-

500元/天数据分析师(Data Analyst)武汉武商电子商务有限公司概要:数据分析与处理能力: 熟练掌握数据分析工具,如Excel、SQL、Python等,能够高效地进行数

-

2000元/天ColdFusion DeveloperWEG概要:1、拥有近20年的Web系统平台开发经验,其中12年在美国工作,积累了丰富的国际项目经验和跨文化沟通