回声

网络运维

- 公司信息:

- 厦门爱粉科技有限公司

- 工作经验:

- 4年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 上海

- 浦东

技术能力

我是一名熟练掌握Linux系统的技术人员,精通Shell脚本编写,能够实现高效的自动化运维工作。我具备扎实的Python编程能力,特别是在爬虫数据采集方面有丰富的经验,能够从网络中提取和处理大量信息。此外,我熟悉网站架构的部署与搭建,能够从零开始搭建稳定高效的网站系统。我致力于不断学习和提升自己的技术水平,以应对不断变化的技术挑战,为团队和项目贡献更大的价值。希望我的专业技能和热情能为您的团队带来帮助

项目经验

在我的职业生涯中,我曾负责管理和搭建过100多个网站,项目采用了先进的技术架构和多层次的安全措施,以确保网站的高效运行和数据的安全。

技术架构

项目架构选用了nginx+tomato+mysql的组合,前后端分离,并加入缓存机制。这种架构不仅提升了网站的响应速度,还提高了整体的稳定性和扩展性。

自动化运维

为了简化运维工作,我编写了多个Shell脚本,实现了网站数据库的自动备份。备份数据存储在一台安全服务器上,该服务器仅允许特定的内部服务器访问,所有外部地址一律拒绝访问,确保了数据的安全性。

安全监控与防护

我还设置了实时监控系统,持续监控网站运行状态。一旦检测到网站受到攻击或出现其他问题,我能及时采取相应措施。例如,通过设置白名单来限制访问权限,并结合云服务提供的安全功能,确保网站在受到攻击时仍能正常运行。

项目成效

这些措施的实施,不仅保障了网站的快速访问和稳定运行,还大幅度提高了数据安全性和应急处理能力。在项目的管理过程中,我积累了丰富的经验,并提升了对大规模网站架构和运维的理解和掌控能力。

通过这些项目的参与,我不仅深化了对各类技术的掌握,还培养了高效解决问题的能力,为后续的工作打下了坚实的基础。

案例展示

-

通过爬虫抓取目标内容

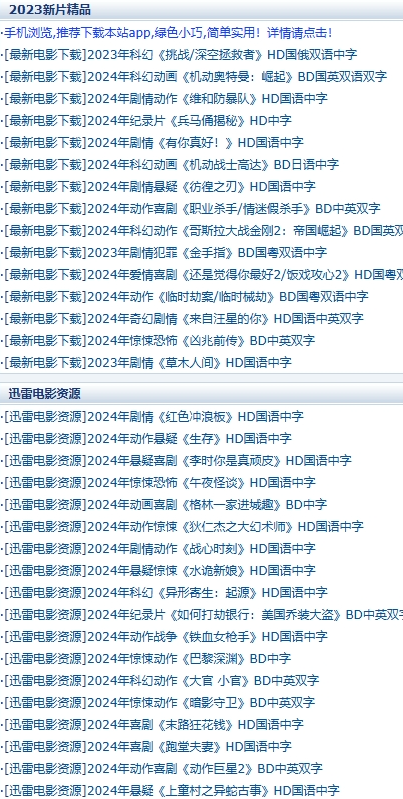

这个项目旨在从某电影网站 抓取最新电影的下载链接和电影名称,并将其保存到本地的 JSON 文件中。项目实现了以下主要功能: 网页内容获取: 通过发送 HTTP 请求,从指定的 URL 获取网页源码。 处理服务器可能返回的压缩内容,自动识别并解压缩 gzip 和 deflat

-

python轻量化抓取目标站点图片并下载

在本项目是一个轻量化网络爬虫,利用 Python 的 requests 和 BeautifulSoup 模块,从指定的目标网站抓取图片并将其保存到本地。 项目目标 从目标网页抓取图片,并将这些图片保存到本地文件夹。 项目步骤 导入必要的模块: 使用 reques

相似人才推荐

-

500元/天超级计算机运维工程师国防科技大学银河技术服务部概要:熟练使用C++进行编程,熟悉Python、SQL等; 熟悉计算机网络七层模型结构,网络通信TCP/

-

500元/天高级运维工程师北京博锐尚格科技有限公司概要:操作系统:Linux、国产 Kylin 数据库:MySQL、SQL server、Oracle、R

-

800元/天运维工程师成都产业投资集团有限公司概要:1.熟悉磁盘LVM磁盘管理 ,操作PV ,VG, LV对存储进行合理分配; 2.熟悉使用 ansi

-

1000元/天云计算架构师埃森哲信息技术(大连)有限公司概要:1、具备 Azure、Amazon云平台开发经验;熟悉云产品的特性并提供合理解决方案 2、对微服务

-

500元/天运维工程师广州森锐科技概要:专业技能1、熟练掌握操作 Linux 系统(CentOS/RHEL7)日常维护和问题排査2、熟练 A

-

500元/天运维工程师明思(上海)软件技术有限公司概要:熟悉Jenkins、Nexus、Nginx、Docker、Prometheus、MySQL、Naco

-

500元/天Devops开发睿魔智能科技(深圳)有限公司概要:1、管理企业云服务器包括(AD域,PLM,FTP,NAS,DHCP,DNS,Jenkins服务器)等

-

800元/天信息安全工程师陕西星川暮希网络科技有限公司概要:参与多次hw行动,保证甲方零失分,信息安全工程师,熟悉应急响应,溯源,处置等,熟悉各个安全厂商设备,