用户7908729170 身份已认证

爬虫工程师

- 公司信息:

- ..

- 工作经验:

- 2年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 北京

- 海淀

技术能力

框架与库

Selenium:利用Selenium模拟真实用户操作,处理动态加载内容和JavaScript渲染的页面,确保数据的完整性和准确性。

Scrapy:运用Scrapy框架实现大规模网络爬虫的构建与部署,高效爬取和解析网页数据。

解析库:熟练掌握BeautifulSoup4(bs4)和XPath,用于从HTML和XML文档中快速提取所需信息。

网络请求库:运用requests和aiohttp进行HTTP/HTTPS请求的发送与接收,支持同步和异步请求,提高爬虫性能。

网络调试工具

Fiddler:使用Fiddler对网络流量进行捕获和分析,辅助定位和解决网络爬虫中的问题。

Charles与Wireshark:这两款工具提供了丰富的网络数据包解析能力,帮助我深入理解网络协议和数据传输过程。

JavaScript处理

ExecJS:通过ExecJS在Python环境中执行JavaScript代码,处理需要JavaScript渲染的页面。

Node.js环境代码移植:具备将浏览器环境中的JavaScript代码移植到Node.js的能力,实现后端自动化和数据处理。

AST抽象语法树解混淆:运用抽象语法树(AST)分析技术,解析和还原混淆的JavaScript代码,以应对复杂的反爬虫机制。

加密与解密

对称加密与非对称加密:熟悉AES、RSA等加密算法,能够处理网站使用的加密数据,确保数据的安全传输和存储。

摘要算法:使用SHA、MD5等摘要算法验证数据的完整性和真实性。

逆向工程与Web技术

逆向Webpack:具备分析和逆向Webpack打包后的JavaScript代码的能力,以获取原始源代码和逻辑。

WebSocket:支持WebSocket协议的爬虫开发,实现实时数据的获取和传输。

Protobuf:熟悉Protocol Buffers(protobuf)数据序列化协议,能够解析和生成protobuf数据,以支持更高效的数据传输和存储。

项目经验

在过去的项目中,我成功为多家企业提供了爬虫逆向与验证码自动化解决方案。这些项目涵盖了金融、电商、教育等多个领域,涉及数据量大、验证码复杂度高的情况。通过我的努力,这些企业均成功实现了数据的自动化获取与解析,提高了业务效率和竞争力。

在最近的一次爬虫逆向项目中,我成功为客户抓取了一个采用复杂加密算法和动态加载技术的目标网站数据。通过深入分析目标网站的JavaScript代码和网络请求,我利用Webpack和魔改加密算法的技术手段,成功破解了目标网站的防护策略。在数据存储方面,我利用MySQL数据库对数据进行管理和存储,通过合理的索引和查询优化,提高了数据的检索效率和准确性。最终,我为客户提供了高质量的数据服务,得到了客户的高度认可。

案例展示

-

xx五矿

1. Web端爬虫逆向技术:我精通Web端JavaScript逆向技术,能够深入分析和理解网页的动态加载、数据加密等复杂机制。在爬虫逆向过程中,我能够灵活运用Webpack进行代码打包和解析,从而破解目标网站的防护策略,实现高效的数据抓取。 2. 魔改加密算法:面对目标网站

-

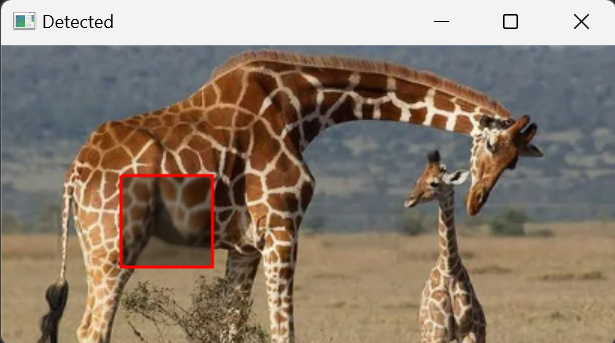

滑块验证码

在面对复杂的验证码挑战时,我具备独特的解决能力。 特别是在处理大图片中一小图片滑块类型的验证码时,我能够自主研发出高效的自动化解决方案。通过图像识别技术,我能够准确识别出小滑块的位置和应划过的距离;同时,我能够自定义滑动速度、轨迹等参数,以应对不同网站对验证码的验

相似人才推荐

-

500元/天python开发旋律云概要:主修语言:python、前端三件套、vue、node.js等; 1. 能够及时地理解客户需求并提供

-

500元/天后端开发工程师中软国际概要:1.4 年 python 开发经验,有良好的编程习惯,能够熟练运用 python3 DRF 框架

-

500元/天安服工程师中国联通概要:作为一名具备Python编程能力的个体,您拥有着深厚的技术功底和解决问题的能力。通过Python,您

-

500元/天高级NLP工程师、爬虫工程师飞算科技概要:拥有多领域的技术能力,涵盖了自然语言处理(NLP)、计算机视觉(CV)和网络爬虫等方面。在NLP方面

-

500元/天后端工程师百度概要:希望有自由的工作时间。 擅长 Python,数据分析,密码学,加密货币,爬虫,抓包 擅长 Pyt

-

500元/天爬虫逆向工程师新浪概要:具有丰富的Python爬虫和JS逆向工程经验,热爱技术研究和创新,注重团队合作与沟通能力。熟悉互联网

-

500元/天学生吉林师范大学概要:大学生兼职实习接单,软件工程专业学生,主要目的历练,薪资可降,目前掌握c,c++,python等语言

-

700元/天NLP算法工程师TYSON概要:熟练 LR, SVM, 朴素贝叶斯,Xgboost,K-means 等常用机器学习模型 熟练 HM