Zark朱

大数据开发工程师

- 公司信息:

- 吉祥汽车

- 工作经验:

- 10年

- 兼职日薪:

- 900元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 上海

- 普陀

技术能力

擅长Spark,Flink , Kafka,HBase,Hive使用及优化。 开发语言:Java、Python。

Spark:熟练掌握PySpark,编写自定义UDF函数,深入理解Spark的核心原理及设计,能够基于RDD算子SparkDSL,SparkSQL进行复杂的数据分析,深入理解Dataframe的设计原理。

Flink:会使用DataStreamAPI和TableAPI开发Flink代码,深入理解窗口,水印,状态,检查点

会使用Java匿名内部类,Lambda函数开发

Kafka:掌握Kafka消息队列的使用,拉取消费数据,对Kafka分布式事务,一致性,分区规则有深入理解,结合Zookeeper实现高可用

HBase:熟悉HBase读写流程,Rowkey设计优化

Hadoop,Hive:熟悉Hadoop原理,Yarn调优,Hive数据倾斜优化,数仓建模,维度设计。

MySQL,Oracle:MySQL窗口函数,索引优化,Oracle存储过程,JDBC写代码拉取数据

其他:Linux操作shell,Python爬虫xpath使用,ElasticSearch,Presto,Druid等软件

项目经验

新能源车企车联网项目

业务背景:公司希望建设大出行车联网项目,所有销售车辆。

技术架构:HBase+Kafka+Flink+MySQL+DophineSchedual

目前项目开发中。。。

技术点包括:

1、基于HBase解析车辆处理车辆历史数据信息,包括经纬度位置信息,速度,里程,三级报警信息,充电信息,电子围栏等。国标数据和企标数据。

2、基于Kafka+Flink,处理车辆实时信息,实时在线情况,实时总里程,实时充电,24小时活跃度

3、车辆统计信息存储在MySQL

证券行情服务及数据大屏

业务背景:公司新成立金融科技部,业务部门需要大数据平台进行实时的个股,指数,板块和K线的行情数据服务升级,通过Restful接口提供沪深指数、沪深板块、沪深个股和K线的实时行情查询功能,内容包括实时国内指数、涨幅榜、个股涨跌、个股秒级行情、实时日K线行情等。这是一个前后端分离项目,前端用Vue绘制K线图,后端负责数据及应用。对接了3个平台和应用。每天产生约2.88亿条数据,数据量大小约85G,每天的app服务端访问量从原来的4.73万增长到现在的日活用户50.54万人。单日使用时长130.5分钟。

技术架构:

Flume+Avro+Kafka+Flink+HBase+Druid+MySQL+HDFS+Sqoop+Zookeeper

个人职责:

1、 根据需求文档和接口说明书文档,编写业务文档,梳理业务逻辑,构建数据地图。

2、 搭建业务模块,沪市行情数据基于Flume自定义source,将数据异步发送到管道。

3、基于自定义Kafka生产者对象,设置参数,将数据封装成Kafka生产者对象,通过sendData方法,发送到Kafka的sse沪市数据主题层。

4、Flink消费Kafka数据,设置检查点,合并流,从个股,债券,基金,板块数据中过滤出个股数据,设置水位线。

5、数据根据业务需求分别保存到不同的数据库中,如秒级行情保存到HBase,分时行情保存到Druid,K线行情保存到MySQL,分时数据备份保存到HDFS。

6、通过采集外部数据源Wind数据,离线导入到数仓,与分时数据进行指标计算,聚合操作,结果通过BI展示到业务大屏。

兰卫医学冷链物流车辆实时监控大屏

业务背景:由于新冠疫情的爆发,公司核酸检测业务也呈爆发式增长。全国所有的冷链物流车辆增长到1000多辆,统筹管理称为一个难题。公司领导层提出建立数字化运营平台,降本增效,同时获得营业外收入。每天产生约1300万条数据,项目数据量每日约6G,服务全国12个分公司网点。

技术架构:

Flume+Kafka+Flink+ElasticSearch+Hive+MySQL+Zookeeper

个人职责:

1、 根据需求文档,编写业务文档,梳理业务逻辑,表关系。

2、 北斗位置信息数据源来自于供应商提供的接口平台FTP,车辆基本信息及状态信息数据来自于公司内部Hive数据集市,基于Flume自定义source从外部FTP服务器获取JSON格式的事实数据,包括经纬度信息等,保存到Kafka。

3、 基于Flink 从 Kafka 消费数据,使用 3 秒的滚动窗口进行实时计算,包括车速、预计到达时间、区域内车辆数量、充电中车辆、修理中车辆、历史违章信息等。对于燃油车,计算指标如估算油耗。

4、 创建ElasticsearchSink,将Flink实时计算结果写入到 ElasticSearch 中。

5、 多部门协同,将数据展示到BI大屏上。

浦发银行信用卡客户智能评分系统

业务背景:银行内部零售银行业务二次改革,需要进行客户资源挖掘,精准拓展零售银行业务,并要求产生BI报表供运营人员使用。一期项目新增数据集市,通过对客户信息表,合同信息表,还款计划表,评分标准表,风险地区表,客户贡献度表,人脉网络表等进行HQL分析,给出客户的行为数据。二期项目,根据一期的行为数据,针对不同客户使用算法计算用户画像,结果可以供运营人员离线查询,对优质客户进行精准推荐,交叉梯度营销,匹配适合的零售银行产品,贷款,理财,基金,保险,贵金属。日新增数据量27G,新增数据约6500万条。

技术架构:

一期:Sqoop+MapReduce+Hive+ DophineSheduler

二期:SparkDSL+MLlib+MySQl+HBase+Zookeeper

个人职责:

一期:

1、 根据需求文档,梳理表关系,采用星型模型进行维度建模分层,编写数据地图说明书。

2、 基于复杂SQL完成20多数据表的增量更新,拉链表更新,清洗转换,脏数据过滤。

3、 抽取事实表,维度表并根据主题构建宽表

案例展示

-

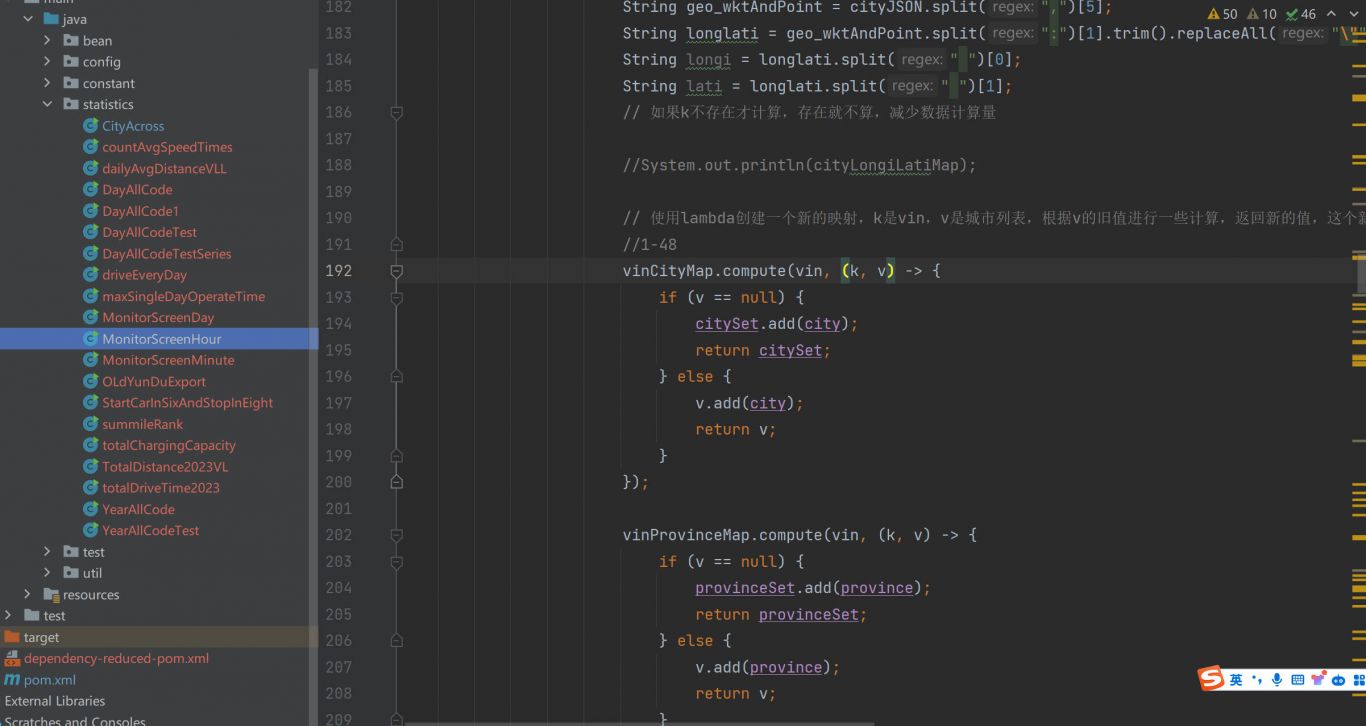

车联网项目

共有三张,包括三个功能: 1、解析车辆经纬度位置信息,并保存到map缓存。 2、开发前写的开发步骤,要处理的几张表

-

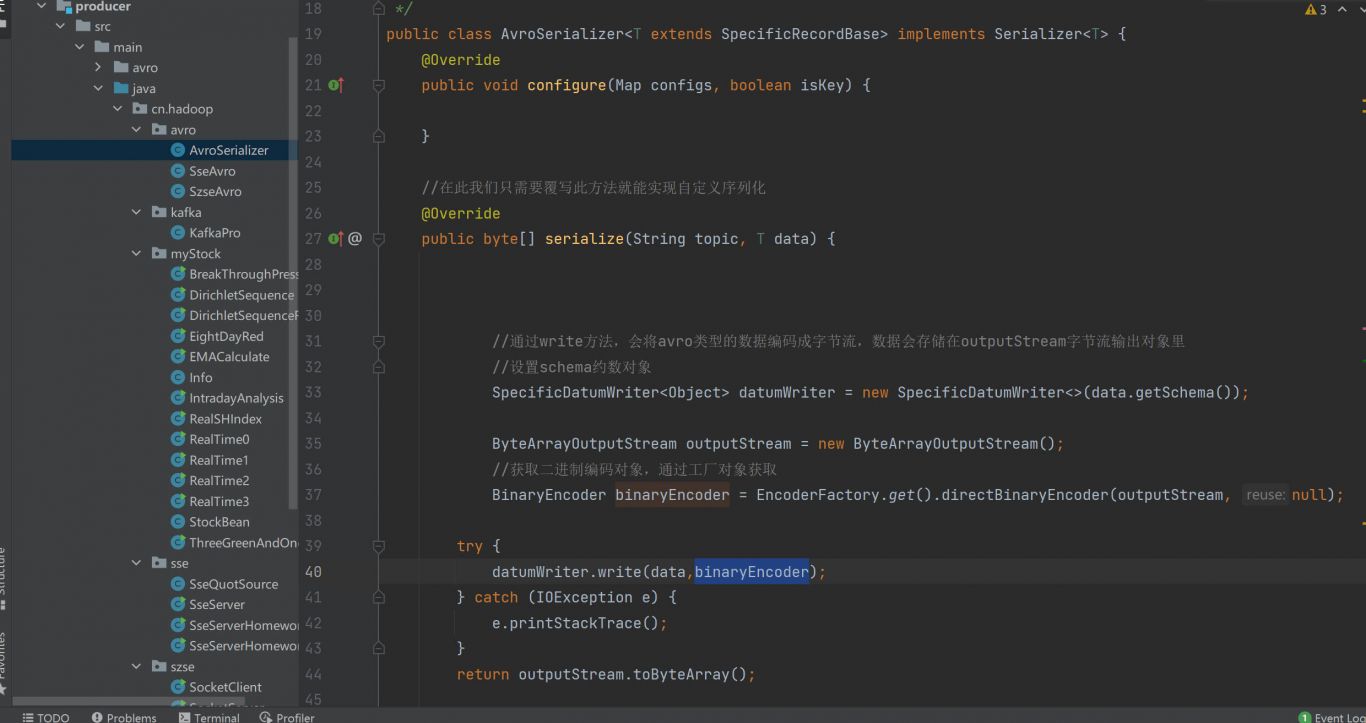

股票实时行情

我负责数据功能开发 1、采用Apache Avro进行股票行情数据格式序列化,相比于传统的JSON格式,节省了70%的存储空间 2、一个静态方法,把实时股票行情数据写入文件

相似人才推荐

-

500元/天软件设计师山东豪迈机械科技股份有限公司概要:1、有ERP开发经验,熟悉MES\APS\WMS\CRM等相关系统; 2、深耕系统间集成8年时间,

-

500元/天技术部经理合肥铭恩信息科技有限公司概要:拥有13年的全栈型程序员技术开发经验,同时兼任技术部管理,实际开发主要使用 JAVA语言,页面使用v

500元/天技术部经理合肥铭恩信息科技有限公司概要:拥有13年的全栈型程序员技术开发经验,同时兼任技术部管理,实际开发主要使用 JAVA语言,页面使用v -

500元/天高级开发工程师太极概要:熟练使用j2ee规范编程、MVC编程思想、三层架构模式、面向服务编程等。熟练使用SpringBoot

-

900元/天高级软件工程师奥特斯科技(重庆)有限公司概要:十年软件开发经验,熟练掌握c/c++、c#、java、sql、html、css、javascript

-

500元/天高级软件开发工程师九天云科技概要:熟练掌握 spring cloud, spring boot 熟悉应用 Mysql ,Oracle

-

1000元/天计算机软件工程师自由概要:计算机软件开发,数据下载,网页前台设计开发。计算机软件开发,数据下载,网页前台设计开发。计算机软件开

-

500元/天全栈工程师自己开公司概要:全栈开发,常用开发语言:精通C# java javascript vue python等 常用数据

-

500元/天后端工程师阿里概要:语言基础:后熟练Java、PythonC++等。 数据库技术:后端了解数据库的基本概念,包括关系型