星辰

高级研发工程师,高级运维工程师

- 公司信息:

- 欧冶云商

- 工作经验:

- 6年

- 兼职日薪:

- 600元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 上海

- 浦东

技术能力

1、熟悉 Java语言,熟悉Linux 系统操作、掌握 Shell 脚本的开发编写。

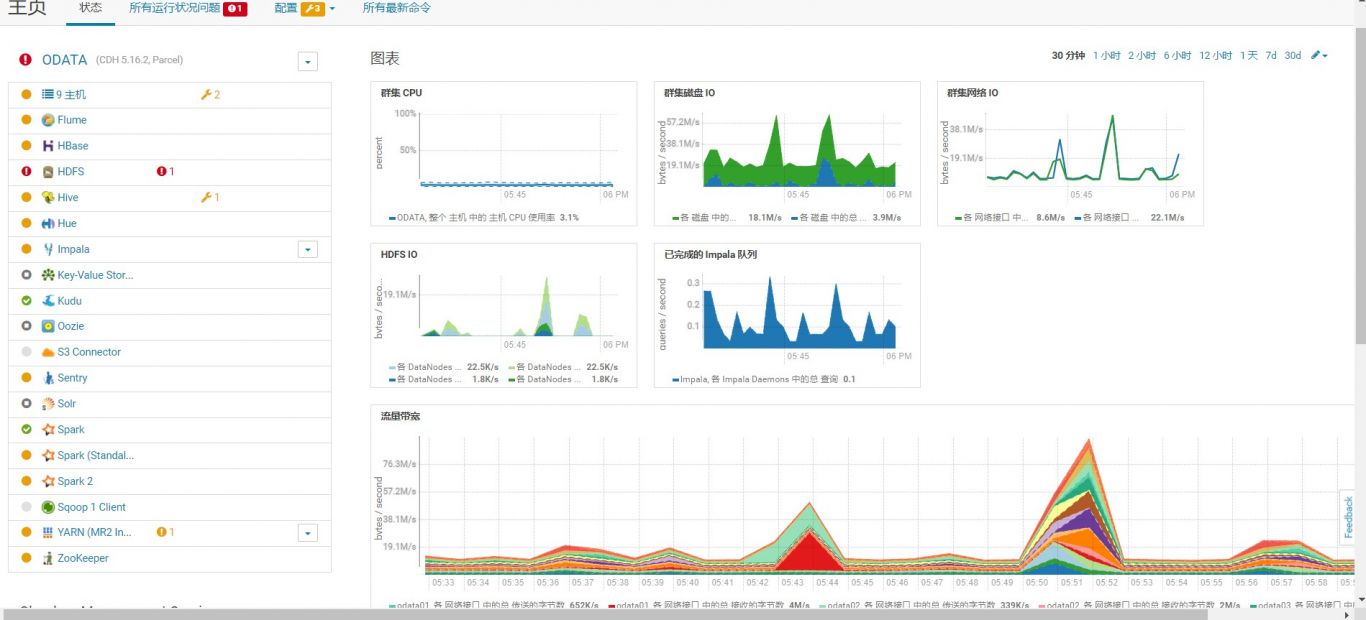

2、熟悉CDH、hadoop、hive、hue、impala、kudu、yarn,kyligence等组件的运维,spark、flink实时计算开发

3、熟练使用Hive 搭建数仓,对数据进行ETL 预处理、HQL 分析、优化、自定义 UDF、UDTF 函数等。

4、熟练使用ETL 工具sqoop、datax 做数据采集、清洗、推送,文件格式转换

5、熟练使用Tableau、fineBI 可视化工具的系统运维和使用

5、熟练常用 SQL语句,熟悉Oracle,Mysql,hive,impala,postgreen等数据库安装部署,熟悉 redis。

6、熟悉运用Spring、springmvc、mybatis、springBoot、Spring Data Redis等主流框架。熟悉使用MVC开发模式,webservice 等技术。

7、掌握canal、zookeeper、kafka、Nginx、ActiveMQ安装和部署等。

项目经验

一、离线数仓搭建

项目描述:该系统是将业务数据库所有数据集中到hadoo大数据平台,进行分层、建模,通过不同维度的指标,全面分析总体运营情况,并依据市场变化做出正确对策,同时对产品进行改进和优化等。

项目架构:Sqoop + hadoop + Hive +impala+ crontab+kylingence+tableau+fineBI

技术要点:

1.通过shell开发出批量生产能自动适配 mysql、oracle、sqlserve等关系型数据库sqoop采集指令和impala建表语句的功能;

2.对Sqoop采集功能配置文件研究,使采集,解决MySQL和Hive的空值、null,转义字符,及数据类型不一致等问题。

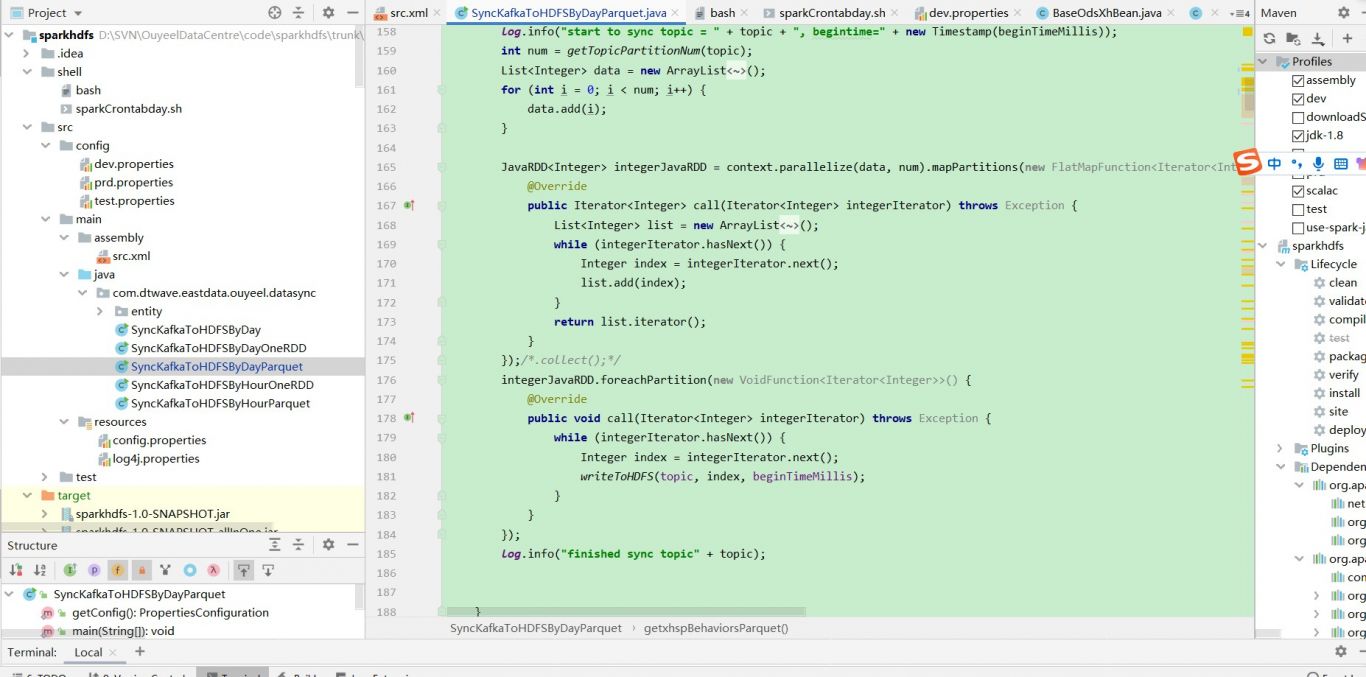

3.使用impala,parquet格式进行压缩和列式存储,提供快速sql查询和开发

4.利用kylingence工具对sql进行建模,能加速页面的响应,让可视化工具更快展示。

5.数据仓库的搭建:

(1)ODS原始数据层:将业务库数据增量或全量采集到ODS层,保证业务库和ods表1:1完全一致

(2)DWD明细数据层:对ODS层数据进行数据清洗和脱敏(有需要可创建非脱敏层)。进行维度建模,选择最小粒度对关心的业务进行分析,以便后续进行更大粒度的计算。构建维度和事实表时进行表维度,构建星型模型。DWD层采用Parquet列式存储。

(3)DWS数据服务层:对DWD的数据进行轻度聚合,粒度为每天或者区域,分别对关心的主题进行数据分析聚合成中间公共层,提供给ads主题层使用。

(4)ADS应用数据层:以分析的主题对象为建模驱动,基于上层的应用和产品的指标需求,构建主题对象的全量宽表。基于DWS层的主题构建全量主题宽表,主要关心各个主题的累计值。

(5).使用Sqoop将ADS层统计的指标导入到MySQL数据库中。同时将ads主题表通过可视化工具tableau展示出来,提供给业务分析

职责描述:

1.参与技术选型,需求分析以及具体方案设计讨论。

2.ods表的采集,ads层提取至tableau或者fineBI工具,其中固化的hivesql建成kylingence模型加速页面响应。

3.维护离线数仓系统的正常使用,解决大数据平台多种问题。同时也维护可视化工具tableau、finebi应用的日常运维

4.tableau和fineBI可视化工具的部署和答疑用户可视化工具的功能使用问题等。

二、java后端开发工程师

一个网上销售新鲜水果的B2B2C商城,网站采用果农商家入驻的模式,经由商城平台进行审核后,果农商家即可通过花果山鲜果商城销售鲜果。

开发环境:idea、Windows7、JDK1.8、Tomcat8、MySQL、git、redis

软件架构:Spring+SpringMVC+Mybatis+SpringSecurity+angularJs+solr

本项目采用的是dubbo这个分布式的框架把整个平台搭建起来,启动Web功能使用SpringMVC作为控制层,使用MyBatis来作为数据访问层,由Redis集群作为缓存缓解数据库的压力,使用的是Nginx做请求的分发完成负载均衡,根据短信接口平台Web Service提供的接口实现短信发送,使用solr索引库实现数据的大量搜索,根据实物商品交易服务集成技术,微信支付在线支付Web Service提供的接口实现

案例展示

-

CDH大数据平台部署运维

1、搭建公司cdh平台,并负责其中的etl采集和系统运维 4、熟练常用 SQL语句,熟悉Oracle,Mysql,hive,impala,postgreen等数据库安装部署,熟悉 redis。

-

可视化工具finebi制作和运维

tableau、fineBI可视化工具制作和运维,并指导用户进行页面指标制作、页面异常、系统异常、系统参数调优进行处理

-

java开发

在前端页面埋点,实时将用户访问行为存入应用日志中,在通过filebeat+logstash将数据实时存入kafka中,再根据spark计算引擎将数据存入mysql.应用接口调用实时存入的数据,在页面展示;

相似人才推荐

-

600元/天运维开发工程师广州数娱概要:精通运维开发部署工作,能独立根据项目需求部署到不同环境。 精通python开发,能独立开发后端服务

-

500元/天中级运维创新工程师玄武云概要:1、python爬虫,独立爬取过中国福利彩票开奖记录,和全国疫情数据爬取,并将数据保存至数据库内(也

-

800元/天高级运维架构师互联网金融公司概要:本人拥有十五年以上运维工作经验,精通各种服务器运维相关技术、熟悉常用运维中间件组件、熟练搭建DevO

800元/天高级运维架构师互联网金融公司概要:本人拥有十五年以上运维工作经验,精通各种服务器运维相关技术、熟悉常用运维中间件组件、熟练搭建DevO -

500元/天高级运维工程师北京尚博信科技有限公司概要:精通 Linux 和 Windows 操作系统,包括系统安装、配置、管理和故障排除。 熟悉云服务平

-

500元/天游戏运维工程师成都雨墨科技有限公司概要:精通centos系统和常用软件维护,例如nginx,php,tomcat,mysql等等。 精通s

-

500元/天运维工程师云帆加速科技有限公司概要:三年CDN经验,架构调整,节点资源主备切换 两年数据运维经验,数据展示,搭建服务== k8s、d

-

700元/天运维工程师北京神州新桥信息科技有限公司概要:主要方向: AD架构管理、DNS(可配配置智能DNS)、DHCP、Exchange企业邮箱管理、o

-

800元/天运维开发爱睿智健康科技(北京)有限公司概要:熟练使用centos,ubuntu操作系统和熟悉网络知识 熟悉iso27001和等保三级认证 熟