桐亽

大数据开发工程师

- 公司信息:

- 平安银行股份有限公司

- 工作经验:

- 12年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 可工作日远程

- 可工作日驻场(离职原因)

- 所在区域:

- 长沙

- 全区

技术能力

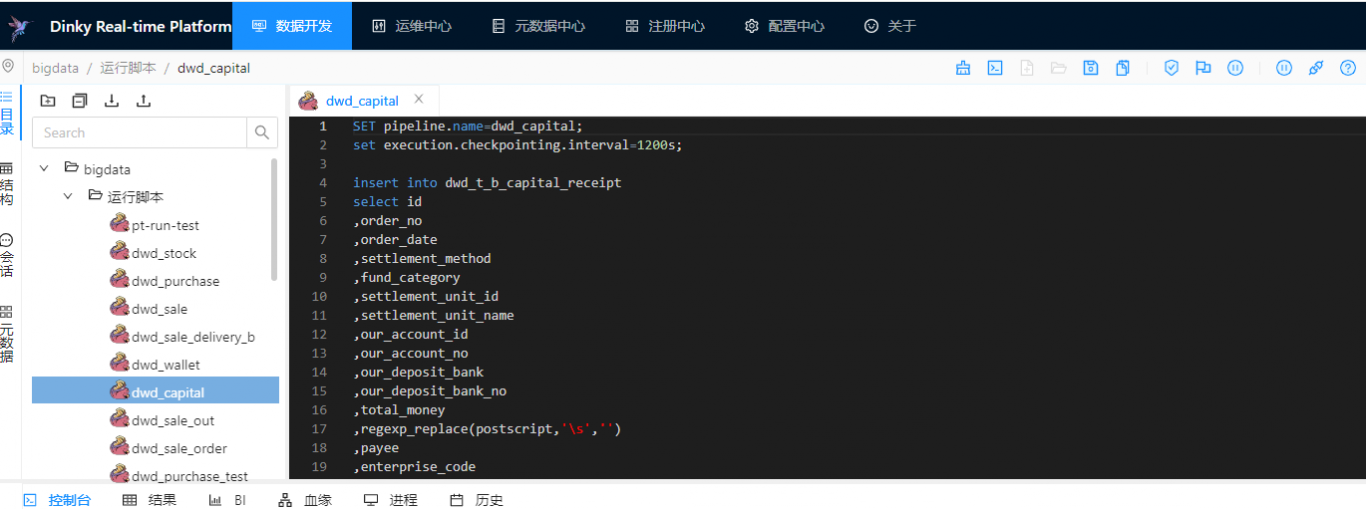

熟练使用Flink + Doris + Dinky搭建实时数仓集群

熟练离线数仓、实时数仓的设计与开发

熟练使用Hive、Shell、Sql、Impala、Scala、Java、Spark、SpringBoot开发

熟练使用Flink、Doris、Dinky、StarRocks开发

熟练使用Oozie、Crontab、DolphinScheduler来调度任务

熟练使用Sqoop、Datax工具同步数据

熟悉Python语言,随机森林、XGBoost、线性回归等算法建模,Scrapy爬虫

熟悉核心网络架构,Hyper-v、VMware vSphere服务器虚拟平台使用

熟悉CDH搭建大数据集群组件,如Hadoop、Hive、Hbase、Spark、Oozie、Kafka等等

熟悉服务器系统运维,桌面维护

了解Docker、Rancher容器化部署服务

了解Oracle存储过程、游标等开发与使用

了解Kafka、Hbase、Elasticsearch 、PowerBI的使用

项目经验

项目一:2021.7-2023.12 实时数仓架构设计、搭建和开发 大数据开发

项目描述:随着公司业务的发展,对数据的及时性要求越来越高,传统的离线数仓满足不了实时的业务需求,于是需要在实时方面做技术突破。期初我有研究过Canal+Kafka+Spark+Impala做准实时架构,这个方案有使用过一段时间,但是在Spark消费Kafka数据有一定延时,Impala加工结果数据也有一定延时,这就导致数据是准实时的,这个只能满足对数据实时性要求不高的场景,因此需要做新的突破。

现流行的Flink分布式流数据流引擎,非常适合公司的业务需求,所以自己研究实时数仓架构,设计出Flink+Doris+Dinky实时架构,并搭建用于生产,用Doris建立实时数仓,数据时效性在1s左右,满足了业务需求。但在某些特定情况下, Flink CDC需要重新同步数据,由于集群资源限制,导致同步完成需要几小时。后面设计Datax全量,Flink增量,使得同步完成缩短到1小时内。

工作职责:实时数仓架构设计、搭建、开发

项目二:2021.7-2023.12 离线数仓设计与开发 大数据开发

项目描述:公司原EOC旗舰版报表基于mysql数据库开发,当数据处理相对复杂的报表时,随着数据的增加,mysql性能已经满足不了报表的查询,往往需要几分钟才返回查询的数据。为了满足查询性能,新的EOC汉河版报表设计基于离线数仓开发。我参与离线数仓的ods、dwd、dws、dm层设计、数仓规范的制定。

工作职责:离线数仓设计、搭建、开发

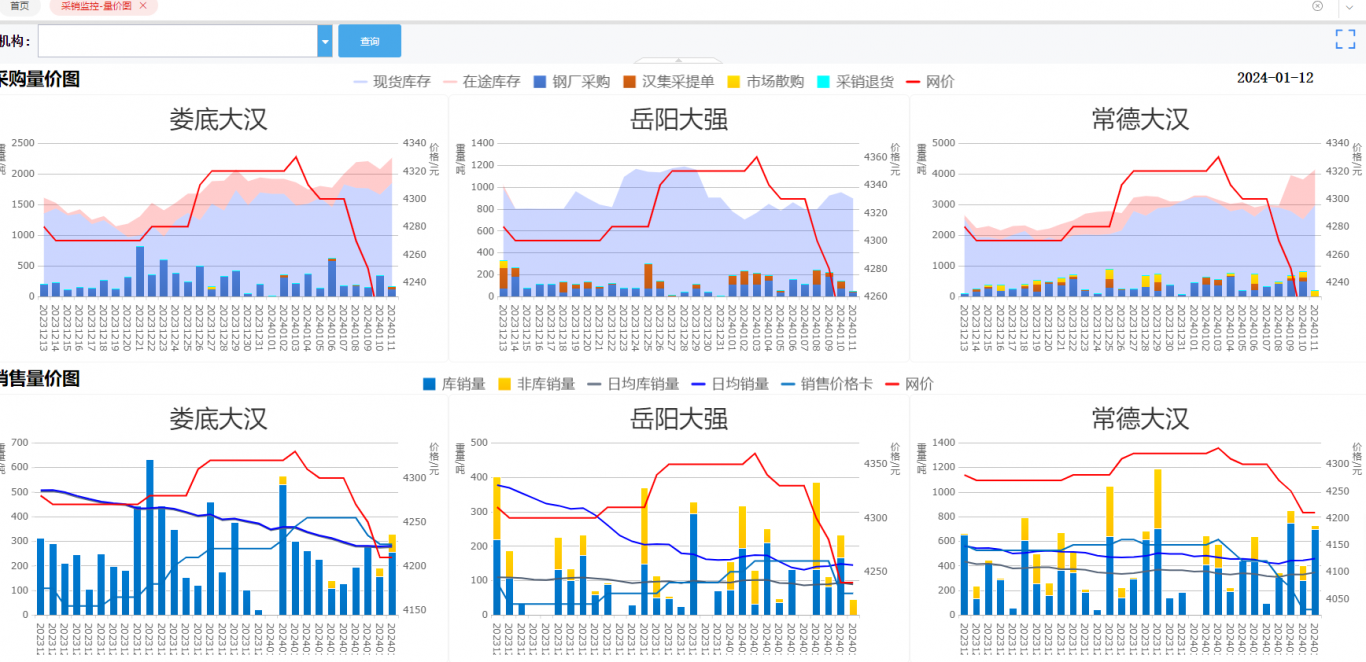

项目三:2021.7-2023.12 大数据报表开发 大数据开发、后端开发

项目描述:公司在开发EOC汉河版,项目工期紧迫,我除了负责EOC汉河版报表的数据开发,还负责基于SpringBoot开发后端接口。数仓历经离线数仓、准实时数仓、实时数仓的迭代,因此数据的开发也经历过hive、impala、doris开发。也负责客户画像、汉盯平台的指标开发,基于海豚调度做数据质量监控。

工作职责:汉河版报表、客户画像等数据开发、后端接口开发、数据质量监控

项目四:2020.5-2020.9 金融壹帐通对数据进行建模与预测输出 大数据开发

项目描述:平安金融壹帐通需要对客户贷款进行精准营销,用以降低营销成本。经过业务与他们的沟通,决定对整个集团的客户数据进行预测,壹帐通再通过接口来匹配数据输出。只能提供有无意向贷款的数据,而想要的结果是放款成功的数据,因此训练好模型只能对有意向贷款的客户预测,因此还要处理结果数据中黑名单和资质差的数据,由于挑选的特征多值型较多,决定采用随机森林或adaboost算法训练模型,采用网格搜索最优参数,发现随机森林效果要好,得到的auc=0.78,用训练好的模型输出结果数据。用户那边经过2次各10万数据调用匹配来验证模型,判断为有意向的分别是17.41%和15.3%,10万人总的放款成功率分别为0.04%和0.06%,其中有意向的客户放款成功率分别为0.22%和0.29%,70%左右的放款成功的客户属于预测的有意向贷款的客户,后面只针对有意向的客户做营销,减少了营销成本。

工作职责:数据的预处理、模型的训练、数据的定时输出

项目五:2020.1-2020.5 平安科技集团应用统计等报表开发 大数据开发

项目描述:根据用户模型申请与调用,生成NAS数据日志,需要分析日志信息获得各项指标,陆续开发集团应用统计、应用详情、并发量统计、调用量统计、时效等报表。数据维度基本都有上百个,根据这些维度统计各种情况下的指标,比如总调用量,有效调用量,客户数、系统数、并发量等等40多个指标。还用druid平台根据用户自定义时间段与专业公司等,去统计调用量、去重后客户数等。

工作职责:需求分析、调度任务建立、数据的ETL、Hive存储过程、druid环境使用

案例展示

-

实时数仓架构设计、搭建与开发

项目描述:随着公司业务的发展,对数据的及时性要求越来越高,传统的离线数仓满足不了实时的业务需求,于是需要在实时方面做技术突破。期初我有研究过Canal+Kafka+Spark+Impala做准实时架构,这个方案有使用过一段时间,但是在Spark消费Kafka数据有一定延时,Imp

-

报表数据开发

项目描述:公司在开发EOC汉河版,项目工期紧迫,我除了负责EOC汉河版报表的数据开发,还负责基于SpringBoot开发后端接口。数仓历经离线数仓、准实时数仓、实时数仓的迭代,因此数据的开发也经历过hive、impala、doris开发。也负责客户画像、汉盯平台的指标开发,基于海

相似人才推荐

-

700元/天RPA机器人开发珠海金智维科技有限公司概要:python开发,shell开发,擅长通过python与其他RPA工具开发软件机器人,代替人工完成有

-

500元/天无无概要:1.知识构成和实践经验 咨询顾问应受过高等教育,一般应该受过专业的管理学教育,或具有一门专业知

-

500元/天结构工程师承德市现代建筑设计院概要:python办公自动化,pandas数据处理,读取excel和sqlite数据库数据,整理分析后,利

-

500元/天SMT工艺工程师意拉德电子概要:用VBA代码实现Excel自动化办公,并把常用的办公代码封装后放到excel 菜单栏里,方便随时使用

-

800元/天工程师龙杰科技(深圳)有限公司概要:1,开发语言会用C,C++,C#,Java,Python,Javascript 2,开发过后台系统

-

500元/天labview工程师深圳驿普乐氏科技有限公司概要:1.基于Labview之上熟练调用RS232、485、USB、蓝牙串口,MES、TCP、FTP、HT

-

500元/天无无概要:功能测试:我可以按照需求文档和测试用例,模拟用户操作,验证小程序的功能是否正常。这包括页面跳转、数据

-

500元/天工程师工程师概要:pythonpythonpythonpythonpythonpythonpythonpythonpy