hoosu

数据工程师

- 公司信息:

- 万翼科技有限公司

- 工作经验:

- 7年

- 兼职日薪:

- 1000元/8小时

- 兼职时间:

- 周六

- 周日

- 可工作日远程

- 可工作日驻场(离职原因)

- 可工作日驻场(自由职业原因)

- 所在区域:

- 深圳

- 南山

技术能力

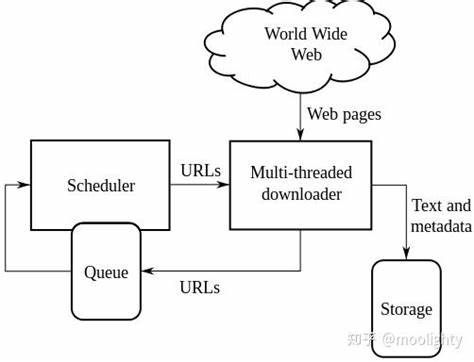

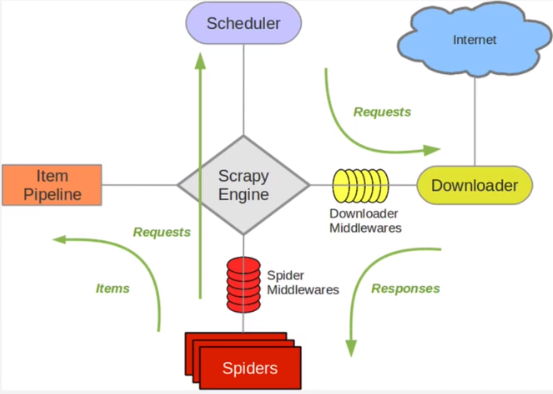

7年工作经验。熟练使用scrapy、aiohttp、asyncio、flask、requests等库,掌握mysql、MongoDB、redis等数据库在爬虫中的运用,linux下爬虫开发部署。处理js逆向、图片验证码、文字样式加密,ip封禁,账号登录等反爬虫问题。熟练使用pyth on多进程+协程高并发。涉及dl,可手写分类问题源码。

项目经验

需要实时更新上述两个网站最新披露的数据,两个网站存在很多可用信息,爬取量大,时效性要求较高

2.技术手段以及实现思路

a.考虑数据量大,主要为结构化数据,使用mysql数据库,pymysql便于操作,代理池proxypool提供代理数据避免ip封禁b.针对两个网站的项目,建立两个scrapyproject,两个项目实现思路一样。考虑以后会新增其他数据需求,start_requests里面使用主域名。针对不同数据需求分析页面,在生成的新请求里面调用不同的parse函数

c.设置异常处理情况,遇到异常时,记录异常信息保存到本地便于后期分析,setting里面注释钓默认的中间件

d.以上架构综合考虑了反爬虫机制,易于修改代码后增加后期数据需求,容错机制等

案例展示

-

银行验证码统一处理

1.项目背景 公司利用arp机器人完成自动报账,登录需要网盾+验证码的输入,我负责处理验证码问题 2.技术手段以及实现思路 a.银行验证码大多是数字和字母的组合,为提高准确率降低训练速度,采用切割之后再训练的方式 b.不同网站验证码字体特征不一样,分别抓下来500个验证码

-

债券网、货币网所有债券发行数据

1.项目背景 需要实时更新上述两个网站最新披露的数据,两个网站存在很多可用信息,爬取量大,时效性要求较高 2.技术手段以及实现思路 a.考虑数据量大,主要为结构化数据,使用mysql数据库,pymysql便于操作,代理池proxypool提供代理数据避免ip封禁b.针对两个

相似人才推荐

-

500元/天普工长越汽车概要:正在学习python和网安,正在学习python和网安,正在学习python和网安,正在学习pyth

-

500元/天数据分析PA概要:掌握的技术涵盖了数据分析、报表可视化、数据建模和爬虫方面的多个领域。熟练掌握的技术和工具如下

-

500元/天研发经理广州安普华德创新科技有限公司概要:开发语言:C,C++,delphi,java,python,basic 开发工具:Visual S

-

500元/天算法工程师诡谷子人工智能科技有限公司概要:掌握python编程,图像处理、爬虫 熟悉深度学习resnet、yolov5、yolov8-seg

-

1500元/天Windows驱动工程师联想概要:10年c/c++开发经验,熟练掌握网络、数据库、界面等技术开发,熟悉网络通信、路由交换、接口等技术;

-

500元/天爬虫专家Python数据分析概要:负责根据需要爬取的数据进行需求分析,分析目标网站的网站结构和一些反爬手段; 负责通过request

500元/天爬虫专家Python数据分析概要:负责根据需要爬取的数据进行需求分析,分析目标网站的网站结构和一些反爬手段; 负责通过request -

1000元/天算法工程师无锡奥特维概要:掌握 pytorch、yolo、Opencv、python、Open3D、Halcon 、LabVI

1000元/天算法工程师无锡奥特维概要:掌握 pytorch、yolo、Opencv、python、Open3D、Halcon 、LabVI -

500元/天爬虫没有概要:熟练于python爬虫,网页数据采集,自动化,熟悉Python编程语言、了解常用的爬虫库(如Requ