山东平妍商贸有限公司 身份已认证

监事

- 公司信息:

- 山东平妍商贸有限公司

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 山东

- 全区

技术能力

本人熟悉Linux,熟练掌握爬虫、数据分析,ffmpeg音视频剪辑MongoDB等,主修爬虫方向、前后端开发、平面设计等有专业的技术支持。

工作认真负责,有一定的时间可以为您服务。安全、环保与消防、职业卫生相关专业经验丰富可以从事安全、环保、职业卫生、消防相关的软件开发和相关程序开发。

项目经验

import requests,csv

import json

import jsonpath

from lxml import etree

from parsel import Selector

class MySpider(object):

def __init__(self):

self.url = 'http://www.xinfadi.com.cn/getPriceData.html'

self.headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.149 Safari/537.36',

'Cookie':''

}

self.header = ['菜名','最低价','最高价','单位']

self.shucai_list = []

self.sum_dict = {

'list': []

}

def get_html(self):

response = requests.post(url=self.url, headers=self.headers,timeout=(3, 7))

data = {

'prodPcatid': 1186

}

shuju = response.json()

prodName = jsonpath.jsonpath(shuju,'$..prodName')

lowPrice = jsonpath.jsonpath(shuju,'$..lowPrice')

highPrice = jsonpath.jsonpath(shuju, '$..highPrice')

unitInfo = jsonpath.jsonpath(shuju, '$..unitInfo')

print(zip(prodName,lowPrice,highPrice,unitInfo))

for i in zip(prodName,lowPrice,highPrice,unitInfo):

shu_ju ={

'菜名':i[0],

'最低价':i[1],

'最高价':i[2],

'单位':i[3]

}

self.sum_dict['list'].append(shu_ju)

print(self.sum_dict)

def save_json(self):

with open('新发地.csv', 'w', encoding='utf-8') as f:

json.dump(self.sum_dict, f, ensure_ascii=False, indent=4)

writer = csv.DictWriter(f, self.header)

writer.writeheader()

writer.writerows(self.shucai_list)

if __name__ == '__main__':

my_spider = MySpider()

my_spider.get_html()

my_spider.save_json()

以上爬虫小案例,本案例比较简单核心的东西没放进去,自动翻页,逆向啥的省略了。

案例展示

-

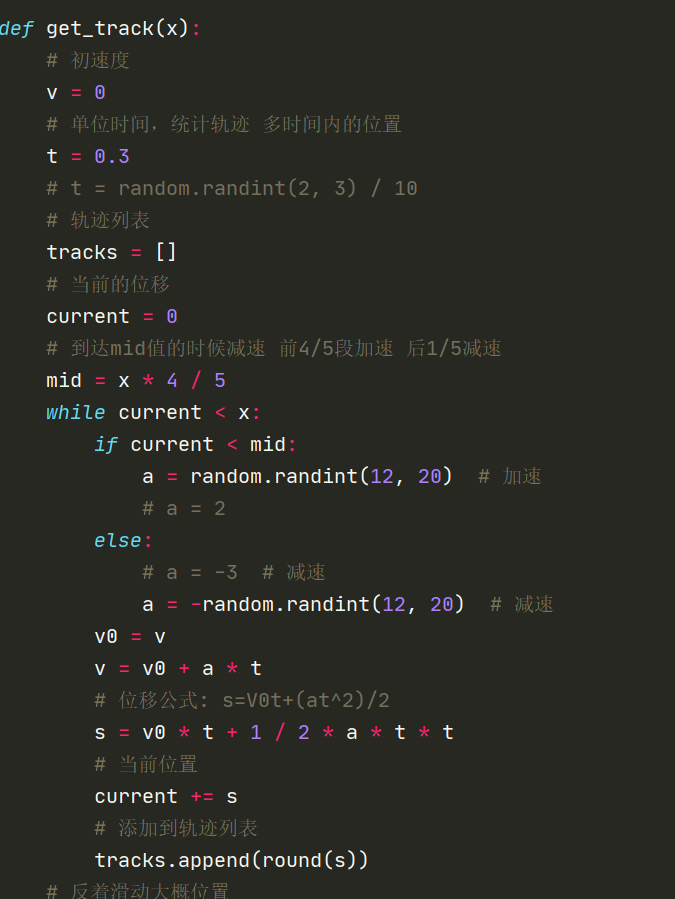

房天下超级

本项目一人独自完成,涉及到了逆向和滑块验证dddocr ,dddd.slide_match()做缺口识别。

-

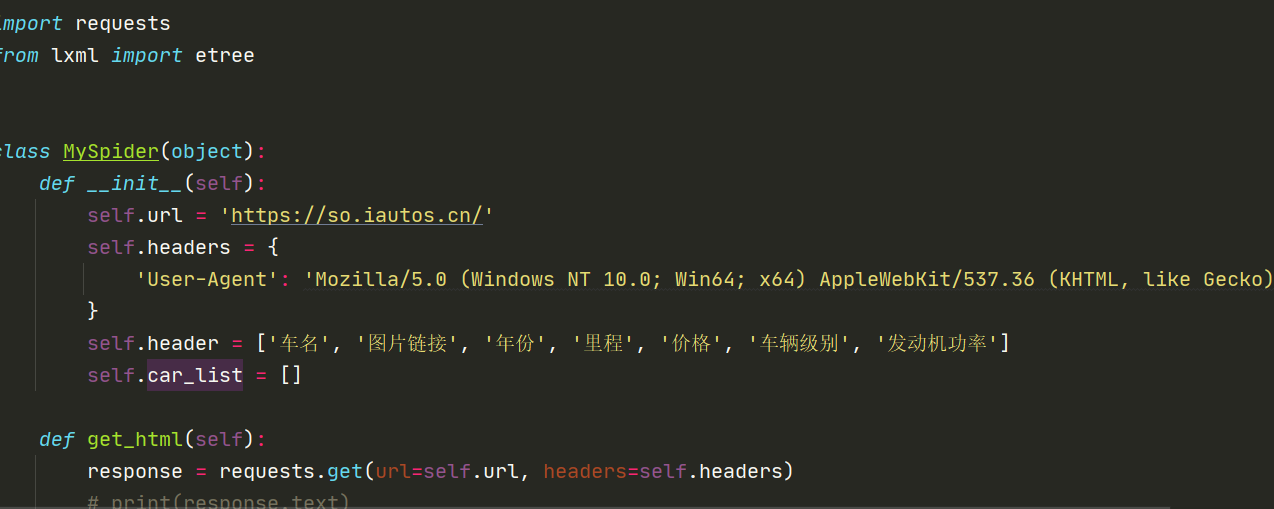

车网信息提取

本项目是个人项目,本人负责整个项目过程,本项目要求拿到车名,图片链接年份,行驶里程,发动机功率等,可以自动翻页获取想要页码的具体信息。

相似人才推荐

-

700元/天网络工程师软通动力概要:1.掌握技能:tcp/ip协议,nat地址转换,acl控制列表,ipv6,ospf,isis,bgp

-

500元/天帆软开发南京概要:熟练掌握帆软报表设计器,能够根据业务需求设计各种复杂报表,包括数据统计、数据分析、数据可视化等。

-

500元/天前端开发上海禹舟同尘概要:主要做前端开发,前端方面的会html、css、js,vue3,element UI ,antd UI

-

500元/天大数据开发工程师文思海辉科技有限公司概要:1、熟悉数仓建模,做过大型项目的数仓开发经验。 2、精通sql,做过很多复杂的sql指标运算,包括

-

700元/天数据负责人深圳老牌家电公司概要:1、oracel、Mysql等数据库,SQL精通 2、PowerBI、FineReport 开发

700元/天数据负责人深圳老牌家电公司概要:1、oracel、Mysql等数据库,SQL精通 2、PowerBI、FineReport 开发 -

500元/天高级网络安全工程师南京利楠群信息科技有限公司概要:目前的主要工作是在医院做网络安全运维,负责江苏、安徽区域的部分三级甲等和三级医院的机房网络运维,也做

-

1000元/天AI算法工程师诚迈科技股份有限公司概要:主要从事大模型的训练,评估,部署,以及 产品化落地 有现成的大模型部署方法 占位占位占位

-

500元/天爬虫工程师无概要:可以用Python编程语言和Scrapy框架来编写程序爬取社交媒体数据,使用API和OAuth来获取