奎 身份已认证

高级大数据开发工程师

- 公司信息:

- 国内知名电商公司

- 工作经验:

- 8年

- 兼职日薪:

- 1000元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 北京

- 朝阳

技术能力

熟悉Spring全家桶,ZK,MQ 等开源框架,熟练使用 ELK 日志检索系统,了解 google Guava Cache 缓存技术,Redis 缓存提升系统性能。 熟练掌握 Oracle、MySQL 常用的数据库操作,熟练使用 mycat。

熟练使用 IDEA、Eclipse、WebStorm、SVN、Git、Maven、Jenkins 等项目开发管理及部署工具。

熟悉 Hadoop技术栈,Hive,Spark,Flink 等大数据框架,熟悉 Azkaban,DolphinScheduler,StreamPark,Flume,Sqoop 等工具。

熟悉 Java,scala开发语言,了解python,shell

熟悉阿里云,华为云环境,了解各环境服务

熟悉企业级项目优化

项目经验

交易风控画像平台

我负责的任务描述:

1、参与画像平台技术选型,从 0 到 1 的平台落地,规划,从1到10的完善。

2、基于springboot完成画像平台流程落地,通过spark sql,计算用户行为特征,划分客群,通

过模型算法,完成用户基线统计,用户风险等级评估打分

3、持续优化,原项目用户行为特征存ES集群,重构为存储hbase,同步至clickhouse供前端查询

4、基于Neo4j构建风控知识图谱

交易风控数据开发

我负责的任务描述:

1、参与了项目技术选型,从 0 到 1 的平台建设,设计统一的ETL流程等等。

2、日常开发hive sql,spark sql,flink实时任务,spark离线任务,完成指标建设,风控画像

等

3、基于flink实时计算,完成准实时业务告警

4、多次完成对ES集群扩容,稳定性优化,查询性能提升建设,索引存储优化,多次对hadoop集

群,kafka集群做出优化,扩容,提升其稳定性,满足生产需要

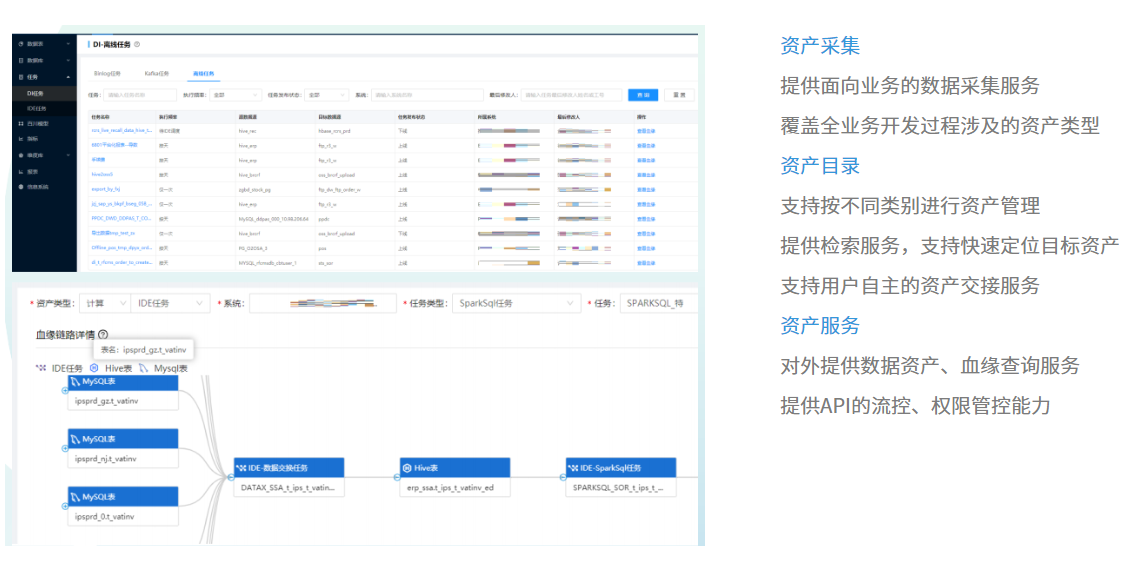

数据资产盘点&血缘链路分析

我负责的任务描述:

1、参与了项目技术选型,从 0 到 1 的搭建,设计统一的资产采集报文等等。

2、对接相关部门做血缘资产采集,对接采集文档,按指定格式往我们部门的 kafka topic 上推

送消息,我们使用 flink 实时消费,做数据清洗,校验入库,存 es 等工作。我主要负责采集系

统,库,表,字段,任务等资产和血缘相关数据。

3、开发相关资产和血缘查询接口。

4、根据数据办提出的数据导出需求,开发相关 hive 任务,开发数据清洗,数据导出等等 spark

任务。

5、参与开发了资产交接功能。

元数据管理系统

我负责的任务描述:

1、根据数据办给出的规范和相关用户提出的需求开发相关功能。

2、对外提供公共接口。

3、开发相关的 java 任务,hive 任务,spark 任务,保证数据最终一致性。

4、Hive 表的生命周期建设。

5、Hive ranger权限改造。

案例展示

-

数据资产&血缘管理平台

1、参与了项目技术选型,从 0 到 1 的搭建,设计统一的资产采集报文等等。 2、对接相关部门做血缘资产采集,对接采集文档,按指定格式往我们部门的 kafka topic 上推 送消息,我们使用 flink 实时消费,做数据清洗,校验入库,存 es 等工作。我主要负责采集系

-

元数据管理平台

项目背景: 通过制定更有效的开发流程来提高兄弟部门对业务的响应度。元数据的集成和可见性可以帮助 兄弟部门了解存在哪些数据、数据存储位置及其含义,从而最大限度地降低信息的复杂性。此外,这种 可见性通过不断变更业务要求为分析变化所带来的影响提供了基础架构,并将会加快新数据集成项

相似人才推荐

-

1000元/天软件开发工程师个人概要:熟练掌握Java语言及面向对象编程思想,精通Spring等主流框架。 精通数据库技术,包括MySQ

-

1000元/天后端研发架构师字节跳动概要:我们的技术栈包括前端,后端,大数据,基础架构,大模型算法等,能提供各种大型项目支撑,整体团队小伙伴均

-

800元/天大数据研发苏州盈天地技术有限公司概要:精通java 熟练掌握spring boot,spring cloud.熟练构建单体服务,微服务

-

500元/天研发经理北京博雅英杰科技股份有限公司概要:1. 深入理解面向对象编程思想。 2. 熟悉ASP.NET、ADO.NET等技术,以及.NET平台

-

1000元/天高级全栈开发工程师成都万像缤纷科技有限公司概要:我精通以下技术,如果相关的开发需求,请找我 前端技术:javascript,ht

-

1000元/天高级爬虫工程师 数据分析师不知名企业概要:python爬虫:JS逆向加密破解,ip池搭建,防反爬,主流数据库灵活使用,抖音,大众点评等APP数

-

1200元/天技术专家支付宝网络技术有限公司概要:1、本人10年研发经验,包含5年研发项目团队管理经验; 2、拥有物联网、智慧医疗、金融支付领域的开

1200元/天技术专家支付宝网络技术有限公司概要:1、本人10年研发经验,包含5年研发项目团队管理经验; 2、拥有物联网、智慧医疗、金融支付领域的开 -

800元/天IT经理成都双流万达房地产开发有限责任公司概要:本人从事运维及开发相关工作8年,有丰富的系统维护及IT支持工作经验。熟悉信息化项目规划分析设计实施、