the sunshine

数据开发工程师

- 公司信息:

- WH

- 工作经验:

- 4年

- 兼职日薪:

- 700元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 北京

- 海淀

技术能力

-熟练掌握 Hadoop,熟悉 MapReduce 的工作流程和 shuffle 机制可以独立编写 MapReduce 处理数据,拥有 Hadoop 调优的经验,理解yarn 的工作机制Spark(core,sql,streaming)、Flink 等大数据开源框架

-熟练掌握 ETL 工具 kettle 进行数据(清洗,转换,整合),datax/sqoop 转储工具

-熟练掌握 SQL,有良好的编码习惯,对分布式有深刻理解

-熟练掌握 mysql/hive/redis/hbase/odps/gbase/kudu 等储存机制,简单调参调优

- 兼职 : python 数据抓取, pandas, Django, Scrapy 相关框架 JQ,JS, app 逆向等

项目经验

项目一

项目名称: 无忧系统 一

项目描述: 为企业和开发者提供结构化数据,支持数据分析处理等功能。为公司提供数据的储存和统计,全流程可视化方式帮助企业客户提升效率,降低开发门槛,快速构建 AI 应用。

开 发 框 架 : mysql+kettle+odps+gabse+hive+kylin+datax+solr+dolphinscheduler+sparkSql/hiveSql

项目职责:

1.基于业务的流程,数据仓库采取建立为四层,ODS 数据贴源层,DW 数据汇集层,DWD 数据分 析层,ADS 数据服务层。

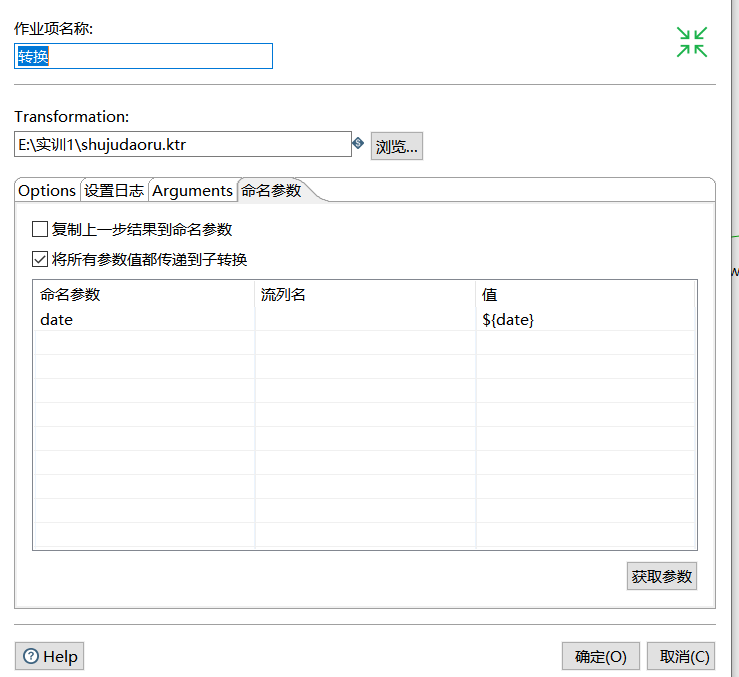

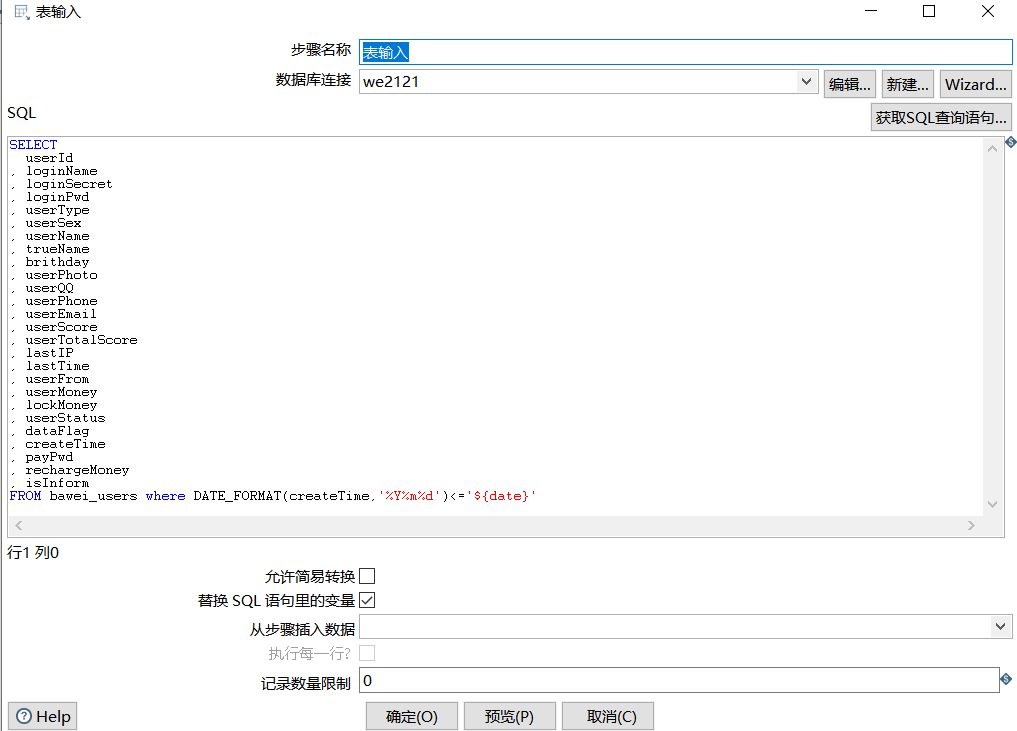

2.将mysql 数据通过 kettle 清洗软件,通过转换,作业的操作进行对数据的(去重,字段删 除,新增 列等) 传到到 ODS 层

3.进行数据及业务分析,生成结果(使用 Hive 的 hql 语句进行数据开发)。

4.通过使用HQL 进行相关指标的开发,进行指标的不同角度分析

5.Kylin 数据分析 dw 层的一个主题(保单表,客户表等)与多个维度(保单类型,支付类型,联系方式, 被保人等),进行表的业务分析

6.进行项目优化,hive,kylin 等组件以及数据倾斜的问题

项目排障:

1.在分析数据数据一直运行,运行不完成的问题: 解决方法

1). combine 使用 combine 可以大量的减小数据倾斜,combine 的 目的就是聚合精简数据2). 空值产生的数据倾斜赋与空值分新的 key 值比较好些

2.kylin 的优化

1).将敏感的维度设置为强制维度,优化后的效果为减少了一半 Cuboid 的数量。综合优化下,膨胀率降至不足 750%,大大减小了 Cube 体积。

2).关闭 HBase 自动 Balance 的功能,仅在夜间业务低峰期开启几个小时;

案例展示

-

12312

12132132133333333333333333333333333333333333333333333333333333

-

12123213

23333333333333333333333333333333333333333333333333333333333333333333333333333333333321111111111111111

相似人才推荐

-

500元/天研发工程师/技术经理广西无止境软件科技有限公司概要:1、精通 C#、Javascript、熟悉 HTML、XML、CSS 等语言 2、熟悉 Asp.

-

800元/天技术总监星河科技概要:前端后端,安全防护,数据维护。都会,反编译。破解,前端vue 后端node.js Java ,Ja

-

1500元/天算法工程师百度概要:985硕士计算机硕士,主要研究方向是计算机视觉,自然语言处理,熟悉语言python,java,c++

-

1000元/天资深后端开发工程师网易概要:十年以上工作经历程序员,做过大型电信领域软件、做过互联网金融理财平台、也做过电商服务saas服务软件

1000元/天资深后端开发工程师网易概要:十年以上工作经历程序员,做过大型电信领域软件、做过互联网金融理财平台、也做过电商服务saas服务软件 -

500元/天高级开发工程师1概要:1、精通主流Web应用开发框架(Spring,Play!,Express,Django,等等);熟悉

-

500元/天项目总监广州思车网信息有限公司概要:1.热更新 (及时解决线上问题) 2.runtime(json解析、数据越界、扩大button

-

500元/天研发经理北京爬虫科技有限公司概要:精通HTML、JavaScript、XML、Ajax等编程技术 精通MVC(Model/View/

-

500元/天架构师阿里巴巴概要:- 精通Java Web开发 , Spring/Spring Boot/Spring Cloud A