🐍 有团队

高级大数据工程师

- 公司信息:

- 华讯科技

- 工作经验:

- 4年

- 兼职日薪:

- 700元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 西安

- 全区

技术能力

1、熟悉 Hadoop 生态圈,HDFS、MapReduce、Yarn 的工作机制,有调优经验,能搭建 Hadoop 高可用集群

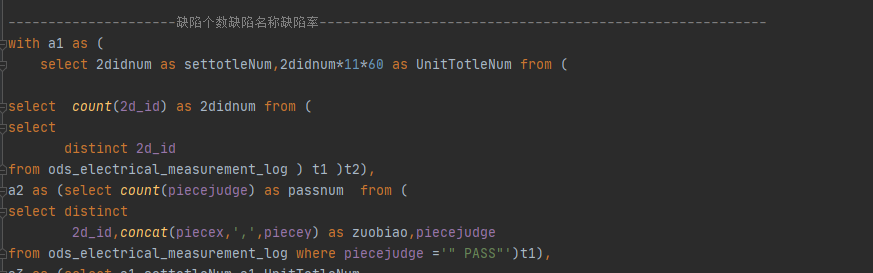

2、熟悉 Hive 数据仓库工具,对日志数据进行查询、统计等操作,并且有一定数据优化经验

3、熟悉 Kafka 的架构以及基本原理,集群的部署以及安装,熟悉 Kafka 消费数据,能解决 Kafka 数据丢失、重复、挂掉等问题

4、熟悉使用 各个数据迁移工具,例如Datax\Sqoop\Maxwell,

5、熟悉 Zookeeper 常用命令、CAP 法则以及 Zookeeper 的选举机制

7、熟悉 Hbase 的基本架构和数据模型以及高可用的搭建,了解 rowkey 的设计原则并结合 Phoenix 建立索引

8、熟悉 Spark 中 Spark Streaming,Spark Core,Spark SQL 的开发和 Spark 常用的 RDD 算子,熟悉 Spark 的运行模式

9、熟悉 Flume 的工作原理,Flume 的组成以及 Flume 的拦截器、选择器、监控器

10、熟悉 Flink 的集群组成,时间语义以及 Flink 的 Watermark 机制

12、熟悉使用 Spring,SpringMVC,Mybatis,Struts2,Hibernate 等常用框架

13、熟悉使用 SpringBoot、SpringDate-JPA、Redis、Springcloud 微服务等相关开发技术

14、了解 Elasticsearch 文档数据库的安装使用,Kibana 可视化平台的使用

项目经验

2021/9—2021/12 工厂实时流平台

项目架构: Kafka+Flink+HBase+Redis+python+flume+Iceberg

项目描述: 在某工厂中,机台不断产生非结构化数据,实时更新内部ERP系统信息,整个工厂的114台机器并行传输数据,需要把这些数据使用高可靠的采集方式,低成本的存储空间,高效率的查询做出整体架构调整

技术实现: 1. 机台将图像数据转换成结构化的文本数据,存到文本文件中中;

2. 通过FlinkCDC监控 提供API将数据导入到Kafka中;

3. 通过Flink从Kafka获取数据,编写代码,实现实时存储;

4. 将分析结果通过API写入HBase,并缓存到Redis中;

5. 前台获取Redis中的数据,做出判断;

责任描述: 负责实时数据流的整体架构设计及部署,对一天1T的数据量存储做出优化,

对接ERP系统,并行化采集数据,实时存储读取,给工厂搭建实时数仓模型用于后续AI优化工艺

解决的问题: 解决工厂业务方面设备的渐发性故障,各种原因导致设备劣化老化,逐渐发展而产生的的故障,此指标制定规则为,发生故障的概率与本设备的使用时间,设备使用时间越长,发生故障概率越大

团队情况

- 整包服务: 微信公众号开发 微信小程序开发 PC网站开发 H5网站开发 App开发 WebApp开发 文档原型图 其他开发

| 角色 | 职位 |

| 负责人 | 高级大数据工程师 |

| 队员 | 产品经理 |

| 队员 | 前端工程师 |

| 队员 | 后端工程师 |

案例展示

-

工厂数仓

责任描述: 负责实时数据流的整体架构设计及部署,对一天1T的数据量存储做出优化, 对接ERP系统,并行化采集数据,实时存储读取,给工厂搭建实时数仓模型用于后续AI优化工艺 解决的问题: 解决工厂业务方面设备的渐发性故障,各种原因导致设备劣化老化,逐渐发展而产生的的故障,此指标

-

大数据平台

项目架构: SpringBoot+Akka+SpringCloud+Ajax+jQuery+Solr+vue+ELK 项目描述: 大数据平台,提供数据集成、数据加工、数据处理等功能,通过数据源组件提供的海量数据集成和计算能力,让用户通过使用一个工具就可以快速完成数据湖、数据仓库

相似人才推荐

-

500元/天后端自由职业概要:成不成一切看缘分成不成一切看缘分成不成一切看缘分成不成一切看缘分成不成一切看缘分成不成一切看缘分成不

-

500元/天nlp工程师中科院信工所概要:熟悉nlp相关技术,熟练使用各个深度学习框架等,熟练使用python语言,为人积极耐心,熟悉nlp相

-

800元/天项目经理厦门市易联众易惠科技有限公司概要:掌握oracle数据库搭建,熟悉sql语句,可以数据库二次开发;熟练掌握影刀rpa开发,可以快速实现

-

1500元/天高级信息安全工程师同威科技概要:熟练掌握php/python/java/C/C++等编程语言,有一定的源代码安全审计能力。 熟悉常

-

600元/天产品经理珠海米水科技有限公司概要:UI设计,原型图。主要技术栈:后端java(springboot,springcloud),前端vu

-

800元/天中级开发长亮科技概要:1、精通Python数据爬虫,基于Python的Excel数据分析,JavaScript安卓开发,熟

-

500元/天学生安徽理工大学概要:我是大学生,我是廉价劳动力。我是大学我是大学生,我是廉价劳动力我是大学生,我是廉价劳动力我是大学生,

-

800元/天STM32研发工程师北京宏光星宇科技发展有限公司概要:可独立完成单片机主控软件及上位机编程,已研发的项目批量生产,销量有500K,200K,100K,30