ID:277750

阿白

无

- 公司信息:

- 无

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 可工作日驻场(离职原因)

- 所在区域:

- 厦门

- 全区

技术能力

精通python爬虫和数据分析,能熟练处理字体反爬,js逆向等反爬,能根据需要爬取的数据进行需求分析,分析目标网站的网站结构和反爬手段,精通requests、scrapy、scrapy-redis、xpath、css、re、bs4等技术手段编写程序进行内容爬取,对爬取到的数据清洗过滤,将数据储存到mongodb,mysql数据库。

项目经验

有盗墓笔记,boss直聘,腾讯招聘,京东,当当、豆瓣、猫眼、瓜子二手车,大众点评,新浪财经,斗鱼,有道翻译,百度翻译等知名网站的项目经验

案例展示

-

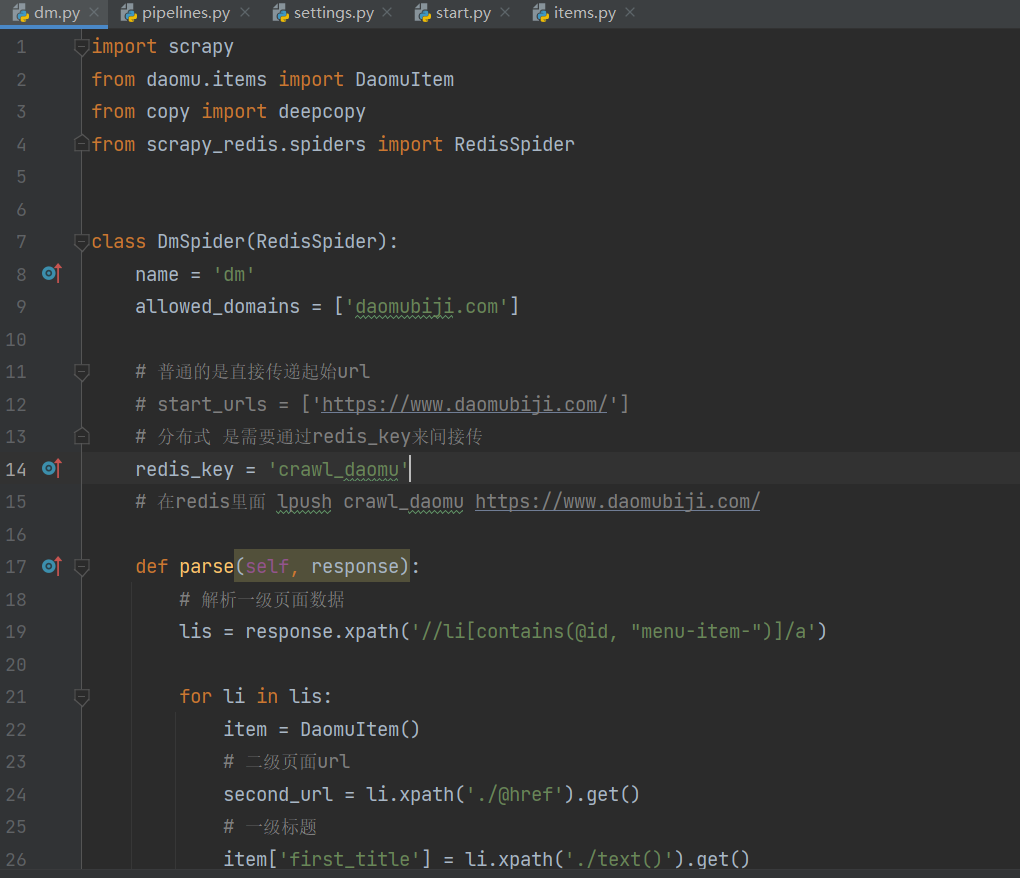

scrapy-redis之盗墓笔记

由于爬取数量较多为提高爬取速度选择用scrapy-redis分布式爬取 首先先分析网页,需要从一级页面获取大标题和二级页面的url,从二级页面获取各章节名称和三级页面url,在三级页面获取小说具体各章节的文本呢内容,再编写爬虫程序,运用xpath解析,再保存数据,再settin

-

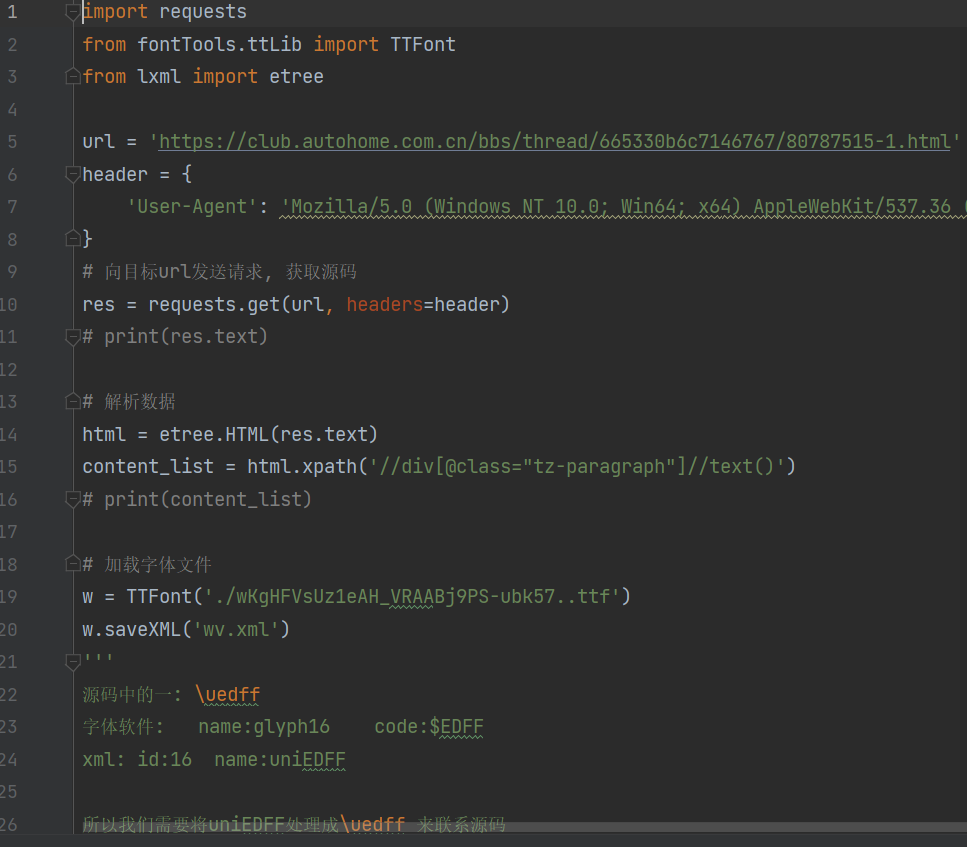

汽车之家(字体反爬)

由网页源码中分析可知该网站由字体反爬,我们需要去找到他对应的字体文件去解析,得到一个替换字典,替换源码中的乱码字体。

-

汽车之家(字体反爬)

由网页源码中分析可知该网站由字体反爬,我们需要去找到他对应的字体文件去解析,得到一个替换字典,替换源码中的乱码字体。

相似人才推荐

-

500元/天工作室创始人PM工作室概要:安卓插件破解、Python脚本编写、网站全面编写(可直接使用)、嵌入式硬件底层编程编写、开发智能家居

-

500元/天算法工程师某IT公司概要:1. 熟悉使用Linux命令及相关开发工具,比如:git, vim等; 2. 熟悉C++,Pyth

-

600元/天大数据开发工程师奇安信概要:1.熟练使用Python和anaconda,可使用其进行数据爬取,数据分析,数据可视化以及自动化脚本

-

500元/天没有没有概要:其它其它其它其它其它其它其它其它其它其它其它其它其它其它其它其它其它其它其它其其它它其它其它其它其它

-

2000元/天无无概要:前端技术 •熟练使用JavaScript和jQuery技术制作页面特效; •熟练使用jQuery

-

500元/天爬虫技术公司概要:利用抓包工具,能JS逆向网络抓取数据,模拟登录,代理IP,解析方式(xpath,re,beautif

-

500元/天文员追梦企业服务有限公司概要:有web开发能力和python能力c++的技术JavaScript和Java////////////

-

500元/天无无概要:通过各种专业的省、国家计算机考试有二级计算机、一级计算机考试。可写一级或者二级 2、熟悉各种语