*寒*

智能应用开发工程师

- 公司信息:

- 厦门市美亚柏科信息股份有限公司

- 工作经验:

- 5年

- 兼职日薪:

- 600元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 广州

- 海珠

技术能力

1、擅长 java 编程以及jvm虚拟机

2、 熟悉 javaWeb并掌握 springmvc、Springboot、mybatis、maven、git、svn 等技术

3、 熟悉 oracle/mysql/Greenplum 等数据库的 SQL 和优化、函数,以及 redis 内存数据库的使用

4、 掌握 kafka、ActiveMQ 消息队列的使用

5、 掌握前端 JavaScript 编程,以及 jQuery、vue 框架的使用

6、理解 hadoop 的分布式文件系统,掌握 hadoop 集群的搭建,对业务完成 Map/Reduce 编程8、熟悉 Elasticsearch+logstash+kibana(ELK)实时日志分析平台使用

7、理解 spark 工作机制。掌握 spark 任务的执行流程,掌握 Spark Streaming/Struct Streaming 流式处理技术, 利用 Spark SQL 进行数据处理、查询、统计

项目经验

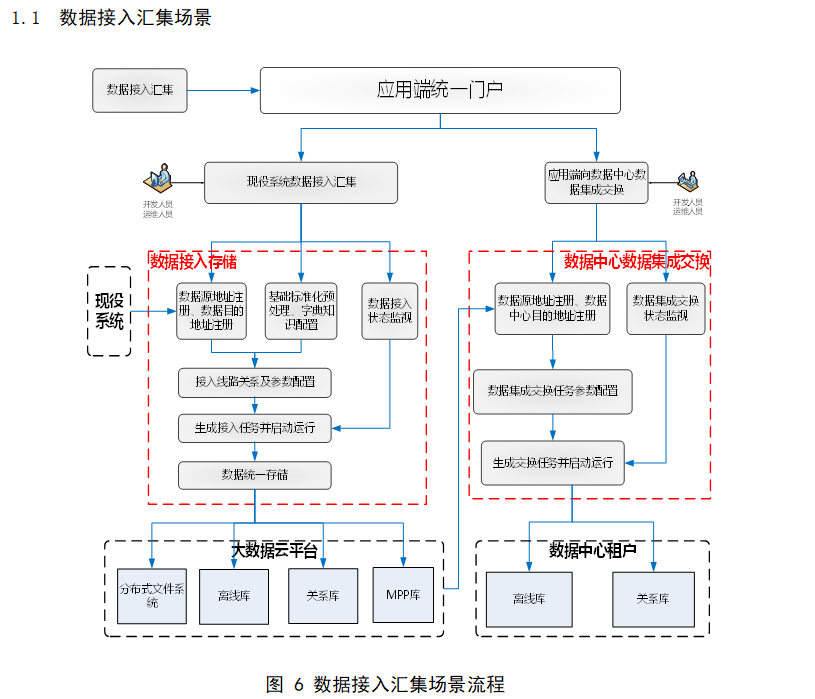

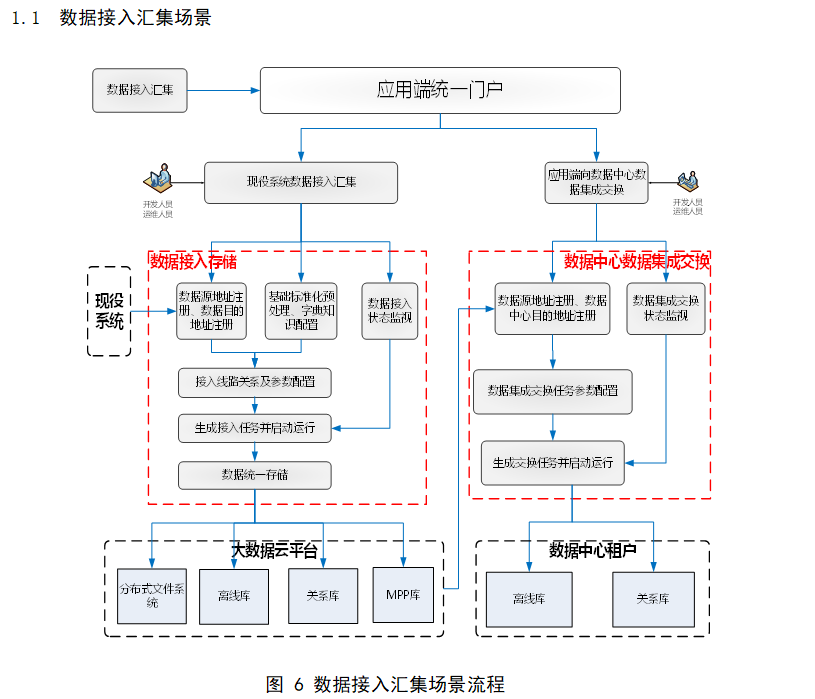

项目一:数据接入平台

开发环境: IDED+maven+jdk1.8+Linux+git

系统架构: springboot+dubbo+mybatis+mysql+redis+python

项目描述:对各个不同的异构数据源的数据进行搬运以及接入,包括关系型数据库如mysql、oracle、libra、greenplum、hive、SqlServer等,以及文本型数据库elasticsearch、MongoDB,消息队列kafka,文件系统Hadoop、ftp(文件包括csv、Excel、txt、json等),对源头数据进行探查其数据量、表字段名称描述、字段类型,并在目标数据库生成表结构,然后进行搬运(IDU,全部成功获取全部失败),搬运成功后对数据进行对账;

主要有三大模块:

1、库探查、表探查、字段探查;

2、数据搬运;

3、数据量对账。

项目二:da-workbench 大数据管理平台

开发环境: IDEA+ PyCharm+maven+jdk1.8+Linux+git

系统架构: springboot+mybatis+spark+Elasticsearch+logstash+kibana+kafka+mysql+redis+python_pandas 项目描述:数据管理平台主要有四大模块:1.基于 ELK 对业务日志数据进行采集、清洗转换、入库;2.python 离线统计汇总(如缓冲率、加载时长等指标),并存储到 es 以及 mysql,为 dmp 模块提供数据支持;3.spark 在线统计模块,主要实现在线人数统计、当前流量统计等,为用户提供实时统计数据;4.dmp 汇总数据以及指标查询模块。工作职责: 1、直播点播视频二次缓冲率以及首屏加载时长统计以及 echart 图表生成(python 编程);

2、通过 Struct Streaming 统计实时在线人数(java 编程);

3、ELK 平台使用,采集业务日志、清洗入库后,供技术支持快速定位问题;

4、功能需求方案设计以及编写。

项目三:智能语音质检分析系统

开发环境: IDEA+ Gradle+jdk1.8+Linux+git

系统架构: spring+springmvc+ mybatis+redis+ Elasticsearch 文本搜索引擎+ kafka+mysql+spark

项目描述:智能质检分析系统主要分为三部分:1.科大引擎对语音的转译成文本和入库;2.系统结合转译文本实现对录音进行人工质检和智能质检;3.系统基于语音的业务进行数据分析。通过智能质检分析能有效地改善呼叫中心的服务质量,质检模块主要实现了人工抽样质检、系统抽样、系统自动评分、定时任务监控、坐席申诉;分析模块偏向算法分析,实现了综合查询、热点分析、交叉分析、聚类规则、语音特征分析等功能。

工作职责: 1、负责系统部分需求文档的编写以及部分功能的设计;

2、前后台代码的开发和 bug 修复,主要为对数据清洗并入库,文本质检以及分析三大模块;

3、进行单元测试、功能接口的测试;

4、系统的在测试以及正式环境的部署以及维护。

案例展示

-

数据接入平台

1、对各种库探查如ip端口账号密码等 2、连接上数据库后探查数据库所有表信息,包括表数据量,表名称、描述等; 3、选择某一张表进行结构探查,获取字段名称、描述、类型等信息 4、选择数据需要搬运到具体的某一个数据库,如果没有表则进行创建后进行搬运 5、如果搬运成功则进行双

-

其他历史案例在内网无法提供

其他历史案例由于在内网开发,无法提供对应代码以及系统截图,暂时无法提供,目前只能提供接入平台项目的案例

相似人才推荐

-

500元/天后端工程师联通概要:python开发,自动化运维工具开发,办公自动化开发,ETL流程自动化开发,基于hive\hadoo

500元/天后端工程师联通概要:python开发,自动化运维工具开发,办公自动化开发,ETL流程自动化开发,基于hive\hadoo -

500元/天研发经理广西阿佳希概要:本人有 10年 C# ERP开发经验 前后端皆可做 承担过多个 中、大型 ERP 开发主力 熟

-

1200元/天Senior Software Engineer通用电气医疗(中国)有限公司概要:1.熟练掌握高级软件编程知识,具备良好的面向对象编程思想,熟悉常用设计模式,深入了解多线程并发编程。

-

800元/天软件开发工程师某航空电子商务有限公司概要:本人从事计算机软件编程已有10余年的工作经验,十年磨一剑,在这10年工作中对于这样一份工作我始终保持

-

500元/天软件开发中讯软件概要:1、擅长sql编写,熟悉java,熟悉数据库Db2、mysql、oracle。 2、数据ETL处理

-

500元/天后端工程师黄河水利科学研究院概要:编程语言: java kotlin es6 | springboot相关, mybatis plus

-

1500元/天创始人潍坊丁元计算机技术有限公司概要:熟练应用: Java、C/C++、Python、HTML、JavaScript、UML、XML、XS

-

1000元/天技术总监安徽创易斯威信息科技有限公司概要:团队成员20人: 前端工程师:vue,uniapp,HTML,CSS,HBuilder JAVA