一只余光萧瑟的scrapy_小白

大数据采集工程师

- 公司信息:

- 广东财贸职业学院联想产业学院

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 所在区域:

- 广州

- 番禺

- 南村万博

技术能力

使用 scrapy 爬虫框架及模块 requests 爬取数据

使用 selenium 模拟登陆技术

使用 xpath、re 等进行页面解析

使用 mysql、redis、mongoDB 等数据库

使用技术破解常见的反爬机制

项目经验

项目一:招聘网站爬虫+招聘网站开发+数据分析 开发工具:PyCharm+python3

技术模块:requests、xpath、re、pymysql、线程池、flask 框架、echarts

项目描述:爬取兼职猫所有招聘信息数据,mysql 建模,数据清洗后进行存储,flask 服务端程序搭建,echarts 统计数据可视化

职责描述:

1、使用多线程爬取兼职猫招聘网站信息;

2、使用 xpath、re 进行页面分析并提取数据;

3、将清洗后的数据按照表结构保存到 mysql 表中;

4、使用 flask 框架模拟兼职网站,将数据展示;

5、前端可进行筛选查询、职位信息查看;

6、使用 sql+python 进行信息进行统计,使用 echarts 展示网站统计数据。

项目二:二手车信息爬虫+数据分析开发工具:PyCharm+python3

技术模块:requests、xpath、re、redis、线程池、mongodb 项目描述:爬取华夏二手车所有二手车信息,对数据进行统计(品 牌分析、二手车品牌占比、折旧率分析等)

职责描述:

1、使用 requests、concurrent 线程池,queue 队列抓取网页数据;

2、购买代理 ip,实现代理 ip 池,定期检测 ip 的可用性,维护代理 ip 池的质量

3.通过正则、xpath 等清洗网页内容并保存数据到 mongodb;

案例展示

-

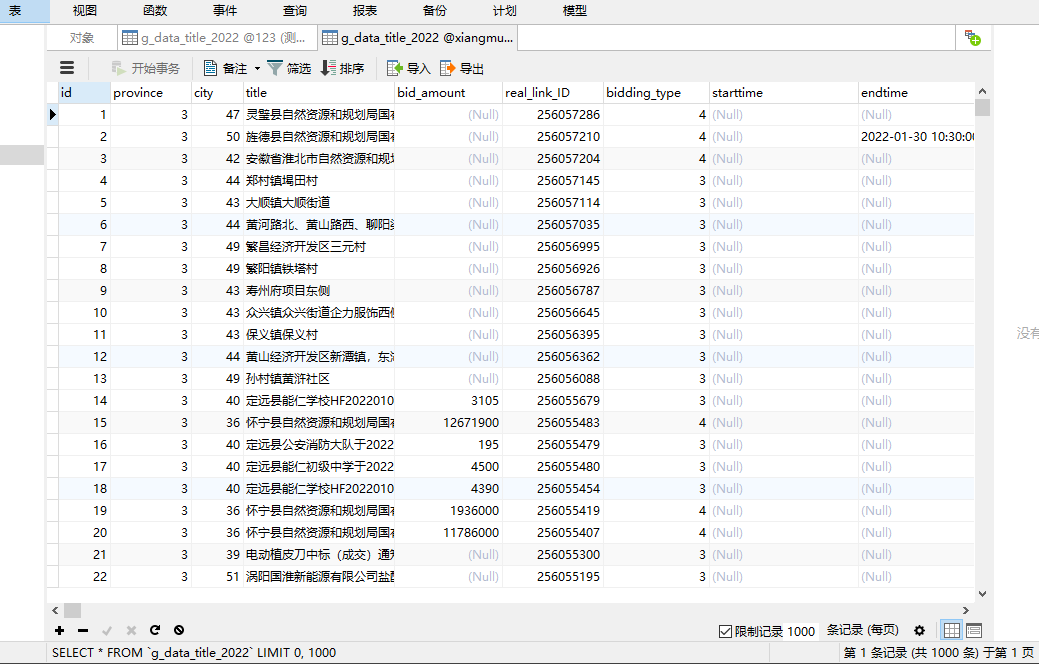

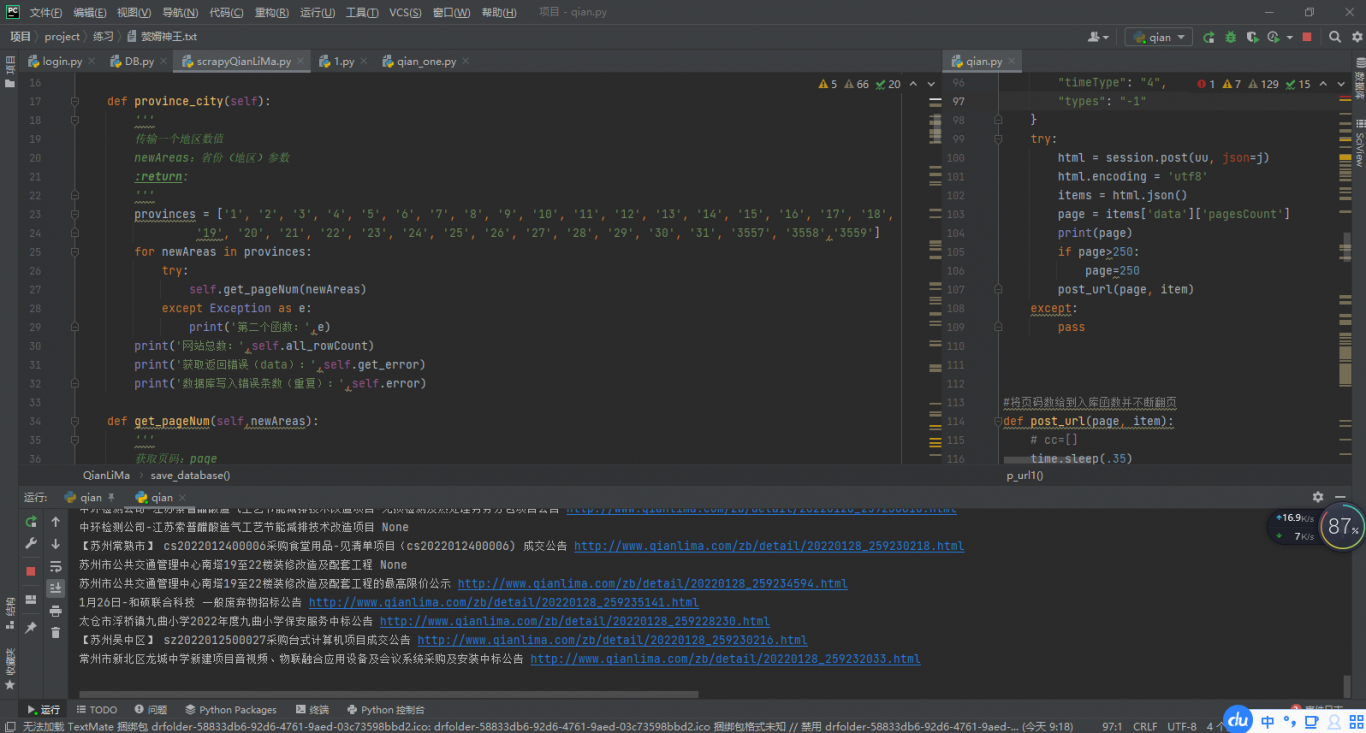

千里马

1.根据需求在网站采集相关数据信息 2.将采集下来数据进行清洗并查重 3.将采集到数据存入公司的数据库

-

华夏汽车

二手车信息爬虫+数据分析开发工具:PyCharm+python3 技术模块:requests、xpath、re、redis、线程池、mongodb 项目描述:爬取华夏二手车所有二手车信息,对数据进行统计(品 牌分析、二手车品牌占比、折旧率分析等) 职责描述: 1、使用 r

相似人才推荐

-

500元/天博士研究生中科大概要:主要研究方向为软件性能分析与优化,有大量基础函数库优化经验(如glibc、OpenBLAS、FFTW

-

500元/天学生兰州城市学院概要:python人工智能 java开发 C/C++开发 HTML/CSS/JavaScript开发

-

700元/天开发工程师哲远科技概要:精通C语言,C++,python等基础语言,大学主要研究python数据分析。对数据分析有独到见解。

-

1000元/天工程师广州市印科科技有限公司概要:熟练掌握 C++, VB.net 语言, 具有良好的编程思想; 熟练掌握 UI 控件特性, 手势,

-

500元/天1上海概要:1111111111 1111111111 1111111111 1111111111 111111

-

500元/天数据采集中国云讯招标网概要:1.熟悉python编程,会写python爬虫项目。 3.熟悉python爬虫相关库request

-

1000元/天技术副总裁深圳理想动力信息技术有限公司概要:主要技能 c#开发Windows桌面应用程序、爬虫(淘宝、拼多多、京东商品数据、优惠信息、店铺信息

-

500元/天经理苏州星昆网络科技有限公司概要:擅长项目 1,Linux相关运维,课程制作等 2,python可单独写脚本,有爬虫经验,并掌握部