fine 有团队 身份已认证

高级python后端开发

- 公司信息:

- 北京华研数据有限公司

- 工作经验:

- 5年

- 兼职日薪:

- 600元/8小时

- 兼职时间:

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 北京

- 西城

- 西单国际大厦

技术能力

前端 html、css、JavaScript

后端 python、flask、django

搜索 elastic search

爬虫 request、scrapy

系统 linux、shell

数据库 mysql、redis、mongo

项目经验

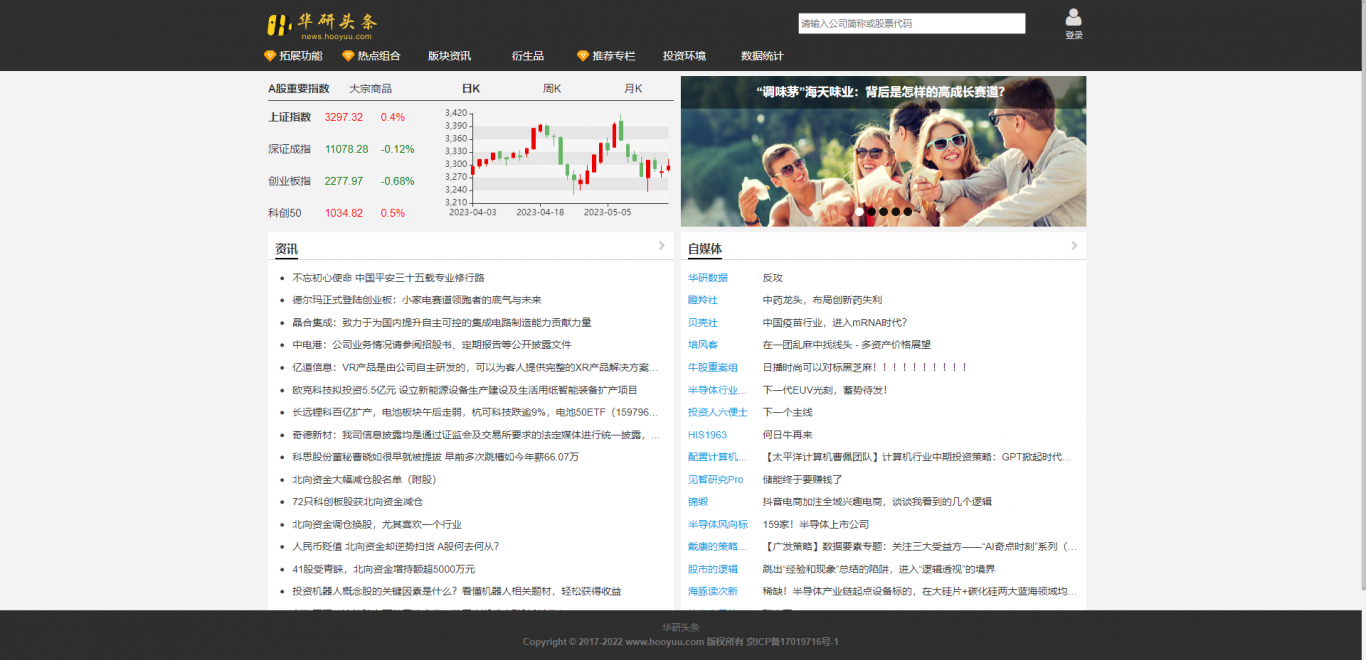

为民众提供股票公司相关的舆情信息, 包含资讯、研报、 公告、自媒体、股票数据等相关数据和工具

技术要点:Scrapy(舆情资讯爬取) + Requests(股票数据爬取) + Mysql(股票历史数据存取) + Flask(华研头条核心内容接口) + ElasticSearch(舆情数据存取、搜索、数据分析) + Mongo(舆情数据备份、带标签的文章、股票数据存取 和 头条一些网站数据、金融数据和统计结果存取) + Redis(缓存) + Neo4j

责任描述:

1. Scrapy框架建立舆情新闻爬虫基础设施, 设立字段规范,负责爬虫爬取决策和方案(后期有其他同事专门写爬虫);

2. Requests 爬取公司股票的交易信息,金融数据, 存入mysql或者mongo;

3. 利用ElasticSearch系统进行舆情新闻预分类和缓存,还有舆情分析(文章每日数量, 热门作者等)

4. Flask 框架建立爬虫舆情系统的核心内容接口,包括股票、 舆情文章、数据分析结果、搜索功能、用户关注作者和通知等接口;

5. Redis用于缓存和临时数据存取, Neo4j存取公司数据和关系

做全国煤机行业一站式采购平台先行者 矿宝网

技术要点:Django + MySQL + Whoosh + Haystack + jieba + HTML + CSS + JQ + Ajax

责任描述:

1. 设计用户信息模型、商品信息模型;

2. 用户注册对用户信息校验,并对密码进行加密存储;

3. 登录成功后对 cookie 和 session 处理,以及对页面的追踪跳转;

4. 通过装饰器判断用户登录状态;

5. 实现商品的展示,商品的分页,以及对客户最近浏览的保存;

6. 使用 whoosh 引擎和 jieba 词库实现了商品关键词检索功能;

团队情况

- 整包服务: 微信小程序开发 PC网站开发 H5网站开发 UI设计

| 角色 | 职位 |

| 负责人 | 高级python后端开发 |

| 队员 | 产品经理 |

| 队员 | UI设计师 |

| 队员 | 前端工程师 |

| 队员 | 后端工程师 |

案例展示

-

华研头条(投资舆情参考讯息网站)

为民众提供股票公司相关的舆情信息, 包含资讯、研报、 公告、自媒体、股票数据等相关数据和工具 技术要点:Scrapy(舆情资讯爬取) + Requests(股票数据爬取) + Mysql(股票历史数据存取) + Flask(华研头条核心内容接口) + ElasticSearch

-

矿宝网电商平台后端

做全国煤机行业一站式采购平台先行者 矿宝网 技术要点:Django + MySQL + Whoosh + Haystack + jieba + HTML + CSS + JQ + Ajax 责任描述: 1. 设计用户信息模型、商品信息模型; 2. 用户注册对用户信息校验,

相似人才推荐

-

500元/天python开发师暂无概要:目前掌握python、html、css、javascript编程语言,熟练的语言为python。熟悉

500元/天python开发师暂无概要:目前掌握python、html、css、javascript编程语言,熟练的语言为python。熟悉 -

500元/天高级python工程师百度概要:对于计算机语言精通接下来这些 Java语言精通,python 语言精通,uniapp语言精通,ht

-

500元/天高级PHP开发工程师 和 python重庆万人联科技概要:php apache nginx linux thinkphp html css jquery

-

500元/天Python云巅科技概要:1、Python语言基础语法入门。Python基础语法入门,数据类型、字符编码、文件操作,函数、递归

500元/天Python云巅科技概要:1、Python语言基础语法入门。Python基础语法入门,数据类型、字符编码、文件操作,函数、递归 -

800元/天python数据开发与爬虫开发江西电信信息产业有限公司概要:1.大数据技术实际经验…电信日志大数据项目; 2.数据开发,后端开发各种业务数据处理; 3.网络

-

500元/天python开心帮概要:Python 基础扎实, 有良好的编码习惯; 了解HTML + CSS 网页设计, 熟练基于 R

500元/天python开心帮概要:Python 基础扎实, 有良好的编码习惯; 了解HTML + CSS 网页设计, 熟练基于 R -

1100元/天算法工程师百度概要:C/C++, Python, Shell 网站开发,小程序开发,后端开发 机器学习,深度学习

1100元/天算法工程师百度概要:C/C++, Python, Shell 网站开发,小程序开发,后端开发 机器学习,深度学习 -

700元/天Python开发华为概要:1. 熟练掌握Python及其标准库。 2. 熟练掌握HTTPS/HTTP协议,熟悉TCP/I