MarioPeng

高级大数据开发工程师

- 公司信息:

- 智协慧同

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 上海

- 杨浦

技术能力

有三年大数据开发,大数据运维,以及java开发的工作经验

拥有Java、Python、Scala 开发经验

熟练掌握 Linux 操作系统 和 Shell 脚本

熟悉 Hadoop 生态圈的 HDFS、YARN、Zookeeper、Oozie、Flume 等组件

熟悉 MapReduce、Spark Core、Spark SQL、Spark Streaming 编程及调优

熟悉 MySQL、HBase、Hive 、Redis 等数据存储工具,有一定SQL优化能力

熟悉 Kafka 分布式消息队列原理,使用 Kafka 进行 Spark 流式开发

项目经验

项目介绍:统计***app的用户行为日志,进行数据清洗和用户行为分析,项目具有完善的数仓分层架构以及优化,可以在业务上进行灵活的扩展,良好的ADS层优化方案以加速查询和报表展示,也可以进行脏数据的统计和示警。

使用技术:Mapreduce、HDFS、Hive、MySQL、Flume、Oozie

责任描述:

参与数据仓库分层与建模的设计

参与封装MR的任务工作链,统一代码的书写规范

负责ETL数据清洗的实现

负责相关业务字段的查询(根据需求查SQL)

负责后期的维护以及项目优化

项目介绍:为了增加公司旗下****app的客户黏粘性,扩展app的新闻资讯栏目,项目组决定使用python语言开发的多机,分布式的高并发框架,并以这个框架为核心,实现新闻网页自动下载与存储

使用技术:Hadoop,Python,Shell,PhantomJs,Redis,Kafka,Mysql

责任描述:

负责编写基于生产消费模式通用的多机多线程框架

负责Mysql中表的结构设计

负责Python发现新闻,下载新闻部分代码的实现

参与了项目的性能优化(例:Redis代替Mysql)

案例展示

-

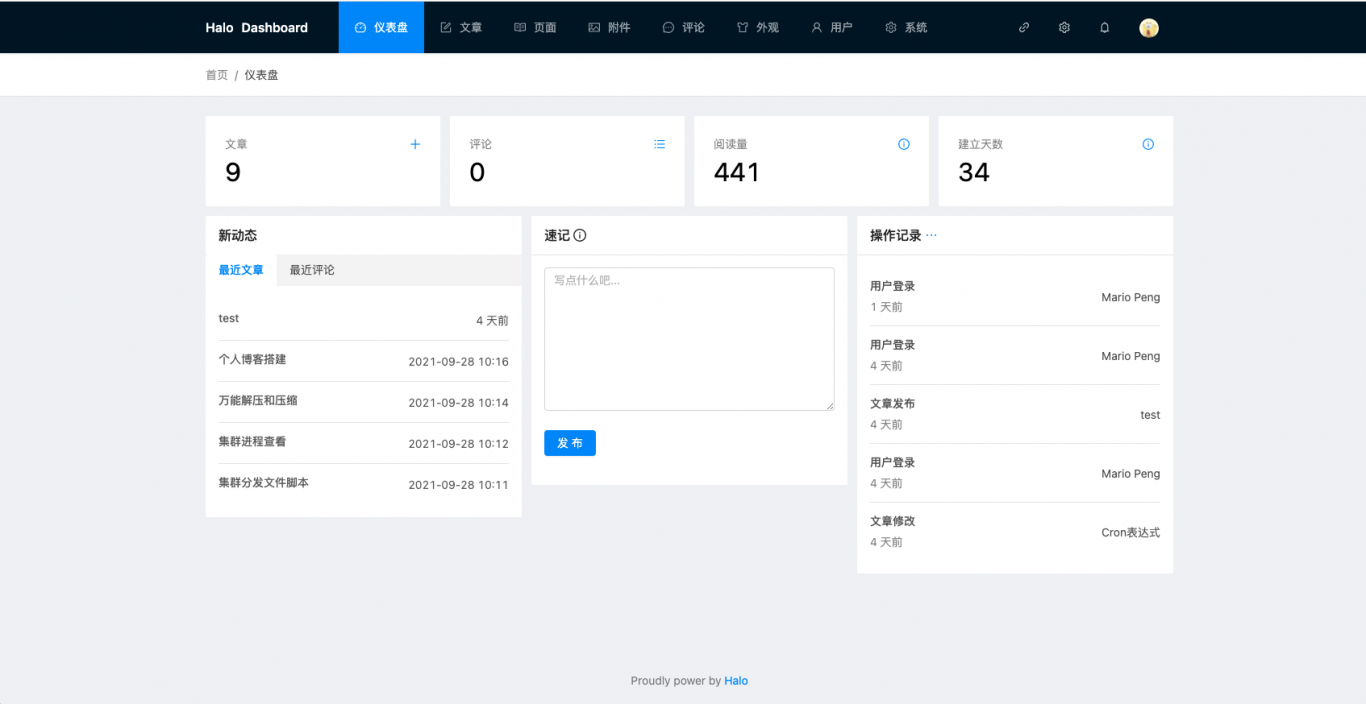

个人博客系统

从服务器,域名的购买,到博客系统图床搭建,博客系统搭建,博客主题的前端页面开发,均有本人独立完成,本博客系统使用了开源的halo框架,欢迎有兴趣的小伙伴参观交流

-

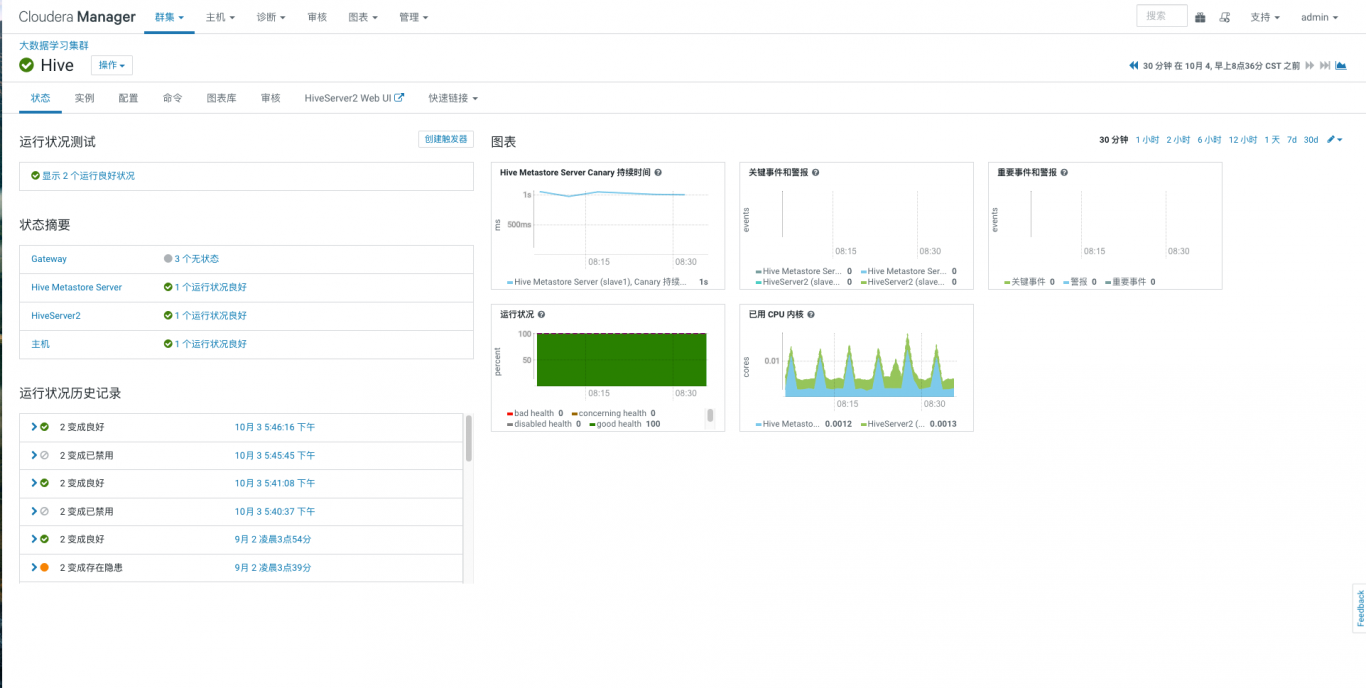

CDH集群搭建,数据分析

使用了开源的CDH搭建了数据分析大数据平台,实用spark作为hive的计算引擎,通过hdfs作为数据分析的源数据存储,通过hql进行相应需求的数据分析,得出结果,通过数据大屏或图表进行数据展示

-

python爬虫

使用python语言开发的多机,分布式的高并发框架,并以这个框架为核心,实现新闻网页自动下载与存储 使用技术有Hadoop,Python,Shell,PhantomJs,Redis,Kafka,Mysql

相似人才推荐

-

500元/天微服务研发工程师长春理想科技概要:熟练使用springboot框架 掌握微服务架构(springcloudalibaba)的前后端分

-

600元/天5G芯片开发工程师北京中科晶上科技股份有限公司概要:计算机科学与技术科班出身,具备扎实的程序编程基础,掌握多门编程语言,如:C++,Python,Jav

-

500元/天资深软件工程师携程旅游网络上海技术有限公司概要:精通java,springboot,flink,clickhouse,mysql,hive,对js,

-

800元/天驱动开发工程师上海龙旗集团概要:1、Linux下TCP/IP及UDP等网络编程模型,熟悉select、poll、epoll等并发机制

-

800元/天技术主管、全栈工程师保密概要:高级全栈攻城师,高效沟通,做事靠谱 技术能力: php、python、nodej

800元/天技术主管、全栈工程师保密概要:高级全栈攻城师,高效沟通,做事靠谱 技术能力: php、python、nodej -

500元/天中级全栈开发工程师东方网力科技有限公司概要:熟练使用Eclipse主流开发工具 掌握Java基础知识,了解面向对象基本思想,具备良好的编程和文

-

500元/天云平台经理隐藏概要:主要开发语言java,其他开发语言python、groovy,js。 熟悉linux,docker

-

600元/天软件开发工程师依图概要:华五本科毕业,三年C/C++开发经验,熟悉C++11标准,掌握操作系统、计算机网络、数据结构与算法等