油猫饼

高级Python工程师

- 公司信息:

- 北京知新树科技

- 工作经验:

- 2年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 可工作日远程

- 所在区域:

- 山东

- 全区

技术能力

熟练掌握 urllib,Requests,Selenium等爬虫模块熟练使用appinum、fillder等工具

熟练使用flask搭建框架,进行后端开发

熟练使用 Python lxml、BeautifulSoup、json模块以及正则表达式进行数据提取熟悉 XPath 语法规则和各 CSS Selector 的使用熟悉 Scrapy 框架和 scrapy-redis 分布式框架等爬虫框架熟悉反爬虫机制,及反爬虫方法熟悉django、flask框架数据库技能:

熟练使用 MySQL数据库,了解 MongoDB,Redis 的相关操作其他技能:

熟悉Javascript语言,掌握HTML/CSS/Javascript/Ajax/JQuery等页面技术熟悉 Linux/shell环境

熟练掌握常用命令行的使用了解 jupyter,Numpy, Pandas,matplotlib,pyecharts 等数据分析

熟悉使用Photoshop+Ai作图软件

项目经验

项目名称:通过异步爬虫爬取HGMD,构建mysql数据库

项目描述:

对高通量测序数据进行数据分析时,需要对snp数据进行相关性筛选,为此需要构建基于mysql的基因突变数据库,对HGMD网站相关基因突变信息进行爬取,爬取内容包括基因名,染色体坐标,突变信息,致病信息等。爬取结果存储于mysql。

我的职责

1,采用asyncio+aiohttp以达成高并发,异步请求。

2,通过timeout设置超时重发机制,因为HGMD为国外网站,防止因为网络卡顿导致页面抓取不到产生数据不全的现象。

3,通过继承aiohttp.ClientSession类来保存cookie对象,以应对基于cookie的反扒策略

4,使用xpath进行页面解析,解析出的数据通过PyMysql模块存储于mysql数据库中

项目名称:分布式爬虫爬取北京市企业信用信息网

项目描述:

这个项目是通过scrapy-redis搭建分布式爬虫爬取企业信用信息网公布栏,爬取列表页每一项下的子页获取数据

我的职责

首先爬取首页后通过xpath匹配每个的信息块的span后构建请求,并通过scrapy.Request发送请求,用xpath匹配需要的信息。

同时循环创建下一页请求的form表单,通过scrapy.FormRequest发送POST请求。所有爬取的信息缓存到redis数据库中,

最后通过编写python脚本将redis数据库中数据读取出来加入mysql数据库。

其他爬取的网站:搜狐新闻、豆瓣、腾讯新闻网、贝壳找房、安居客等等等等。

项目名称:房源平台数据爬取

项目简介:搜集全国各地租房、房源及中介信息,并实时监测,对数据进行简单的数据清洗

项目内容:

利用 scrapy 框架编写爬虫代码对不同的城市租房信息进行爬取

定期检测爬虫程序的运行结果,针对爬虫程序出现的问题进行针对性处理,遇到问题及时更正

负责破解网站的反爬手段

项目名称:公司内部清洗系统

项目简介:寻找清洗规则,发现相同逻辑,编写代码进行清洗

项目内容:

使用flask搭建框架,将疾病的清洗规则导入数据库。

编写flask视图界面,测试交互

开发接口,上传实例进行测试,使用机器学习算法,多线程模式提高程序效率。

案例展示

-

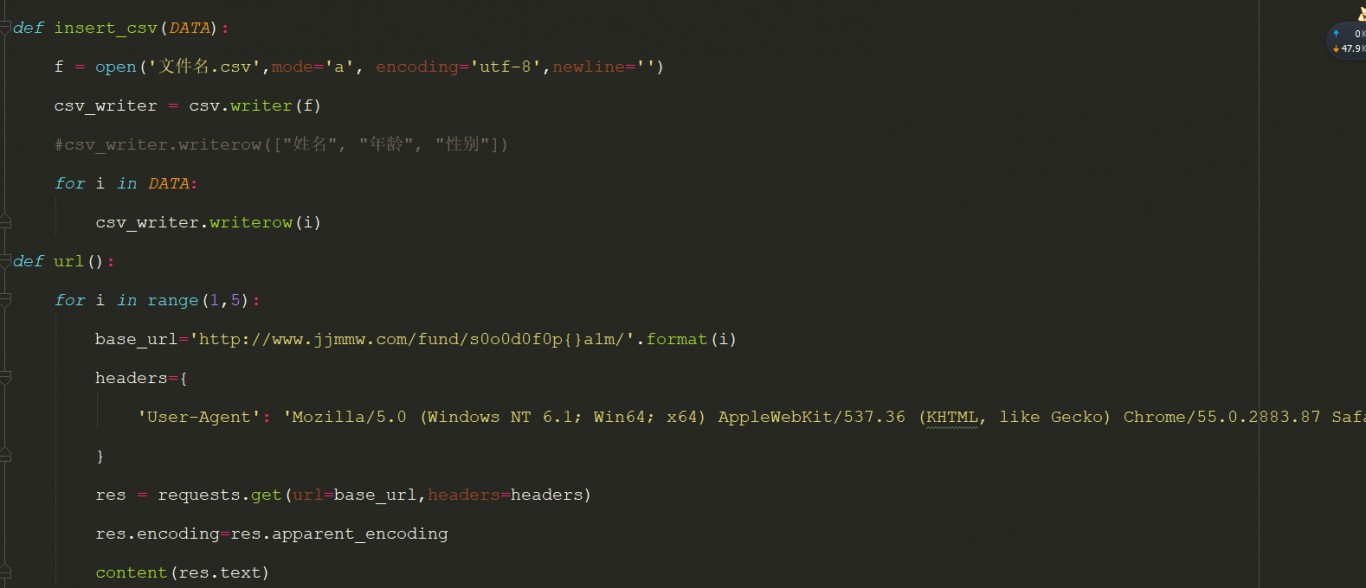

基金采集模块

爬虫网站 基金买卖网 使用模块 Requests、csv、lxml 目的 通过爬虫获取数据分析股票涨幅 1、分析网站结构,找出逻辑规则 2、编写xpath规则 3、写入数据库

-

跨境产品挖掘系统

该产品与做跨境电商的朋友共同研发,目前尚未发行。 考虑当前跨境电商大环境下,产品分析是跨境电商中必不可少的一部分。 本产品应用了数据爬虫技术,数据分析,机器学习算法。

-

跨境产品挖掘系统

该产品与做跨境电商的朋友共同研发,目前尚未发行。 考虑当前跨境电商大环境下,产品分析是跨境电商中必不可少的一部分。 本产品应用了数据爬虫技术,数据分析,机器学习算法。

相似人才推荐

-

1000元/天python开发无概要:精通oodo二次开发,熟悉python三剑客 熟悉pgsql数据库, 熟悉diango, 精通

-

600元/天python工程师武汉卓信智恒数据科技有限公司概要:*精通Java基础 *熟练掌握MVC模式开发,及Spring、SpringMVC、Mybatis框

-

1000元/天Python工程师阿里巴巴概要:熟悉H5开发,包括移动端H5,PC端开发,后端Python各种开发,基于Django框架开发的各种管

-

500元/天python研发途游概要:python数据可视化 python爬虫 python数据可视化python数据可视化pytho

-

500元/天python开发工程师 软件部门主管西安勺子智能科技有限公司概要:主Python开发,熟练掌握Django、Flask、FastAPI后端框架,熟悉Scrapy爬虫框

-

1000元/天python数据分析深圳中软国际有限公司概要:熟悉Python,会爬虫爬取数据,会用python第三方库django进行web开发,熟悉pytho

-

500元/天python工程师英格科技有限公司概要:精通python基础模块 掌握Django及rest framework后端框架 掌握爬虫相关

-

500元/天python工程师成都xx科技概要:1、掌握python,具备工程级项目能力,有2年+的python数据分析经验,非常熟悉numpy、p