小伦子 身份已认证

数据开发工程师

- 公司信息:

- 连连

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 杭州

- 余杭

技术能力

大数据框架: Flink、Spark、Hive、HBase、Kafka、Hadoop、Zookeeper

前后端框架:Flask、Django、Spring、Vue、React

数据库:MySQL、Redis

工具:Docker、 Git、Linux

编程语言:Python、Java、Scala、SQL

外语: 大学英语六级,能流畅阅读英文文档

项目经验

优惠券促活大数据模型

原来优惠券是采用固定规则发送给用户,规则不灵活,促活转换率不高,故基于用户历史订单设计一个大数据模型提高转换率和减少成本

1. 与业务方协商模型产出结果与线上实时数据对接,确定对接方式和整体模型结构

2. 针对历史业务抽取上百维度数据,在历史数据上进行训练验证,优化模型准确率达到90%以上

3. 实时监控优惠券转换率,最终模型节约了90%成本,提高了10%的转换率

文书检索项目

文书数据存贮在MySQL数据库中、由于数量在两千万左右(每天都有更新)、普通的SQL检索性能太慢、所以使用Spark批量处理数据并导入的ElasticSearch中进行检索

1. 采集行政规划数据并改造Aho-Corasick算法、实现文书地理行政规划判断、解析速率单核最终为2ms每篇

2. 负责编写Scala程序实现对每天新产生的文书解析并导入ES中、优化速率最终速率单节点100篇每秒

3. 设计动态拼接DSL、优化查询客户数据匹配、准确度提升2倍左右<

处罚文书分类系统

需要搭建一套集采集以及分类的系统来自动获取并分类处罚文书的所属公司,并搭建一套审核系统来人工审核分类是否准确

1. 设计一套通用爬虫框架支持增量和全量更新政府公开信息

2. 基于贝叶斯模型设计一套简单高效的分类器,判断文书是否为处罚的准确率90%以上

3. 基于Flask和Vue搭建了一套响应式界面来提供后台审核人员确认文书是否分类准确

案例展示

-

PB级大数据存贮查询系统

业务方后台需要搭建一套日志导入以及查询系统,总数据量在1PB左右,需要支持超过500G日志导出 1. 设计了一整套大数据处理程序,使用Spark,支持PB级数据导入HBase 2. 设计了一套基于Spring Boot的web界面,支持提交任务并导出用户详细日志

-

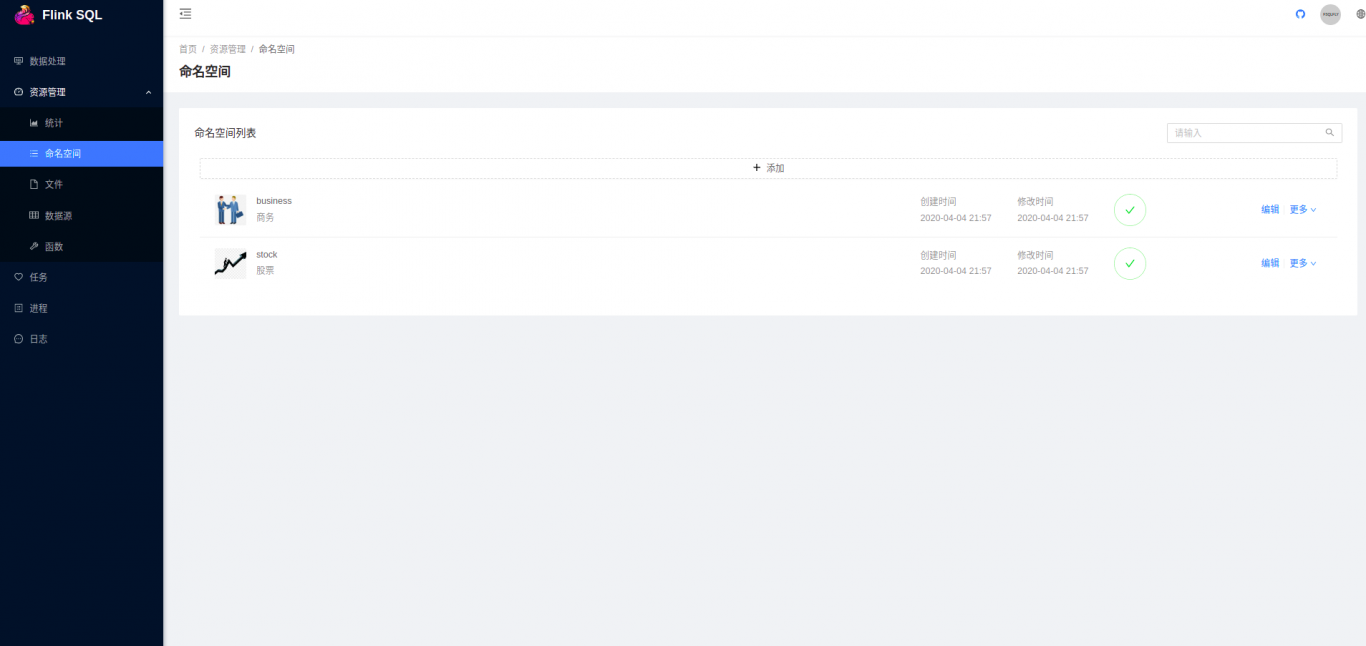

实时计算SQL管理系统

原始计算平台依赖SQL存储过程,吞吐量低、开发维护困难,进过调研各种实时计算平台,最终决定基于Flink搭建一套集开发以及监控的计算平台 1. 在迁移历史项目的时候发现,一个单一的Flink Job开发涉及到代码编写、编译、包上传、查看日志等多个步骤,开发周期以周为单位,

相似人才推荐

-

500元/天高级开发工程师神州数码信息系统有限公司概要:熟悉Python语言,以及Python的常用模块; 熟悉vue.js,nodejs,layui

-

500元/天系统研发实习生广州新略科技信息咨询有限公司概要:基本熟习C语言的应用,可以完成一些基础的project;除此之外,还会基础的python语言,及Li

-

1000元/天全栈工程师金大智胜概要:精通Java语言及J2ee开发,并拥有15年开发经验;熟悉Spring、JFinal、SpringM

1000元/天全栈工程师金大智胜概要:精通Java语言及J2ee开发,并拥有15年开发经验;熟悉Spring、JFinal、SpringM -

500元/天后端工程师软通动力概要:1.Java后台开发技能,JVM调优,垃圾回收算法,并发场景 2.常见框架,中间件及数据库,如sp

-

500元/天ABAP开发工程师SAP成都研发中心概要:C#,Python,Java,Vue CCCCCCCCCCCCCCCCCCCCCCCCCCCCCCC

-

600元/天软件工程师陕西某信息科技有限公司概要:php后端,mysql数据库,HTML前段这一系列过程比较熟悉,能够走完整的流程,以此为基础做过两个

-

500元/天计算机研究生中国海洋大学概要:本人为中国海洋大学计算机研究生,本科时为软件俱乐部PHP组组长,熟悉Javaweb,HTML,CSS

-

500元/天高级后端开发工程师济南哗啦啦互联网概要:前端:html,jquery,js,bootstrap,vue,后端:java,springboot