L.S

大数据开发工程师

- 公司信息:

- 杭州某跨境电商独角兽

- 工作经验:

- 7年

- 兼职日薪:

- 700元/8小时

- 兼职时间:

- 可工作日远程

- 所在区域:

- 杭州

- 西湖

技术能力

大数据技能

1.深入了解spark、hadoop,掌握spark-streaming、Spark SQL进行数据处理,能使用scala语言编程

2.熟悉hive的工作原理,了解数据仓库建立,完成对数据主题抽取和多维分析

3.熟练使用datax、logstash、sqoop、flume等采集工具

4.理解Hbase的存储原理,Hbase存储架构,实现数据的毫秒检索

5.掌握redis内存数据库的基本原理,实现数据的毫秒查询

6.掌握kafka缓存层的搭建和使用

7.熟练使用Linux操作系统命令,编写shell脚本

8.熟练使用python,能进行爬虫编写和数据分析

JAVA技能:

9.Java基础扎实,有良好的编码习惯,熟悉并能运用主流的Java设计模式,熟练使用多线程编程

10.熟练使用springboot、springcloud微服务框架开发。

11.熟练使用spring+springMVC+mybatis等框架的整合开发,熟悉其工作流程和原理。

python技能:

12.能使用主流技术进行数据爬取,包括代理、多线程、反爬等

数据库技能:

13.熟练 Oracle、MySQL、PostgreSQL等关系数据库熟悉Sql语句编写与优化。熟悉Jdbc、数据源、DBUtil

其它技能:

14.掌握搭建maven、svn服务器

15.掌握使用docker、dockercompose容器

项目经验

杭州某跨境电商独角兽(2019.12-2020.04)

任职部门:数据平台

任职岗位:大数据开发工程师

工作内容:datax读写组件二次开发,根据不同的同步源需求,定制开发datax读写组件,减少数据流转链路,提高同步速度;

spark实时通用采集功能开发,实时通用计算指标功能开发,通过通用性功能,提升平台易用性和通用性;

presto推广及支持,多种查询引擎针对不同场景,完成提速;

搭建推广superset,支持分析查询报表展示;

参与自研调度系统开发、zeppelin二次开发、同步采集需求部分开发工作。

杭州某数据整合科技公司(2019.8-2019.12)

任职部门:ds

任职岗位:大数据开发工程师

工作内容:编写优化文本文件预处理入库;对集群数百万小文件进行合并;开发数据管理平台;建设实时数仓,提高数据输出速度;地址库项目开发;数据新老集群迁移、gitlab迁移;910项目统筹攻坚等工作。

项目内容:

编写优化文本文件预处理入库,将文本文件合并入库到数仓做处理

对集群数百万小文件进行合并,减少主节点负担提高计算性能

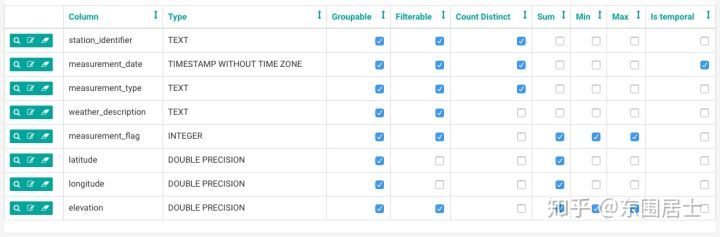

开发数据管理平台,包括数据元数据管理,业务元数据信息,数据质量监控,数据预测,数据告警等功能。

建设实时数仓,提高数据输出速度,支撑大数据量低延迟的场景

910项目统筹攻坚,拱墅区公安的人员监控项目,打通全流程包括源数据增量清洗同步等

地址库项目,从各种场景提取地址完成结构化

杭州某服务整合会员制公司(2017.4-2019.8)

任职部门:基础架构

任职岗位:资深大数据工程师

工作及项目内容:

系统架构设计,文档编写,技术选型,带领同事攻坚难点完成项目。

负责推荐系统,通过不同维度离线计算用户喜好度,结合时间段分品类商品销售等维度top表,完成离线推荐,基于数据平台通过spark协同过滤als算法等完成个性化实时等推荐;提供相关业务线的商品及服务推荐,增加用户使用粘性。

负责观察者数据分析平台,结合埋点数据,提供行为分析,用户分群,转化漏斗,留存分析等功能。

负责反垃圾系统,采用强匹配结合机器学习算法识别各种伪装的垃圾内容。

负责平台方面工作,包括负责搭建维护大数据集成环境,搭建安装ELK、kylin和大数据相关组件,负责打通流式计算采集层、kafka缓存层及维护,调研安装zeppelin presto。

负责部分实时计算开发,参与埋点和推荐的sparkstreaming的流式计算以及flink流式开发 ,消费MQ数据,通过实时处理埋点数据,入库到hdfs;并实时分析用户行为和轨迹,实现个性化推荐。

负责数仓部分工作,开发udf函数,包括建设初期入库提数加工计算工作,参与数仓dw层建设,参与基于数仓的数据可视化报表后端开发。

负责ETL系统开发维护,采用datax结合调度工具完成业务库与数仓的同步

熟悉数加平台使用。

采用cdh集成并管理监控大数据环境并持续优化,完善数据治理、数仓元数据管理、任务管理监控等内部管理。

工作业绩:

全面的数据可视化有效的支撑了业务运营的分析和决策,数据平台经过数次的迭代实现了部分的数据驱动,为公司很多重大决定及方案提供了过硬的数据指导。

基于内容的文本,图片,媒体反垃圾系统准确率达到95%,过滤绝大部分违规敏感内容和评论。

推荐系统二期上线后,日活及日活使用时长提升明显,用户反馈良好。

数据监控有效感知到数据的健康情况以及浮动情况,及时的为研发运营发现数据问题并及时纠正处理避免更大的损失。

北京某大型外包有限公司 (外包)(2013.8-2017.3)

任职部门:金融事业部

任职岗位:高级大数据工程师

工作内容:

参与数据中心方案设计,ETL流程方案讨论,数据进数出数接口设计对接,数据校验,数据T+1持续维护。

负责前期需求分析、参与方案设计和相关功能数据库设计;负责相关模块的功能实现,负责详设、概设、使用和部署文档的编写,完成核心代码编写;负责单元测试,修复程序bug;参与新知识的学习和培训;参与与其业务相关的需求变更及评审;为其他部门提供技术支持。

项目内容:

1.picc人保财险数据中心 (2016.1-2017.3)

项目及责任描述:

picc有功能繁多的项目系统,在进行数据交互的时候,会有很多的数据流转过程加大数据的丢失率以及时效性,迫切的需要一个统一的数据平台进行入数出数。

1、安装cdh维护集群运行状况,排查业务和架构问题

2、负责拉取增量数据处理并入库,增量数据每十分钟在服务器以压缩包形式生成,通过java多线程程序,每十分钟处理入库hbase

3、负责全量数据导出,全量由数据库(informix)通过shell脚本导出,初始化全量数据到hbase

案例展示

-

精要网

精要网是一个将书籍知识精简概要成一小本册子的网站,旨在让人能够快速学习从而快乐学习。零星的学习会导致基础不扎实,只有系统的学习才能真正的进入某个知识邻域;而书籍就是其中最好的方式,它不仅是人类进步的阶梯,更是人的进步阶梯。创办这个网站就是为了让自己更好更快更有效的获取想要的知识,

-

superset体验版

Apache Superset是一个数据探索和可视化web应用程序。 超集提供了: 1.一个直观的界面来探索和可视化数据集,并创建交互式指示板。 2.大量漂亮的可视化展示你的数据。 3.简单、无代码、用户流可以向下钻取,并将暴露的仪表板上的数据切片和骰子。指示板和图表作为深入分析

-

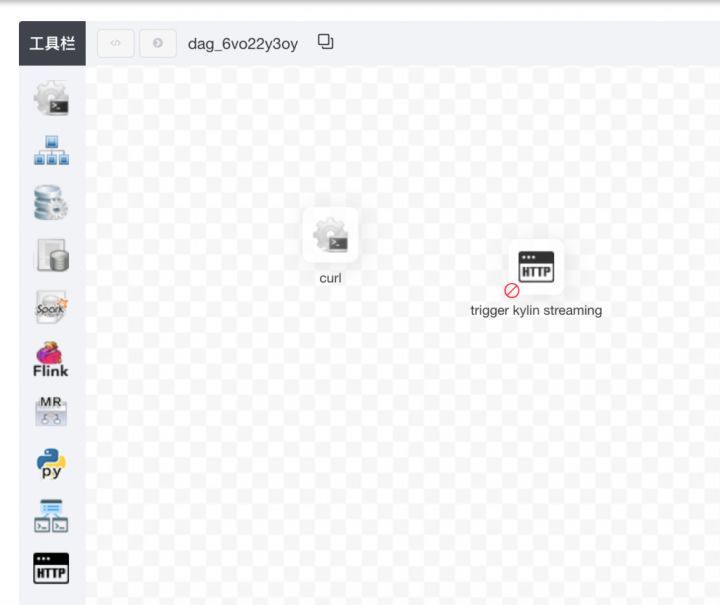

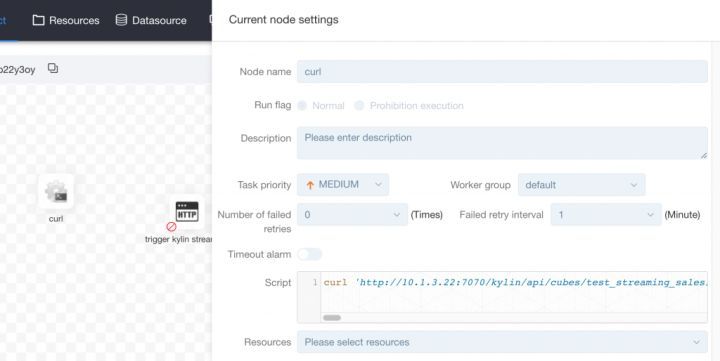

DolphinScheduler体验版

Apache DolphinScheduler是一个分布式去中心化,易扩展的可视化DAG工作流任务调度系统。致力于解决数据处理流程中错综复杂的依赖关系,使调度系统在数据处理流程中开箱即用。 高可靠性 去中心化的多Master和多Worker, 自身支持HA功能, 采用任务队列来避

-

DolphinScheduler体验版

Apache DolphinScheduler是一个分布式去中心化,易扩展的可视化DAG工作流任务调度系统。致力于解决数据处理流程中错综复杂的依赖关系,使调度系统在数据处理流程中开箱即用。 高可靠性 去中心化的多Master和多Worker, 自身支持HA功能, 采用任务队列来避

相似人才推荐

-

1000元/天高级后端工程师暴风集团概要:多年互联网工作经验,开发的项目主要有: 1.暴风影音视频ios端app 2.暴风影音视频

-

700元/天架构师、高级开发、项目经理Wind资讯、大智慧概要:10年以上工作经验。精通C#的前后台编程技术;对于面向对象编程(oop)有一定的理解并能较好的运用到

-

500元/天全栈开发工程师保密概要:技术能力: 1、 熟练掌握PHP语言 2、 熟悉html5、css、 js语法 3、 熟练掌

-

500元/天算法工程师阿里巴巴概要:Java / Python / SQL / Scala / JavaScript / C++ / C

-

800元/天部门经理昆明能讯科技有限责任公司概要:写得了方案,讲得了PPT。 跑得了市场,接待过客户。 参与过审计,懂一些商务。 策划过课题,写

-

800元/天软件研发工程师北京地平线机器人有限公司概要:熟悉C/C++, Python, Java, Matlab等语言,熟悉Pytorch, Tensor

-

500元/天技术经理河北新禾科技有限公司概要:1. 精通.Net、.NetCore、Web前端开发,熟悉IOS开发 2. 精通主流ORM框架

-

1000元/天高级测试开发工程师华宇信息技术有限公司概要:1、精通Python编程、熟练掌握Python后端开发框架Django、Flask、Tornado等