Adyan🥶

爬虫工程师

- 公司信息:

- 广州穗和智能科技有限公司

- 工作经验:

- 5年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 广州

- 全区

技术能力

熟悉Scrapy和Scrapy-redis框架,有海量数据爬取经验。

熟悉pyppeteer、requests、selenium,fiddler、Charles、mtim、appium获取网络数据信息。

熟悉正则表达式、xpath、lxml模块提取数据。

熟悉前端HTML、CSS、JS页面结构,知晓web交互流程及原理。

熟悉网站常见反爬策略,有ip池、cookie池、js解密、css解密等经验,能根据网页分析出常见反爬手段。对各类验证码的破解有深刻理解。

有微信、抖音、拼多多、苏宁易购、唯品会、京东等手机app的爬取经验

了解逆向工程,能够使用androidkiller 分析APP结构以及IDA断点调试分析

熟练使用mysql,mongodb,redis,有集群搭建和管理经验。

了解数据分析Numpy、Pandas数据处理模块的使用。

了解后端框架flask、django、tornado并编写后端。

爬虫管理系统开发

项目经验

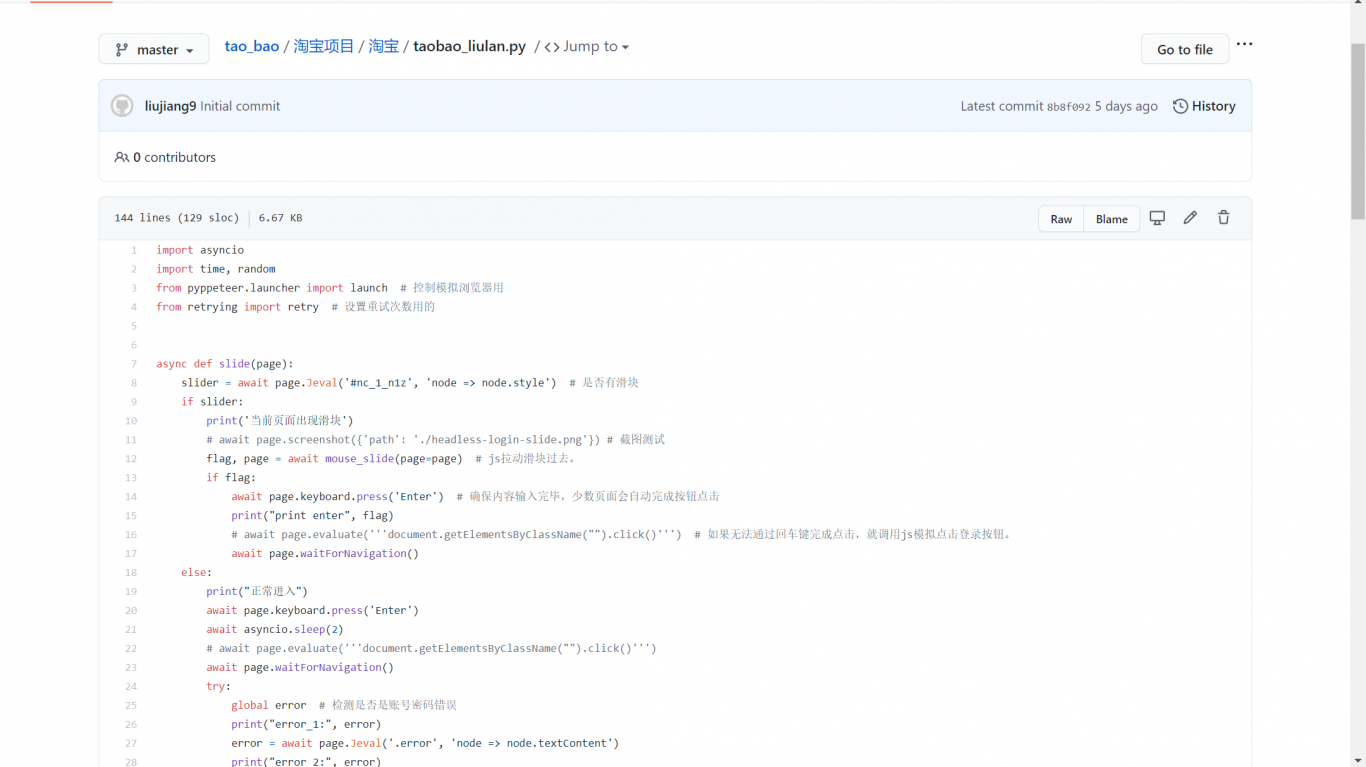

项目名称:淘宝网,京东商城、amazon等大型网站商品信息采集

项目描述:采集各大商城各类女士化妆品商品信息,为某化妆品公司提供热销产品信息

术架构:scrapy-redis+pyppeteer+json+fiddler+lxml+mongodb+Gerapy+liunx

项目职责:

1.使用Scrapy-Redis分布式框架创建pyppeteer中间件爬取目标网。

2.使用pyppeteer构建模拟人工处理验证码及登录中间件异步获取商品数据信息。

3.使用fiddler创建一个fiddler自动保存的脚本保存json文件。

4.使用正则表达式提取完整的json字符串。

5.将获取到的json字符串进行解析处理。

6.使用mongodb储存处理后的数据。

7.项目期间日常的爬虫管理维护。

开发遇到的问题及解决方案:

1.在浏览过程中发现商品信息是ajax异步请求加载的数据;

解决方案:使用自动化测试工具模拟浏览商品信息请求加载

2.在模拟操作时先使用的是selenium模拟登陆,在滑块验证时selenium被淘宝检测到在滑动结束后一直提示网络错误重新加载;

解决方案:跟换了自动测试工具后即可完成操作

项目名称:大众点评商家评分及用户评论信息采集

项目描述:采集大众点评网站关于湘菜地理位置及商家评分,评论信息,为某连锁店提供最新行情信息

技术架构:Scrapy-Redis+lxml+High-Logic FontCreator+mongodb+Gerapy+liunx

项目职责:

1.使用Scrapy-Redis分布式框架爬取目标网页信息。

2.破解文字加密

3.使用xpath提取结构与非结构数据。

4.使用numpy对数据进行清洗

5.使用mongodb储存处理后的数据。

6.项目期间日常的爬虫管理维护。

开发遇到的问题及解决方案:

1.在浏览过程中发现评论信息及商户评分是加密的;

解决方案:

1.分析文字来源寻找规律

2.下载对应文字库文件

3.商户评分文字破解:使用High-Logic FontCreator打开woff文件,分析该文件找到对应文字的16进制编码与网页中的格式一致,找到对应的文字生成对应的字典,再将原文中评分进行互换。

4.客户评价文字加密:下载对应的css文件,根据规律计算原文字在文字库中的坐标,再用原文加密字符与对应文字生成字典,在对原文进行替换。

项目名称:拼多多,唯品会,淘宝等APP信息采集

项目描述:采集各个APP有关于女士服装的店铺信息及商品信息、销量等,为某电商平台提供数据

技术架构:scrapy-redis+mitm+appium+fiddler+redis+hadoop+Gerapy+liunx

项目职责:

1.使用mitm+appium+fiddler获取目标信息url链接

2.拿到目标url后,采用scrapy-redis库进行请求连接获取对应的数据

3.使用json语法提取对应的信息

4.使用numpy对数据进行清洗

5.使用hadoop储存处理后的数据。

6.项目期间日常的爬虫管理维护。

开发遇到的问题及解决方案:

1.在使用fiddler链接app发现商品信息异步加载的数据,

解决方案:使用appium模拟人工浏览加载数据

2.在使用fiddler分析数据api时,发现商品信息是以json文件加载的对应的api在浏览器上无法直接请求

解决方案:使用mitm抓包工具抓取对应的api,使用mitm脚本获取保存对应的json文件

项目名称:链家、房天下、等房屋租赁网站信息采集

项目描述:采集各个网站个人房源信息,为某房屋中介公司提供数据

技术架构:scrapy-redis+redis+mongodb+Gerapy+liunx

项目职责:

1.分析网页页面结构,

2.获取目标url,储存在redis队列中

3.使用scrapy-redis从队列中拿去url请求获取数据

4.使用xpath提取对应的数据

5.使用numpy对数据进行清洗

6.使用mongodb储存处理后的数据。

7.项目期间日常的爬虫管理维护。

案例展示

-

淘宝关键字销量采集表

模拟人工登陆淘宝网在商品搜索栏搜索对应的关键字,使用爬虫获取该关键商品销量信息,通过销量判别该关键字的利用价值

-

大众点评评论获取

通过爬虫获取大众点评商家店铺评分,以及各类热销菜品名称单价,及店铺的店铺地址,评论信息等,通过分析该数据来确定是否符合分店店铺设立

相似人才推荐

-

500元/天图像算法工程师深圳市泽宝电子商务股份有限公司概要:灵活使用python,熟悉js和jQuery解析,熟悉网络请求,代码风格良好; 擅长爬虫技术:

-

500元/天后端开发工程师征宙概要:熟练应用JAVA应用服务器进行Java软件开发:如Tomcat 7.0等 熟练使用Struts2,

500元/天后端开发工程师征宙概要:熟练应用JAVA应用服务器进行Java软件开发:如Tomcat 7.0等 熟练使用Struts2, -

1500元/天影像效果工程师oppo广东移动通信有限公司概要:能力范畴: 主要从事高通、MTK相机ISP效果优化,对3A算法也有了解,对相机效果开发流程比较熟悉

-

1000元/天视觉算法工程师海康威视概要:五年图像处理经验,擅长机器学习,深度学习方法实现算法需求。 涉及领域包括但不限于:图像分类,目标检

-

500元/天wuwy概要:擅长C++语言,熟悉LINUX常用命令,利用C++完成项目有学生通讯录管理系统,企业职工管理系统,机

-

500元/天工艺员金鹏筑工集团概要:会用微软办公软件 ,Excel丶Word丶PDF,有较强分析能力,积极认真,细心负责拥有各种办公软件

-

500元/天Data WarehouseLenovo概要:Database, SQL Server, ETL ELT, Kettle, Data Wareho

500元/天Data WarehouseLenovo概要:Database, SQL Server, ETL ELT, Kettle, Data Wareho -

1000元/天123123概要:AI人工智能AI人工智能AI人工智能AI人工智能AI人工智能AI人工智能AI人工智能AI人工智能AI