Little cookie

爬虫工程师

- 公司信息:

- 深圳市杨翔文化传媒有限公司

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 所在区域:

- 广州

- 荔湾

技术能力

1. 熟悉 Windows,Linux 操作系统及掌握常用命令能在 Ubuntu,Windows 系统下完成开发

2. 了解 HTTP/HTTPS 协议,TCP/UTP 等网络通信协议

3. 熟练 使用多线程,多进程,进程池

4. 了解 html,css 前端页面结构

5. 熟练 使用 scrapy 框架,增量式爬虫,分布式爬虫

6. 熟练 使用 re、xpath、BeautifulSoup、json 数据提取

7. 熟练 掌握常见的反爬虫及应对措施

8. 熟练 使用 selenium 自动化工具

9. 熟悉 Fiddler 抓包工具

10.熟练 使用云打码

11.了解 Tesseract 机器图片识别

12.熟悉 MySQL 数据库,了解 Mongodb,Redis 相关操作

13.熟悉 Python 语言

项目经验

项目名称 1:唯品会商品信息爬取

项目使用技术:

pycharm + scrapy + redis + mysql + csv

开发工具: python3.7 + pycharm 开发环境: Windows10

项目详细描述:

1.通过抓包获取到所对应的商品 AIP 接口,经过分析测试可以通过修改搜索关键字请求 url 来获取相应的

页数,再通过页数去批量生成 url 去请求。

2.通过多次测试,请求头需要加上 referer 参数,否则无法获取响应。

3.需要设置爬取的频率降低网页重定向的几率,可以通过 response 对象中的 url、status_code 两个属性

来判断,解决:得到跳转前的页面源码,从中提取出重定向 url 信息。

4.通过对商品 url 的 MD5 指纹加密,再去判断 redis 里是否存在该 url 的指纹,不存在则添加到 redis

里。

5.使用 json 提取商品的商品名称、商品价格、商品优惠、商品规格、商品样式、商品详细图片、商品详细

概述、商品用户好评度等字段,在数据提取的过程中需要判断是否有值,比如商品的优惠,如果没有则赋值为

None。

6.按字段存储数据到 mysql,为了减少磁盘的操作从以前的 execute 单条数据存储,优化到

executemany 多条数据批量存储。

项目名称 2:京东商品信息以及评论的爬取

项目使用技术:

pycharm + scrapy + redis + mysql + csv

开发工具: python3.7 + pycharm 开发环境: Windows10

项目详细描述:

1.搜索关键字修改 url 来获取响应,经过多次测试可以修改 url 的 page 参数来解决京东 Ajax 加载商品的

问题。

2.使用 xpath 提取每页的商品 url。

3.url 去重:使用 MD5 指纹加密,再去判断 redis 里是否存在该 url 的指纹,不存在则添加到 redis 里。

4.使用 re 提取商品的名称、商品编号、产地(国家)、品牌、价格、好评度、规格包装等字段,其中商品

价格和评价是加载了其他接口需要抓包获取接口。

5.找到评论接口通过商品的 id 去爬取评论,需要注意频率问题,否则无法获取相应。

6.检测 User-Agent:使用 fake-useragent 第三方库随机生成 User-Agent。

7.检测 IP:使用芝麻代理。

8.按字段存储数据到 mysql,为了减少磁盘的操作从以前的 execute 单条数据存储,优化到

executemany 多条数据批量存储。

项目名称 3:SHOPEE

项目使用技术:

pycharm + requests + redis + mysql + csv

开发工具: python3.7 + pycharm 开发环境: Windows10

项目详细描述:

1.通过浏览器抓包找到商品的 API,配合 requests 模块请求数据,通过 json 匹配数据 name、

shopid、itemid 参数拼接获取二级页面 url,三个参数必不可少。

2.将二级页面的 itemid 参数生成 MD5 的指纹存储到 redis 数据库中,再去判断 redis 是否存在指

纹,不存在则添加,完成商品的去重。

3.通过 shopid、itemid 参数拼接评论 API 批量获取评论数据存储 csv 文件中。

4.通过 shopid、itemid 参数拼接评论 API 获取商品的信息,由于业务的需求,需要获取到的价格做

一个汇率的转换。

5.使用 fake-useragent 第三方库随机生成 User-Agent。

6.使用芝麻代理随机更换 ip 和设置请求频率来降低封 ip 和网页重定向的反爬。

7.按字段存储数据到 mysql,减少磁盘的操作使用 executemany 完成多条数据批量存储。

项目名称 4:零购 APP

项目使用技术:

pycharm + requests + redis + mysql + csv + fiddler

开发工具: python3.7 + pycharm 开发环境: Windows10

项目详细描述:

1.使用 fiddler 抓包从主页加载的数据中获取到 APP 搜索接口结合 requests 模块对 url 进行请求,拿到响

应的页数,再批量生成 url 进行多线程爬取。

2.使用 json 模块提取商品的名称、图片、折扣、价格、样式、店铺信息等字段。

3.爬取频率:设置每个页面抓取时间间隔,降低被封概率。

4.检测 IP:使用芝麻代理,随机

案例展示

-

个人博客

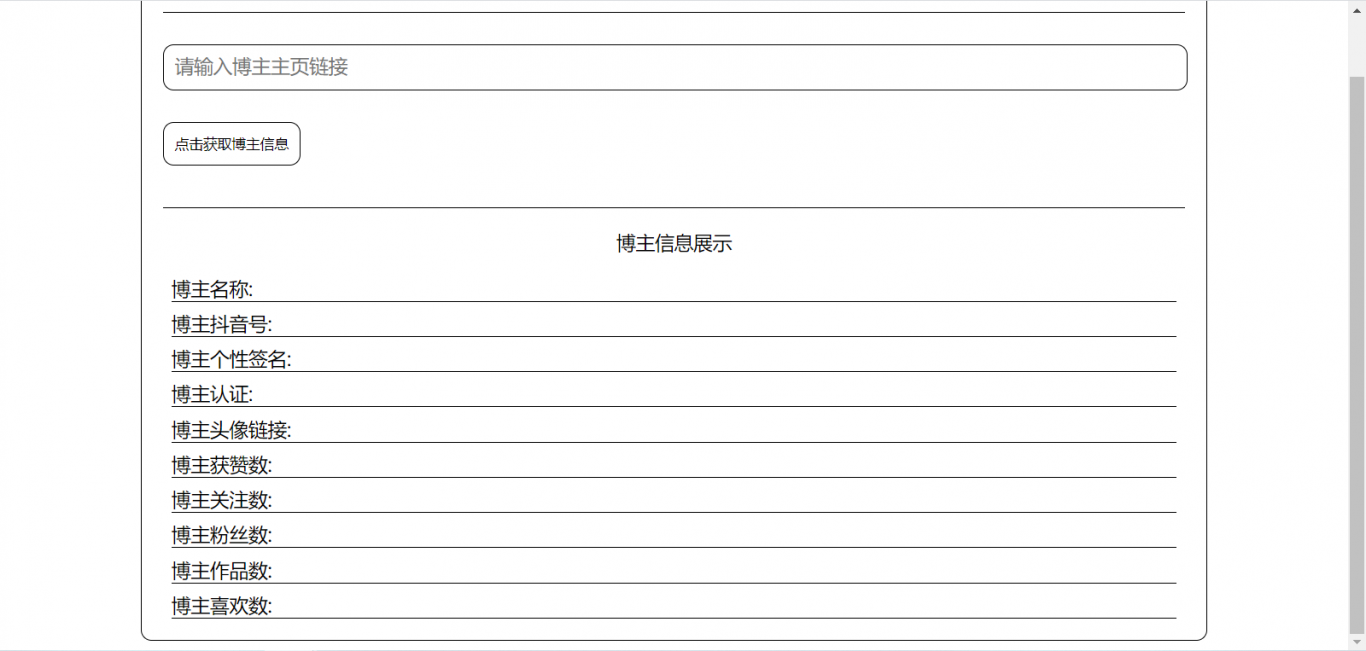

基于抖音APP的抖音博主信息爬取,速度快, 查询以下信息 博主名称 博主抖音号 博主个性签名 博主认证 博主头像链接 博主获赞数 博主关注数 博主粉丝数 博主作品数 博主喜欢数

-

网易云音乐

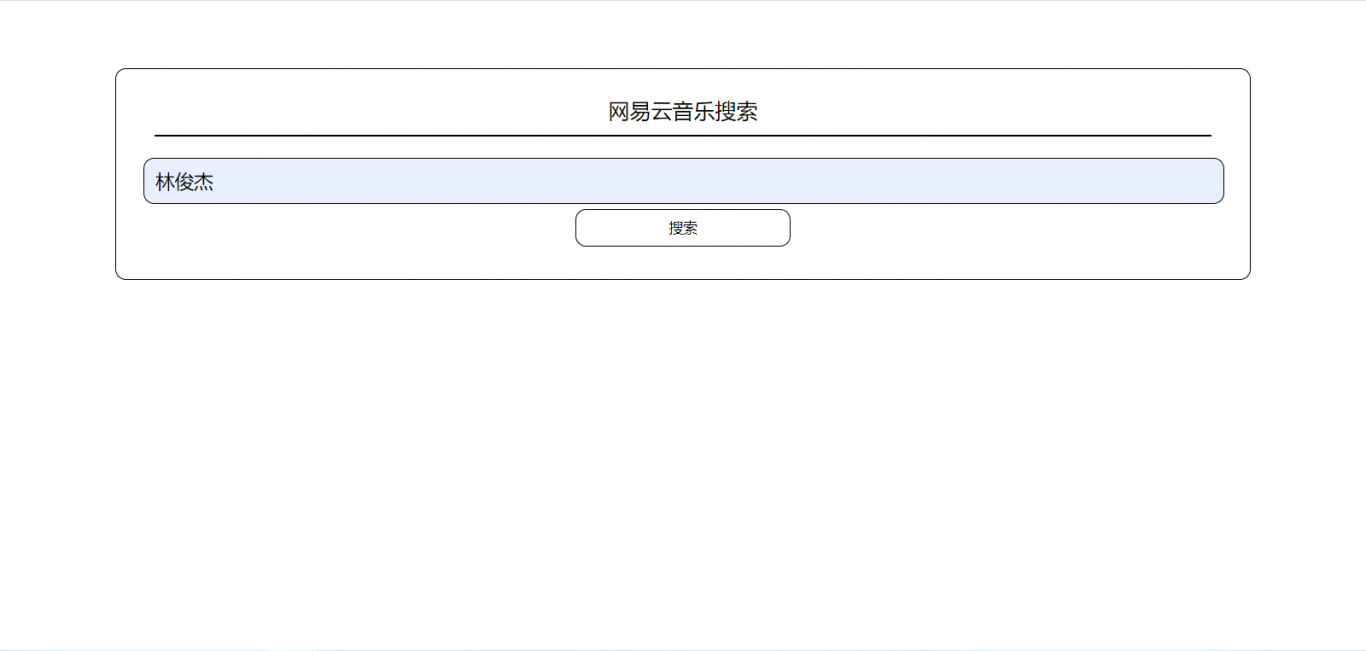

基于网易云音乐的破解,可听VIP音乐歌曲,通过js逆向来破解网易云的歌曲的获取,每页有三十条数据,可下载

相似人才推荐

-

800元/天高级全栈开发工程师博彦科技概要:全栈工程师,10年开发经验 Golang: 熟练 Java, Kotlin: 熟练 Pytho

-

1500元/天架构师&技术合伙人北京智慧基石科技有限公司概要:本人是2013年南京大学本科毕业,2016年北京大学研究生毕业。开过三个科技公司,目前作为技术合伙人

-

600元/天高级软件工程师深圳力堃科技有限公司概要:1.熟练掌握Linux系统,shell窗口中vi编程 2.熟练vs,vc软件的操作 3.对erp

-

800元/天云计算研发工程师华为概要:本硕985 CS; 熟练各种计算机技术,如:Java、Python、H5、JavaScript、T

-

500元/天自由人暂无概要:主要是python语言,个人能力:MySQL数据库使用,socket,多线程,多进程的实现,;还熟练

-

800元/天高级系统架构师中兴通讯概要:毕业于湖北大学计算机系,在校期间专业成绩优秀,获得一等奖学金。曾参加 ACM 并获奖。毕业论文获得优

-

1000元/天项目经理中兴通讯股份有限公司概要:1、5年以上上市公司架构师和项目管理经验; 2、有大型高并发项目和分布式服务项目实际经验;开发过的

-

500元/天后端研发工程师中国科学院空天信息研究院概要:1.熟练掌握C++,C#、python后端技术 。 2.熟练掌握springboot java技术