宇空星雨

python工程师

- 公司信息:

- 深圳普云信息技术有限公司

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 可工作日驻场(自由职业原因)

- 所在区域:

- 北京

- 海淀

技术能力

1. 熟练掌握python语法,包括多线程、多进程、多协程及面向对象的设计思想,常用模块,装饰器的使用,正则等;

2. 熟悉常见设计模式;

3. 熟练掌握HTML、CSS、JS、JQuery等前端技术;

4. 熟练掌握MySQL的增删改查,原生SQL语句的使用,Linux环境下及python环境下对MySQL的操作,事务的控制及MySQL的优化;

5. 熟练使用Django进行开发,理解MTV设计思想,熟悉Ajax的使用,中间件的使用,缓存等;

6. 熟练掌握Nginx做负载均衡来处理高并发;

7. 熟练掌握Redis的5种基本类型及两种持久化机制RDB和AOF,Redis的使用,Redis集群搭建;

8. 熟悉网络编程,熟悉HTTP协议、TCP/IP协议、UDP协议等,熟悉基于TCP/IP协议和UDP协议的socket编程原理;

9. 熟悉RabbitMQ的原理及使用。

10. 熟练掌握Linux系统的常用操作;

11. 熟悉Git原理及常用操作,gitflow工作流;

12. 熟练掌握requests,scrapy等框架进行网络爬虫,熟练使用多线程进行爬取,并熟练掌握Scrapy各组件作用以及运行流程;

13. 熟练掌握分布式爬虫scrapy-redis的搭建与基本使用;

14. 研读过requests,scrapy部分源码,并参与过分布式爬虫的设计;

15. 熟练掌握常见的反爬机制及破解技术,如滑块验证码,动态cookie,自定义字体等;

16. 熟悉asyncio,基于aiohttp框架开发并封装异步爬虫框架;

17. 熟练掌握HDFS的搭建与维护,以及yarn集群进行资源调度的原理;

18. 熟练掌握常用hadoop生态圈技术,如使用HIVE做数据清洗,使用sqoop将HDFS/HIVE中的数据导入/导出到MySQL等;

19. 熟练掌握HBase集群的搭建与使用zookeeper做高可用集群;

20. 熟练掌握数据结构及算法,包括链表、栈、队列、哈希表、二叉树、图等,以及各种排序和查找算法;

21. 熟悉pandas,numpy,matplotlib等工具做数据清洗、可视化与分析;

22. 熟练掌握常见机器学习算法,如KNN,线性回归,逻辑回归,朴素贝叶斯,SVM,决策树,随机森林等监督学习算法,K-means

项目经验

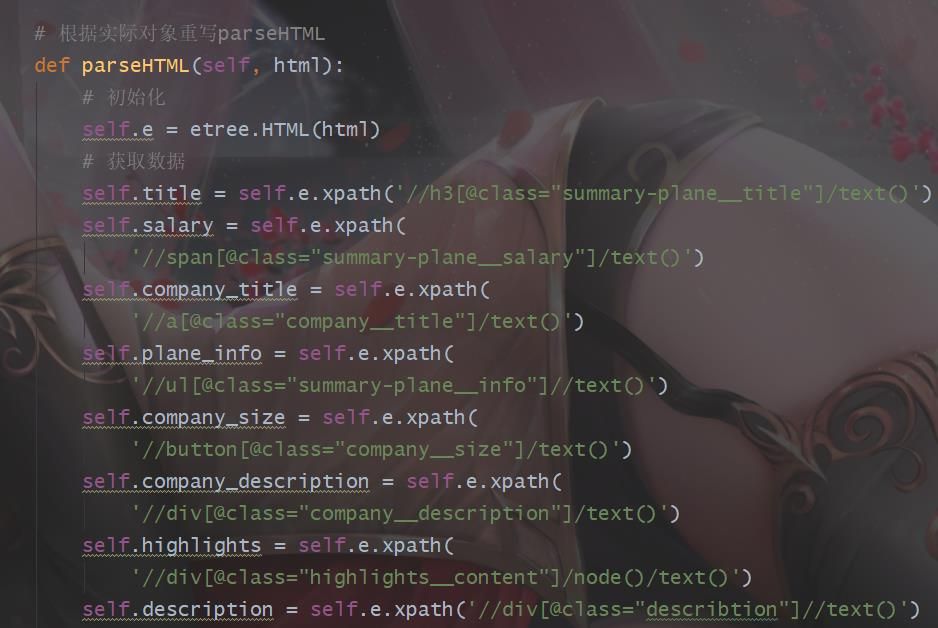

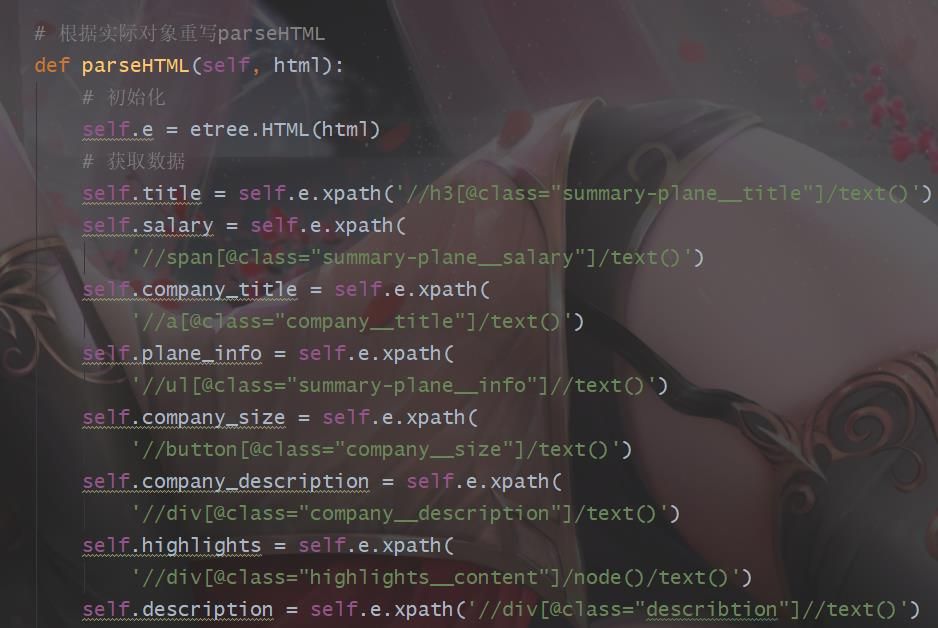

优民招聘App后台系统(2018.12-2020.01)

开发环境:python+pycharm+Linux

软件技术:Django,Redis,pandas,numpy,pywin32,HBase,Hive,sqoop,sklearn

项目职责:记录用户日志,布置反爬,对离线数据进行清洗,分析用户日志,对用户做分类,据此做推荐系统。

技术描述:1. 使用Redis记录用户日志,并转存到HBase中;

2.通过装饰器布置UA检测和用户行为检测(使用Redis存储IP封禁状态);

3.使用pywin32清洗Word离线数据(约25GB),使用pandas清洗Excel离线数据(约10GB),分析获取数据做进一步使用;

4.使用Hive做用户日志清洗,使用sqoop将清洗数据转存到MySQL中,使用pyecharts做PV,UV,运营指标的展示,并对日志做关联性分析;

5.使用用户简历及日志数据,对用户做分类;

6.使用协同过滤算法(基于岗位)推荐公司招聘信息给用户。

个人简历和企业数据采集及处理(2017.08-2018.11)

开发环境:python+pycharm+Linux

软件技术:Scrapy,Scrapy_Redis,Requests,MySQL,Redis,HDFS,HBase,Hive,sqoop,pyecharts

项目职责:对智联、58、51、大街网、万行教师、中国商标网、BOSS直聘、招聘狗等各大招聘网站和企业数据网站进行个人简历与企业数据的爬取,爬取数据量约14亿,并对部分数据做清洗,生成报表。

技术描述:1.使用Scrapy框架进行数据的爬取;

2.参与分布式爬虫框架设计,搭建Scrapy_Redis提高爬取的效率;

3.对部分网站仍采用了Requests进行爬取,后基于aiohttp做了异步爬虫框架的封装,提高爬取效率;

4.中国商标网企业数据爬取遇到JS加密的反爬,通过不断分析网站,以数据为导向,最终找到绕过JS加密反爬手段的接口,获取到需要的数据;

5.大街网会动态更换登录的cookie信息,通过发送搜索页来获取新的cookies信息,再携带着新的cookies重新获取数据;

6.在爬取大量数据后,MySQL查询效率明显变慢,后采用大数据技术,搭建HBase集群(并使用zookeeper做高可用集群),将爬取到的数据存放到HBase中;

7.搭建Hadoop环境, 使用Hive将爬取到的数据做清洗,使用sqoop将清洗后的数据放入MySQL中,用于后续使用(如用pyecharts做了数据可视化等)。

社交类网站用户数据采集(2016.11-2017.07)

开发环境:python+pycharm

软件技术:Requests,多线程,MySQL

项目职责:对人人网、百合网、世纪佳缘、微博等社交类网站的用户数据进行采集,主要使用的是requests并结合多线程进行爬取,数据量累计约6000万。

技术描述:1.通过一个用户的数据,获取与之相关联的其他用户的数据;

2.通过UA池,模拟成不同的浏览器,获取用户数据,通过封装IP代理池并维护,在出现IP封禁的情况下使用可用IP进行爬取;

3.在出现强制输入验证码的反爬时,常通过打码平台(超级鹰)进行破解;

4.爬取到的数据存储在MySQL中。

书来书往App用户信息管理系统(2016.06-2016.10)

开发环境:python+pycharm+Linux

软件技术:Django,Ajax,JS,JQuery,Redis,MySQL

项目职责:主要使用Django设计用户模块,购物车模块,统计用户数据(包括订单和配货地址)。

技术描述:1.设计用户登录注册模块,使用Ajax和JS(JQuery)技术进行表单内容提交和动态内容显示,使用MySQL存储用户数据,使用MD5和随机盐对用户密码进行加密,使用邮箱验证用户的真实性;

2.使用面向对象的思想封装设计购物车,使用JS操作前端页面,更好实现动态价格显示,使用Redis存储临时购物车数据;

3. 使用MySQL存储用户订单和配货地址。

案例展示

-

社交类网站用户数据采集

对人人网、百合网、世纪佳缘、微博等社交类网站的用户数据进行采集,主要使用的是requests并结合多线程进行爬取,数据量累计约6000万。 技术描述:1.通过一个用户的数据,获取与之相关联的其他用户的数据; 2.通过UA池,模拟成不同的浏览器,获取用户数据,通过封装IP代理池

-

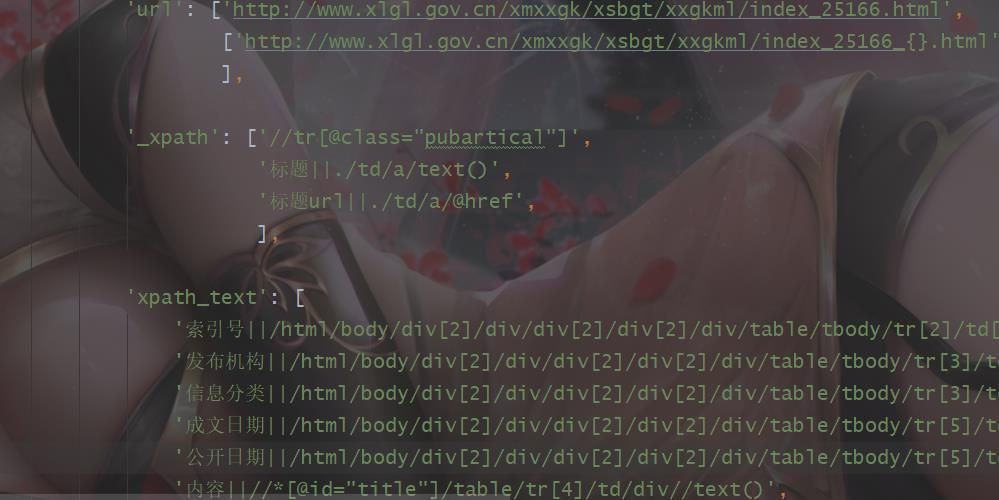

政府网站数据爬取

对智联、58、51、大街网、万行教师、中国商标网、BOSS直聘、招聘狗等各大招聘网站和企业数据网站进行个人简历与企业数据的爬取,爬取数据量约14亿,并对部分数据做清洗,生成报表。 技术描述:1.使用Scrapy框架进行数据的爬取; 2.参与分布式爬虫框架设计,搭建Scrapy

-

爬取各类网站

使用Redis记录用户日志,并转存到HBase中; 2.通过装饰器布置UA检测和用户行为检测(使用Redis存储IP封禁状态); 3.使用pywin32清洗Word离线数据(约25GB),使用pandas清洗Excel离线数据(约10GB),分析获取数据做进一步使用; 4.

相似人才推荐

-

500元/天Python某科技概要:Python爬虫:熟练使用requests,多线程并发,js逆向分析,asyncio异步协程使用,

-

600元/天Python高级开发工程师东软集团(大连)有限公司概要:熟练 Python、PyQt、C 等编程语言,能够进行 bug 处理和开发 熟悉 H5、C3、J

-

500元/天Python软件开发工程师东软集团概要:1. 熟练掌握Python,熟悉Java、JavaScript、C等编程语言。 2. 熟练掌握Dj

-

800元/天python工程师花旗银行概要:熟悉Python、C#、Typescript 语言 熟悉常用的机器学习和深度学习模型,如LR、

-

600元/天Python开发工程师中国移动概要:1、熟练掌握python语言,有5年python开发经验。 2、熟练掌握常用数据结构和算法。 3

-

500元/天pythonWeb无概要:毕业于周口职业技术学院云时代校企合作,专业python,熟练运用office办公软件、python、

-

600元/天python后端开发创新奇智, 华为概要:目前为自由职业,4年全栈开发经验,拥有多个产品0-1研发并成功上线运营经历,涉及零售、金融、安防、机

-

600元/天python 算法工程师中航信概要:南开大学数学系毕业,理论基础扎实,思维活跃。 英语托福97分, pandas数据分析, pyt