HzrisZHAO

后端研发

- 公司信息:

- 百度

- 工作经验:

- 3年

- 兼职日薪:

- 800元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 山东

- 全区

技术能力

一、大数据采集大数据采集,即对各种来源的结构化和非结构化海量数据,所进行的采集。数据库采集:流行的有Sqoop和ETL,传统的关系型数据库MySQL和Oracle 也依然充当着许多企业的数据存储方式。当然了,目前对于开源的Kettle和Talend本身,也集成了大数据集成内容,可实现hdfs,hbase和主流Nosq数据库之间的数据同步和集成。网络数据采集:一种借助网络爬虫或网站公开API,从网页获取非结构化或半结构化数据,并将其统一结构化为本地数据的数据采集方式。文件采集:包括实时文件采集和处理技术flume、基于ELK的日志采集和增量采集等等。二、大数据预处理大数据预处理,指的是在进行数据分析之前,先对采集到的原始数据所进行的诸如“清洗、填补、平滑、合并、规格化、一致性检验”等一系列操作,旨在提高数据质量,为后期分析工作奠定基础。数据预处理主要包括四个部分:数据清理、数据集成、数据转换、数据规约。数据清理:指利用ETL等清洗工具,对有遗漏数据(缺少感兴趣的属性)、噪音数据(数据中存在着错误、或偏离期望值的数据)、不一致数据进行处理。数据集成:是指将不同数据源中的数据,合并存放到统一数据库的,存储方法,着重解决三个问题:模式匹配、数据冗余、数据值冲突检测与处理。数据转换:是指对所抽取出来的数据中存在的不一致,进行处理的过程。它同时包含了数据清洗的工作,即根据业务规则对异常数据进行清洗,以保证后续分析结果准确性。数据规约:是指在最大限度保持数据原貌的基础上,最大限度精简数据量,以得到较小数据集的操作,包括:数据方聚集、维规约、数据压缩、数值规约、概念分层等。

web框架

这个是最直接的,一门语言要成为web后台语言,首先要有处理web后台相关的库,然后在一些巨人的封装下,形成web框架。python目前热门的web框架有:Django、tornado、flask,web.py,web2.py等。我自己接触过,web.py、tornado。

restfull

目前后台组织代码比较火的规范之一。

pep8

目前python代码编码规范之一

web server

webserver为网上信息浏览服务,对后台来说,生产环境往往会涉及这部分的内容。所以常见的webserver的配置,优化。是必修的功课之一。而且目前webserver往往作为软件

项目经验

项目时间:2017-01到2011-10

项目名称:引物自动化设计软件

项目描述:

项目介绍

这个软dao件开发原因是因为随着每日数据分析量的加大,组内人员较少,对引物设计这种工作变成了工作效率的阻碍,遂提出了设计软件以达到自动化设计的目的。而且引物设计主要费时在于多种验证操作,可以通过软件自动验证减少人力成本。

我的职责

1,软件基础功能设计,完成相关函数如自连互连验证,温度验证等功能

2,分析NCBI网页格式,设计API调用接口

3,编写测试脚本对软件进行测试

项目时间:2018-12到2019-10

项目名称:政务大数据平台解决方案

项目描述:

项目介绍

政务大数据平台解决方案——推行电子zhengwu、建设智慧城市等为抓手,以数据集中和共享为途径,推动技术融合、业务融合、数据融合,打通信息壁垒,形成覆盖全国、统筹利用、统一接入的数据共享大平台,构建全国信息资源共享体系,实现跨层级、跨地域、跨系统、跨部门、跨业务的协同管理和服务。

我的职责

1,ETL设计及实现

2,python接口进行hive pandas等手段进行数据分析

3,设计批处理流程和增量处理流程

案例展示

-

农业知识图谱

农业知识图谱是融合了农业地域性,季节性,多样性等特征后,利用农业领域的实体概念与关系,挖掘出农业潜在价值的智能系统 应用场景: 通用 vs 领域/行业应用 从搜索延伸至推荐、问答等复杂任务 从简单关系发现到深层关系推理 从回答what问题到回答why问题

-

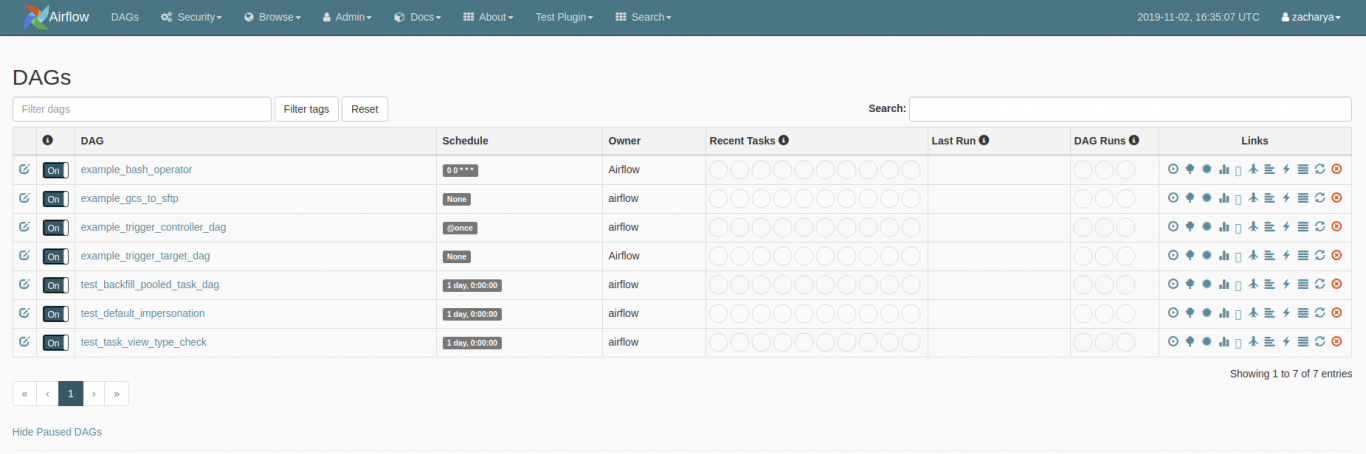

大数据工作流调度平台

大数据工作流调度平台是一个 Python功能 模块,可以构建复杂的批量作业管道。处理依赖决议、工作流管理、可视化展示等等,内建 Hadoop 支持。 大数据平台技术框架支持的开发语言多种多样,开发人员的背景差异也很大,这就产生出很多不同类型的程序(任务)运行在大数据平台之上

-

可视化大数据同步系统

可视化数据同步系统是在DataX之上开发的分布式数据同步工具,提供简单易用的操作界面,降低用户使用DataX的学习成本,缩短任务配置时间,避免配置过程中出错。用户可通过页面选择数据源即可创建数据同步任务,RDBMS数据源可批量创建数据同步任务,支持实时查看数据同步进度及日志并提供

相似人才推荐

-

500元/天技术主管筑牛网概要:1、掌握HTML,DIV,CSS,JS,JQuery,Bootstrap等基本web前端技术 2、

-

2000元/天技术顾问上海汉得概要:技术方面:SQL Server,JAVA,PL/SQL,Mysql,Windows,Linux,OR

-

1000元/天技术总监微世纪新媒体有限公司概要:java方面撑握spring、springboot、springcloud架构,mybatis、jp

-

1000元/天AI算法工程师深圳资福医疗技术有限公司概要: •AI算法,模式识别,神经网络, 嵌入式开发 ,图像处理算法 . 软件开发:熟悉L

-

500元/天软件工程师浪潮集团浪潮通软概要:1.熟练掌握C# WINFORM开发 熟悉SQL SERVER,ORACLE等数据库。熟练编写SQL

-

1000元/天技术总监大连执象科技有限公司概要:大连执象科技有限公司 专业的开发团队 市场团队:专业的,互联网从事行业经验丰富的销售团队 营销团

-

1000元/天高级工程师中电29所概要:熟悉掌握c#开发,数据库处理,熟悉单片机硬件开发,驱动开发,具有python,c++项目开发经验,研

-

500元/天软件工程师黑龙江运通科技有限公司概要:本人有三年多的Java后端的经验,掌握springboot,springcloud,mybatis,