浮云骑士

大数据开发工程师

- 公司信息:

- 伯图大数据管理有限公司

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 其他

- 全区

技术能力

1、熟练使用大数据相关的技术,CDH6.0.1大数据集群管理平台 、Spark2.2.0、Kafka2.2.0、debezium1.0.3、Hadoop3.0.0、hive2.1.1、hbase2.0.0、kylin2.1.0、oozie5.0.0、hue 4、sqoop1、OGG、elasticsearch7.2.0等。

2、熟练使用hive udf,spark udf。

3、熟练使用Java ,scala面向对象编程,良好地规范代码编写习惯。

4、熟练使用shell 脚本。

5、熟练运用 JUnit,Debug 进行程序调试。

6、熟练运用标准 SQL 语句,熟悉 Oracle、Mysql 数据库 。

7、熟练使用 Maven,Git,Sbt,IDEA等工具。

项目经验

1、事例1

项目名称:伯图数据-集团商业分析模块

项目时间:2017年12月1日~2018年6月26日

项目职责:参与伯图数据-商业模块,数据采集、清洗等Spark ETL工作。

项目成果:伯图数据-商业分析PC端和APP

项目使用技术:spark2.2.0、hbase2.0、hive2.1.1、kylin2.1.0、Java1.8、OGG、

scala2.11.8、shell脚本以及定时任务设置。

项目技术难点:

1.集团内各个子公司重叠客户合并与分类。

2.客户分析模块 cube查询速度延时大,针对cube相关参数进行优化。提升查询速度。

将查询速度控制在1s内。

项目介绍:伯图数据-集团商业分析模块,数据分析及ETL

1.销售模块-KPI分析

2.销售模块-客户分析

3.销售模块-产品分析

4.销售模块-竞品分析

5.库存模块-库存查询

6.库存模块-库存预警

7.库存模块-库存监控

1、事例2

项目名称:伯图数据-工业分析模块

项目时间:2018年5月8日~2018年9月20日

项目职责:独立负责数据实时采集和spark ETL

项目成果:伯图数据-工业分析模块PC端

项目使用技术:spark2.2.0、hbase2.0、hive2.1.1、kylin2.1.0、Java1.8、OGG

scala2.11.8、oozie5设置定时任务。

项目技术难点:

1.前端echarts图表展示需要显示补零数据,导致图表数据显示延时。

解决办法:在后台ETL对数据进行补零,用于填充前端图表框架。

2.工业分析模块,销售报表由于数据量大,sql查询26小时后才能生成报表。

解决办法:用spark 对数据进行处理,并将数据存储至 Kylin

3.OGG 在采集数据过程中由于数据量大,进程挂断。

解决办法:修改优化OGG内存使用,trandata由批量添加改为单独添加。

4.OGG 同步全库数据时,hbase每张表占用一个region。影响hbase读写性能。

解决办法:1减少业务表的数量,取核心业务表。2.使用hbase On hive 模式设置读写分离。

项目介绍:伯图数据-工业分析,主要对供应链销售和库存情况进行分析。

使用大数据技术对数据进行采取,分析,清洗,转换和展示。

Pc端主要包含以下功能:

1.月销售回款情况分析。

2.体制内和体制外各子公司回款情况分析。

3.各子公司月发货情况分析。

4.各子公司发货同期对比。

5.各子公司发货同期环比。

6.各个子公司每日发货统计。

7.销售回款月分析。

8.各子公司库存每日分析。

9.库存产品一年半效期分析。

10.各子公司产品近效期分析。

2、事例3

项目名称:伯图大数据-整体数仓

项目时间:2019年3月01日~2020年03月10日

项目职责:配合技术经理,负责整体数仓开发的进度控制与任务分配。

项目成果:统一的数仓,数据结构

项目使用技术:spark2.2.0、hbase2.0、hive2.1.1、kylin2.1.0、Java1.8、OGG、

scala2.11.8、shell脚本以及定时任务设置。

项目技术难点:

1.数据采集:各个子公司使用的系统平台未统一,使用的数据库和操作系统不同。数据库有mysql,oracle,sqlserver等。

2.各个公司的业务类型统一,以及数据结构的统一。

3.统一销售、采购和库存等业务流程,构建统一的数据模型。

4.存在个别公司,使用的sqlserver 表字段名为中文,无法使用hive On hbase 模式设置读写分离。

项目介绍:涉及7家药品销售商业公司和5家药品制造工业公司的异构数据整合。

将各个商业公司异构数据经过采集、分析、清洗。形成统一、规范化的数据结构。

统一数仓主要包含功能,销售流程、采购流程以及库存模块的数据规范统一。

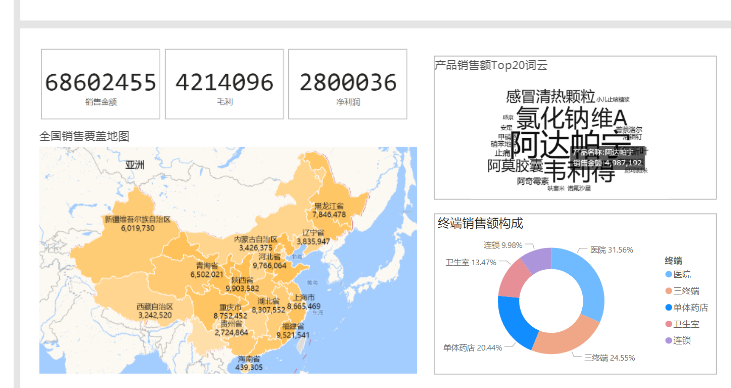

案例展示

-

数据分析平台

2、事例3 项目名称:伯图大数据-整体数仓 项目时间:2019年3月01日~2020年03月10日 项目职责:配合技术经理,负责整体数仓开发的进度控制与任务分配。 项目成果:统一的数仓,数据结构 项目使用技术:spark2.2.0、hbase2.0、hive2.1.1、

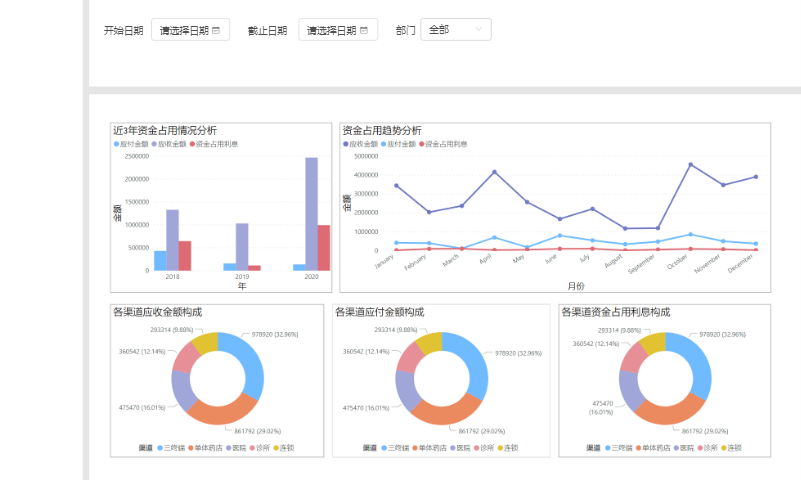

-

数据分析资金占用

1.实时采集关系型数据库,存储至hadoop. 2.使用spark 对数据进行ETL处理,完成后将数据存储在kylin 中. 给前端进行查询已经数据展示

相似人才推荐

-

500元/天项目经理、程序员三驱软件概要:本人自2000年开始从事软件开发,以企业管理软件开发为主,使用PowerBuilder+SQLSer

-

900元/天高级大数据开发工程师比亚迪概要:8年java开发经验,熟悉java, Go, Spring, Spring Cloud, MyBat

-

500元/天后端工程师大连华信计算机技术股份有限公司概要:本人了解JavaScript,Ajax,jQuery等前台开发技术;熟悉MySql,sql语句;掌握

-

500元/天研发工程师地球村概要:从事程序开发与定制工作多年,熟练掌握c#、python、c++、vba等编程语音,熟悉小程序,微信公

-

500元/天Qt工程师深圳市量旋科技概要:熟练运用C++及Qt技术,有多个软件系统从0到1的开发经验,熟练软件系统的开发流程,包括需求整理、u

-

1200元/天后端阿里巴巴、字节跳动概要:掌握多门语言:c/c++、rust、java、c#、python、js、haskell... 熟悉

-

500元/天后台开发工程师北京有竹居网络技术有限公司概要:1. 掌握基础的计算机知识,数据结构、计算机网络、操作系统等等 2. 熟悉Java后台开发的技术栈

-

500元/天中级开发工程师北京开科唯识技术有限公司概要:1、具有良好的编程习惯,三年的开发经验,一年的团队管理经验。 2、熟悉Hibernate、Spri