自由平等公正法治 有团队

python爬虫、vue前端

- 公司信息:

- 南京猜客电竞网络有限公司

- 工作经验:

- 2年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周日

- 所在区域:

- 南京

- 全区

技术能力

python爬虫类:

熟悉常见的爬虫、反爬虫如:js加密、js代码混淆,伪造请求头,使用代理,代理池等

掌握使用requests、urllib

掌握Python lxml、BeautifulSoup、re、json、xpath模块进行数据提取

熟悉XPath语法规则和各CSS Selector的使用

熟悉Selenium+PhantomJS实施动态HTML抓取

熟悉Scrapy框架,以及编写各类中间件

熟悉scrapy-redis分布式框架,了解各组件工作机制

熟练使用pycharm和jupyter,熟悉Finder抓包工具的使用

熟悉pandas和pyecharts的使用

熟悉fiddler抓包工具的使用,能够获取到动态生成的页面

熟悉八爪鱼、火车头爬虫工具的使用

熟悉appium爬取app的工具

前端:

vue、js、css

后端:

java、django

数据库:

redis、mysql、oracle

服务器:

熟悉Linux开发环境,熟练掌握常用命令行的使用

redis哨兵模式的搭建,服务的运行等

项目经验

项目一: 天眼查爬取

所用技术:selenium,requests,xpath

超级鹰处理验证码

使用MySql进行信息存放 。

项目描述:该项目是为公司需要抓取公司数据,然后对天眼查全部数据各种维度的采集和存储,

工作描述:

1. 使用selenuim打开一个网页,模拟登陆。获取cookie,并且处理cookie

2. 使用requests对网页进行信息采集。

3. 如果遇到验证码就使用selenuim对网页进行截图,处理验证码信息,返回给超级鹰打码平台进行处理验证码。

4. 然后对数据存入临时库,交由数据组其他成员清洗处理数据

项目二: 中国商标网爬取

所用技术:1.requests,execjs,xpath,多线程

2.mysql

项目描述: 该项目是公司需要商标公告数据,对中国商标网上的所有商标公告进行采集,为商标处理流程进行铺垫。

工作描述:

1. 该网站使用了js混淆cookie所以要对js进行解析

2. 请求该网页发现第一个js和执行会得到一段cookie第二个js,然后对返回的js进行处理解析然后执行会返回第二段cookie对返回的cookie进行拼接然后就可以正常post网站

3. 数据是存在一个给出的接口中,加上参数请求该接口会返回一个json,对数据进行采集

4. 将数据放入临时表,数据处理清洗后放入表中

项目三: 新浪微博爬取

所用技术:scrapy框架

Cookies池对接

代理池

工作描述:1.修改spider,配置各个Ajax的URL,选取几个大V ,将他们的ID赋值成一个列表,重写start_requests ( )方法,也就是依次抓取各个大V的个人详情页,然后用parse_user( )进行解析

2. 定义了collection 字段,指明保存的Collection的名称。用户的关注和粉丝列表直接定义为一个单独的UserRelationitem ,其中id 就是用户的ID, follows 就是用户关注列表, fans 是粉丝列表。提取数据接着提取数据,

3.解析用户信息,实现parse_user( )方法

4. 解析JSON 提取用户信息并生成UserItem返回,

构造用户的关注、粉丝、微博的第一页的链接,井生成Request ,这里需要的参数只有用户的ID 。另外,初始分页页码直接设置为‘1’即可。

5.接下来实现解析所发所有微博的方法 parse_weibos()

6. 解析JSON 提取微博信息并生成WeiboItem返回解析微博内容text的时候分三种情况:a.所发微博内容较长,微博内容中包含微博全文链接,如果有,进入到parse_all_text( )方法中获取全文;b.提取到的text内容为'转发微博',获取所转发微博的内容,如果所转发的内容含有全文链接,进入到parse_all_text( )方法中获取全文,否则直接获取;

7. 构造用户微博的下一页链接

接下来解析解析用户关注列表和粉丝列表,原理相同

8. 大概的思路就是以微博的几个大V为起始点,爬取他们各自用户信息、所发微博信息、他们各自的关注和粉丝列表。

如果想实现递归爬取,再获取关注和粉丝列表的用户信息、关注和粉丝列表,以此类推爬下去,只要把上面几行注释掉的加上即可

9.转化时间:有些微博的时间可能不是标准的时间,比如它可能显示为刚刚、几分钟前、几小时前、昨天等。

10. 数据清洗完毕之后,将数据保存到MongoDB数据库中

11. Cookies 池对接:Cookies 池见:Python3WebSpider/CookiesPool我自己使用时,有一些验证码识别困难,我屏蔽了验证码识别部分,添加了 点击登录后 等待10s时间,10s钟内自己手动点击验证码自己试验的时候添加了10个账号,如果添加大量账号,可以添加识别验证码平台,在Github上可以找到类似项目。(我用的时候把端口改为了API_PORT = 5005)

12. 添加了IP代理池

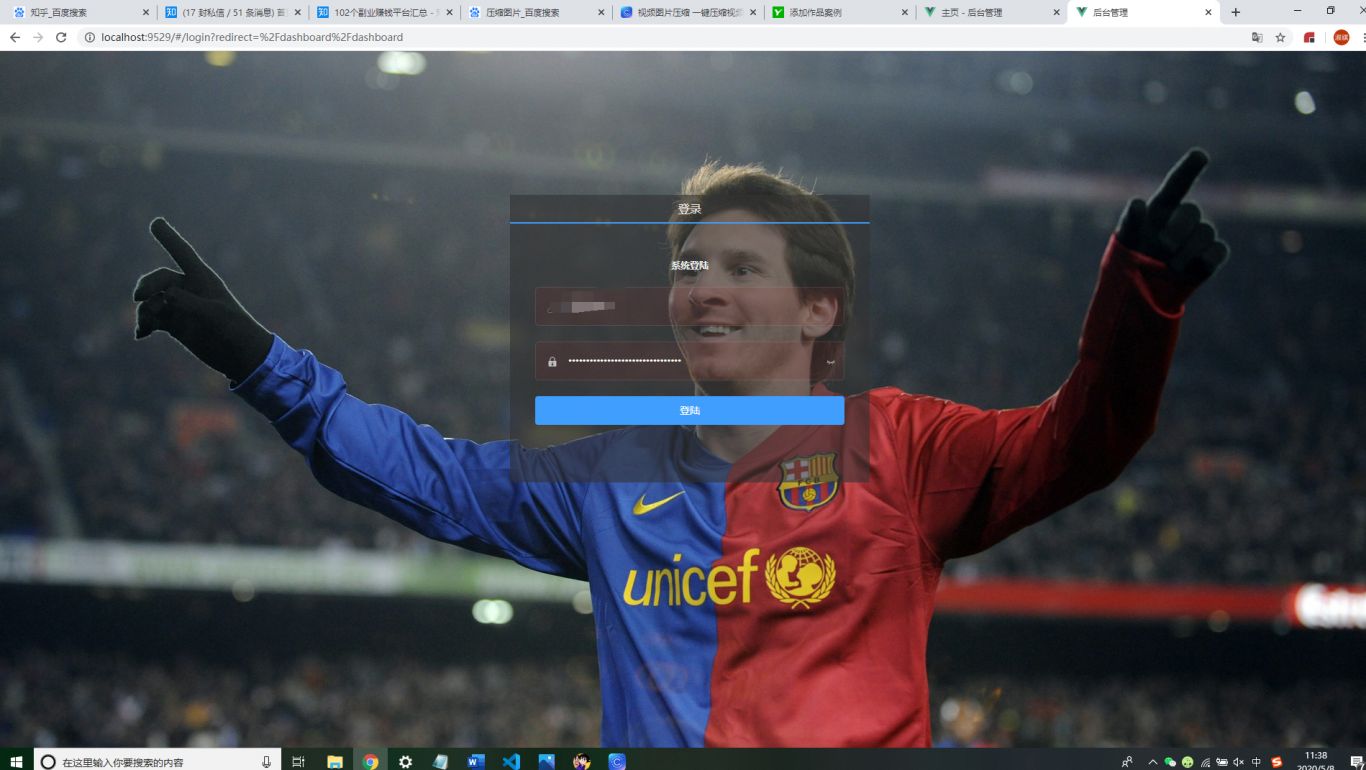

项目四:项目后台前端设计与实现

所用技术:vue,js,css

工作描述:负责后台操控接口的可视化,让员工操作更简单,高效,明了。

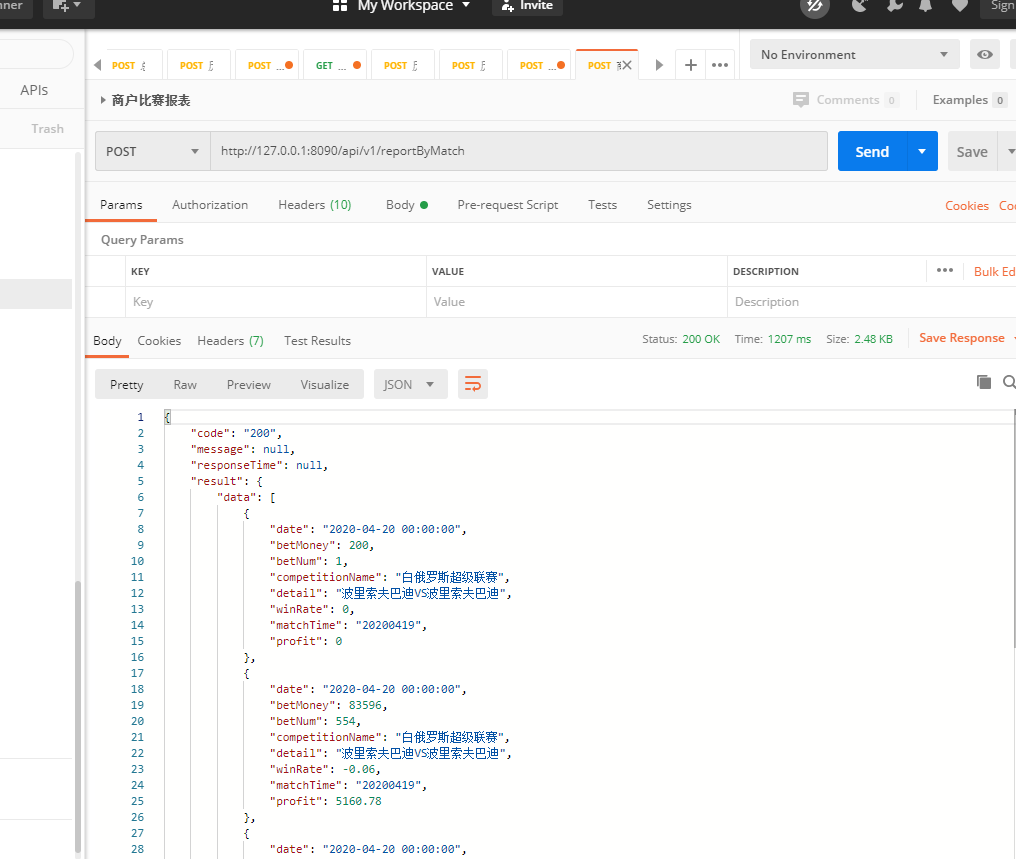

项目五:java后台的编写

所用技术:java、mysql、redis

工作描述:访问接口的实现、业务逻辑的编写。

团队情况

- 整包服务: PC网站开发 运维类开发 其他开发

| 角色 | 职位 |

| 负责人 | python爬虫、vue前端 |

| 队员 | 前端工程师 |

| 队员 | 后端工程师 |

案例展示

-

后台PC端页面开发

后台服务可视化,为员工提供更高效、简洁、直白且更准确的操作方式,大大减少了操作难度。 因为是公司内部项目,不太好描述

-

后台数据服务

可以获取历史数据,目前比赛数据以及未来比赛数据等各种功能,查看之前历史数据报表,分析球队之间综合实力。 我在作品中负责编写业务逻辑,测试等。

-

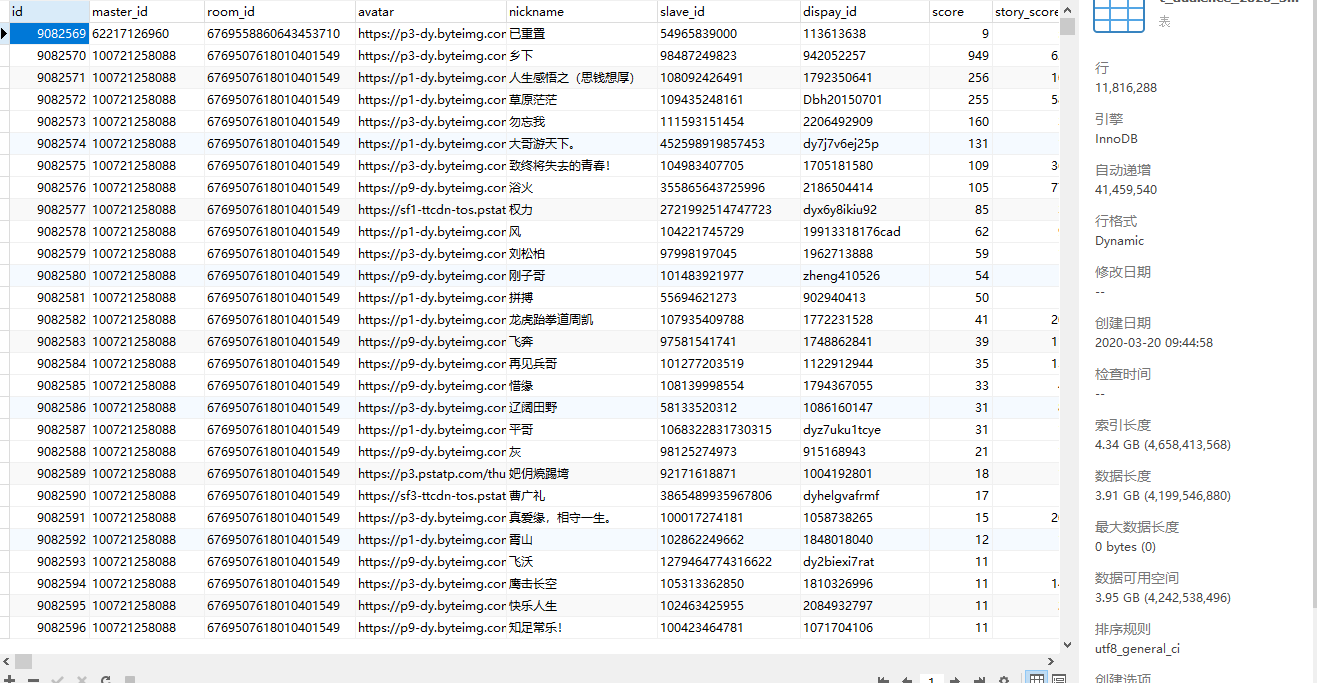

抖音主播数据爬取

公司需要大量数据,因爬取抖音等各种平台各种主播信息来进行各平台对比。 本人负责编写程序,爬取内容,清洗数据入库等等工作。

相似人才推荐

-

800元/天PHP+VUE全栈开发工程师成都优游信息技术有限公司、成都交投概要:本人可独立完成中小型项目开发和维护。责任心强,精益求精,善于沟通需求,评估实际的开发时间。后续的项目

-

800元/天UE4引擎工程师上海威墨信息科技有限公司概要:技能树: 1、 Unreal 蓝图系统 / 材质系统 / UMG / 后期处理 VXGI; 2、

-

600元/天java开发,vue前端开发上海卡梅拉科技有限公司概要:1.熟悉springboot + mybitsplus 框架, 2.前端精通vuejs ,el

-

600元/天IT项目经理 java vue中科软科技概要:备扎实的Java基础,深入理解OOP编程思想,具有良好的编码习惯 深刻理解JavaWEB技术体系架

-

600元/天全栈开发工厂师(java,vue)上海安硕概要:1、10年java项目开发经验,精通SSH SSM springboot,sping cloud通

-

500元/天web前端开发(Vue)上海华钦利宏金融信息科技有限公司概要:1、熟练掌握JavaScript、HTML/HTML5、CSS/CSS3; 2、熟练掌握Vue前端

-

800元/天PHP开发、vue开发四川牙易在线网络科技有限公司概要:个人从事软件开发有5年的工作经验、精通使用PHP语言开发后端。熟悉SQL语法、MySQL、Reids

-

500元/天UE4开发工程师/Unity3D开发工程师西安盘相科技有限公司概要:本人主要从事基于UE4,Unity3D引擎的软件开发工作,主要从事VR开发,Unity3D引擎的We