宅男拯救协会会长

python数据分析工程师

- 公司信息:

- 京东数字科技控股股份有限公司

- 工作经验:

- 3年

- 兼职日薪:

- 600元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 可工作日驻场(离职原因)

- 可工作日驻场(自由职业原因)

- 所在区域:

- 北京

- 海淀

技术能力

熟悉Pandas、Numpy、Matplotlib等数据分析常用库的功能,进行数据操作、采集、处理、清洗、可视化、规整数据集;

● 熟悉Random Forest、GradientBoosting、Logistic Regression、K-Nearest Neighbors、Naive Bayes、Linear Regression、Support Vector Machines 等机器学习算法应用;

● 熟悉常用数据结构算法;

● 熟悉NLP中Word Segmentation、Filtering Words、Representation、Sentence Similarity、Noisy Channel Model、Language Model等方法原理;

● 对数据有较强的敏感度;

● 熟悉集成学习算法的模型选择;

● 熟悉数据离散化操作;

● 熟悉特征工程;

● 理解TensorFlow深度学习框架的使用;

● 理解深度学习、神经网络;

● 熟悉Github操作;

● 理解Hadoop、Hive;

● 熟悉MySQL、MongoDB、Redis数据库的使用;

● 熟悉Python函数式编程;

● 熟悉Linux命令;

● 熟悉常见网站的反爬策略;

● 理解Scrapy爬虫框架;

● 熟练掌握Python OOP开发,编码遵守PEP8规范;

项目经验

项目一:对目标网站爬取分析生成报告

项目简介:利用Scrapy框架编写代码对一些特定网站的数据进行抓取,然后将获得的数据进行内容分析,得到可用的数据后生成情报报告。

项目职责:

1.从上级获取目标网站。

2.分析网站结构。

3.编写爬虫代码,将数据存在本地。

4.针对报告格式编写自动化生成报告程序。

项目二:对网站中的内容进行分类

项目简介:通过建立语言模型判断目标网站内容发布的信息是否有害,并将结果上报给相关部门。

项目职责:

1.利用爬虫搜集网站内容。

2.通过分词工具建立有害信息字典。

3.利用贝叶斯算法训练分类模型。

4.将结果输出并上报。

项目三:基于平台大学生用户行为分析绘制用户画像

项目简介:P2P借贷平台的兴起吸引了社会中各个层次人群加入其中,对于用户群体分析发现许多年轻大学生活跃程度很高。为了分析大学生在目标客户平台借贷的行为特征,对大学生借贷、投资和生活行为制作用户画像。

项目职责:

1. 提取用户信用信息,定位目标用户。

2. 分析提取用户强相关信息,忽略弱相关信息。

3. 根据用户信息为目标用户打标签。

案例展示

-

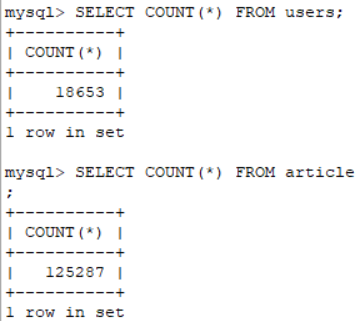

简书用户爬虫

通过爬虫实现一个提取简书网用户数据的程序,实现从简书网翻页提取包括关注用户数、粉丝数、文章数、字数、收获喜欢、简书钻、文章内容,将获取的数据存储到数据库中。然后运用NLP分析工具对用户文章进行分析使得给用户贴上标签,进而对简书用户进行分类。最后利用关键词标签生成词云,将每个用户的

-

机器学习对简书用户进行分析,生成用户画像

通过爬虫实现一个提取简书网用户数据的程序,实现从简书网翻页提取包括关注用户数、粉丝数、文章数、字数、收获喜欢、简书钻、文章内容,将获取的数据存储到数据库中。然后运用NLP分析工具对用户文章进行分析使得给用户贴上标签,进而对简书用户进行分类。最后利用关键词标签生成词云,将每个用户的

相似人才推荐

-

500元/天python大数据开发工程师着迷网概要:(1)两个大数据BI系统从设计到实现,分别为核心开发者和后端负责人。 (2)掌握Python/Dj

-

500元/天python武汉芯云道数据科技有限公司概要:目前专业从事国内外期货数据采集,数据分析处理,股票数据分析等;目前就职于武汉芯云道数据科技有限公司,

-

500元/天Android、Java、Python人工智能北京博创尚和科技有限公司概要:熟悉Android开发、熟悉java后台开发(springboot,springmvc,mybait

-

600元/天python全栈辰兴信息科技概要:湖南辰兴科技有限公司 全栈开发工程师 开发部 公公司主营业项目 负责内容: •手机模拟器银行

-

500元/天python开发工程师南京文交所概要:Python 基础扎实,有良好的编码习惯 熟悉基于Django开发以及ORM操作 熟悉MySQL

-

500元/天Python开发工程师顺丰科技有限公司概要:第三方支付项目实施、Linux运维、Oracle运维、Python后台开发。 技术栈:Pyth

-

500元/天python无概要:熟悉掌握python,会javase基础 ,找点儿兼职做。熟悉掌握python,会javase基础

-

500元/天测试工程师、自动化测试、前端、python工程师智芯原动科技有限公司 ICE TECH概要:技能:python,selenium,jmeter,pytest,vue 控制浏览器自动化操作、u