图灵

python工程师

- 公司信息:

- 无

- 工作经验:

- 1年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 可工作日驻场(离职原因)

- 可工作日驻场(自由职业原因)

- 所在区域:

- 深圳

- 龙岗

技术能力

掌握的技能:

1.Python中8种数据类型的精通使用

2.Python匿名函数、列表推导式、装饰器的熟练使用

3.Python中re、requests、beautifulSoup等库的熟练使用

4.Python爬虫框架Scrapy的熟练使用

5.Python爬虫伪装中代理IP、UserAgent的熟练使用

6.Python与scrapyt-redis分布式爬虫的基本使用

7.Python操作Mysql数据库增删改查

8.Python操作MongoDB数据库增删改查

9.Python建立数据库连接池提高效率

10.团队协作开发工具git的熟练使用

11.熟悉Linux日常工作环境,熟练掌握常用命令和调优监控手段

12.python机器学习库scikit-learn库的熟练使用

13.python科学计算库numpy、scipy和数据分析库pandas的熟练使用

项目经验

项目介绍:智能数据分析平台

开发一个软件质量评测项目,项目属于web项目,主要负责后台方法编写、部署,前端略有参与,项目分多个阶段,着重介绍2个阶段:

第一阶段:(着重后端方法编写)

缺陷自动分类功能实现,根据缺陷(bug)的标题、描述等相关特征信息,对缺陷严重程度等级(1-6)级进行分类,用到相关技术:

1、常用的建模/数据分析方法编写,处理缺失值、数据离散化、归一化、one-hot编码、字符串索引、降维、算法模型构建/模型保存与加载等常用功能编写通用方法,直接调用

2、结巴分词对描述信息文本分词,并去除停用词、构造自定义词典处理数据

3、 运用pandas对数据进行处理,缺失值、异常值、重复数据处理、特征向量化等

4、通过TF-IDF将数据向量化,在建模阶段对数据进行28比例切分,最后通过Sklearn SVM/朴素贝叶斯/决策树构造模型,对比验证各种模型的效果

第二阶段:(前后端配合)

该阶段是本项目重点阶段,采用django搭建后台,前端通过拖拽数据处理功能的操作,将数据/数据处理流程/建模方法等数据传到后端,后端根据传过来的参数,结合第一阶段编写好的方法对数据进行处理建模,并将结果返回前端进行相关图表展示,前端框架涉及jsplumb(流程图)、datatable.js(表格)、echarts.js(图表)、d3.js(架构图),后端相关技术主要有django框架、Pandas、numpy、sklearn常见数据处理与分析库。

第三阶段:(仿真测试缺陷预测)

根据公司内部测试数据,研究性预测每个项目仿真测试缺陷数,数据特征比较多,挑选了一些影响关系大的因子,开发人员经验、开发时间、项目类别等,并对离散型特征通过one-hot和分箱转化成数值参与模型运算,在建模过程中,考虑到不同特征下预测结果不一样,编写随机算法选择特征与手动选择特征进行结果比较,也通过在相同特征下选择不同的算法模型进行预测,得出结果进行比较,这样充分考虑各种情况,得出一份更具有参考性的结果。

案例展示

-

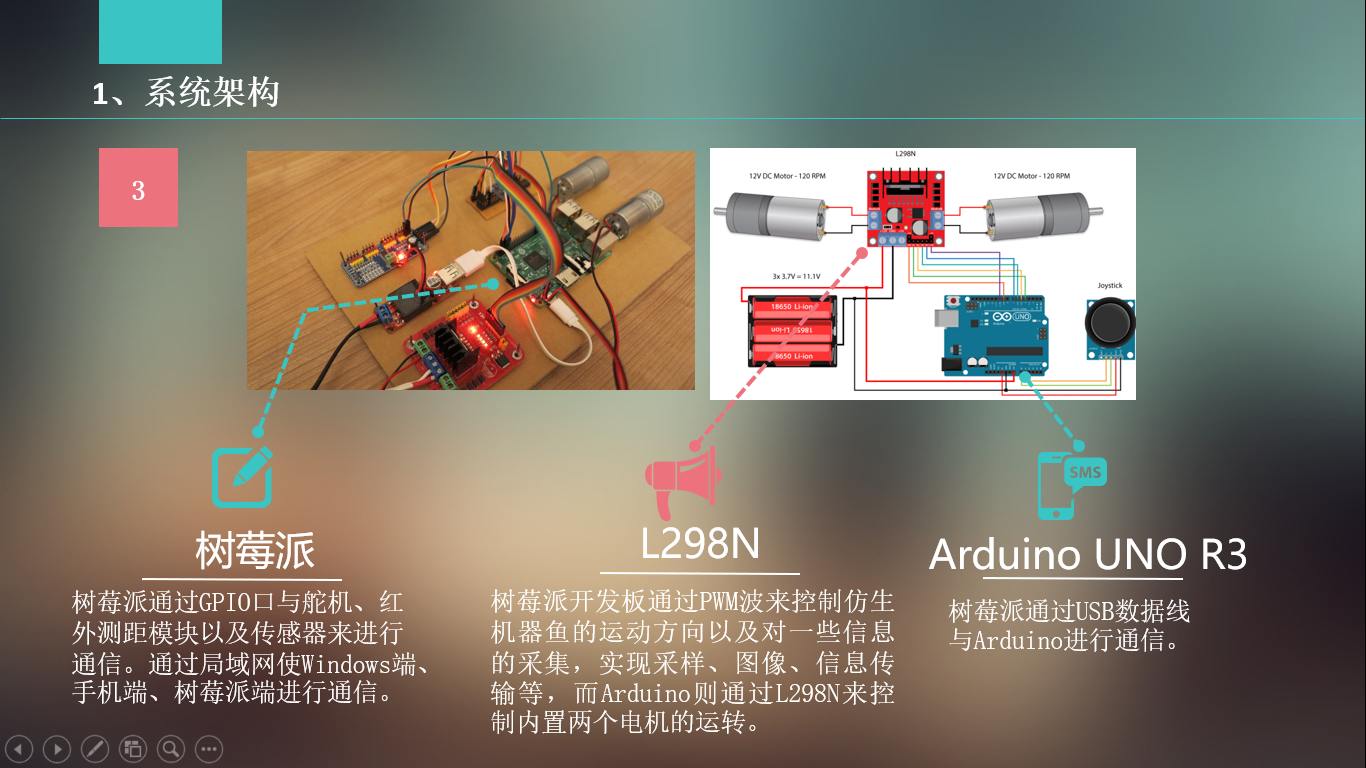

《基于大数据平台的鱼型环境检测机器人》

功能与指标 (1)尾部摆动功能:通过占空比与舵机旋转角度的算法使得树莓派输出PWM波对舵机占空比的控制,初步实现尾部舵机能像真鱼一样自如摆动。 (2)沉浮功能:通过控制鱼身内部直流减速电机的旋转。使鱼体尾部“活塞式”鱼壳通过伸缩控制进出水来增减鱼的体重,从而达到鱼沉浮自如的效

-

《豆瓣top250爬虫工程》

本项目的主要功能包括: 1,爬取豆瓣TOP250的书籍 2,将爬取到的数据存储到mysql 3,将程序编译为界面化程序 4,将界面化程序编译为可执行文件 关键点: 1、伪装请求报头(request header) 2、减轻访问频率,速度 3、使用代理IP

相似人才推荐

-

500元/天python工程师魔方微猎概要:pyt三年一直从事IT行业,有一年的Python前、后台交互开发及两年的Python爬虫工作经验,熟

-

500元/天Python后端开发工程师国网汇通金财信息科技有限公司概要:主要从事 Python 后端开发,精通django能基于源码二次开发,熟悉flask,tornado

-

800元/天高级测试工程师百度概要:https://blog.csdn.net/qq_41856814?spm=1010.2135.30

-

600元/天python开发工程师中软概要:熟悉Python编程语言等相关工作环境搭建,有良好的编程习惯。 熟练使用python/Java语言

-

500元/天Python开发工程师阿里巴巴概要:因为是一整个团队,团队角色包括 1.产品经理 1人 2.Python开发工程师2人 3.架

-

600元/天Python开发杭州妙学科技有限公司概要:擅长Python开发、爬虫、web开发,智能硬件产品原型开发,网站前后端开发,有Python、Jav

-

800元/天高级Python开发工程师深圳市国泰安教育技术有限公司概要:熟悉Python面向对象编程,熟悉Python的线程、进程以及协程 熟练运用django、flas

-

800元/天Python开发工程师索贝数码概要:两年Python后端开发经验 熟悉Linux操作系统和常用服务的安装与配置 熟悉Python主流