ID:186625

瞳

数据开发工程师

- 公司信息:

- 500

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 深圳

- 南山

技术能力

hadoop生态环境部署

熟悉数据采集,清洗,计算等数据开发流程

掌握mysql,psql,redis等等数据库

接口开发:python flask结合sqlalchemy,java jdbc

掌握airflow,azkban等任务调度工具

项目经验

crm系统接口开发:

采用flask结合sqlalchemy,封装接口,对postgres数据库进行增删改查。

用户行为告警数仓搭建:

hadoop+postgres+airflow+hive+spark+datax

案例展示

-

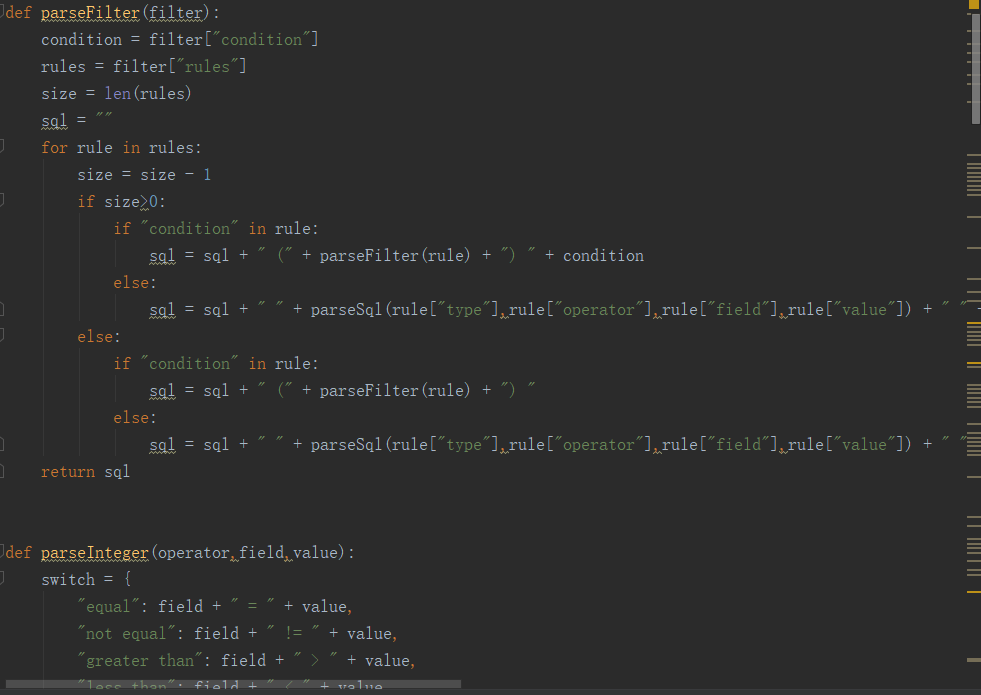

crm接口开发

嵌套json采用递归方法解析为sql,接口开发,采用flask轻量级框架,实现标准的restful。

-

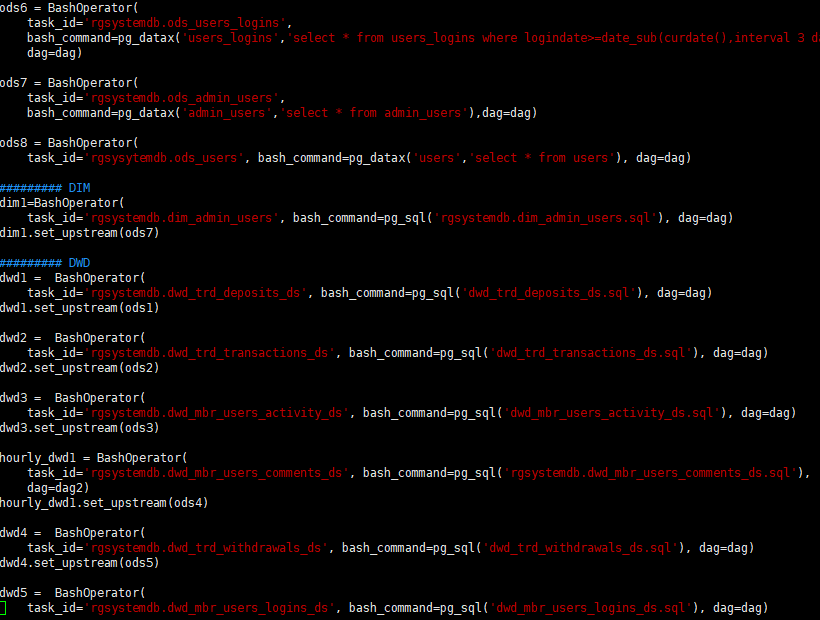

数仓开发

标准的数仓开发,分层4层,ods,dwd,dw,st。ods层通过datax同步数据到数据仓库,dwd对数据进行清洗,dw轻度聚合,st指标展示,用airflow每日进行调度。

相似人才推荐

-

1000元/天高级工程师中软国际概要:从事java开发,熟悉java后端主流框架,微服务、mysql数据和oracle数据,有分布式部署经

-

600元/天框架研发工程师上海前隆科技有限公司概要:语言掌握java(spring、springmvc等)、go(gin,自研socket游戏框架)、p

-

500元/天前/后端工程师浙江大华技术股份有限公司概要:熟悉C/C++ ; 熟悉GO; 熟悉rtsp/sip; 熟悉rtp/rtcp; 熟悉wire

-

500元/天系统研发工程师中国银联股份有限公司概要:1.2年中国银联股份有限公司运维研发工程师经验,精通Shell、python语言开发及linux命令

-

500元/天高级软件工程师东软集团概要:13年java高级工程师工作经历,在javaweb方面有丰富经验,前端、后端都能精通 前端html

500元/天高级软件工程师东软集团概要:13年java高级工程师工作经历,在javaweb方面有丰富经验,前端、后端都能精通 前端html -

500元/天程序员恩施州微点网络科技有限责任公司概要:我在恩施州微点网络科技有限责任公司担任技术总监,我们是团队有4位成员前端两名后端一名外加一名项目经理

-

800元/天高级软件工程师滴滴概要:1 熟练使用C/C++、java、python 2 熟练使用golang,具备相关实际项目的设

-

1000元/天cto江苏灵创优动网络技术有限公司概要:你的需求我不大全会做,但是大差不差你的需求我不大全会做,但是大差不差你的需求我不大全会做,但是大差不