郑勇 有团队

高级java工程师

- 公司信息:

- 浪擎科技

- 工作经验:

- 2年

- 兼职日薪:

- 800元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 上海

- 徐汇

技术能力

熟练应用Java,理解Java 中常用类、数据结构、多线程、反射机制等,熟悉Python、Scala语法;熟悉爬虫技术;

掌握算法与数据结构基本功,熟练使用设计模式进行程序设计;

熟练应用Java 主流框架:SSM(Spring、SpringMVC、MyBatis)、Springboot、SpringDataJPA、Shiro、SpringCloud;熟悉

SpringIOC、SpringAOP的源码;

掌握HTML5、CSS3、JavaScript、JQuery、Ajax、Echarts、Bootstrap、XML、JSON前端开发,了解Vue;

熟练使用IntelliJIdea、Eclipse、Webstrom、Pycharm、Hbuilder、Sublime、Navicat等开发工具;

熟练使用SVN、Git、Maven项目管理工具;

熟悉MySQL、Oracle、 SQLServer、DM、KingBase等关系型数据库;熟悉Logminer、Canal、Binlog、CDC等增量数据捕获;

有Redis、MogonDB等非关系型数据库(NoSQL)使用经验;

熟练应用Kafka 及Kafka 相关组件,有KafkaConnect+KafkaStream+Kafka 数据流通道设计经验;

熟悉大数据的相关技术栈:Hadoop、Spark、Kafka、HDFS、Hive 等

项目经验

浪擎DataOne数据融合系统

开发环境:IntelliJIDEA+JDK1.8+Maven+Git+MySQL+Redis+Kafka+Tomcat+Netty

框架选用:分布式集群架构

1、前台:React+AntDesign+Echarts

2、中台:SpringCloud+SpringDataJPA+Shiro+Swagger2;

3、数据采集、转换、清洗、脱敏、过滤、对比、文件同步服务:SpringCloud+Netty+Kafka+KafkaConnect+JDBC:

项目描述:

1、DataOne 是浪擎科技自主研发的多元异构数据汇聚产品,致力于解决大数据治理的“第一公里”,主要用于各类数据融合、数

据交换场景,专为超大数据量、高度复杂的数据链路设计的灵活、敏捷、及时、可扩展的数据交换平台,无需额外的开发和生产发布,

通过可视化图形配置和管理数据任务,几分钟即可自服务部署一条实时数据管道,所有操作在浏览器内就可以完成,减少企业的数据

融合成本。

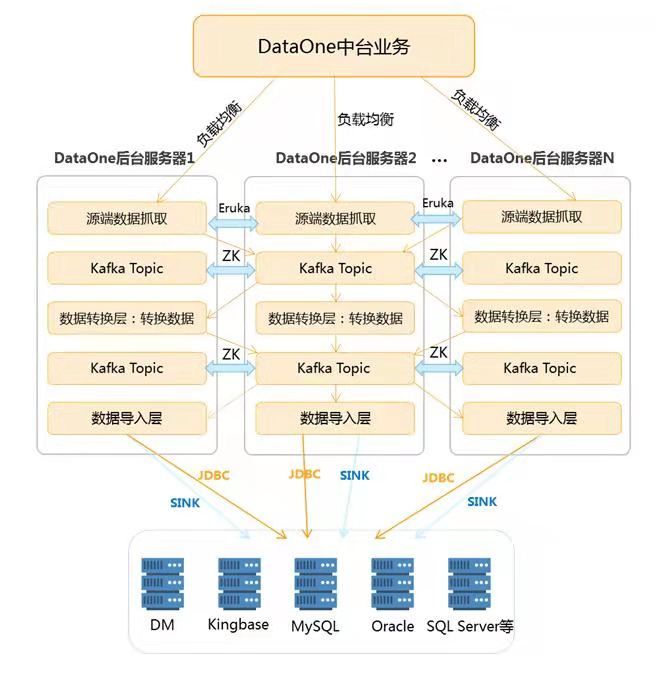

2、DataOneV5.0版本将系统底层功能模块化,采用分布式架构

中台服务采用:Springboot+Shiro+SpringDataJpa+SpringCloud等框架提供相关服务 API:系统安全管理、用户权限管理、系统

日志管理、历史任务管理、数据同步管理、数据对比管理、实时监控、数据可视化等功能;

数据同步服务:采用SpringCloud+Kafka 相关组件实现分布式的任务数据流通道,数据同步服务分为数据采集层、数据转换层

及数据导入层,数据采集层主要采用KafkaSourceConnector与各种数据库对应的归档日志,实现实时、定时捕获数据源全量或增量数

据;数据转换层实现过滤、脱敏、去重、异构转换、高级清洗脚本等数据治理;数据导入层主要采用KafkaSinkConnector与JDBC 将

处理完成的数据导入到指定的目的端数据源。目前支持MySQL、Oracle、SQLServer、Sybase、DM、KingBase 等关系型数据库异构迁

移转换,支持FTP文件迁移,支持关系型数据源到目的端HDFS、HBase、Hive 等数据迁移。

数据对比服务:目前仅支持Oracle 到 Dm的对比,支持数据库表结构:长度、精度、字段类型、允许空值、主键类型、默认值、

注释对比;支持数据对比:数据量、数据差异、数据缺失等;数据库对象:触发器、视图、存储过程、存储函数等数量对比

个人成就:

1、负责把控项目每阶段的进度,分配后端开发成员工作任务,管理代码提交质量;负责系统中后台的架构设计,充分运用抽象

工厂、动态代理等设计模式;整合SpringCloud、Kafka 构建实时数据流通道,重构了原来C\C++编写的同步数据模块,大大提升了整

个任务同步的实时性与同步效率,支持了全量的并行流通道;集成Quartz,实现了任务的定时读取功能,满足了客户绝大部分数据迁

移的场景;应用Java的反射机制实现动态调用界面配置的脚本,大大提高了数据治理层的可扩展性。

2、编写了相关关系型数据库增量采集的可行性分析文档,如Binlog、Logminer(工具)、CDC、ChangTracking、fndblog等事务

日志解析;如KafkaSourceConnector、Canal、MaxWell、DataX 等数据增量采集工具;如 DM的DTS、Oracle 的DataPump、Rman、

人大金仓的KingbaseDT等迁移备份工具。

3、 实现了数据源MySQL5.7以上、Oracle11g至Oracle19c 全量与增量采集;目的端达梦数据库兼容dm7、dm8;Oracle 最开始

版本采用 Logminer 实现,通过 Oracle 的 Logminer 的工具,对增量数据进行解析捕获发送至 Kafka 中 ,后采用 Kafka Oracle Source

Connector开源组件,其底层也是使用Logminer,修改了该工具的源码:数据封装格式改成与DataOne 增量数据格式一致;修改Logminer

文件加载的流程,避免大事务增量导致connector卡死的问题;添加了DDL增量数据捕获的功能。MySQL采用 debeziumconnector实

现。目的端使用jdbc的批处理实现。

4、2020年6月在xx市公积金测试Oracle12cRac 同步数据到 Oracle11g和12c;2020年9月xx市府信访办测试Oracle11g迁移

到DM7。数据质量、迁移性能均得到客户满意的反馈。后期规划采用DataOne构建xx市公积金数据中台,负责xx市府信访办、宣传

部等信创迁移工程。

5、2

团队情况

- 整包服务: 微信公众号开发 微信小程序开发 PC网站开发 H5网站开发 App开发 WebApp开发 文档原型图 DBA开发 其他开发

| 角色 | 职位 |

| 负责人 | 高级java工程师 |

| 队员 | iOS工程师 |

| 队员 | 安卓工程师 |

| 队员 | 前端工程师 |

| 队员 | 后端工程师 |

案例展示

-

浪擎DataOne数据融合系统

1、DataOne 是浪擎科技自主研发的多元异构数据汇聚产品,致力于解决大数据治理的“第一公里”,主要用于各类数据融合、数据交换场景,专为超大数据量、高度复杂的数据链路设计的灵活、敏捷、及时、可扩展的数据交换平台,无需额外的开发和生产发布,通过可视化图形配置和管理数据任务,几分钟

-

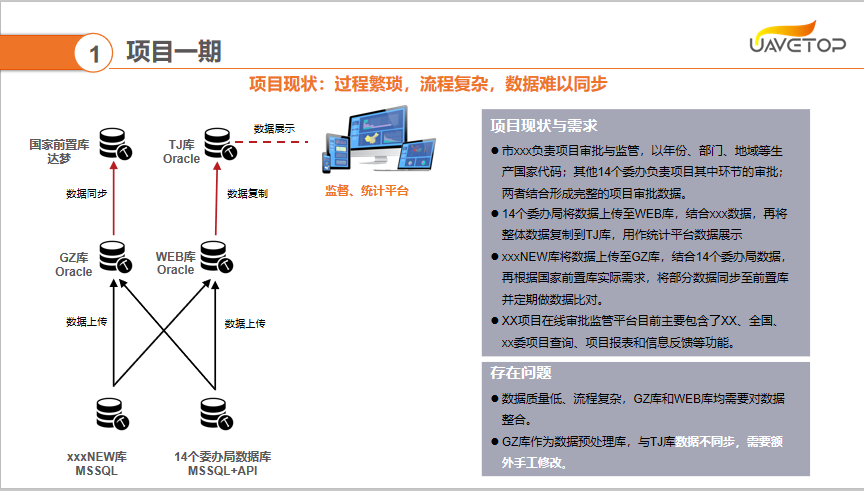

上海市在线审批监管平台

1、项目初期规划分为三期建设,2018 年 9 月项目团队开始进场梳理固投业务领域知识及 Web 查询系统的需求,截止至今该项目 已完成两期建设 2、一期建设内容:梳理了固投审批平台 500 多张核心业务表;开发清洗功能;辅助投资处、信息中心制作全国固投评比材料(PPT、网页

相似人才推荐

-

500元/天java开发工程师吉林省汇杰科技有限公司概要:Java基础开发工具,SSM、SSH等开发框架,前段页面加工优化,后端代码编写,相关程序文档梳理,可

-

500元/天Java工程师富泰华实业有限公司概要:1、熟悉并掌握Java面向对象程序设计,有良好的编程习惯; 2、熟练使用Java的工厂模式、单例模

-

600元/天JAVA研发北京布卡互动有限公司概要:三年Java开发,一年Python,半年Go语言使用经验, 掌握常用设计模式, 熟练操作Linu

-

500元/天java 开发工程师北京吉贝克有限公司概要:具有良好的Java基础,有良好的编程习惯,及面向对象设计思想。 能熟练使用java集成开发工具

-

500元/天Java开发工程师中金支付有限公司概要:主要从事Java后台开发;熟练使用主流的SSH以及SSM框架;熟练使用 dubbo,MQ等中间件;对

-

500元/天java开发工程师北京东方国信概要:熟悉SSM框架,熟悉springboot和springcloud微服务开发。 熟悉elastics

-

500元/天中级java开发上海科匠信息(目前在职)概要:orcale,linux(熟知) spring springmvc redis mysql quar

-

500元/天java开发工程师青岛英谷教育科技股份有限公司概要:精通JAVA语言,熟练掌握HTML/CSS、JavaScript、Ajax、Jquery等常用WEB