ID:152175

R I S E_💦 身份已认证

高级爬虫工程师

- 公司信息:

- 中泰证券

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 上海

- 浦东

- 陆家嘴

技术能力

熟悉 mysql , redis , Mongodb

熟悉使用Linux

熟练编写 爬虫程序

日均数据量100w+

熟练多线程,多进程

熟练使用scrapy

熟练 爬虫 能解决 反爬虫 ip封禁 headers规则 ajax动态加载 验证码

熟练使用 正则 ,xpath,bs4解析模块

熟练使用网络请求库 requests urllib urllib2

使用 crontab 做定时任务

数据 清洗 无重复 不会漏数据

项目经验

分布式 淘宝 (店铺,宝贝,评论,关键字,排行) 爬虫

微信公众号(券商中国)

caipan文书网(所有文书)

新浪财经(股票,基金)

58同城 个人房源

雪球 --- 配资

亚马逊

京东

今日头条

拉勾网

新浪环球市场

腾讯新闻

苏宁

陆金所基金

案例展示

-

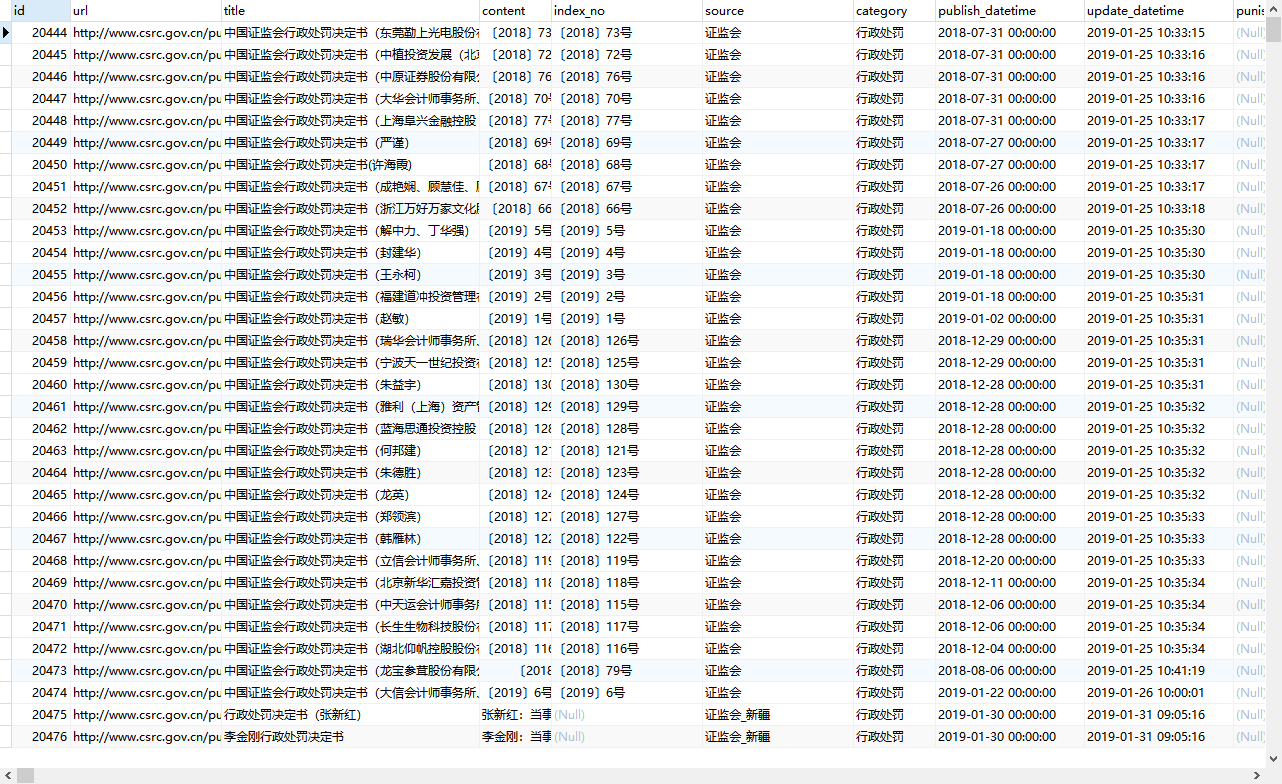

证监会行政处罚

证监会行政处罚数据:链接,标题,内容,文号,时间 全国中小企业股转动态数据:类型,标题,时间,访问次数,内容,pdf链接(可直接跳转下载),子标题,链接

-

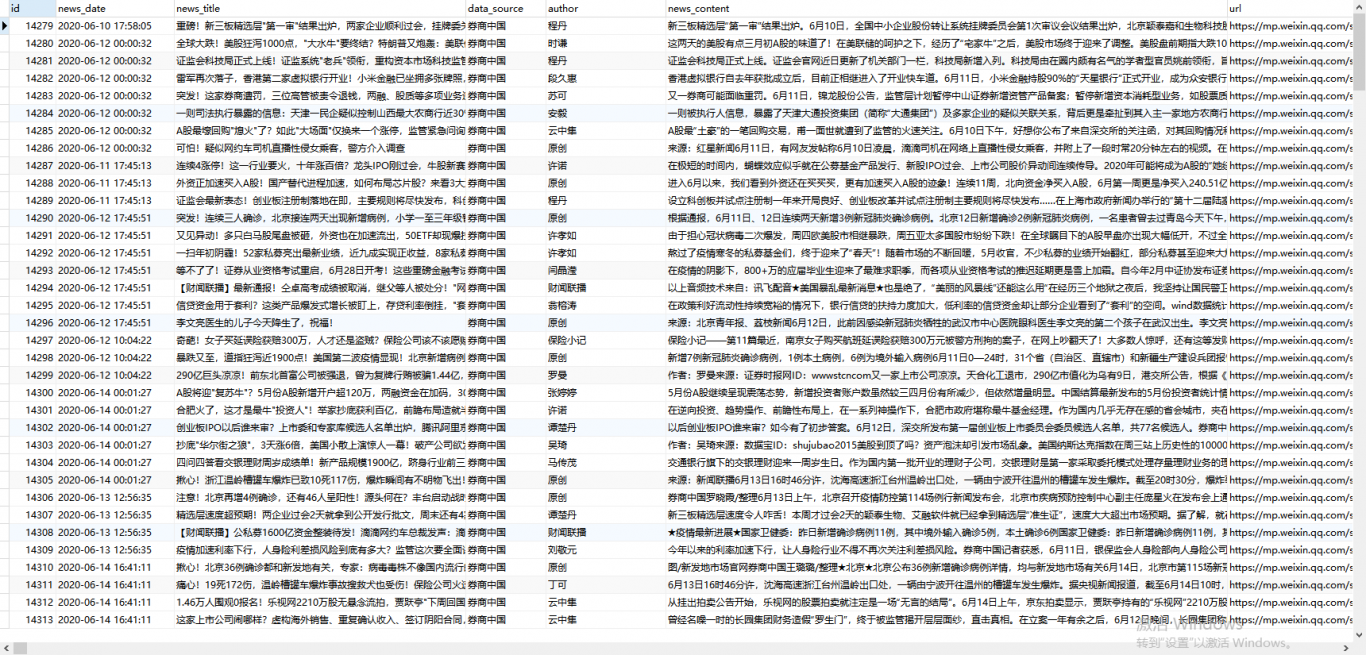

微信公众号

微信公众号数据抓取:发布日期,标题,作者,内容,链接 可抓取网站海量图片,数据,地址 可以多种形式交付:Exl mysql csv

相似人才推荐

-

500元/天中级软件工程师东软集团概要:1. 熟练运用struts2、hibernate、maven 、Mybatis、spring、jqu

-

500元/天项目经理亿阳信通概要:1:熟悉python语言 ,熟悉flask框架,懂得爬虫,包括爬取web及app端 2:熟悉web

-

1000元/天应用软件经理海康威视概要:10年开发经验,熟悉Java基本技术,熟悉主流数据库oracle,MySQL,postgresql等

-

800元/天高级软工公司不方便透露概要:1、作为一个java程序员,后台模块主要职责有:后台代码的编写、包括数据库操作、语句优化、技术调用接

-

800元/天高级软件开发工程师华为概要:熟悉JAVA后端的开发,对微服务有深入的理解,熟悉mysql,postgresql等数据库的基本应用

-

500元/天学生西南交通大学概要:熟悉java开发,C/C++开发 了解Spring,struts,servlet等框架。 掌握多

-

500元/天技术部主管上海华盛喜一酒店管理有限公司概要:Spring,Struts,Hibernate,Spring Mvc,Mybatis,SpringB

-

500元/天软件开发工程师寿之源养老服务管理有限公司概要:熟练掌握Java语言、php语言;熟练运用Spring,Mybatis,springmvc,等;熟悉