shenjinrui

运维工程师

- 公司信息:

- 自由职业者

- 工作经验:

- 5年

- 兼职日薪:

- 1300元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 深圳

- 南山

技术能力

掌握shell脚本的编写,曾从0到1完成服务器上线初始化脚本、应用发布脚本等企业运维脚本的编写。

熟悉Linux系统,掌握常见命令的使用,从事过系统运维(负责5000机器),业务运维(从0到1建立起业务运维体系)。

熟悉java编程语言,了解java JVM工作原理,从事业务运维期间,经历了java服务从单体应用到微服务的变迁。

熟悉常见关系型、非关系型数据库,如MySQL 、Redis。

熟悉主流web服务器,如nginx。

熟悉监控体系及常见开源监控软件,如zabbix。

熟悉常见运维服务,如ELK、bind、samba、rsync、mecached、svn、lvs、keepalived。

熟悉基本的网络知识,基于TCP三次握手的基本原理处理过多次故障。

熟悉Hadoop生态圈常见组件的安装部署,如Hadoop、Hive、CDH。

熟悉自动化运维工具,如ansible。

熟悉iptable的基本原理,曾落地5000台服务器的iptables策略的统一管理方案。

熟悉docker技术,曾把java微服务迁移到k8s集群,实现服务的自动扩容与缩容。

项目经验

项目一:内部DNS高可用方案

项目介绍:hadoop、kafka等服务依赖于hostname,刚开始大数据团队通过修改/etc/hosts文件来处理,随着群集节点的增加,维护/etc/hosts文件越来越困难,所以提出了自建内部dns server的需求。

我的职责:负责整个项目,具体考虑方向及实施如下:

1、 业务分布在国内外,国内访问facebook等海外服务是有问题的,所以在国内外机房各选一个核心机房部署一套dns server,一共4台服务器。

2、 dns server作为一个基础服务,必须保证其高可用,所以在物理上,把服务器放在不同的机柜,在软件上采用Keepalived实现高可用,通过VIP对外提供服务。

3、 负载均衡方面,经过压力测试,dns server每秒能处理1700左右的请求,出于越简单越好的运维原则,同时为了提高服务器利用率,所以弃用lvs进行负载均衡,把暂时空闲的服务器暂时用于其它服务。

4、 为了确保dns server服务的正常,对可用性、请求量进行监控。

相关技术:shell、bind9、Keepalived、lvs

项目二:服务器标准化上线

项目介绍:随着公司业务发展,采购服务器的需求越来越多,随之而来的是服务器的上架及管理越来越乱。随着服务器数量的增加(目前5000+),因配置不一而导致的管理成本越来越大。所以对服务器按配置来确定14款机型,相同机型的配置统一起来。

我的职责:

1、 按机型编写shll脚本,对新机器进行初始化。

2、 按机型编写shell脚本,对新机器上线进行验收。只有验收通过了,才允许交付上线。

3、 维护初始化\验收脚本,有新的配置需求及时修改脚本。

4、 对线上3500+服务器的配置进行管理,如iptables规则的变更。

5、 对iptables的拒绝情况进行监控,判断是否有拒绝了正常的请求。

相关技术:shell、iptables、监控。

项目三: 基于Spark的业务实时监控

项目描述:

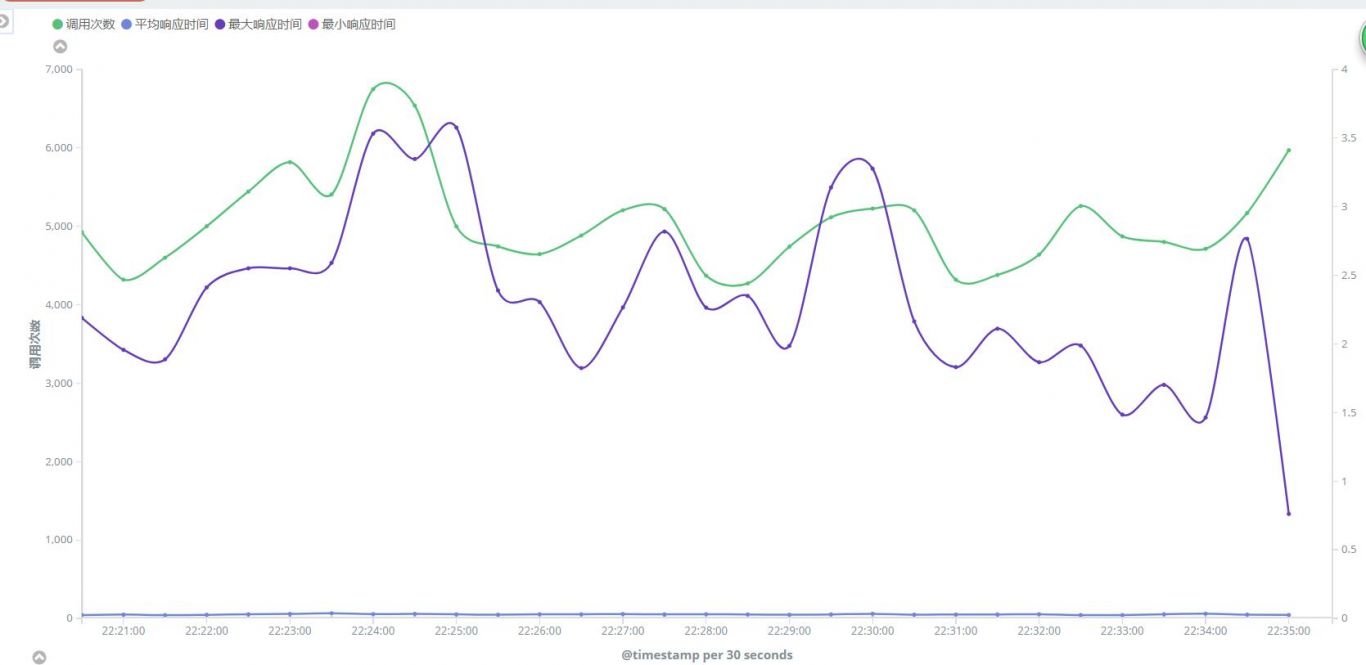

该项目主要分为数据传输、数据消费、数据分析三个阶段。通过实时计算nginx日志的http响应状态码、反向代理调用后端java接口的响应时长,为线上业务健康监控提供数据基础。

软件架构:filebeat + kafka + Spark + MySQL

责任描述:

1、 负责整个系统的架构环境搭建及代码编写。

2、 统一nginx日志格式。

3、 filebeat采集数据,实时监控nginx日志文件,传入kafka topic。

4、 基于Spark Streaming实时计算nginx日志的http响应状态码、反向代理后端java的接口的响应时长,对异常情况通过短信邮件告警。

5、 MySQL维度建模。根据对应的数据指标创建对应的MySQL数据表, Spark 写入到MySQL表中。

案例展示

-

蓝鲸系统部署

为了解决人肉运维的效率低、出错率高等痛点,上线腾讯开源的蓝鲸系统,为运维提供的一站式运维(技术运营)技术解决方案。其于蓝鲸监控完成了线上所有服务器的监控(包括系统监控,业务监控);基于作业平台来管理我们的日常作业,避免登陆服务器人肉执行各种命令,导致出错;基于标准运维,完成我们的

-

CDH的安装部署

hadoop生态圈组件非常多,并且大数据基本都要使用到这些组件,为了统一管理这些组件并且避免出现依赖问题,上线CDH来管理大数据使用的组件。

-

基于efk实时分析业务流量情况

为了实时分析线上日志,实现实时分析nignx日志,获取接口调用次数、http状态、接口调用耗时等信息,上线efk系统。

相似人才推荐

-

800元/天运维工程师编程猫概要:熟悉docker容器化技术 熟悉ansible,有很强ansible-playbook代码编写能力

800元/天运维工程师编程猫概要:熟悉docker容器化技术 熟悉ansible,有很强ansible-playbook代码编写能力 -

500元/天运维工程师成都聚信杰信息技术有限公司概要:工作经验三年,从事过web前端设计、实施运维工程师岗位,熟悉前端布局、网页设计、程序部署、服务器维护

500元/天运维工程师成都聚信杰信息技术有限公司概要:工作经验三年,从事过web前端设计、实施运维工程师岗位,熟悉前端布局、网页设计、程序部署、服务器维护 -

500元/天通信运维工程师国家电网概要:J2EE(熟悉java基础,熟悉数据结构与算法,熟悉多线程开发、NIO、Socket开发。了解Tom

-

600元/天运维工程师国内NO.1教育行业概要:nginx/tengine 反向代理 tomcat等常用web容器 redis、activemq

600元/天运维工程师国内NO.1教育行业概要:nginx/tengine 反向代理 tomcat等常用web容器 redis、activemq -

500元/天linux运维安徽商网信息产业有限公司概要:熟练掌握linux centOS系统,精通linux apache mongodb php网站环境服

-

500元/天软件运维移动概要:C++开发(基础算法和Qt客户端) Python开发(数据处理脚本、爬虫、自动化脚本) shel

500元/天软件运维移动概要:C++开发(基础算法和Qt客户端) Python开发(数据处理脚本、爬虫、自动化脚本) shel -

500元/天运维经理黑龙江亿林网络股份有限公司概要:上云顾问,阿里云,腾讯云,小鸟云,amazon aws,microsoft azure 等等 服务

-

500元/天桌面运维工程师北京金融资产交易所概要:精通桌面电脑软、硬件相关知识和技能,能独立判断软、硬件故障,对于常用的Office办公软件较精通;

500元/天桌面运维工程师北京金融资产交易所概要:精通桌面电脑软、硬件相关知识和技能,能独立判断软、硬件故障,对于常用的Office办公软件较精通;