案例介绍

ARB(Arbitrum One chain)nitor + geth + prsm

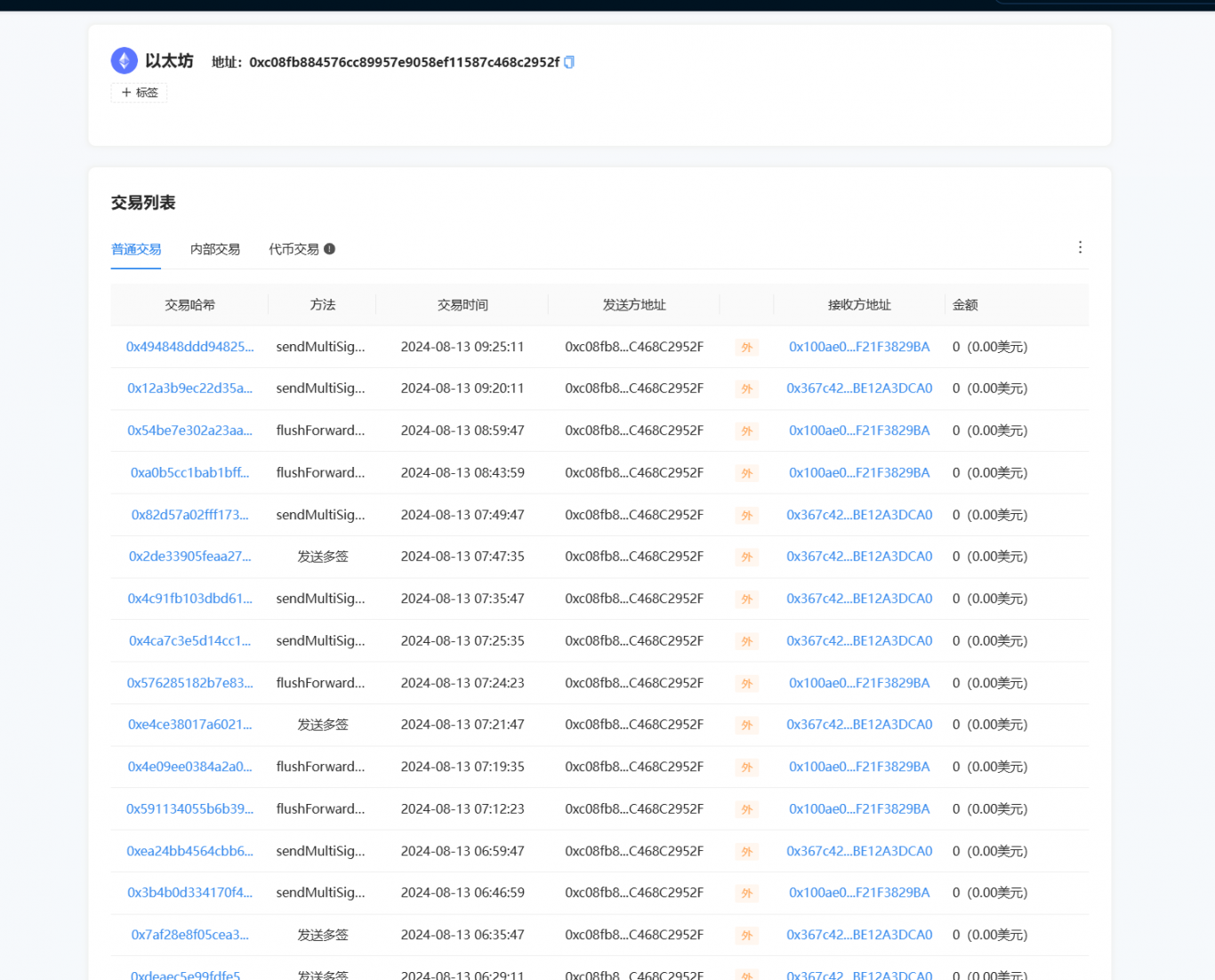

• Arbitrum One chain 全节点的建设,包括 Layer1 层 Ethereum 和 prysm 的部署安装,结合第三方 RPC 节点有

效同步区块高度

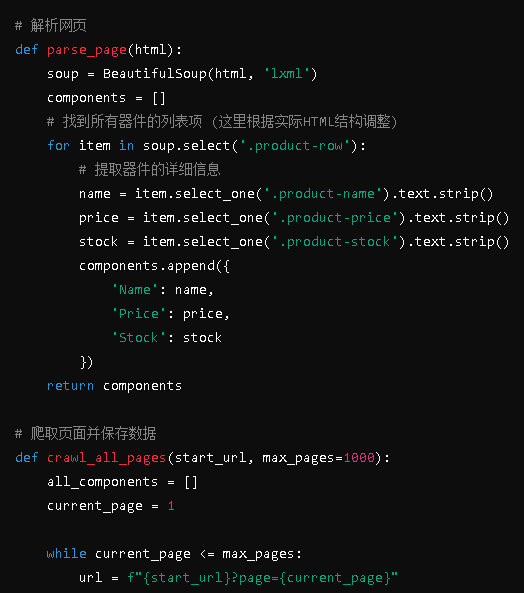

• 通过了解 ethereumetl 源码和二次开发 Web3j 的 JAVA 库,使用本地 RPC 接口解析并导出区块、交易、日志、

内部交易等数据,写入至 kafka

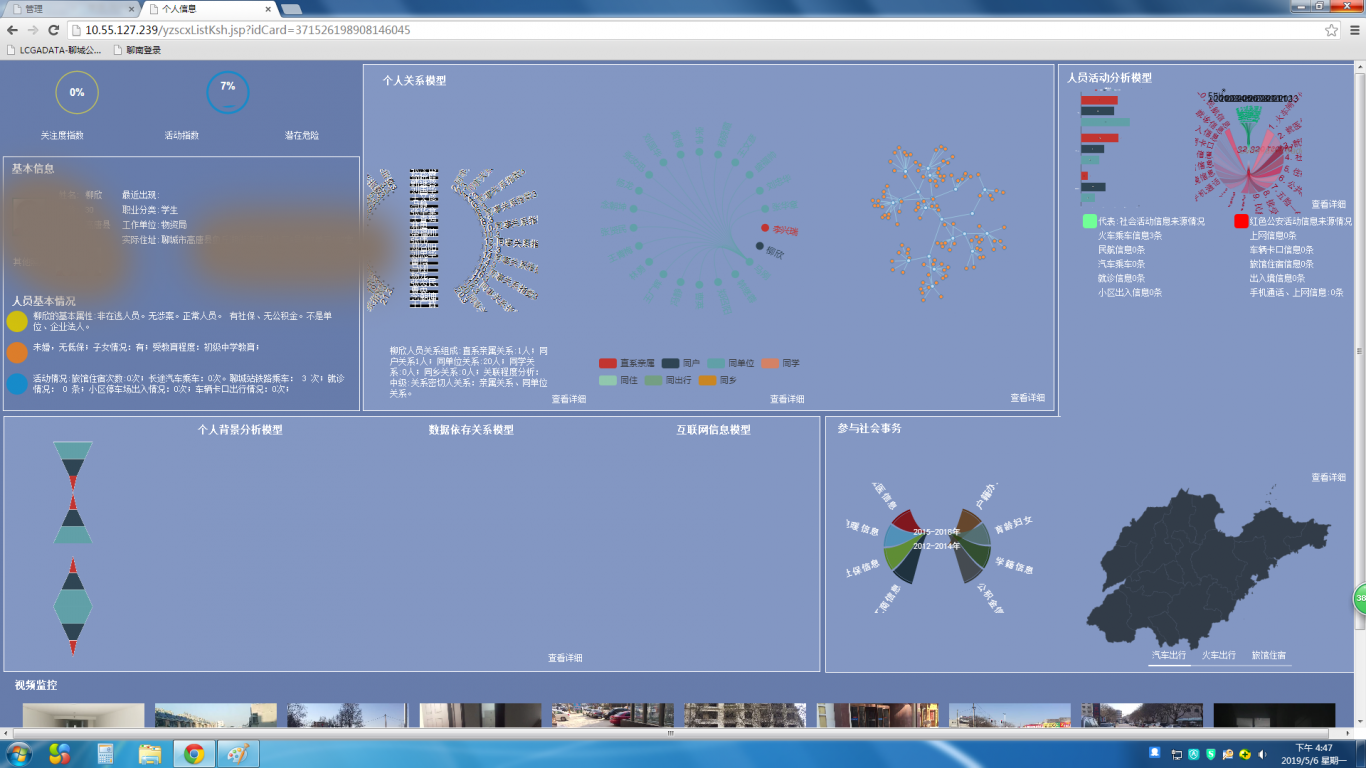

• 根据 ETH\BSC 指标做出优化开发,将基础数据清洗,转换、入库,为前后端基础数据 的查询做支撑

• 根据需求完成实时流处理模型的开发及优化(部署\调用合约攻击监测,流动性排行、预警,RugPull 预警,大额转

账等)

BSC(BNB smart chain)geth(48club)

• BNB smart chain (bnb)全节点的搭建及维护,有效同步区块高度

• 使用 ethereumetl 执行命令将区块、交易、日志、内部交易等数据导出至文件,开发并执行 jar 包读取文件写入

至 kafka

• 将基础数据清洗,转换、入库,为前后端基础数据 的查询做支撑

• 根据需求完成实时流处理模型的开发及优化(部署\调用合约攻击监测,流动性排行、预警,地址交易预警,

RugPull 预警,大额转账等)

工作经历

• 使用 bitcoin-etl 命令导出数据至文件,使用 filebeat 日志采集工具将数据采集写入 kafka(弊端,缺失数据)优

化 btc 数据导出,使用自定义 jar 包读取文件写入 kafka

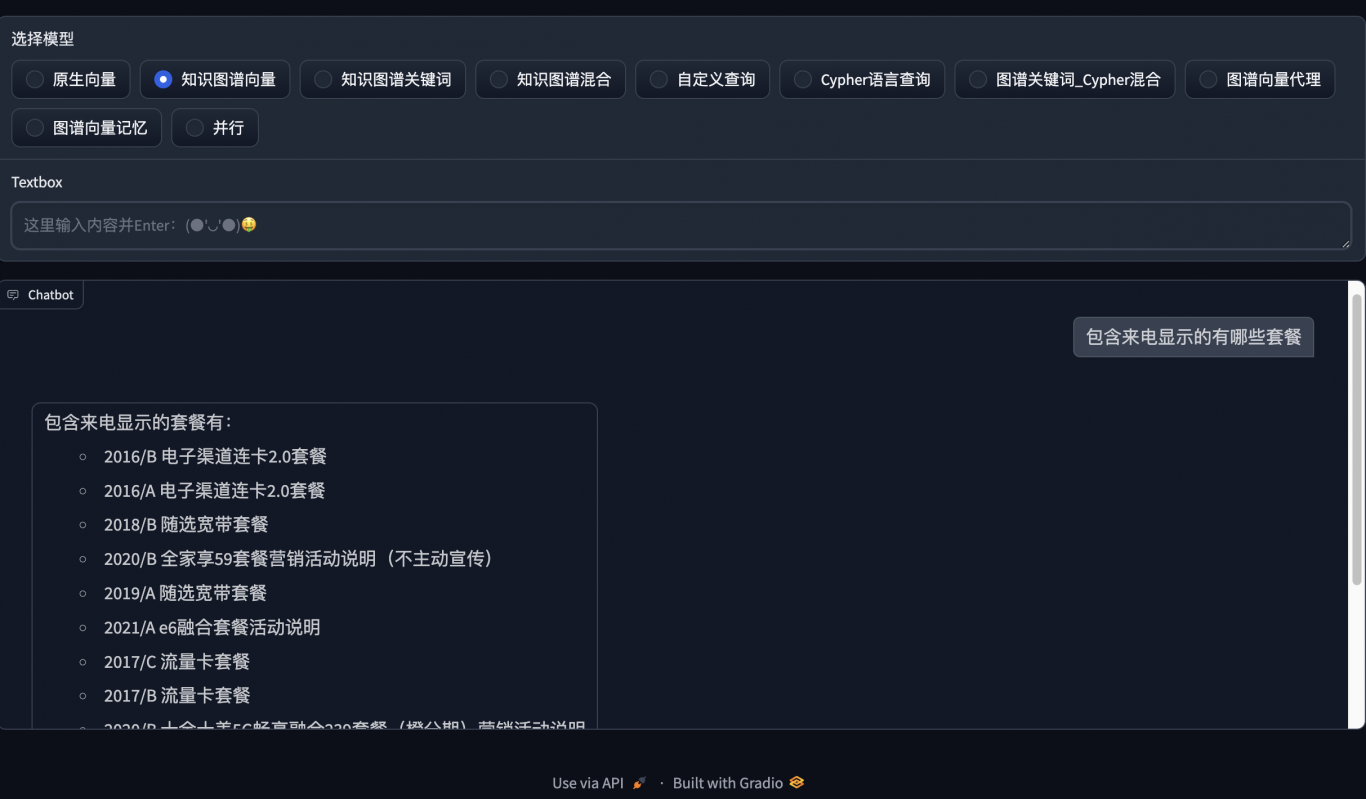

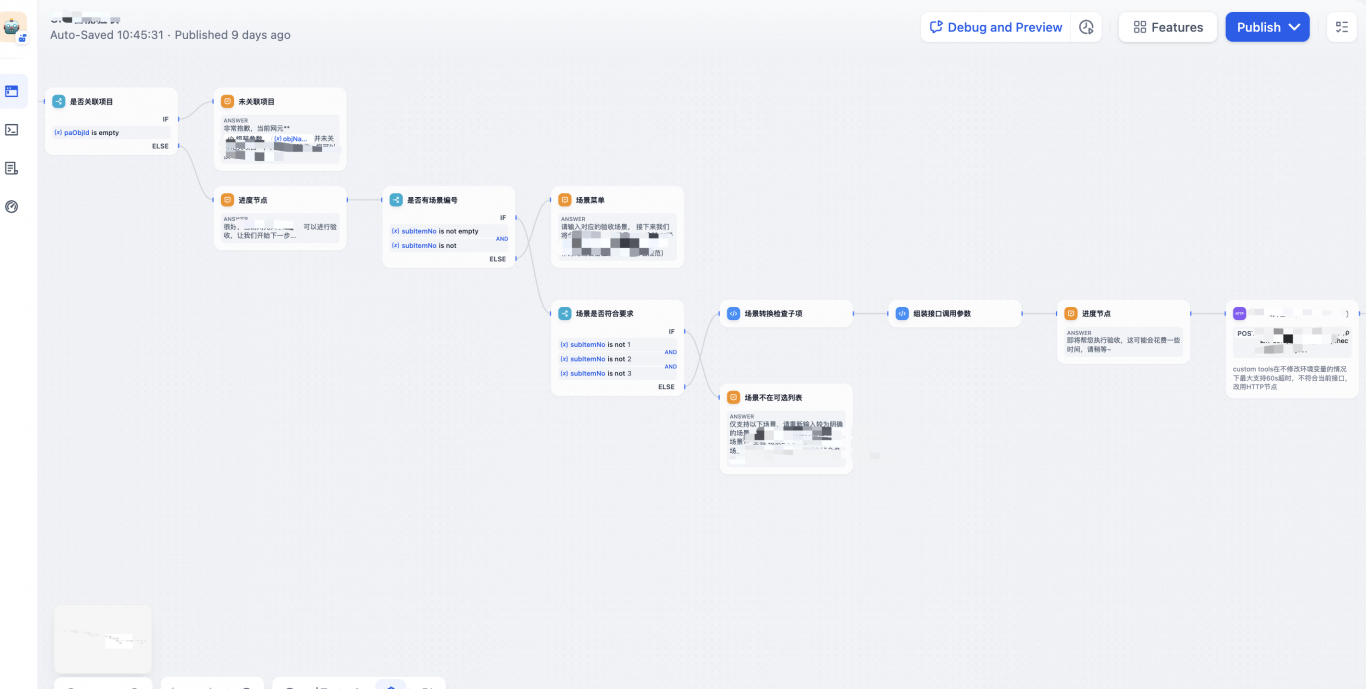

Flink 实时流处理引擎(自主研发)

• 是一款针对 Flink 任务运行的一站式运维平台,主要为上传、下载 jar 包、简化提交、执行 Flink 任务,测试和生

产环境隔离,任务版本维护,关系型数据库存储元数据,任务失败预警提醒等功能

• Flink+ HDFSApi + YarnApi + Mysql + SpringMVC + vue + 阿里钉钉 + Web3j

案例图片