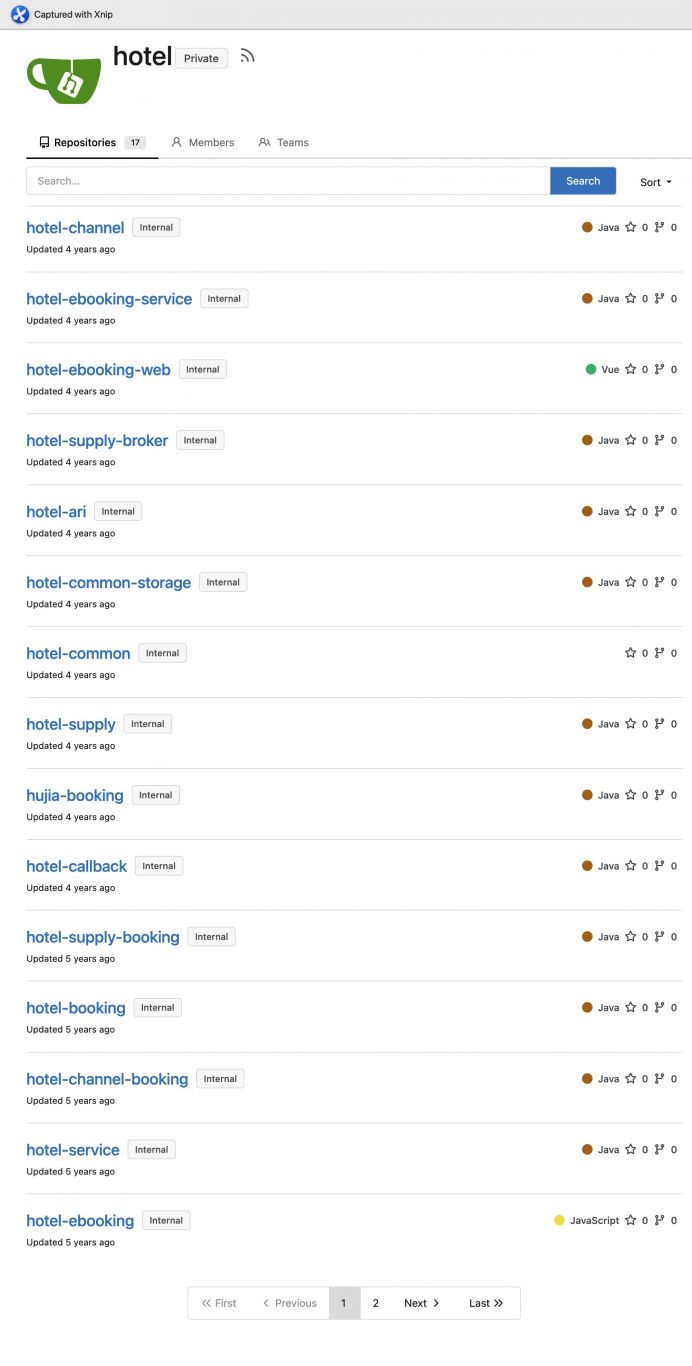

案例介绍

在“竞品猎手”项目中,担任了项目核心开发工程师。以下是这项目中负责的具体工作:

1. 技术选型与框架搭建:选择了Scrapy作为主要的爬虫框架,因为它的高效性和灵活性能够满足我们对大规模数据抓取的需求。同时,负责搭建项目的基本架构,包括爬虫的分布式部署、数据存储方案以及异常处理机制。

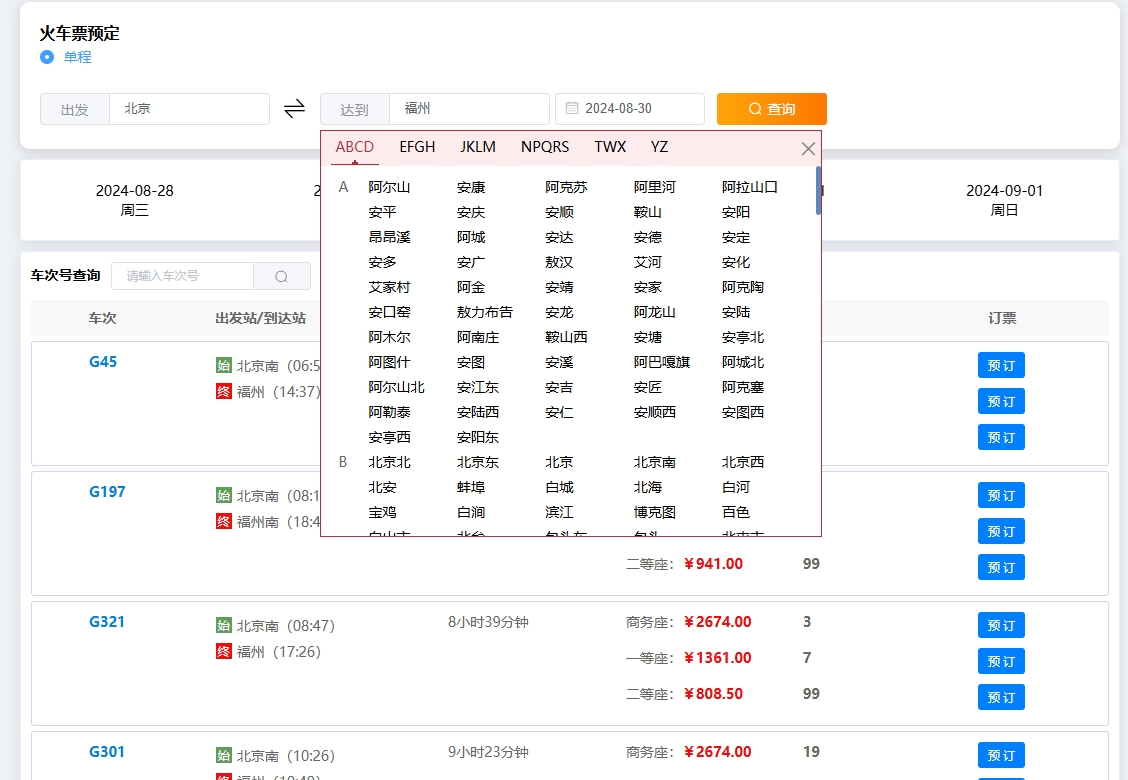

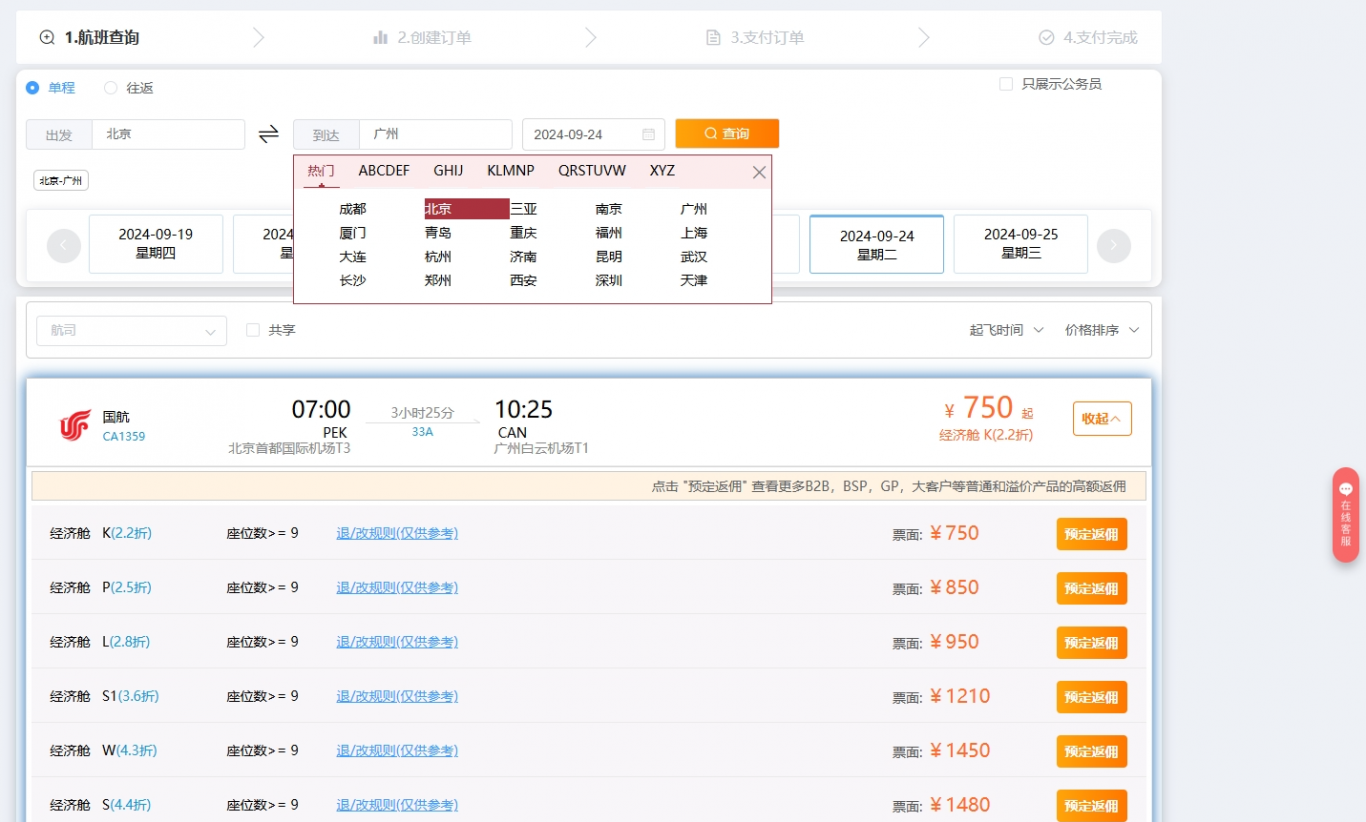

2.爬虫开发与优化:开发了多个针对不同竞品网站的爬虫,负责编写爬虫代码,处理页面解析、数据抽取和持久化存储。针对反爬虫策略,设计了相应的绕过方案,如IP代理池、User-Agent轮换、请求频率控制等,确保爬虫的稳定运行。

3.数据清洗与处理:为了保证数据的准确性和可用性,编写了一系列的数据清洗脚本,对抓取到的数据进行去重、格式化和校验,确保最终交付的数据质量。

4.性能监控与维护:负责监控爬虫的运行状态,及时发现并解决性能瓶颈和潜在问题。此外,还定期对爬虫进行维护和更新,以适应目标网站的变化。

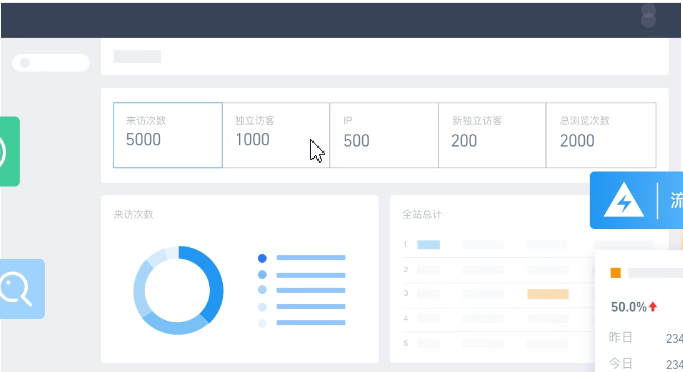

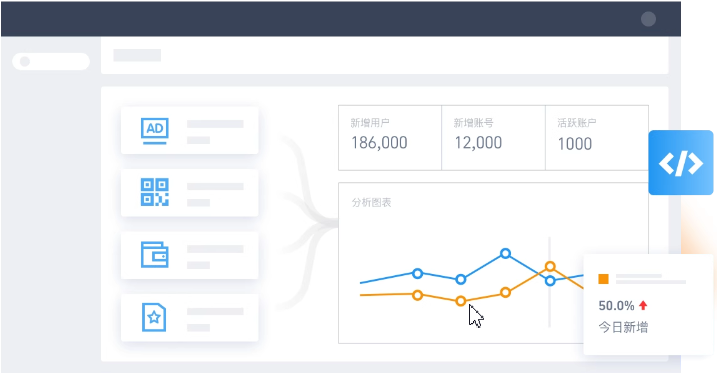

案例图片