案例介绍

So-VITS 技术基于 Transformer 架构的人类仿真音色生成

项目背景:

在语音合成领域,传统的基于规则和统计的方法往往难以产生自然流畅的人类语音。基于神经网络的端到端语音合成技术由于其能够从大量数据中学习语音特征而受到关注。So-VITS(Sonic Voice Transformation)技术结合了 Voice Conversion 和 Text-to-Speech 技术,利用 Transformer 架构实现了更加自然的人类仿真音色生成。

技术特点:

Transformer 架构: So-VITS 使用了 Transformer 架构,这种架构在自然语言处理领域已被广泛应用,其自注意力机制能够捕捉输入序列中的长距离依赖关系,适用于语音信号的建模。

语音特征学习: So-VITS 利用 Transformer 网络对语音特征进行学习,能够有效地捕获语音信号中的音频特征和语义信息,从而实现更加自然的语音合成。

音色转换: So-VITS 通过学习语音特征的表示,并在此基础上实现音色的转换。它能够将输入的语音信号转换为与目标人类音色相似的声音。

端到端训练: So-VITS 实现了端到端的训练,即从原始音频到生成音频的整个过程都在一个模型中完成,避免了传统语音合成系统中的多个模块串联带来的问题。

项目成果:

So-VITS 技术在人类仿真音色生成领域取得了显著的成果,生成的音色更加自然、流畅,接近于真实人类的语音。

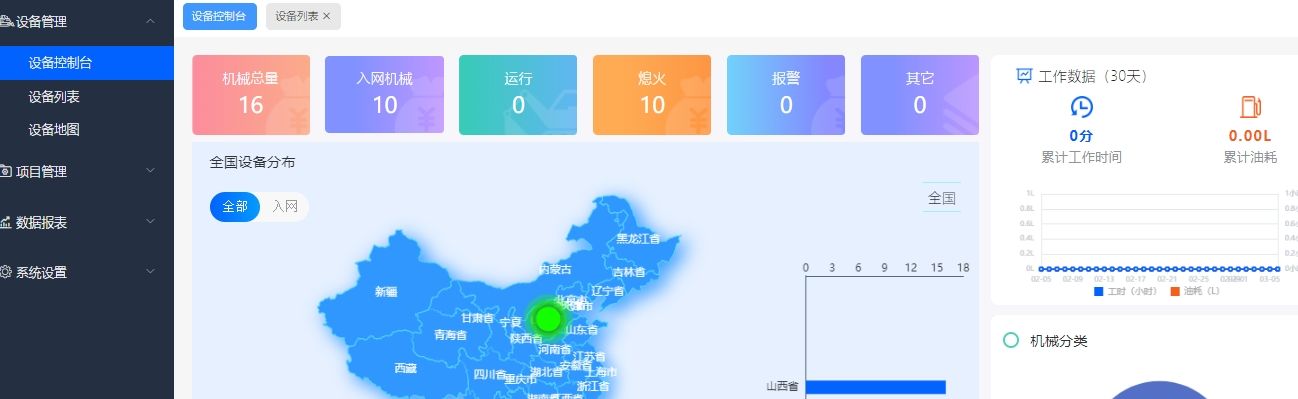

该技术在语音合成、语音识别等领域具有广泛的应用前景,可用于智能语音助手、自动驾驶系统、医疗辅助等领域。

未来展望:

So-VITS 技术的不断发展和优化将进一步提升人类仿真音色生成的质量和效率,为语音合成技术的发展开辟新的可能性,并在各个领域带来更加智能、自然的语音交互体验。

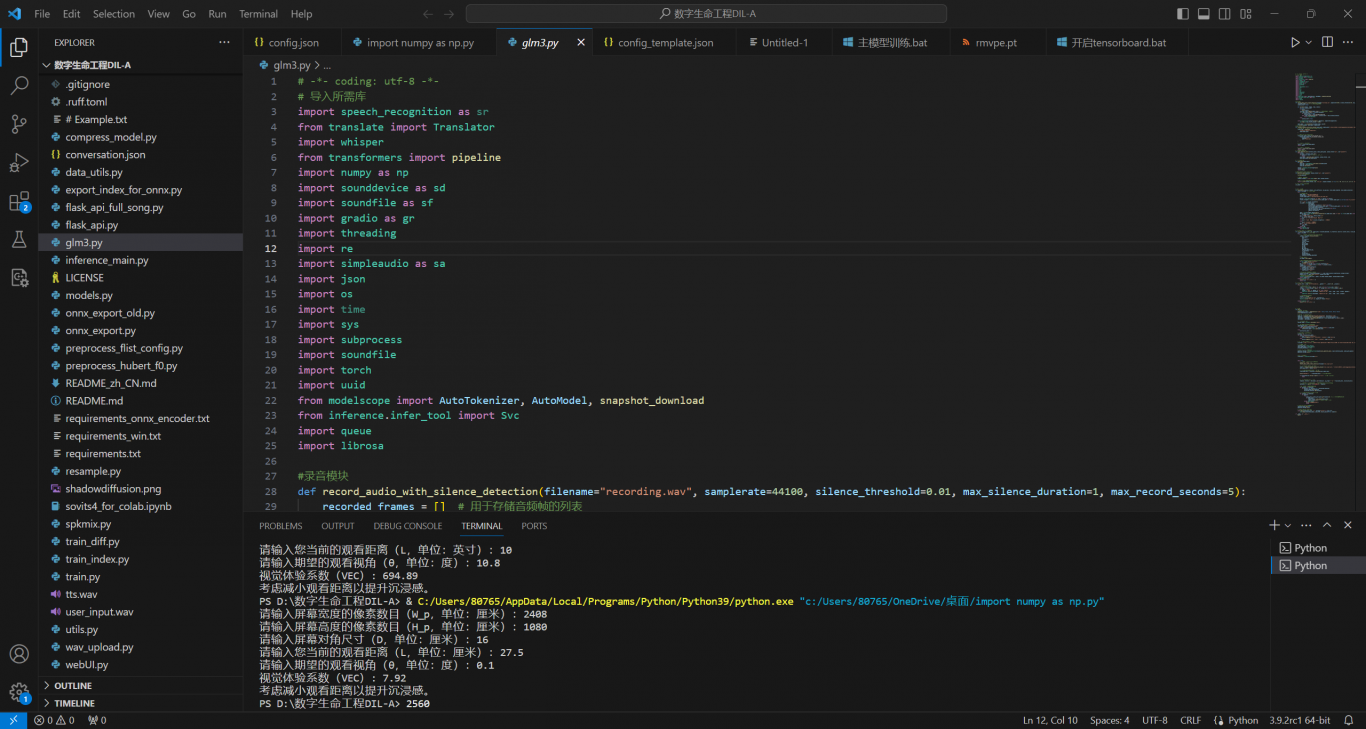

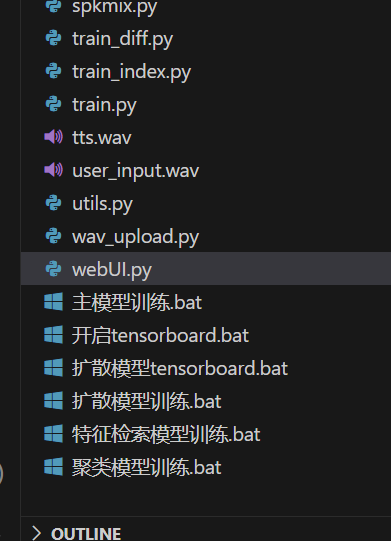

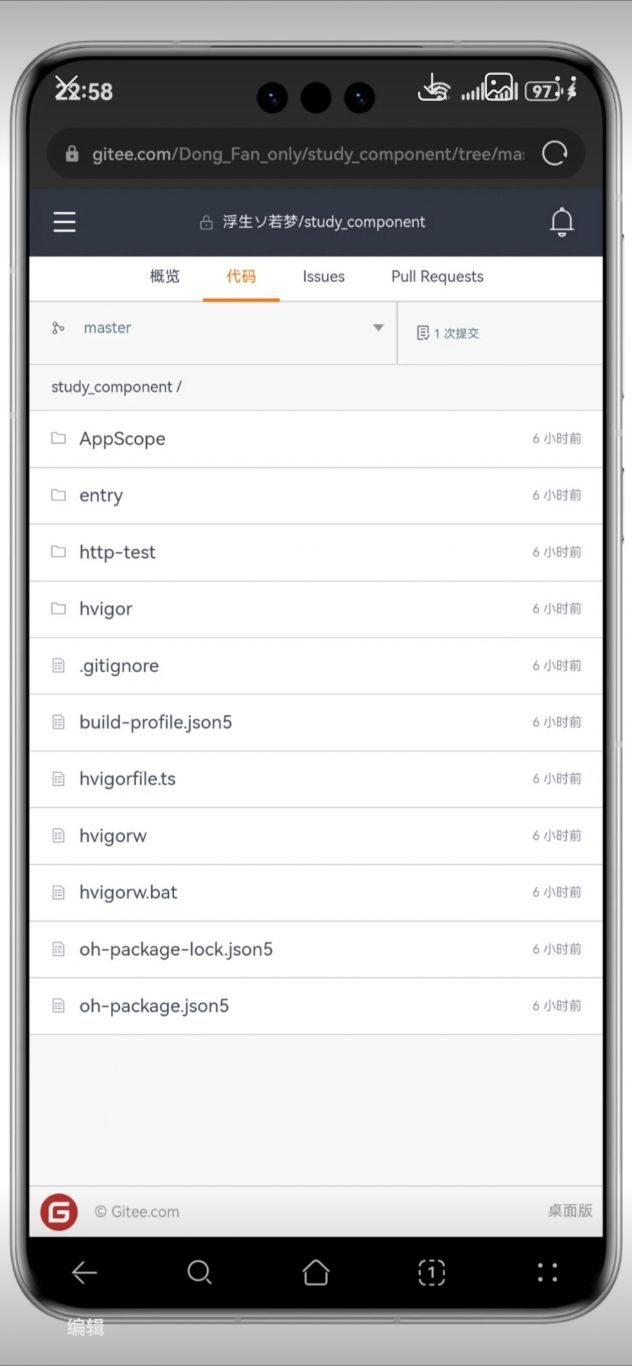

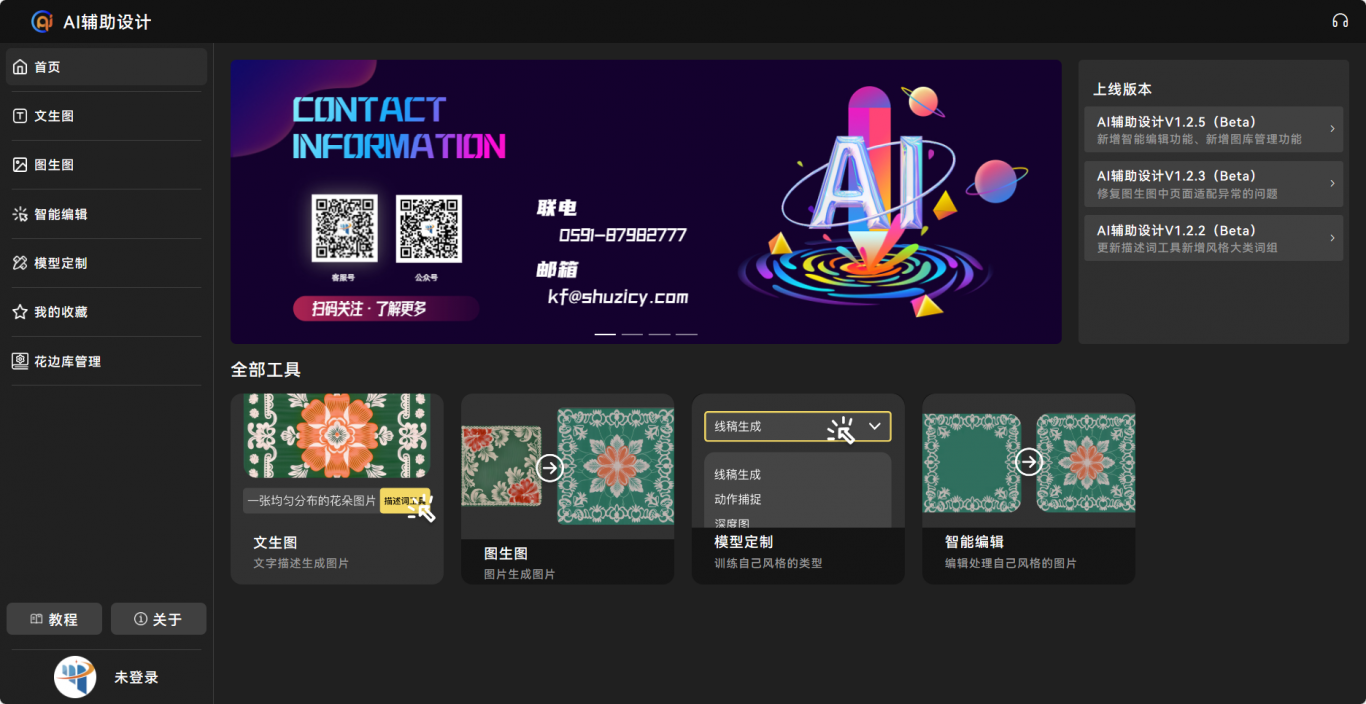

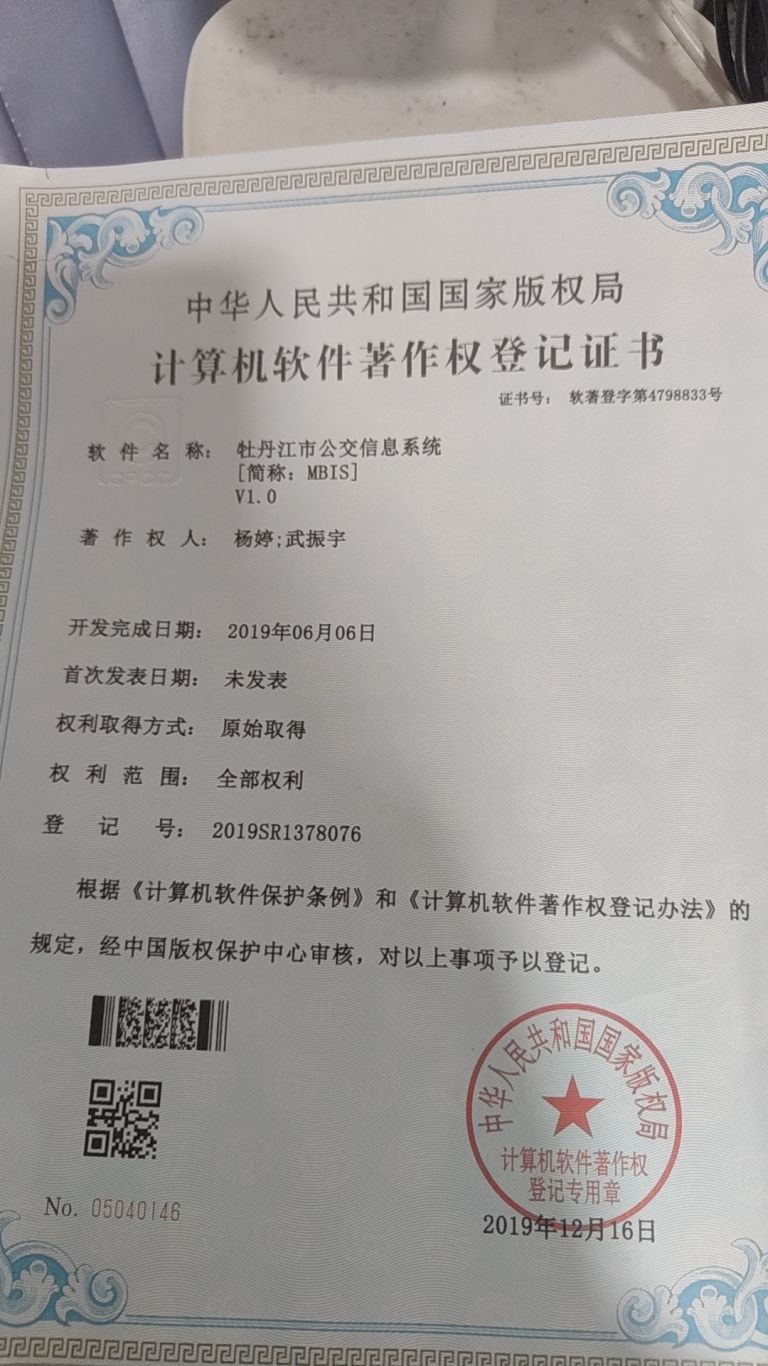

案例图片