案例介绍

1.项目背景

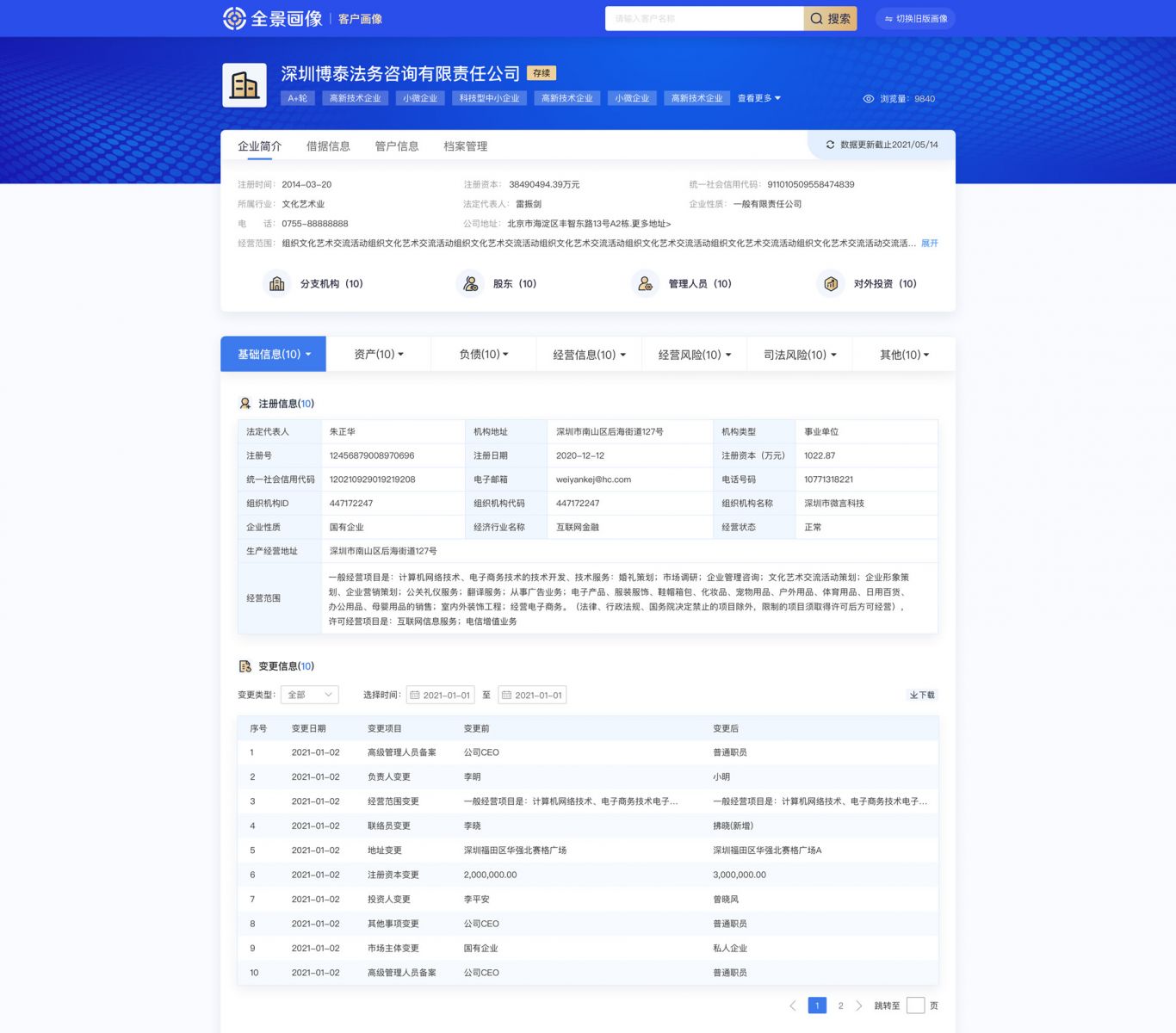

需要实时更新上述两个网站最新披露的数据,两个网站存在很多可用信息,爬取量大,时效性要求较高

2.技术手段以及实现思路

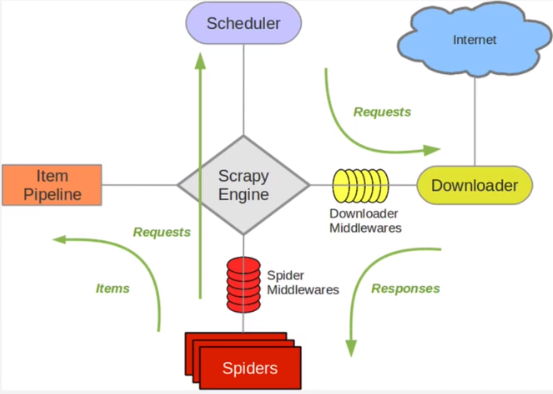

a.考虑数据量大,主要为结构化数据,使用mysql数据库,pymysql便于操作,代理池proxypool提供代理数据避免ip封禁b.针对两个网站的项目,建立两个scrapyproject,两个项目实现思路一样。考虑以后会新增其他数据需求,start_requests里面使用主域名。针对不同数据需求分析页面,在生成的新请求里面调用不同的parse函数

c.设置异常处理情况,遇到异常时,记录异常信息保存到本地便于后期分析,setting里面注释钓默认的中间件

d.以上架构综合考虑了反爬虫机制,易于修改代码后增加后期数据需求,容错机制等

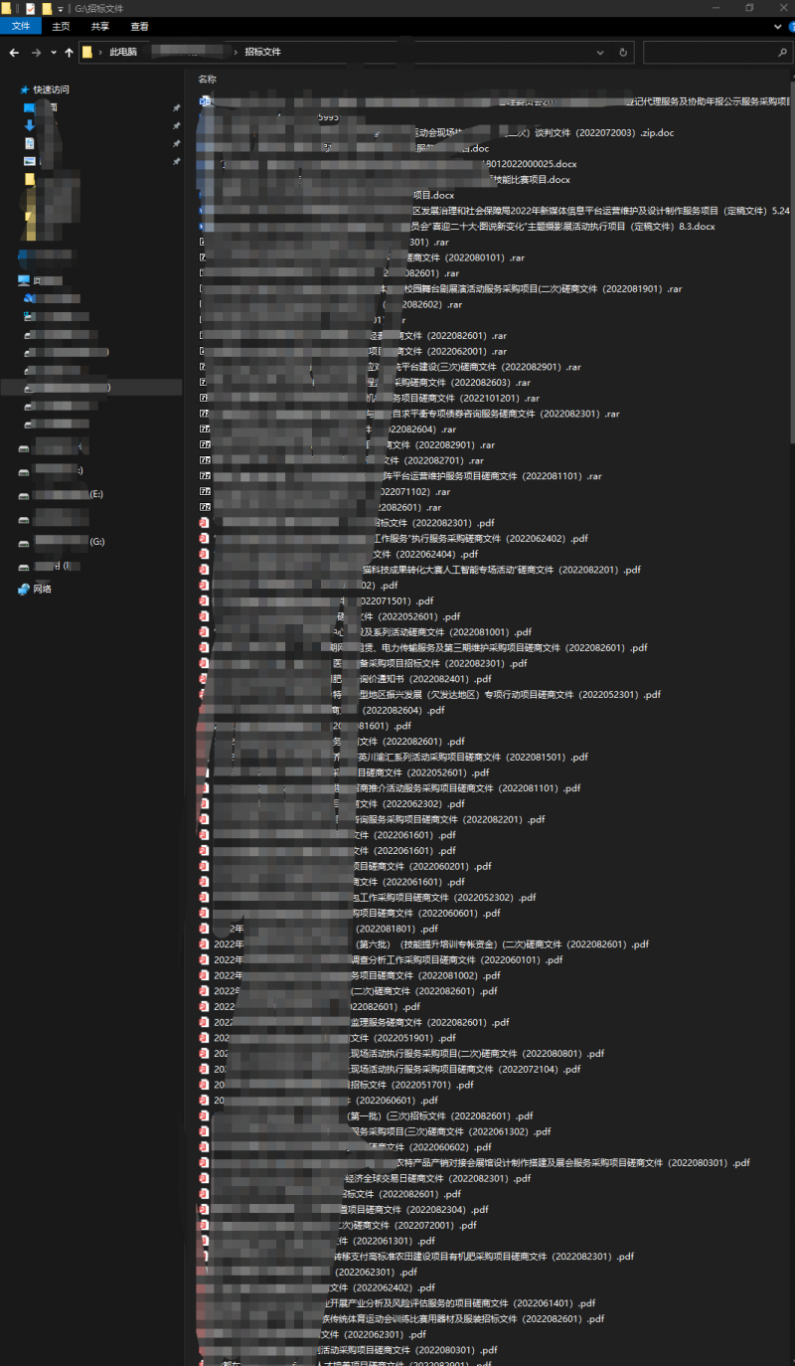

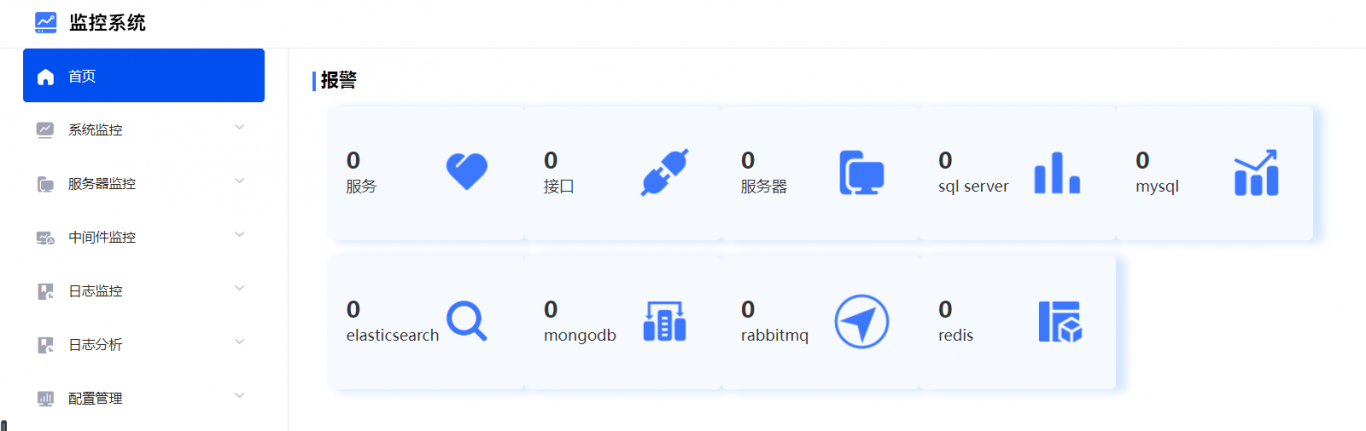

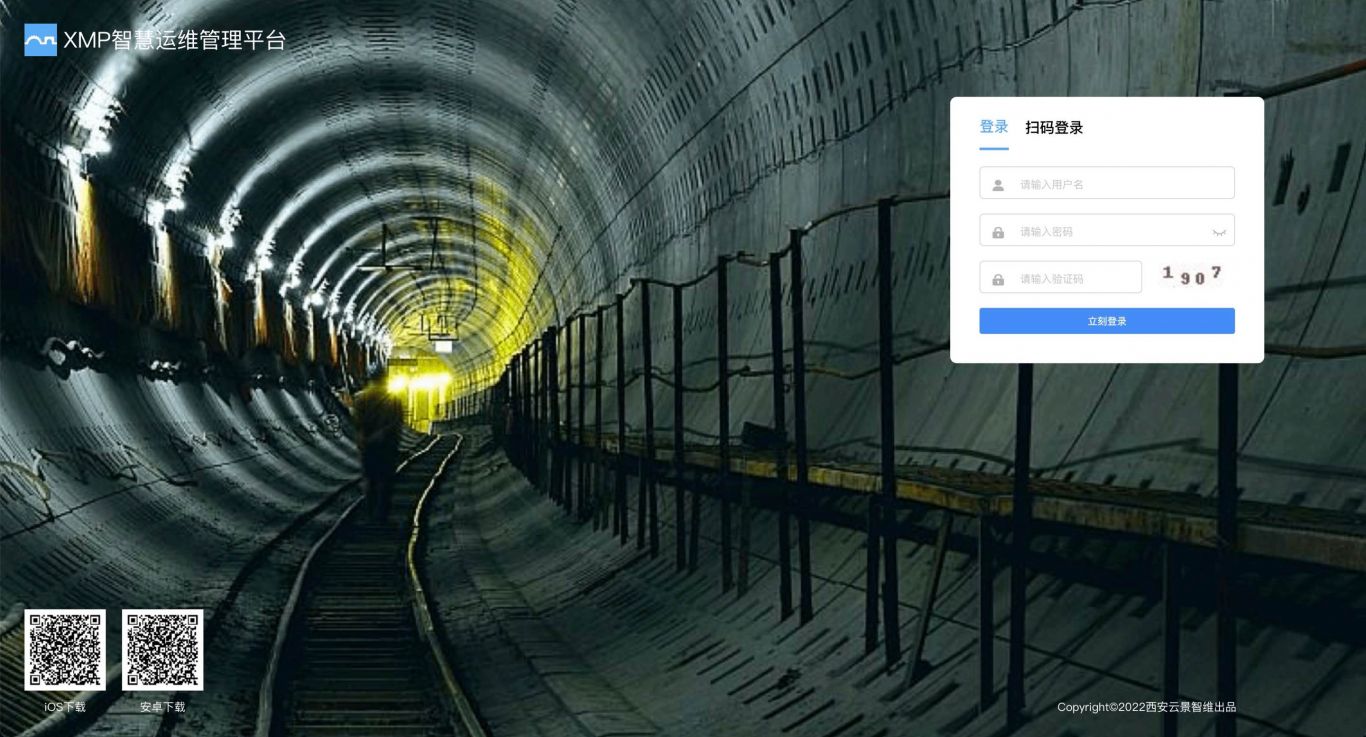

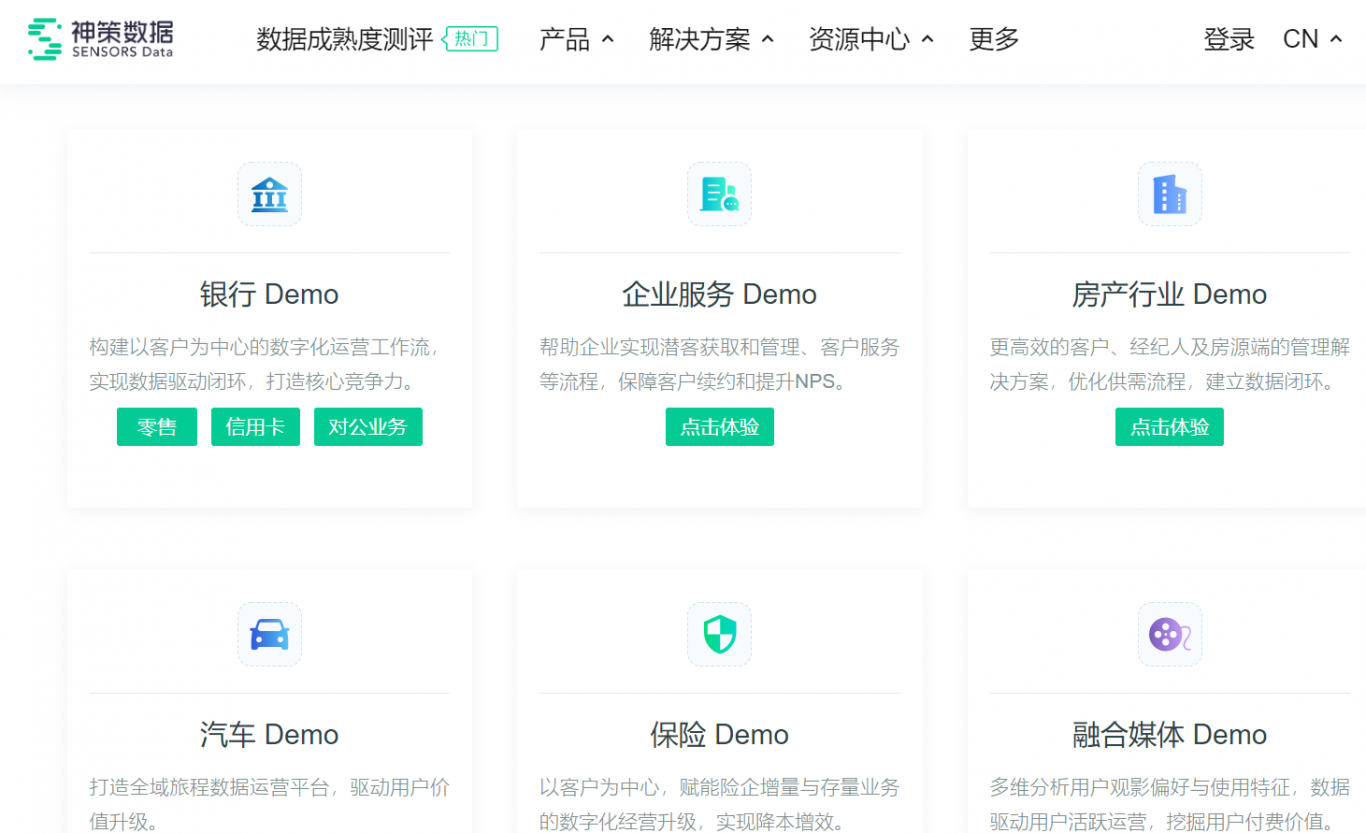

案例图片