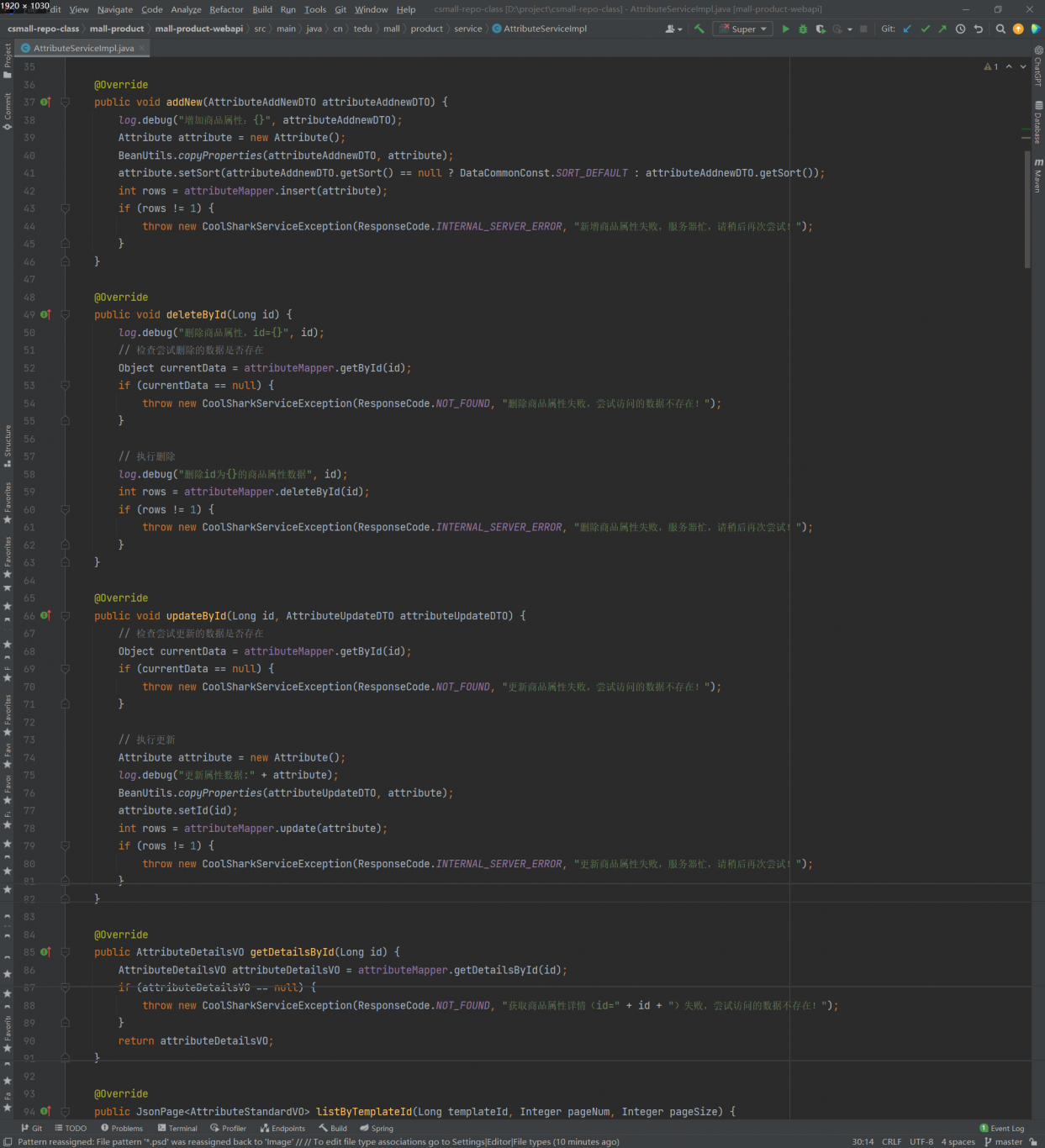

案例介绍

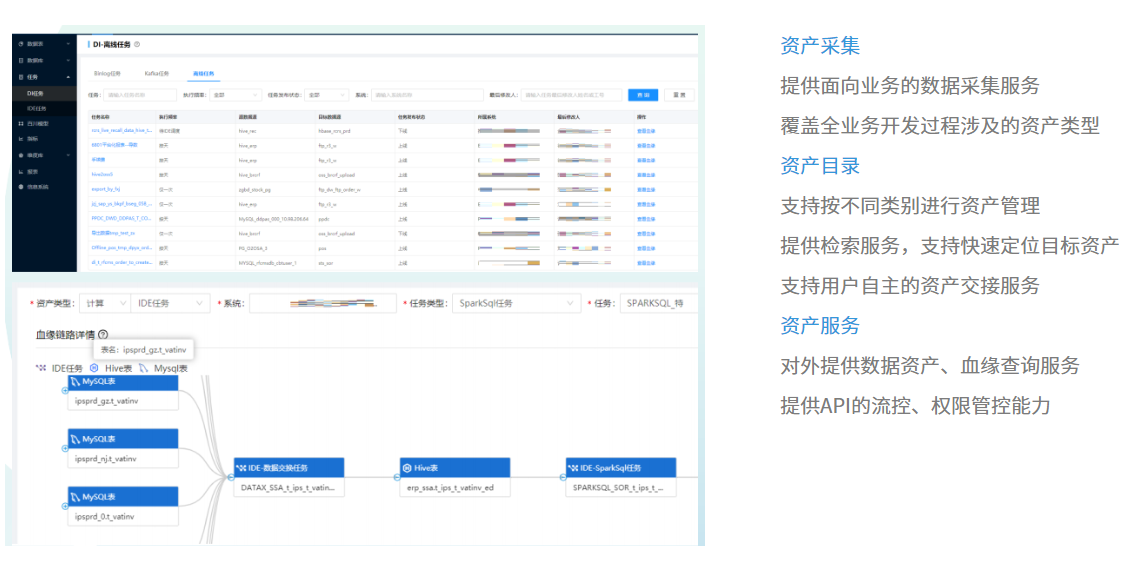

1、参与了项目技术选型,从 0 到 1 的搭建,设计统一的资产采集报文等等。

2、对接相关部门做血缘资产采集,对接采集文档,按指定格式往我们部门的 kafka topic 上推

送消息,我们使用 flink 实时消费,做数据清洗,校验入库,存 es 等工作。我主要负责采集系

统,库,表,字段,任务等资产和血缘相关数据。

3、开发相关资产和血缘查询接口。

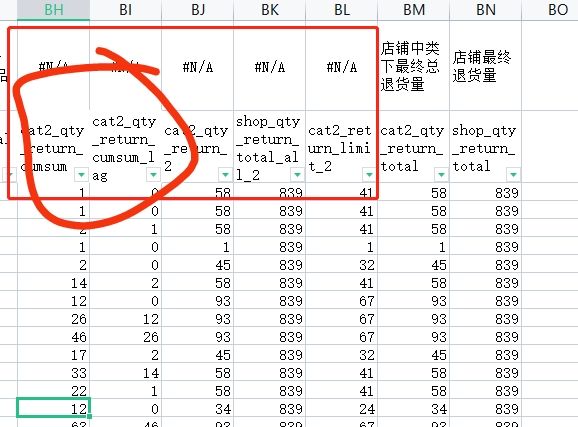

4、根据数据办提出的数据导出需求,开发相关 hive 任务,开发数据清洗,数据导出等等 spark

任务。

5、参与开发了资产交接功能。

案例图片