分布式爬虫

案例介绍

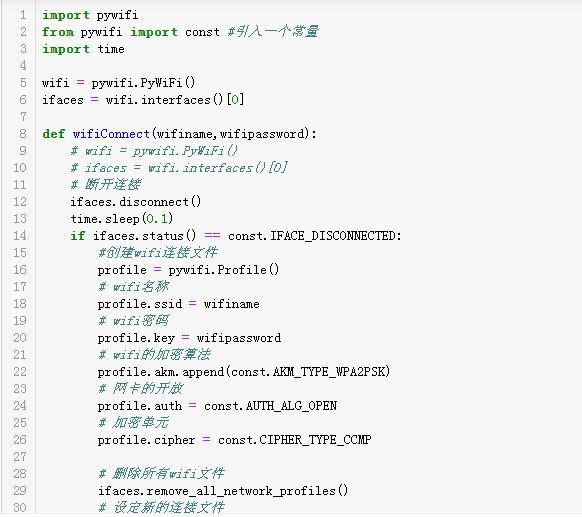

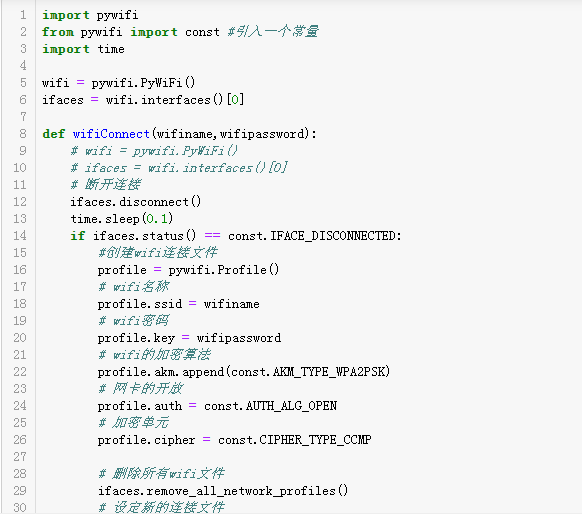

我的职责:首先爬取首页后通过xpath匹配每个的信息块的span后构建请求,并通过scrapy.Request发送请求,用xpath

匹配需要的信息。同时循环创建下一页请求的rorm表单,通过scrapy.FormRequest发送POST请求。所有爬取的信息

缓存到redis数据库中,最后通过编写python脚本将redis数据中数据读取出来加入mysql数据库。其他爬取的的网站:

搜狐新闻、豆瓣、腾讯新闻网. 项目介绍:这个项目是通过scrapy-redis搭建分布式爬虫爬取企业信用信息网公布栏,爬

取列表页每一项下的子页获取数据。

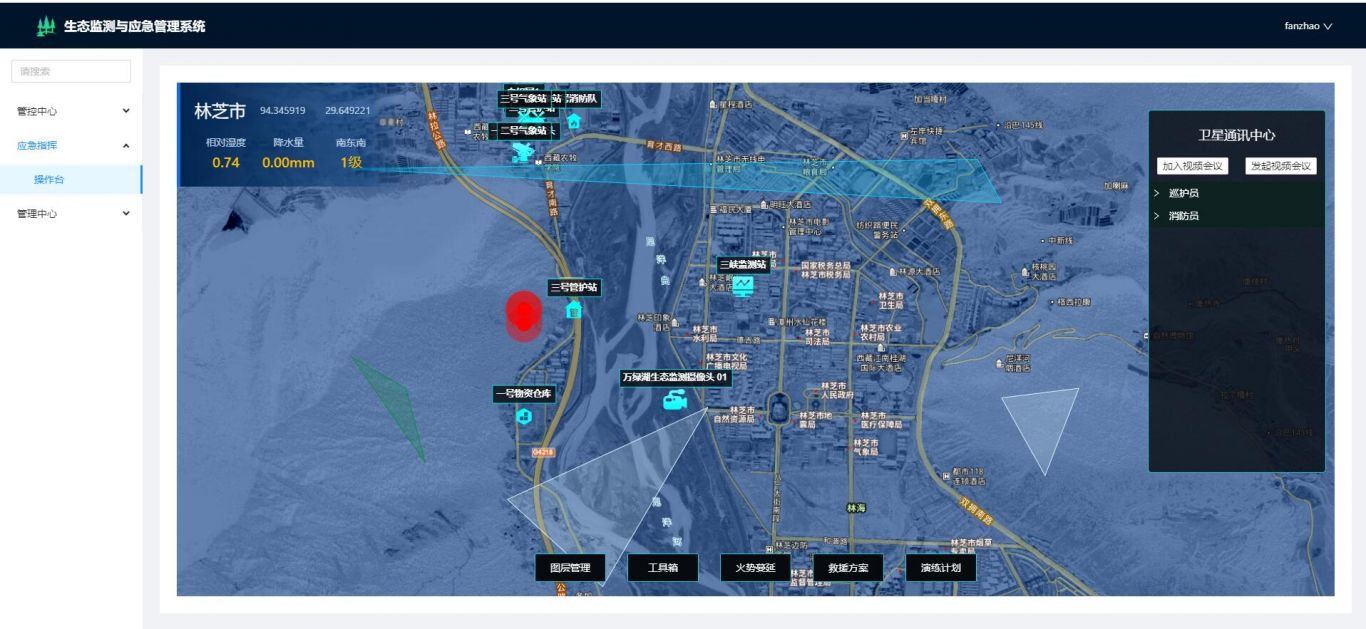

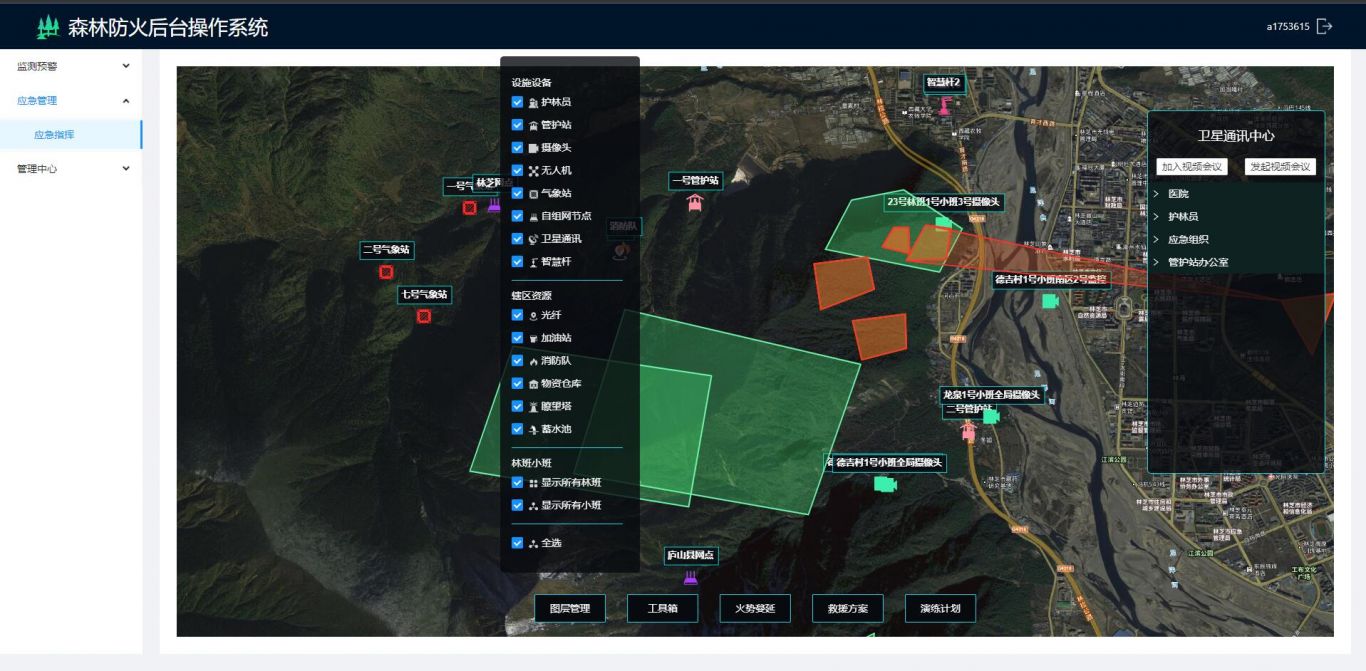

案例图片