案例介绍

An Efficient Method of Supervised Contrastive Learning for Natural Language Understanding 第一作者

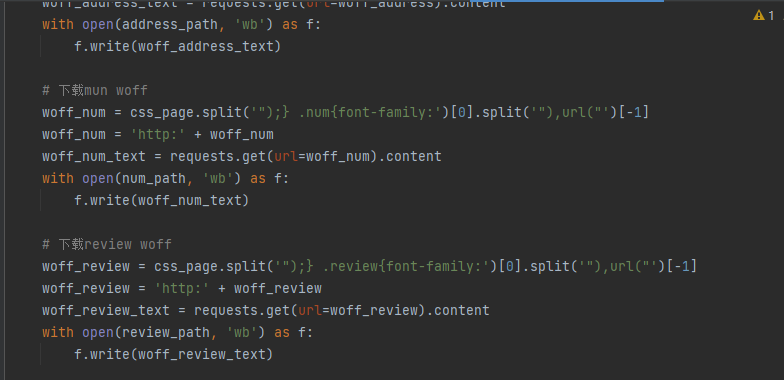

论文背景 论 :对于文本分类任务,目前主流的方法:预训练语言模型+微调的范式,常常采用交叉熵损失函数。模型输

出置信度在0.5左右的样本,是对于模型分类比较困难的样本。针对这个问题,利用监督对比学习有效地提升了模型

对于困难样本的分类准确率。

• 主要内容 主 :1.通过融合交叉熵损失函数以及提出的监督对比学习损失函数,尽可能地最大化类间方差和最小化类内方

差,提升类别特征区分度。2.通过在隐层状态上的数据增强方法来提升模型训练的鲁棒性,同时增强模型泛化能力。

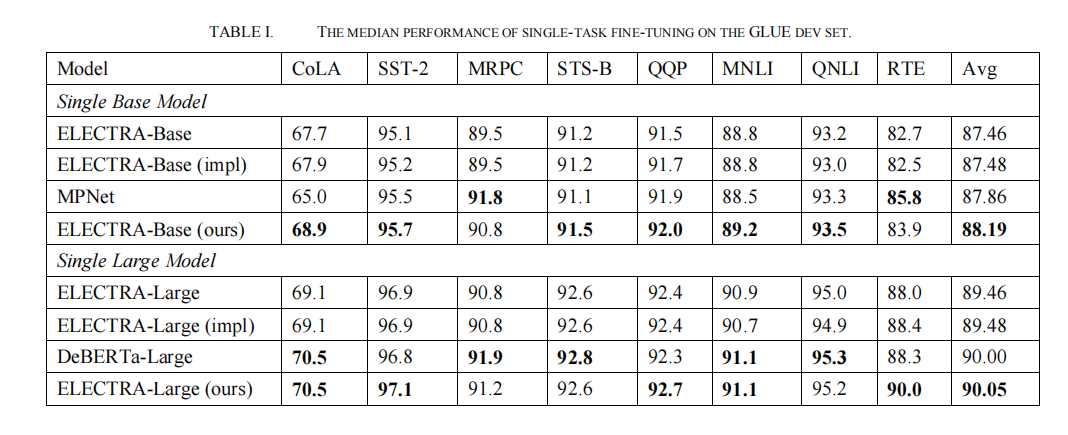

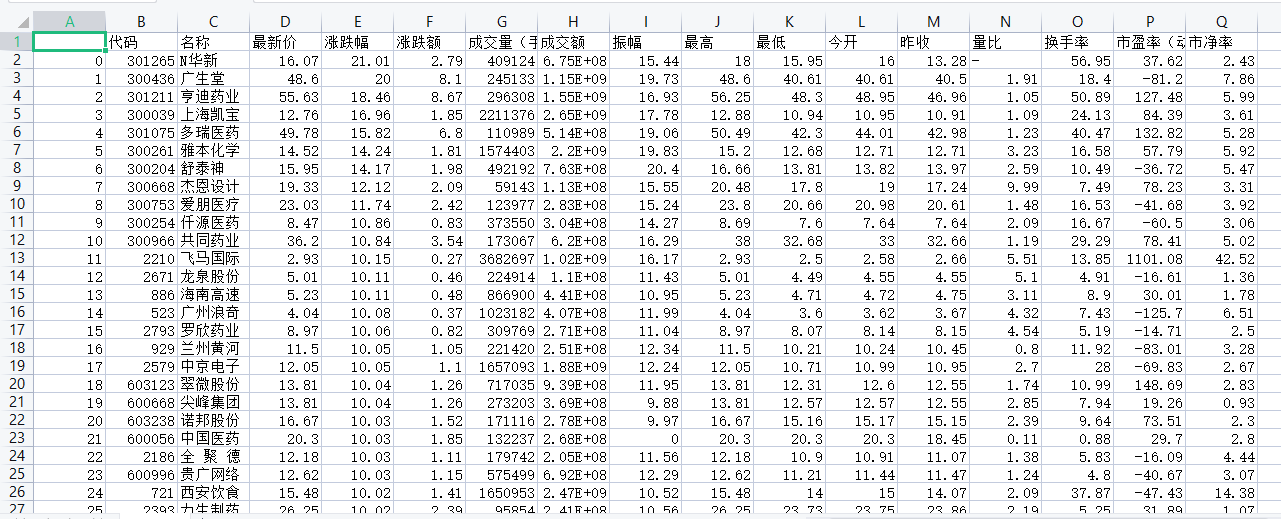

• 实验结果 实 :1.使用ELECTRA模型在GLUE benchmark的8个数据集上均有显著提升。2.与传统的交叉熵损失函数以及

其他的对比学习损失函数比较,在分类效果(tSNE可视化)、泛化能力等指标上,均有更好的表现。

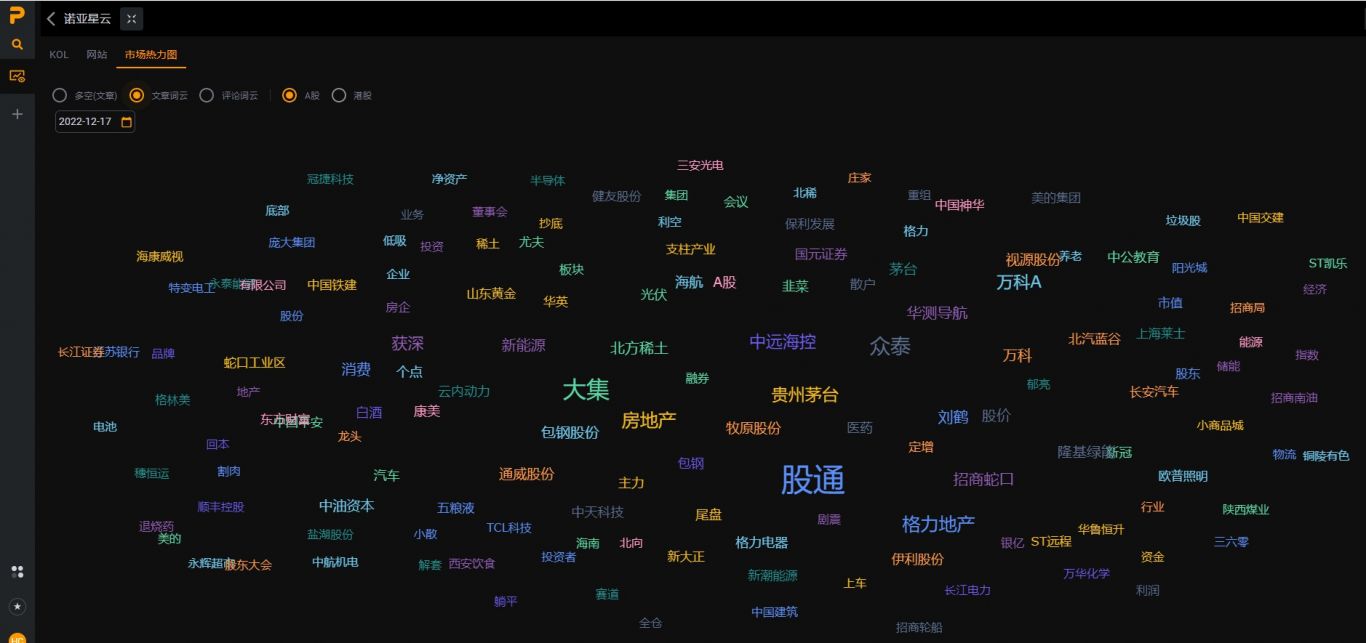

案例图片