案例介绍

项目主要工作内容如下:

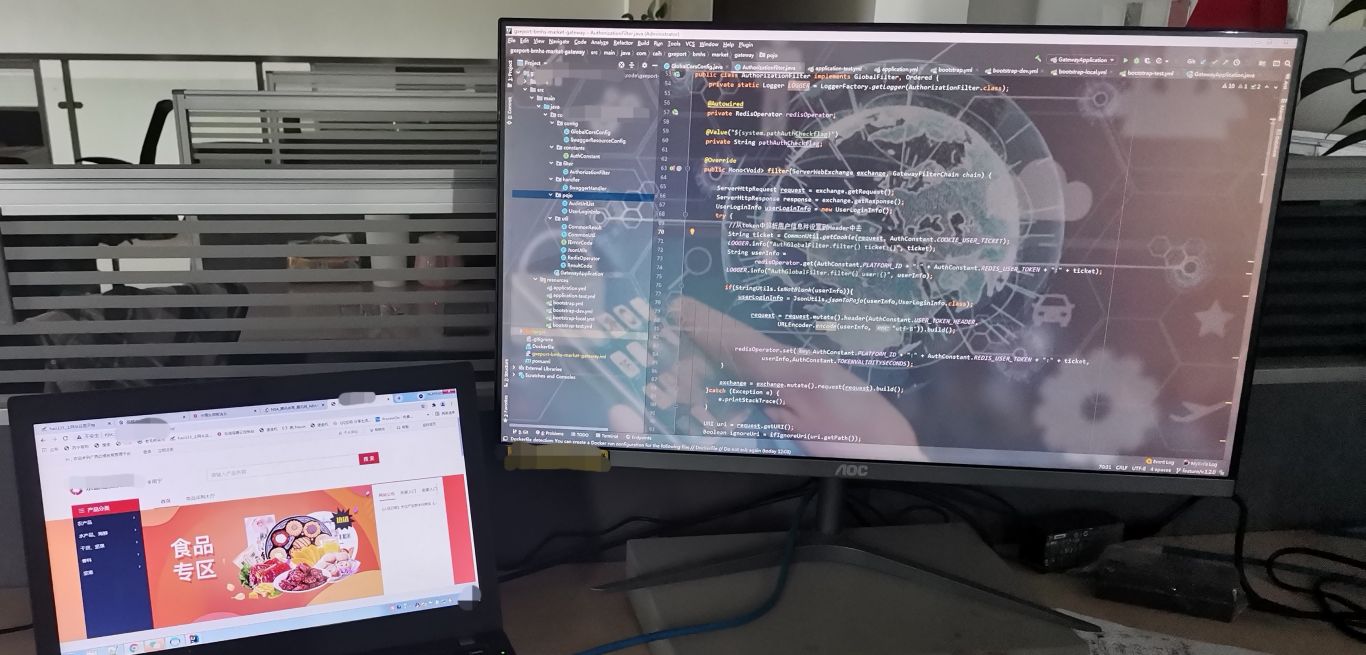

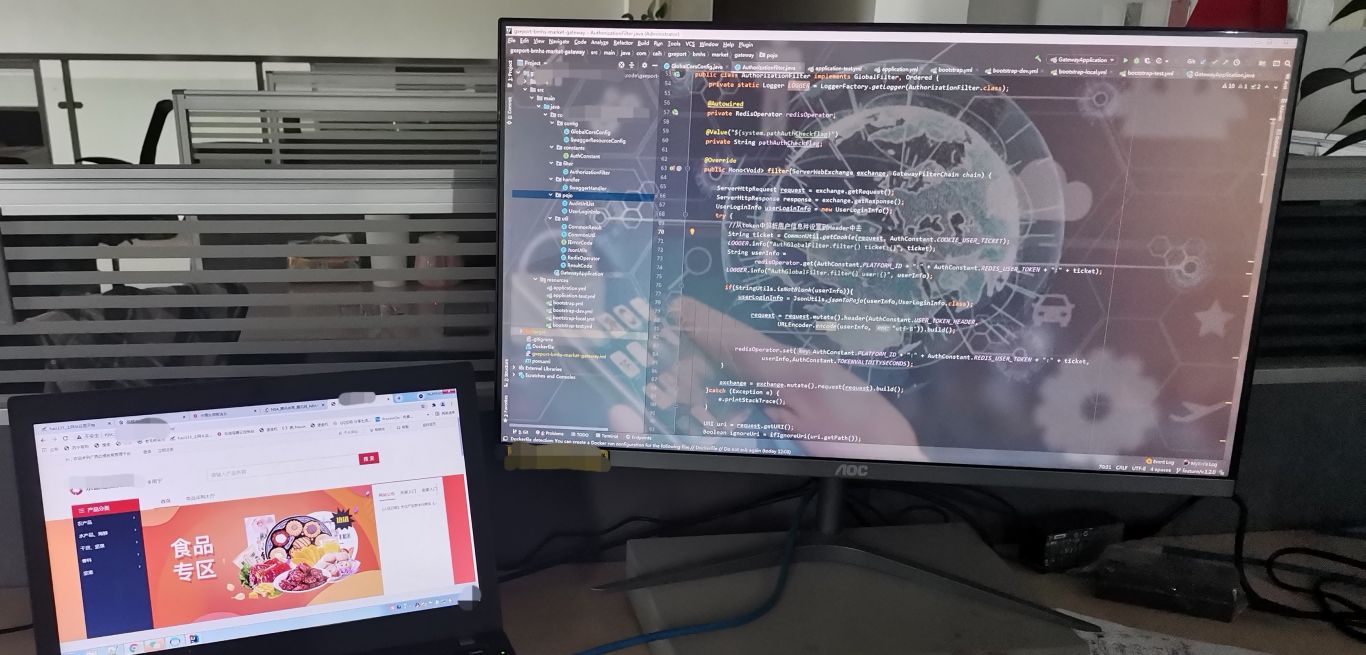

1、 kakfa 代码开发,接入爬虫数据. 2、 elasticsearch 搜索引擎平台构建、优化. 3、 基于 motan rpc 为上层提供接口. 4、 kafka 、elasticsearch 相关开发文档编写和整理. 5、Spark 关键词提取,智能解析,人工推荐.(1)数据缓存层:针对爬虫的数据(微博、微信等)通过 kafka 进行缓存,缓存生命周期 7day.(2)实时计算层:对 kakfa 数据,采用stormtopology 实时消费、分析.(3)数据应用层:对 storm 和 spark Streaming 实时分析的数据,实时 elasticsearch 搜索引擎,提供最终客户数据.用 hadoop/spark,hbase,mysql 做离线分析.Spark 做关键词提取,智能解析,人工推荐.具体实现:本项目采用 kakfa 对爬虫的数据进行缓存,storm/saprk 实时的对 kafka 数据进行消费,最终将 storm/saprk 实时处理的数据写入到 elasticsearch 搜索引擎,为客户提供精准、实时的数据.项目主要用到的组件: storm, kafka, elasticsearch ,hbase, kibana, shell, spark,hadoop

案例图片